ElasticSearch

ElasticSearch 概述

概述

Elasticsearch 是什么

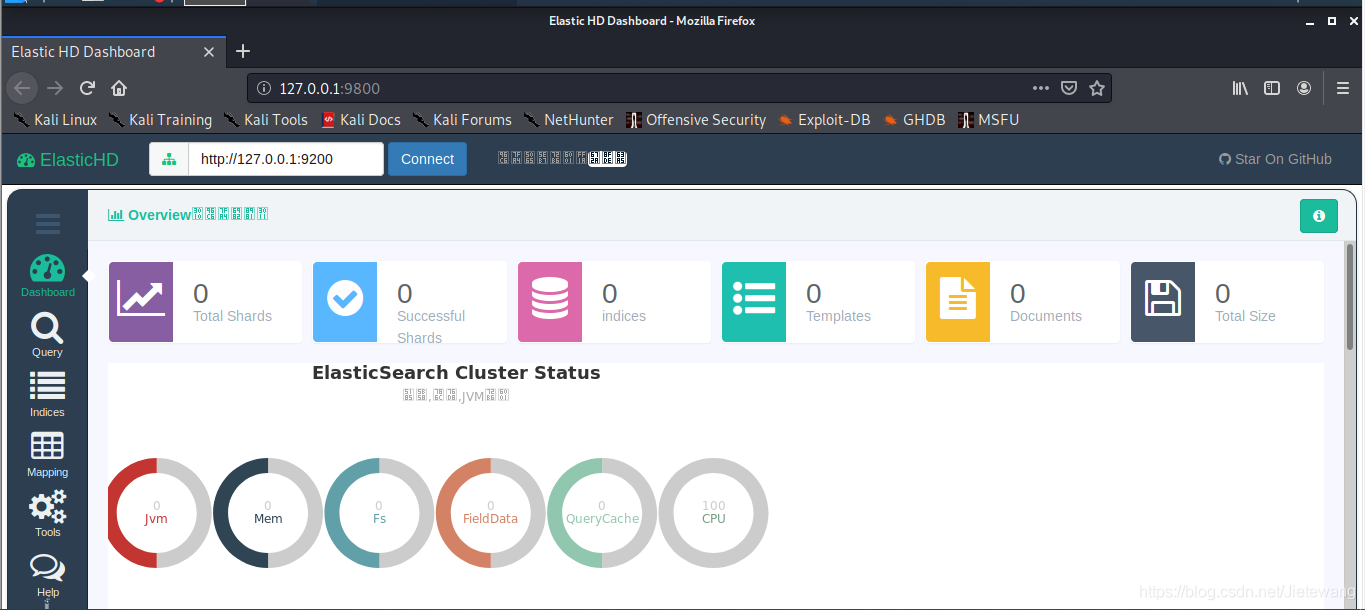

Elasticsearch(简称ES)是一个基于Apache Lucene(TM)的开源搜索引擎

Elasticsearch 是一个高伸缩的开源全文搜索和分析引擎,是一个基于JSON的分布式搜索和分析引擎,基于restful web接口,Elasticsearch是用Java语言开发的,基于Apache协议的开源项目,是目前最受欢迎的企业搜索引擎。

它可以快速地、近实时的存储,搜索和分析大规模的数据。一般被用作底层引擎/技术,为具有复杂搜索功能和要求的应用提供强有力的支撑。

ElasticSearch特点

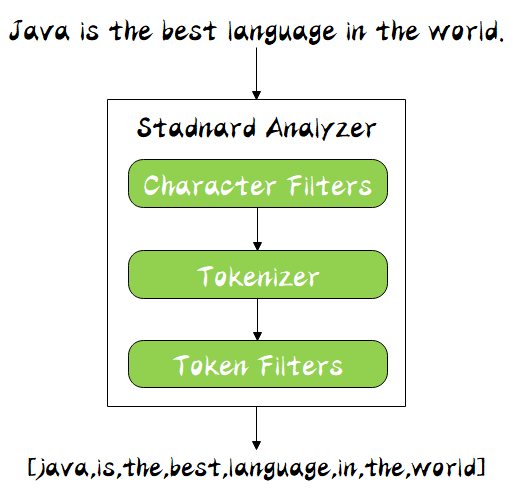

Elasticsearch是实时的分布式搜索分析引擎,内部使用Lucene做索引与搜索,有以下特点

- 近实时性:新增到 ES 中的数据在1秒后就可以被检索到,这种新增数据对搜索的可见性称为“近实时搜索”

- 全文检索:将全文检索、数据分析以及分布式技术,合并在了一起,才形成了独一无二的ES

- 分布式:意味着可以动态调整集群规模,弹性扩容

- 集群规模:可以扩展到上百台服务器,处理PB级结构化或非结构化数据

- 开箱即用:对用户而言,是开箱即用的,非常简单,作为中小型的应用,直接3分钟部署一下ES

- 不支持事务:数据库的功能面对很多领域是不够用的,事务,还有各种联机事务型的操作

使用场景

ElasticSearch广泛应用于各行业领域, 比如维基百科, GitHub的代码搜索,电商网站的大数据日志统计分析, BI系统报表统计分析等。

记录和日志分析

ELK结合使用可以实现日志数据的收集整理

围绕Elasticsearch建立的生态系统使其成为实施和扩展日志记录解决方案最简单的系统之一,利用这一点将日志添加到他们的主要用例中,或者纯粹将我们用于日志记录。

从Beats到Logstash,再到Ingest Nodes,Elasticsearch为您提供了很多选择,可以随时随地获取数据并将其编入索引,从那里,像Kibana这样的工具使您能够创建丰富的仪表板和分析。

搜集和合并公共数据

像日志数据一样,Elastic Stack有很多工具可以使远程数据的获取和索引编制变得容易。

而且,像大多数文档存储一样,缺乏严格的架构也使Elasticsearch可以灵活地接收多种不同的数据源,并且仍然可以使所有数据源易于管理和搜索。

全文搜索

全文搜索作为Elasticsearch的核心功能,得到了广泛的应用,远远超出了传统的企业搜索或电子商务

从欺诈检测/安全性到协作及其他方面,Elasticsearch的搜索功能强大,灵活,并且包含许多工具,可以使搜索变得更加容易,Elasticsearch拥有自己的查询DSL以及内置的功能,可自动完成

事件数据和指标

Elasticsearch在如指标和应用程序事件之类的时间序列数据上也能很好地运行

这是巨大的Beats生态系统允许您轻松获取常见应用程序数据的另一个区域,无论您使用哪种技术,Elasticsearch都有很大的机会拥有可以立即获取指标和事件的组件。

可视化数据

Kibana拥有大量图表选项,用于地理数据的图块服务以及用于时间序列数据的TimeLion,是功能强大且易于使用的可视化工具。

对于上述每个用例,Kibana都会处理一些可视组件,熟悉了各种数据提取工具后,您会发现Elasticsearch + Kibana将成为您可视化试图包裹数据的必备工具。

能做什么

要使用ElasticSearch我们需要知道ElasticSearch能够做什么

提供快速查询

试想一下,当你打开一个博客网站,搜索一篇博客的时候,等待了一分钟才有搜索结果,那将会是一个极差的体验。

可想而知,这个博客网站肯定没有使用搜索引擎处理搜索的请求,而是使用了传统的关系型数据库查询,在庞大的数据面前,关系型数据库的查询就显得力不从心,相当耗时。Elasticsearch在这个时候可以帮上忙,使用博客数据建立索引库,依赖倒排索引的优势,为用户快速的呈现搜索的相关结果。

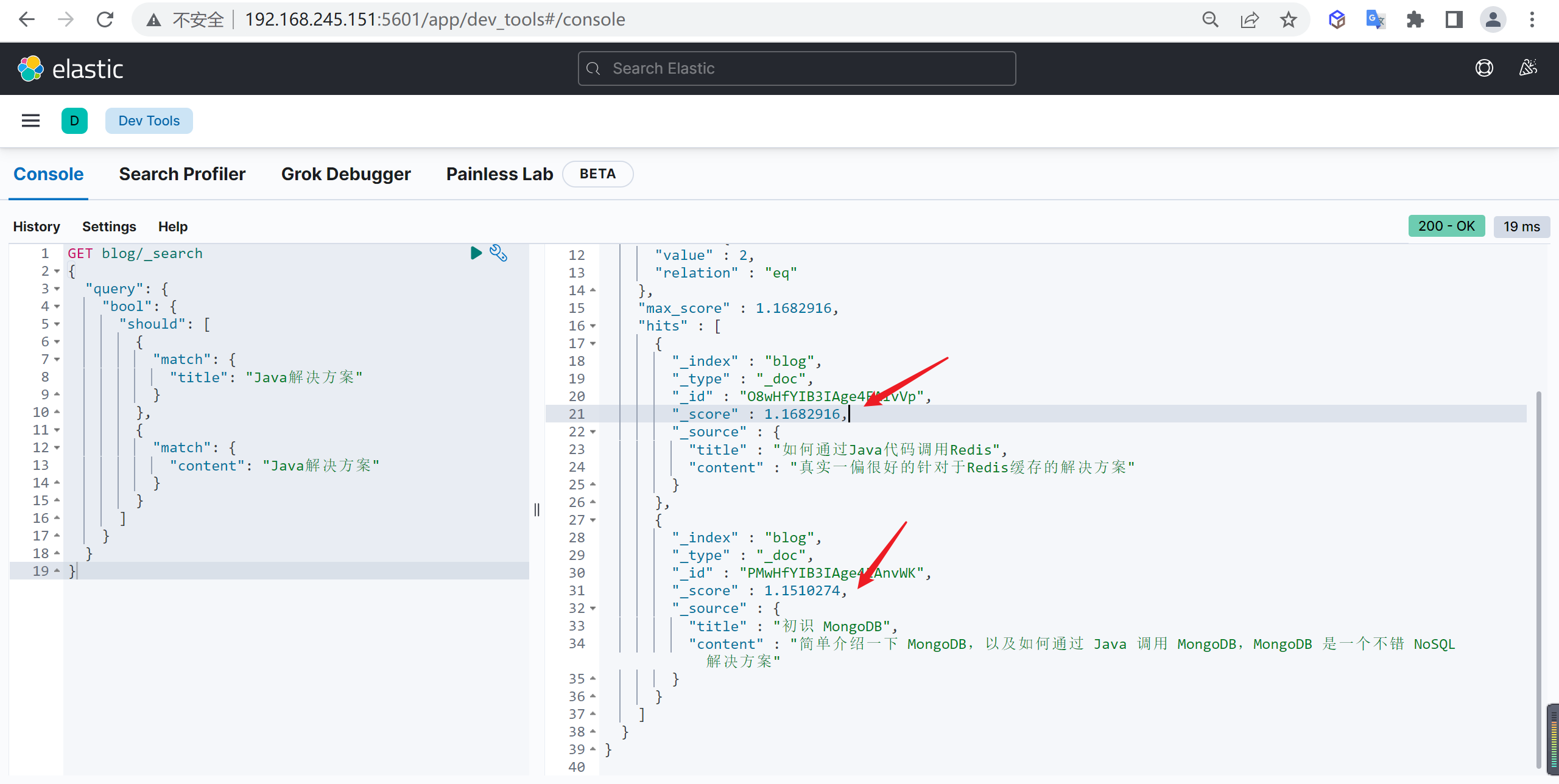

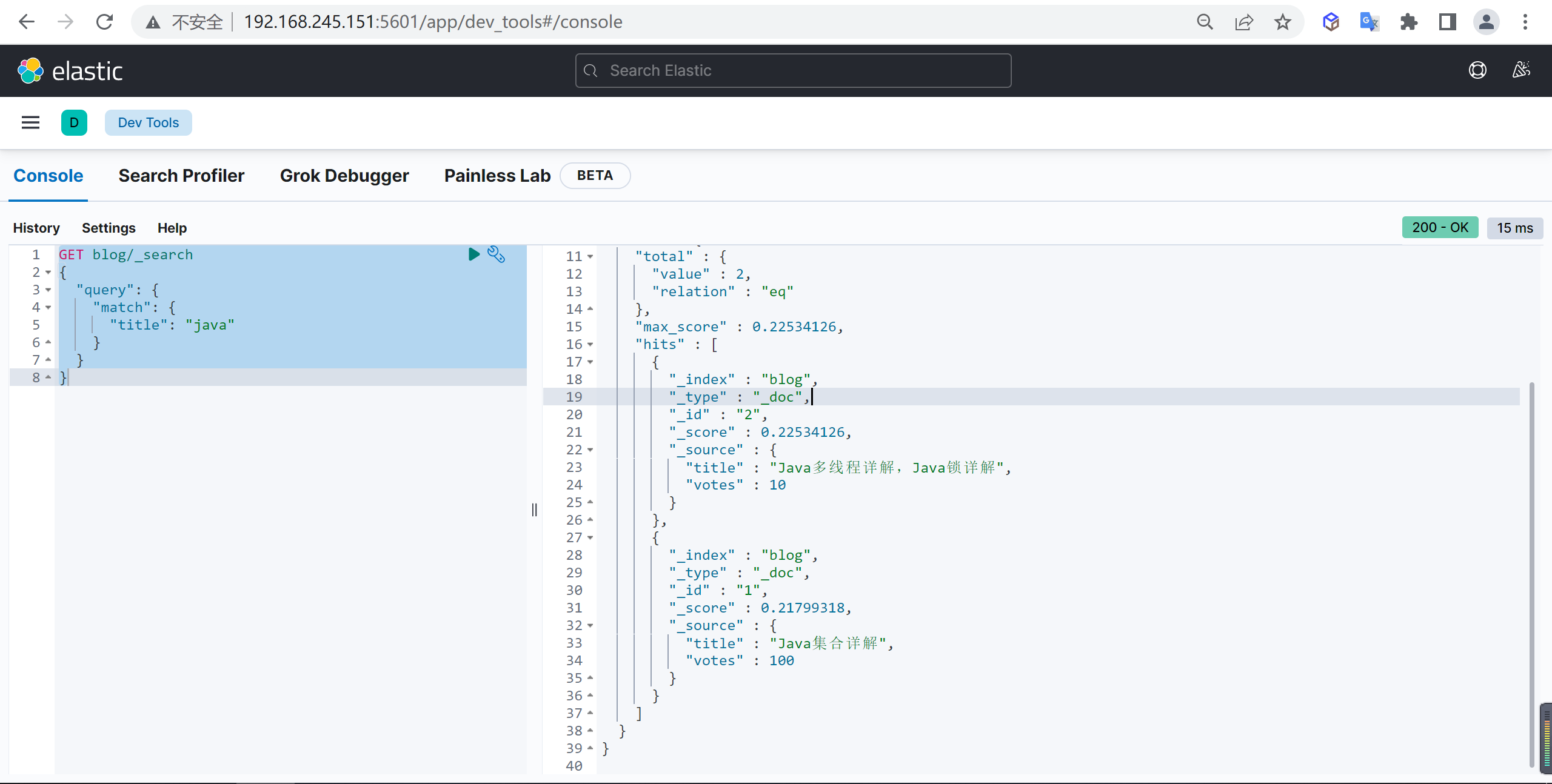

确保结果的相关性

接下来有一个难题: 如何将真正描述选举的帖子排序在前呢?有了 Elasticsearch,就可以使 用几个算法来计算相关性的得分( relevancy score ),然后根据分数来将结果逐个排序 。

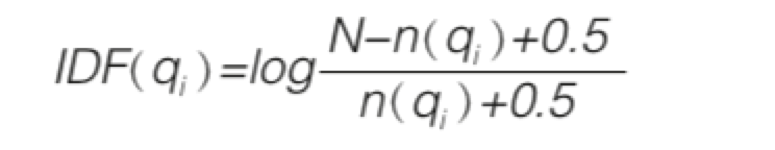

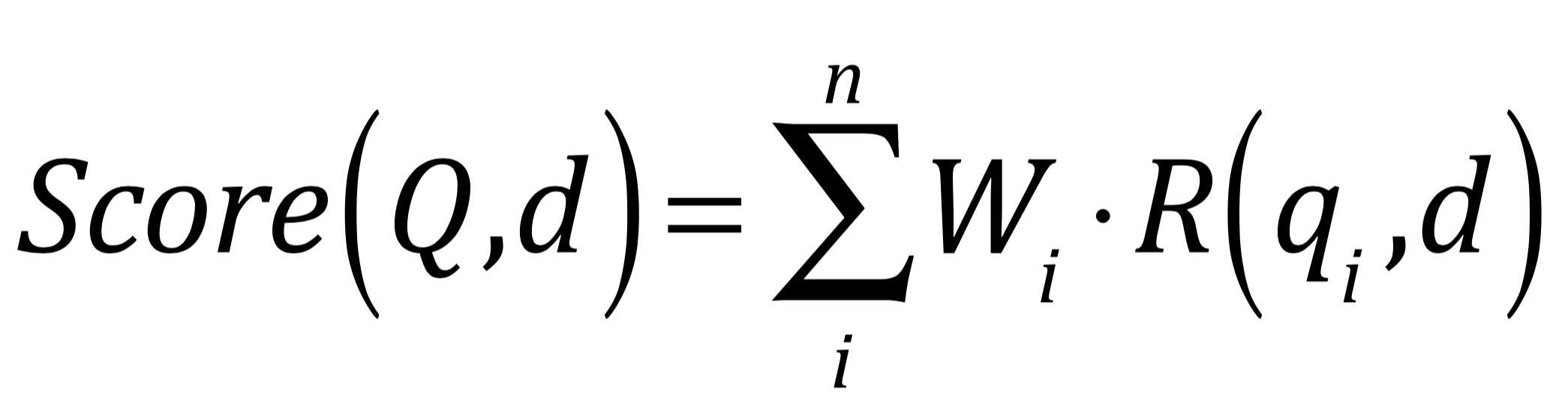

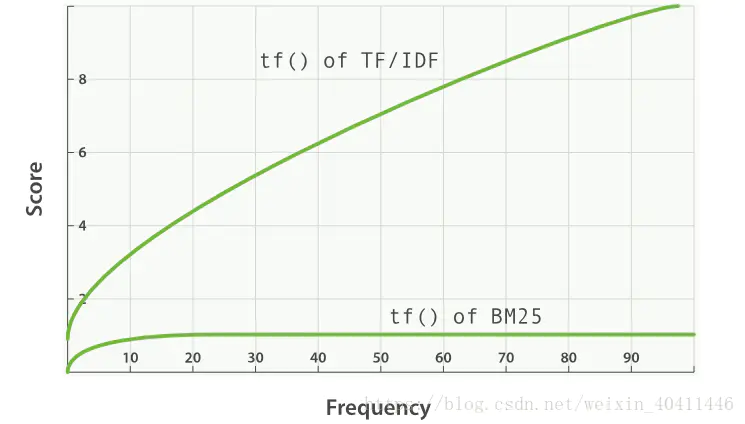

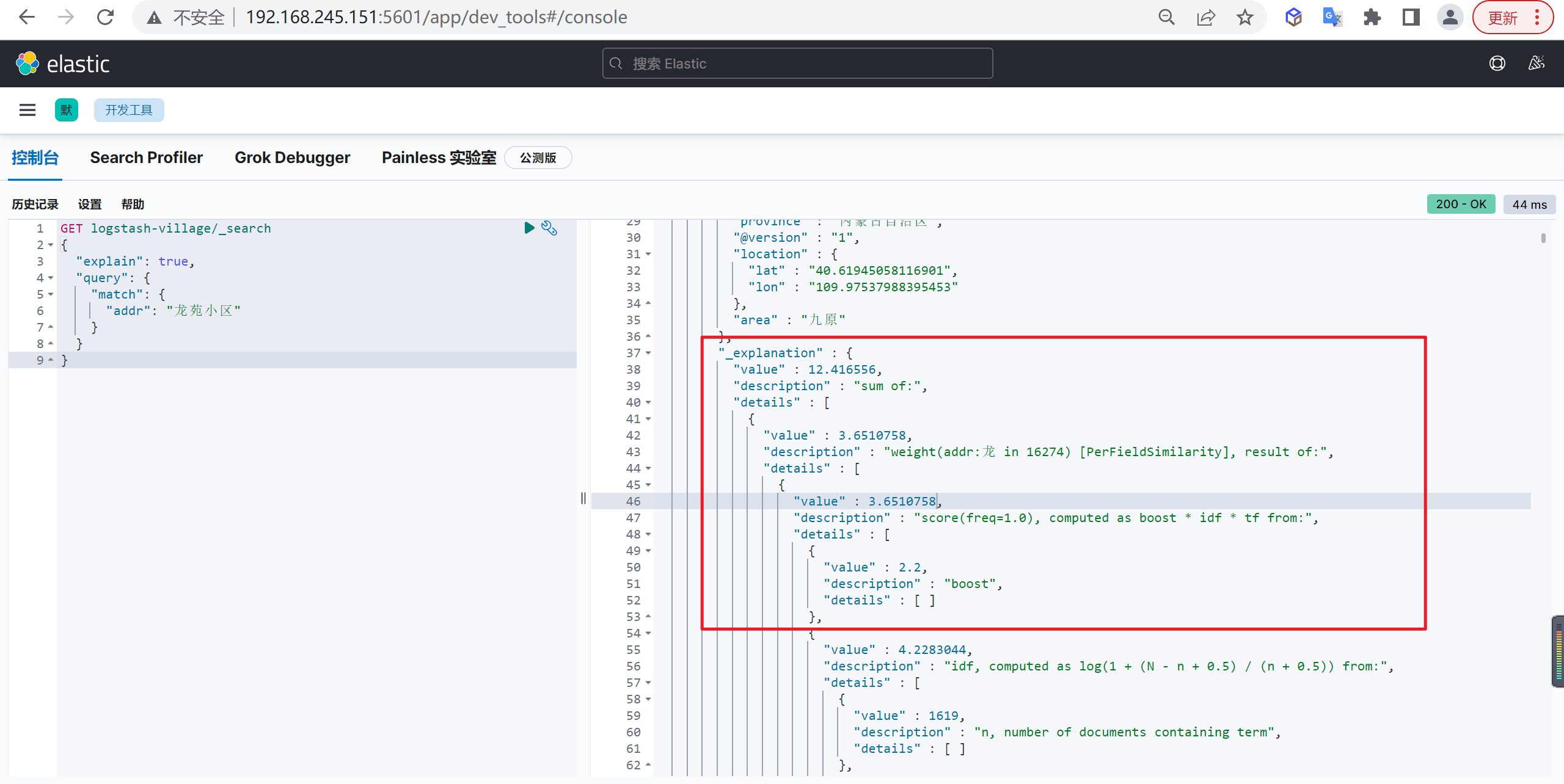

默认情况下,计算文档相关性得分的算法是TF-IDF(term frequency-inverse document frequency),词频逆文档频率。我们将在后面讨论这个概念。除了选择算法,Elasticsearch还提供了很多其他内置的功能来计算概相关性得分,以满足定制需求。

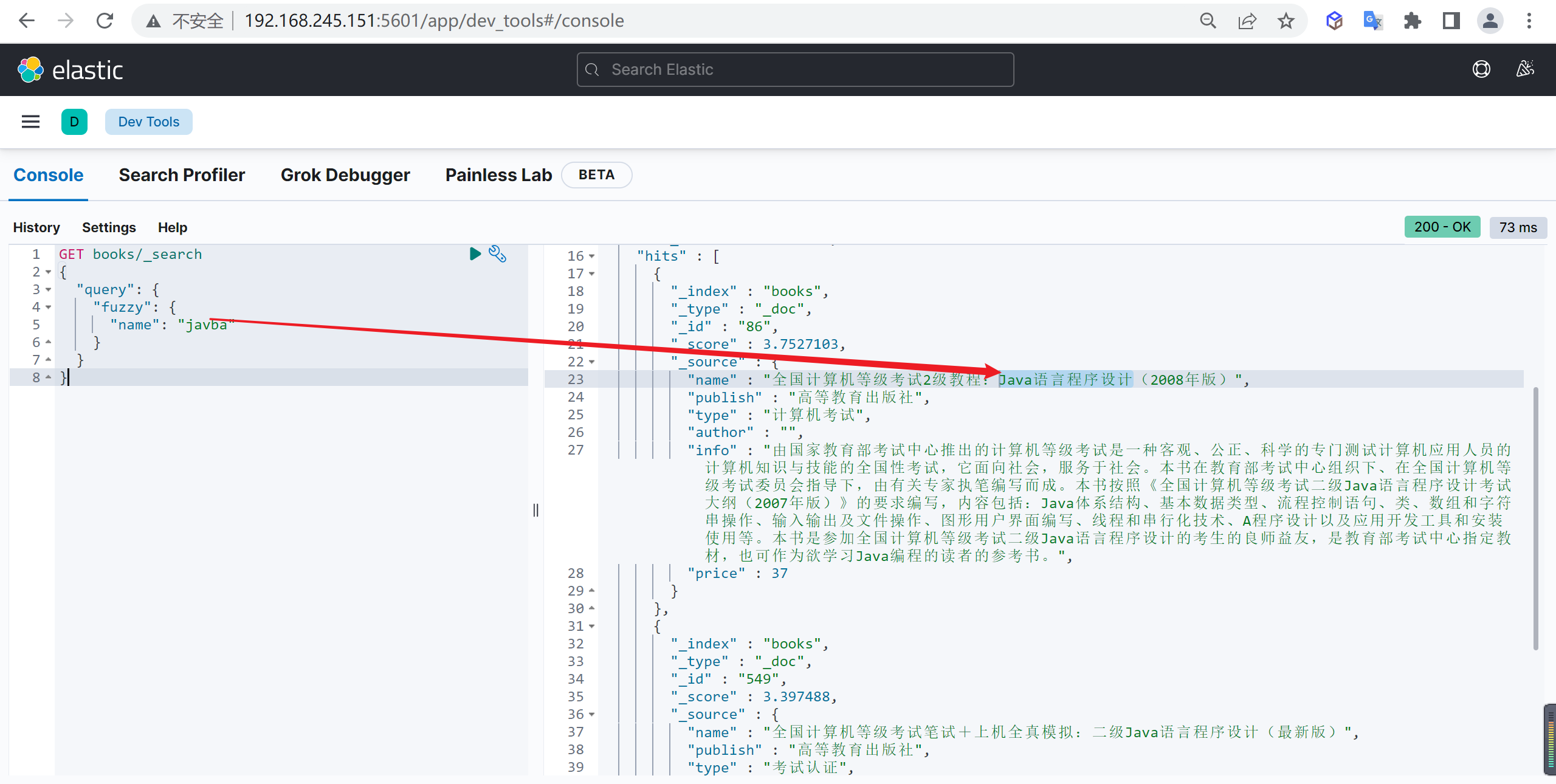

处理错误的拼写

当我们在使用搜索时,会出现英文拼写错误,中文错别字等情况时有发生。

我们可以通过配置让Elasticsearch容忍一些错误,而不仅仅只是查找精确匹配,如我们输入“book”的时候由于手误输入了“bok”,如果搜索引擎能够意识到这一错误并且在搜索时帮我们修正这个错误,那么搜索会更快让人满意。

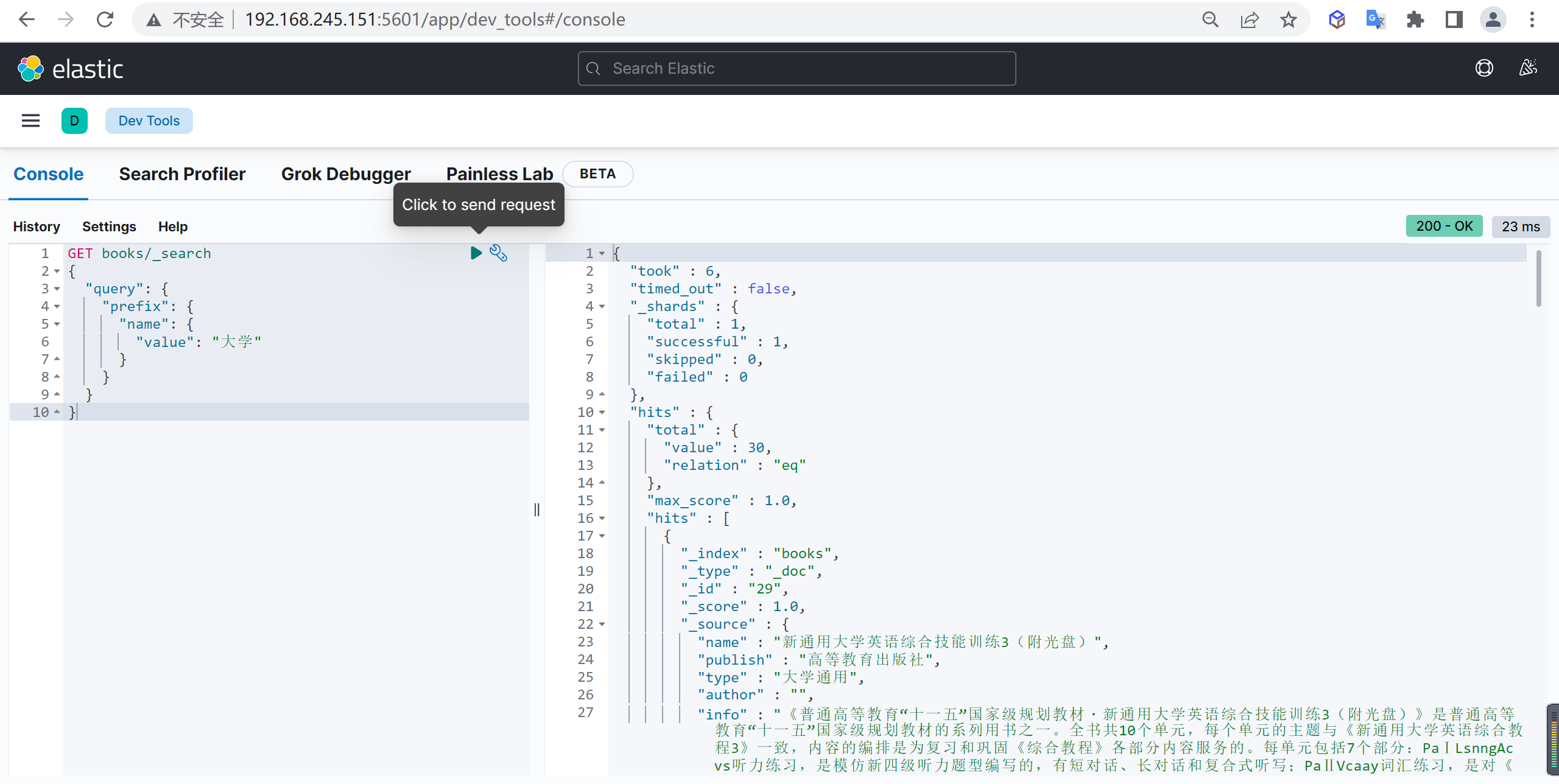

给予自动提示

当用户开始输入时,你可以帮助他们发现主流的查询和结果。

还可以通过自动提示技术预测 他们所要输入的内容,就像 Web 上很多搜索引擎做的那样,你同样可以展示主流的结果,通过 特殊的查询类型来匹配前缀、通配符或正则表达式。

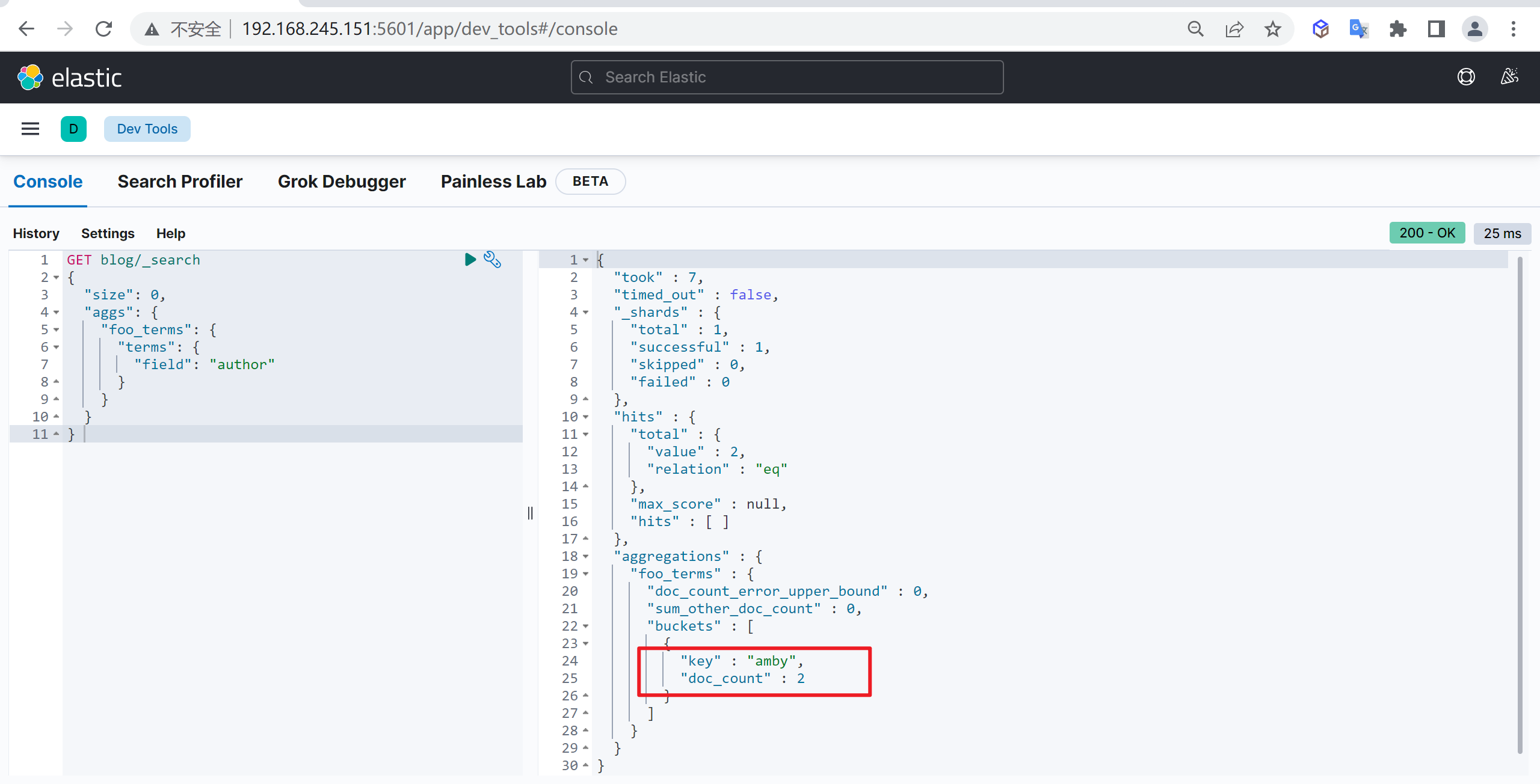

使用统计信息

当用户不太清楚具体要搜索什么的时候,可以通过几种方式来协助他们 。

一种方法是聚集统计数据, 聚集是在搜索结果里得到一些统计数据,如每个分类有多少议题、每个分 类中“赞”和“分享”的平均数量。

假想一下,进入博客时,用户会在右侧看见最近流行的议题。 其中之一是自行车。 对其感兴趣的读者会点击这个标题,进一步缩小范围。 然后, 可能还有另外 的聚集方式 ,将自行车相关的帖子分为“ 自行车鉴赏”“自行车大事件”等。

ElasticSearch的发展

起源Lucene

Lucene 是一个用 Java 编写的非常古老的搜索引擎工具 包,用来构建倒排索引(一种数据结构)和对这些索引进行检索,从而实现全文检索功能。

缺点

Lucene,必须使用Java来作为开发语言并将其直接集成到你的应用中,并且Lucene的配置及使用非常复杂,你需要深入了解检索的相关知识来理解它 是如何工作的,有以下缺点

- 只能在Java项目中使用,并且要以jar包的方式直接集成项目中

- 使用非常复杂-创建索引和搜索索引代码繁杂

- 不支持集群环境-索引数据不同步(不支持大型项目)

- 索引数据如果太多就不行,索引库和应用所在同一个服务器,共同占用硬盘,共用空间少。

lunce 单独占用内存?

诞生

ElasticSearch的创始人期初是为了能够为妻子开发一个菜谱搜索应用而接触的Lucene

它本身不是一个应用程序无法直接提供用户使用,同样对其他语言不友好的,那么ElastiSearch的开发者在使用过程中遇到的一系列问题,他就在Lucene的基础上对之进行不断的优化形成了自己的一套应用程序‘Compass’。

后来它自己在工作中同样遇到了一个需要高性能,分布式的搜索服务,所以他就在‘Compass’的基础之上重新构建起了ElasticSearch,从设计之初的目标就是打造成分布式、高性能、基于JSON、Restful的易用性可易用与其他语言的独立服务。

发展

围绕ElasticSearch后来成立一家公司(Elastic公司)全面围绕ElasticSearch或者说是数据生态进行发展,该公司已经在去年上市(ESTC),上市当天暴涨

ELasticSearch当前已经可以与多种客户端进行集成Python、PHP、.NET、Java等,当前同样支持与Hadoop、Spark等大数据分析平台进行集成。

ElasticSearch衍生出一系列的开源项目,例如业内较火的ELK Stack,ELK Stack是负责数据检索服务的ElasticSearch、数据采集解析服务的Logstash和负责数据可视化服务的Kibana的简称,Logstash是由Java语言编写的,同时负责数据的采集与解析工作,会导致服务的CPU与内存资源占用过高,后来ELastic又推出采用Go语言编写的Beats家族

ElasticSearch基本概念

索引类型

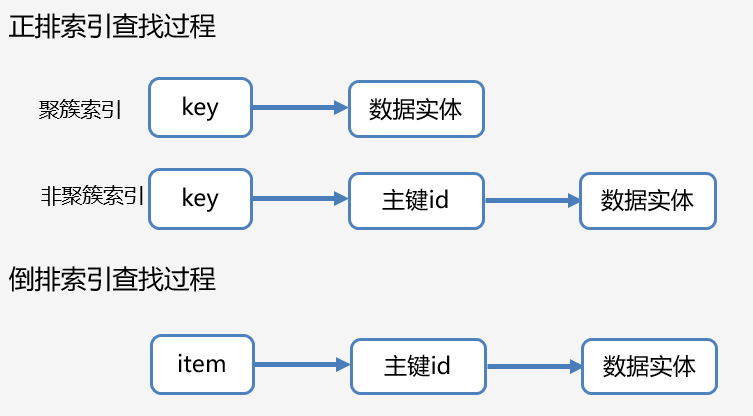

我们常见的索引包括正排索引和倒排索引

正排索引

正排索引是以文档的ID为关键字,表中记录文档中每个字段的位置信息,查找时扫描表中每个文档中字段的信息直到找出所有包含查询关键字的文档

正排索引说明

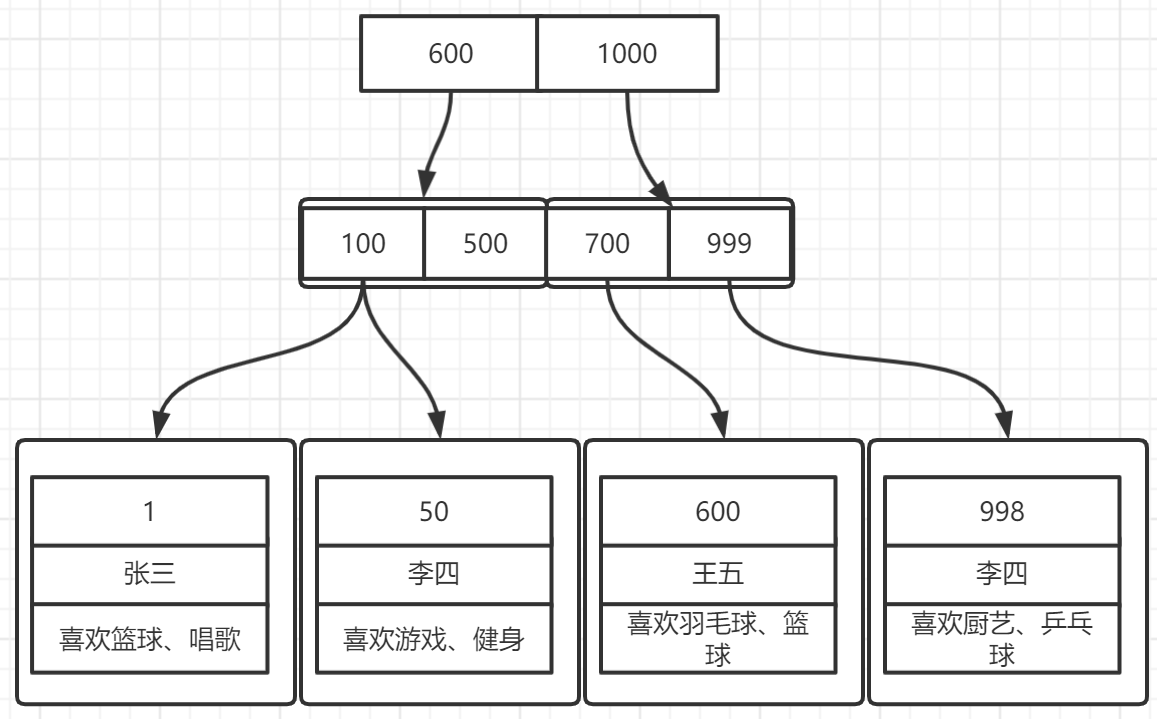

拿MySQL Innodb的聚簇索引来说,如下图所示,一个极简版(无页属性)的B+树索引结构大概是这样,叶子节点存放完整数据,非叶子节点存放建立对应聚簇索引对应的字段(主键),一条可以使用到聚簇索引的SQL,会依次从上到下进行B+树的查找直到字段一致;

CREATE TABLE user_info (

id int,

name varchar(16),

hobby varchar(256)

);

索引查询

而对应非聚簇索引只是叶子节点的内容存放的是该表的主键信息,查询的顺序则是 先通过非聚簇索引的字段找到叶子节点中一致的 单个或者多个主键id,再使用这些主键id进行回表,最终获得对应的完整实体数据。

全表扫描

如果我们看上面在mysql中表的hobby爱好字段,如果我们有业务需求:根据用户爱好关键字如“篮球”去查询对应用户列表,我们怎么做,只能是写个字符串的like sql,全表扫描的逻辑。

SELECT *

FROM user_info

WHERE hobby LIKE '%篮球%';即使我们对hobby字段创建了普通索引,在Innodb引擎下,在查询中想使用字符串类型的索引也只能走最左前缀索引的逻辑,即 LIKE ‘篮球%’。

全文索引

幸好Innodb在5.6版本后支持了全文索引full text,在创建完全文索引后,查询中使用MATCH、AGAINST就能够使用全文索引了,比全表扫B+树效率会高很多,但是对应全文索引会占据相当的磁盘空间,全文索引与我们要说的倒排索引就是一个意思了。

SELECT *

FROM user_info

WHERE MATCH (hobby) AGAINST ('篮球');倒排索引

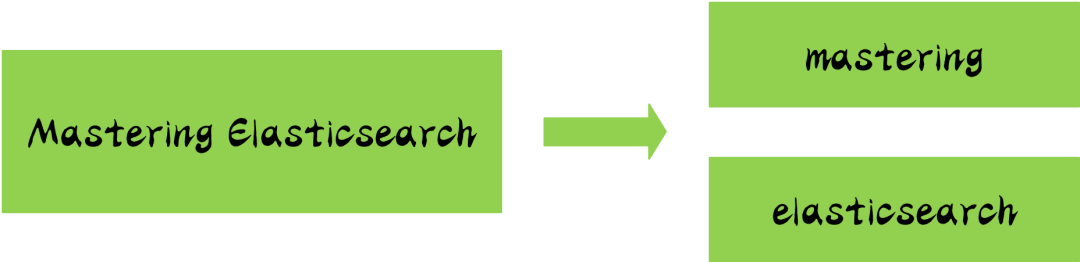

倒排索引源于实际应用中需要根据属性的值来查找记录,也就是说,不是由记录来确定属性值,而是由属性值来确定记录,因而称为倒排索引

相比B+树的正排索引,如果我们对hobby字段建立了索引,他的倒排索引极简的数据格式如下。

创建倒排索引的field,会通过分词器根据语义将字段中的field分成一个一个对应的词索引(term index),构成该类型数据的全部词索引集合,如“喜欢篮球、唱歌”会被分成 “篮球”和“唱歌”两个term index;

第二列是含有这些term index对应的文档Id,这个数据可以帮助我们最终溯源到完整实体数据;

第三列则是对应term index在该文档字段中的位置,0表示在开头的位置,这个可以帮助标注检索出来数据的高亮信息。

两种索引查找顺序

逻辑概念

假设我们在一个业务系统中选择MySQL做数据存储,那么我们需要先创建一个database,再创建一组相关的table,Elasticsearch同样具有这样的概念,使用index和mapping来组织数据,下面是Elasticsearch的一些基本概念

| 概念 | 关系型数据库 | 说明 |

|---|---|---|

| 索引库(indices) | Databases 数据库 | indices是index的复数,代表许多的索引 |

| 类型(type) | Table 数据表 | 类型是模拟mysql中的table概念,一个索引库下可以有不同类型的索引,比如商品索引,订单索引,其数据格式不同,不过这会导致索引库混乱,因此未来版本中会移除这个概念 |

| 文档(document) | Row 行 | 存入索引库原始的数据,比如每一条商品信息,就是一个文档 |

| 字段(field) | Columns 列 | 文档中的属性 |

| 映射配置(mappings) | 表结构 | 字段的数据类型、属性、是否索引、是否存储等特性 |

索引(Index)

一个索引由一个名字来标识(必须全部是小写字母),并且当我们要对这个索引中的文档进行索引、搜索、更新和删除的时候,都要使用到这个名字。

一个索引相当于数据库,是多个相似文档的集合,必须通过索引才能进行搜索,使用使用能够极大的提升查询速度,类似于词典里面的目录。

当然在底层,肯定用到了倒排索引,最基本的结构就是“keyword”和“PostingList”,Postinglist就是一个int的数组,存储了所有符合某个term的文档id,另外,这个倒排索引相比特定词项出现过的文档列表,会包含更多其它信息。

它会保存每一个词项出现过的文档总数,在对应的文档中一个具体词项出现的总次数,词项在文档中的顺序,每个文档的长度,所有文档的平均长度等等相关信息。

类型(Type)

一个类型过去是索引的逻辑类别/分区,允许你在同一索引中存储不同类型的文档

例如,一种类型用于用户,另一种类型用于博客文章,在索引中创建多个类型不再可能,类型的整个概念将在稍后的版本中删除,相当于sql领域中表的概念。

类型的变化

在不同的elasticsearch中,类型发生了不同的变化

| 版本 | Type |

|---|---|

| 5.x | 支持多种Type |

| 6.x | 只有一种Type |

| 7.x | 默认不在支持自定义的索引类型,默认类型为_doc |

文档(Document)

一个文档是可以被索引的一个基本单元,相当于数据库中的一条数据,索引和搜索数据的最小单位是文档

字段(Field)

相当于数据库表的字段,每个字段有不同的类型

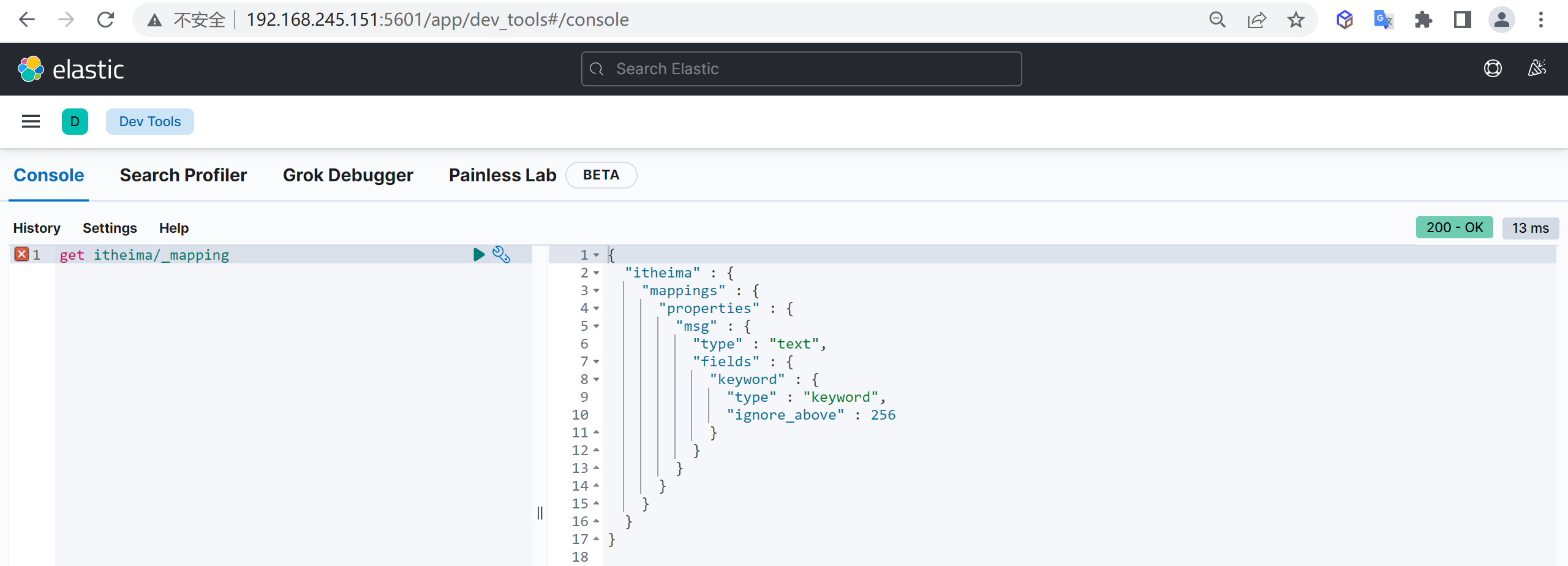

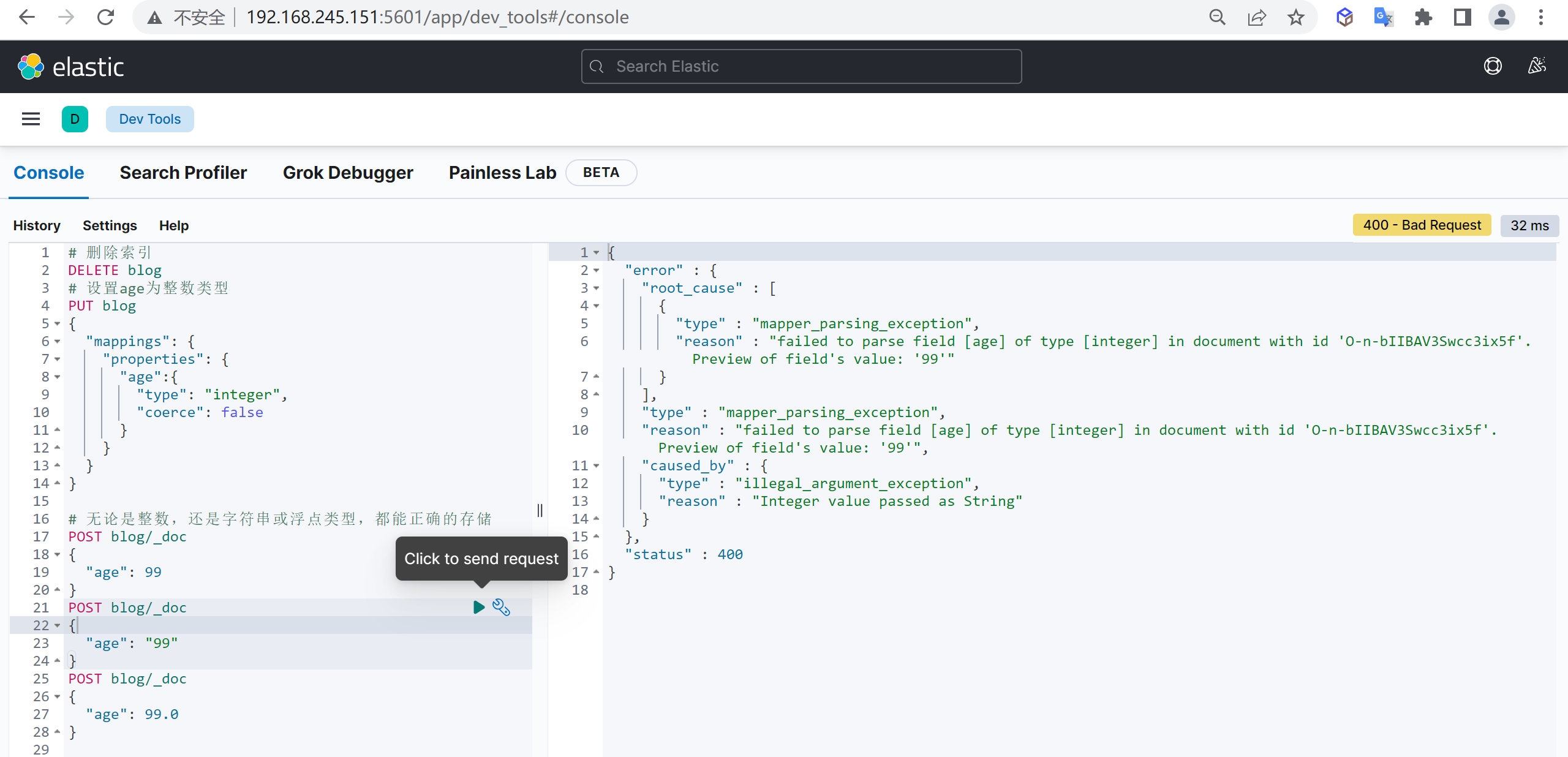

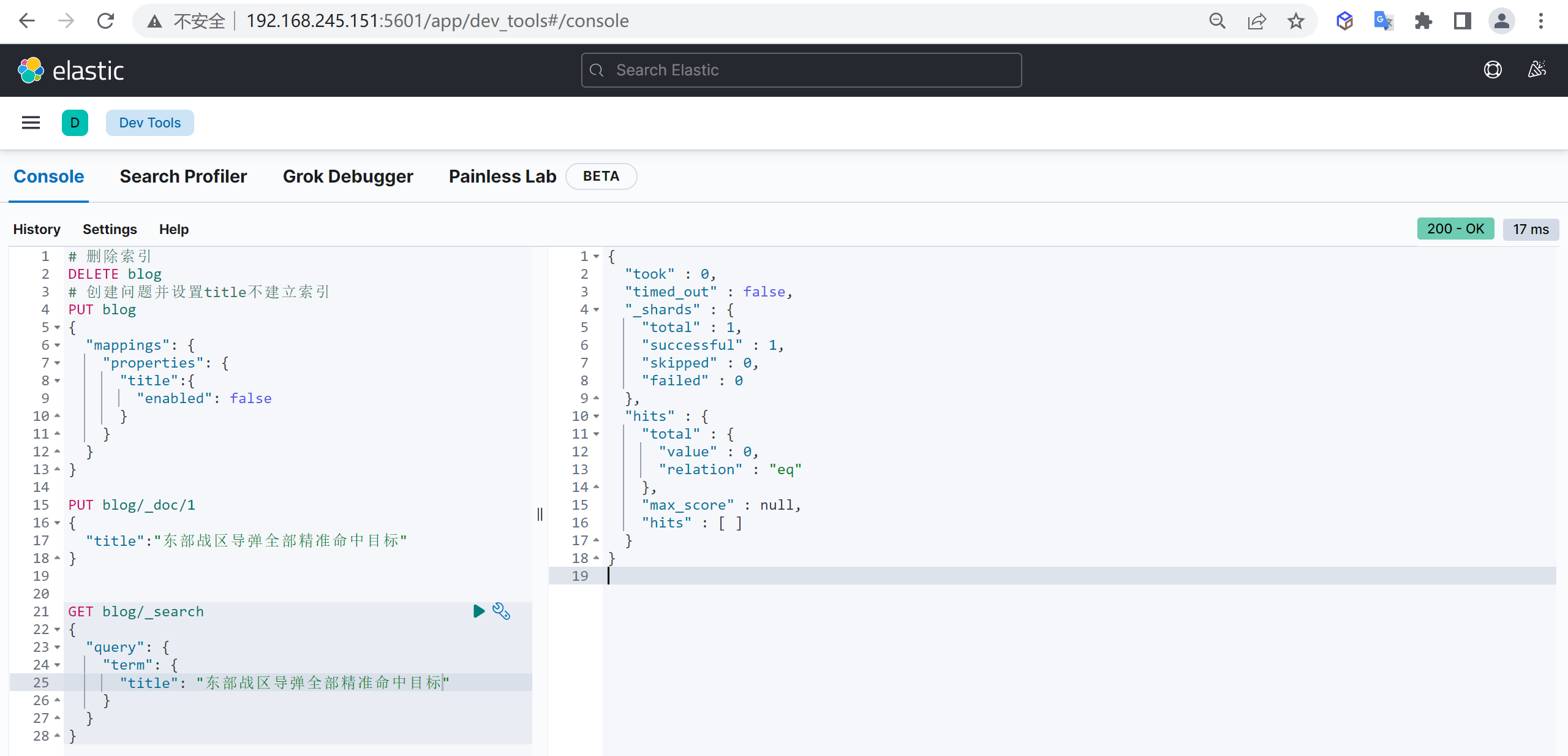

映射(Mapping)

Mapping是对处理数据时的方式和规则作出一定的限制,如字段的类型、默认值、分析器、是否被索引等,映射定义了每个字段的类型、字段所使用的分词器等。

可以显式映射,由我们在索引映射中进行预先定义,也可以动态映射,在添加文档的时候,由es自动添加到索引,这个过程不需要事先在索引进行字段数据类型匹配等等,es会自己推断数据类型。

get itheima/_mapping

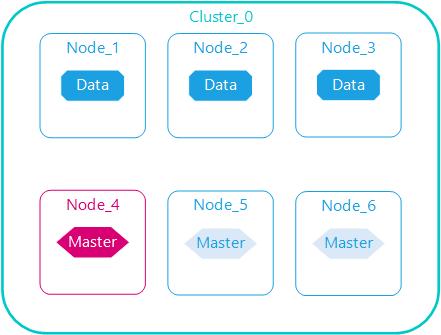

物理概念

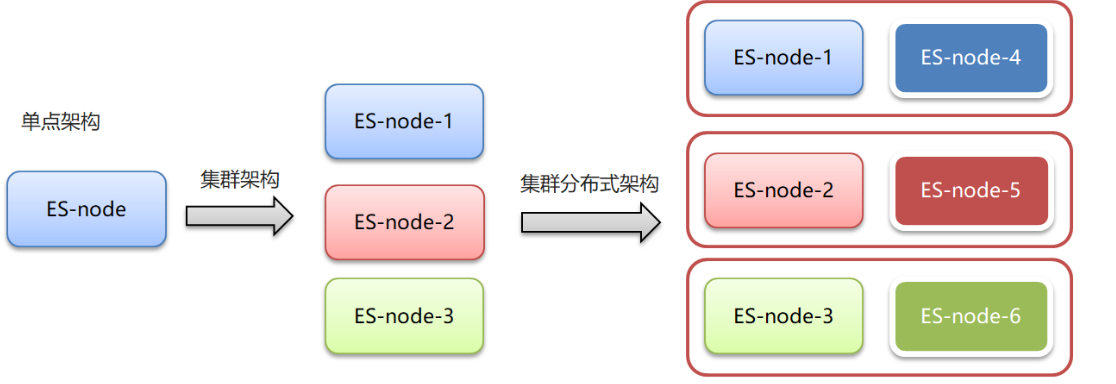

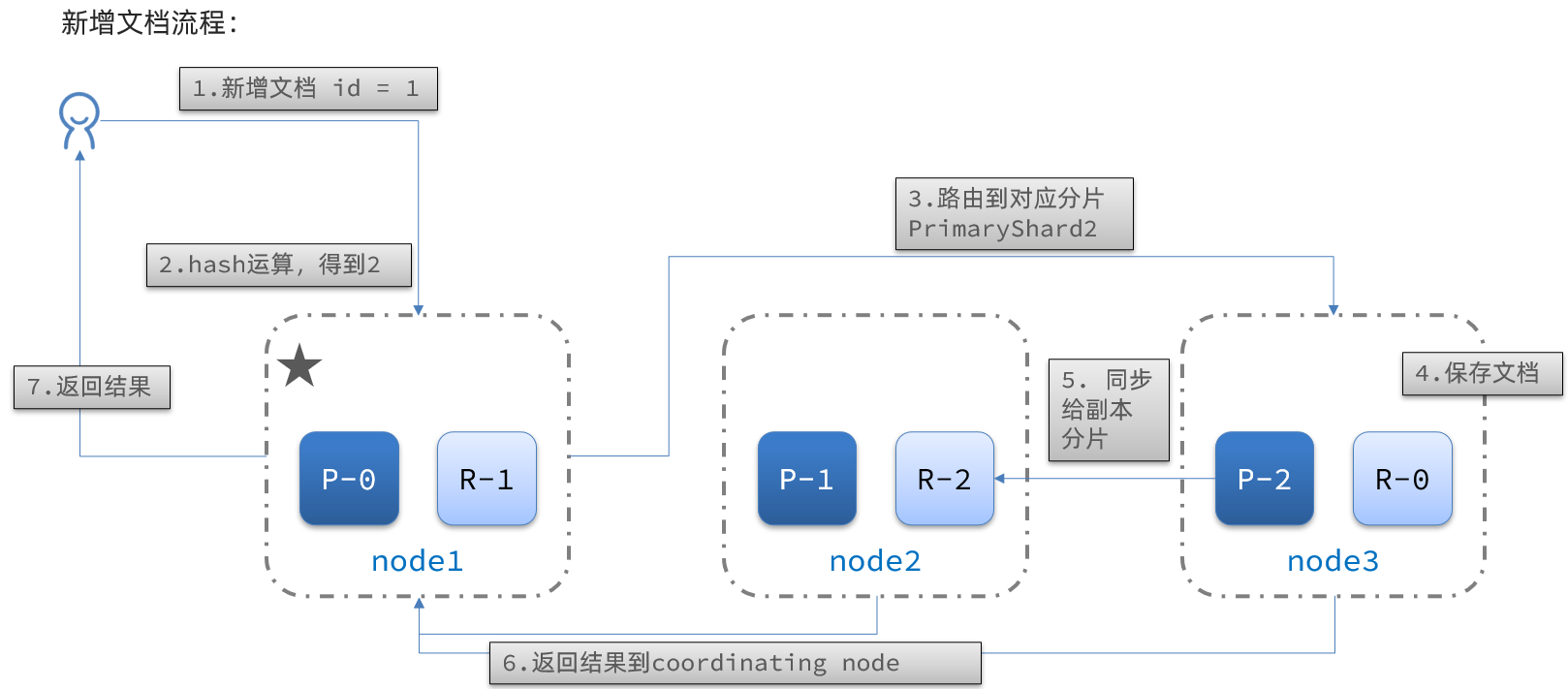

Elasticsearch是一个分布式系统,其数据会分散存储到不同的节点上,为了实现这一点,需要将每个index中的数据划分到不同的块中,然后将这些数据块分配到不同的节点上存储

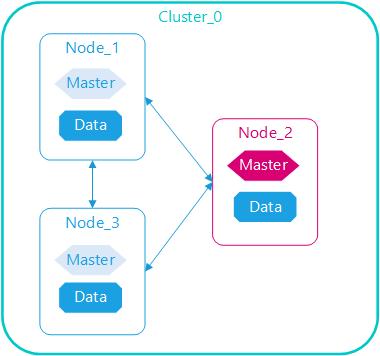

集群 (cluster)

一个集群就是由一个或多个节点组织在一起,它们共同持有整个的数据,并一起提供索引和搜索功能

集群(cluster)是一个或多个节点(node)的集合,这些节点 将共同拥有完整的数据,并跨节点提供联合索引、搜索和分析功能。

集群(cluster)是一个或多个节点(node)的集合,这些节点 将共同拥有完整的数据,并跨节点提供联合索引、搜索和分析功能。

一个集群由一个唯一的名字标识,这个名字默认就是“elasticsearch”,这个名字是重要的,因为一个节点只能通过指定某个集群的名字,来加入这个集群。

ES集群是一个 P2P类型(使用 gossip 协议)的分布式系统,除了集群状态管理以外,其他所有的请求都可以发送到集群内任意一台节点上,这个节点可以自己找到需要转发给哪些节点,并且直接跟这些节点通信,所以从网络架构及服务配置上来说,构建集群所需要的配置极其简单

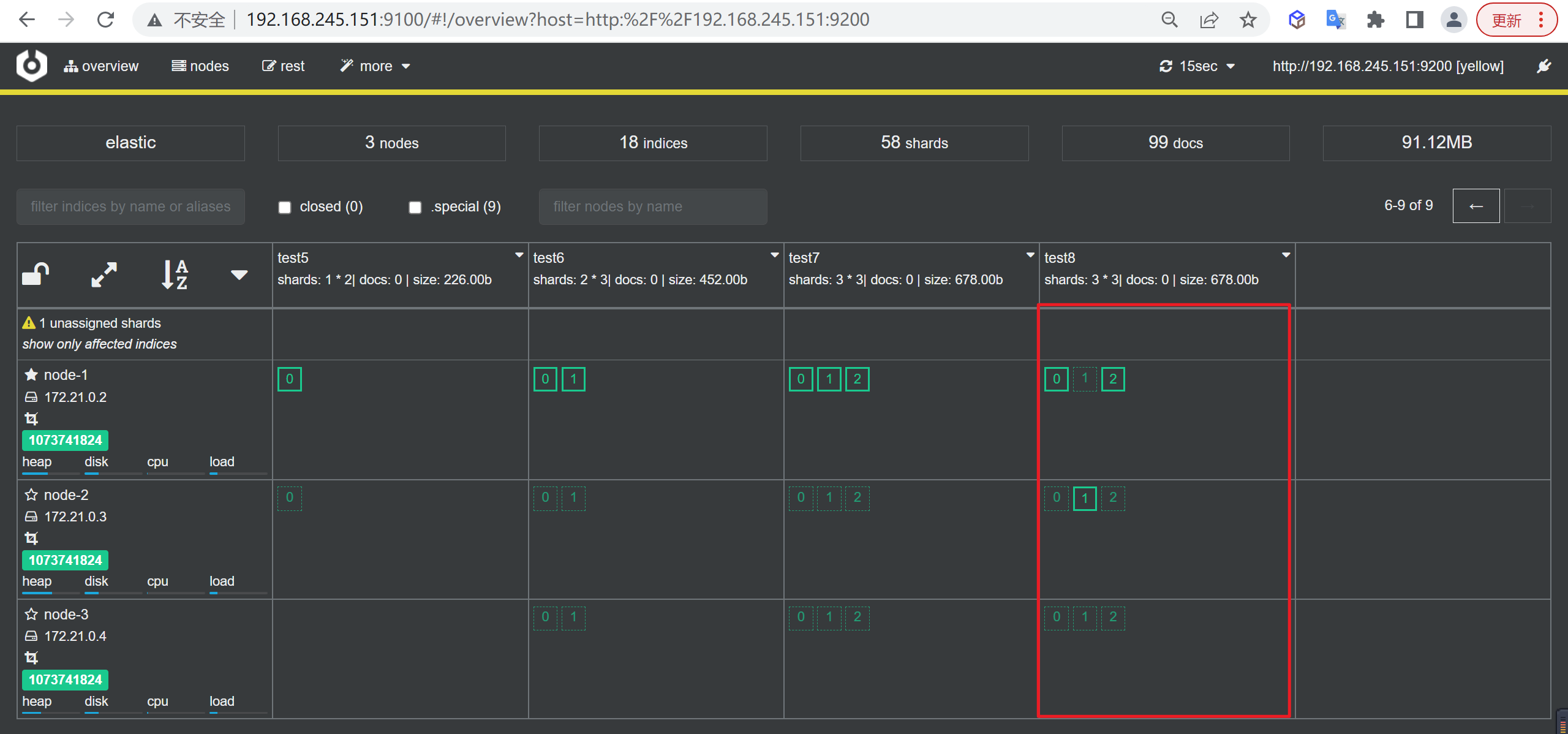

集群中节点数量没有限制,一般大于等于2个节点就可以看做是集群了,一般处于高性能及高可用方面来考虑一般集群中的节点数量都是3个及3个以上。

节点(node)

一个节点是集群中的一个服务器,作为集群的一部分,它存储数据,参与集群的索引和搜索功能

和集群类似,一个节点也是由一个名字来标识的,默认情况下,这个名字是一个随机的漫威漫画角色的名字,这个名字会在启动的时候赋予节点

一个节点可以通过配置集群名称的方式来加入一个指定的集群,默认情况下,每个节点都会被安排加入到一个叫做“elasticsearch”的集群中,这意味着,如果你在你的网络中启动了若干个节点,并假定它们能够相互发现彼此,它们将会自动地形成并加入到一个叫做“elasticsearch”的集群中。

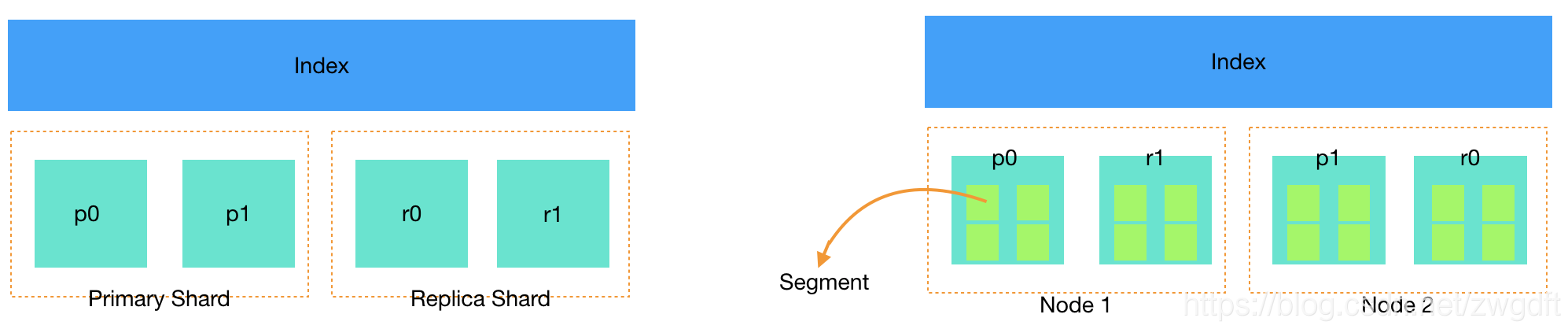

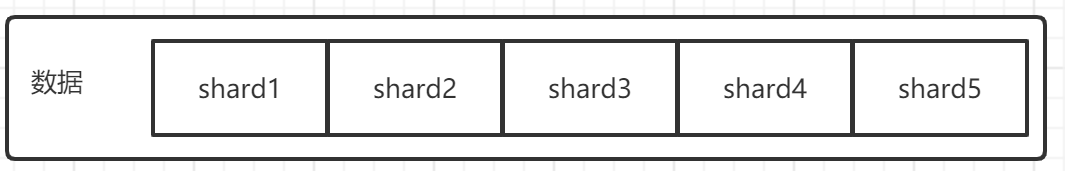

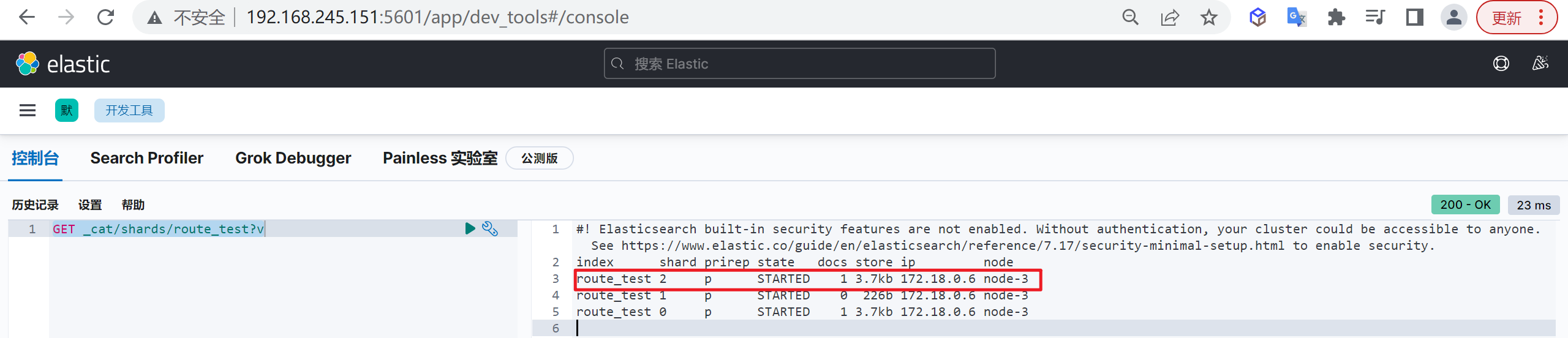

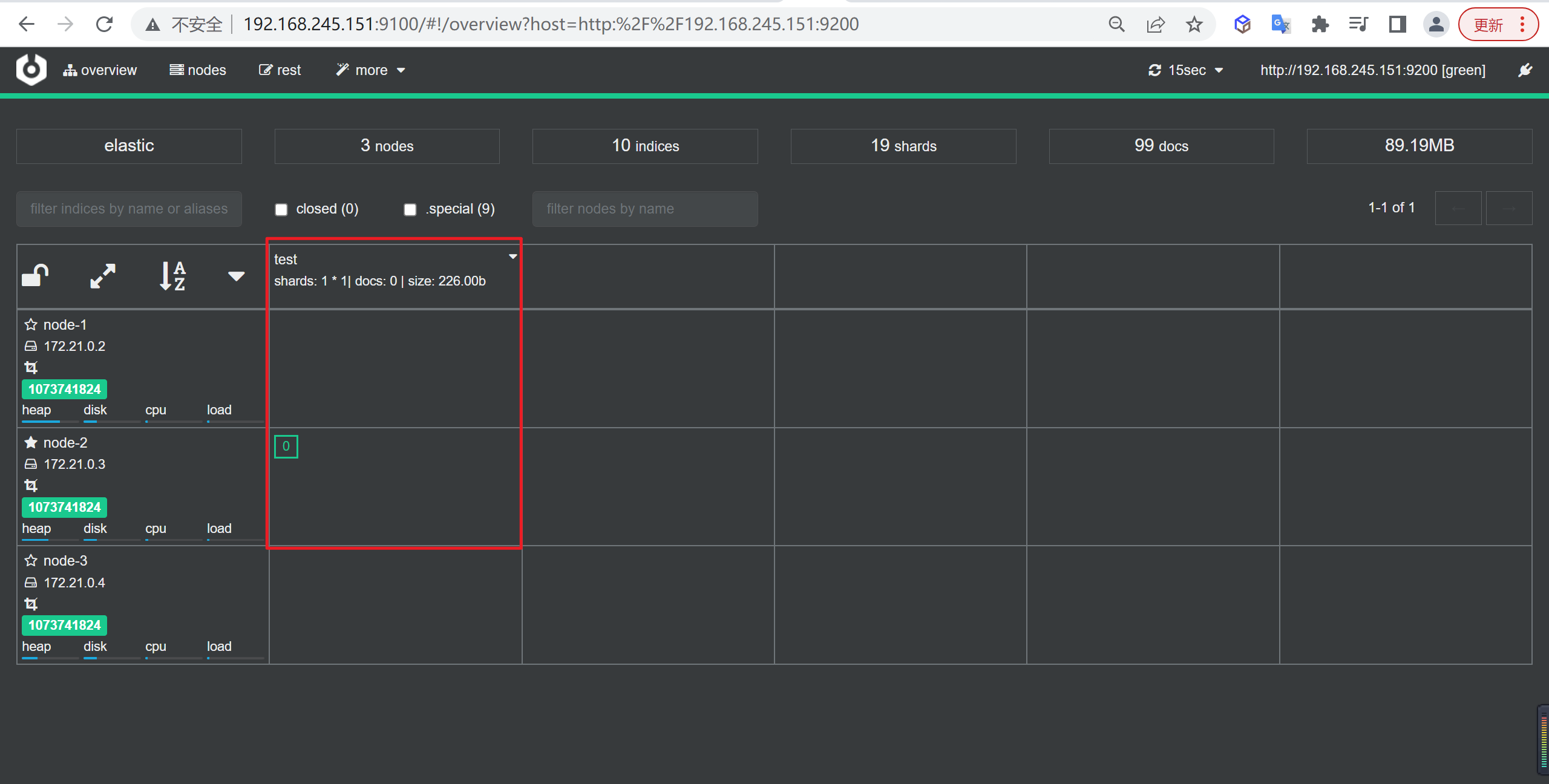

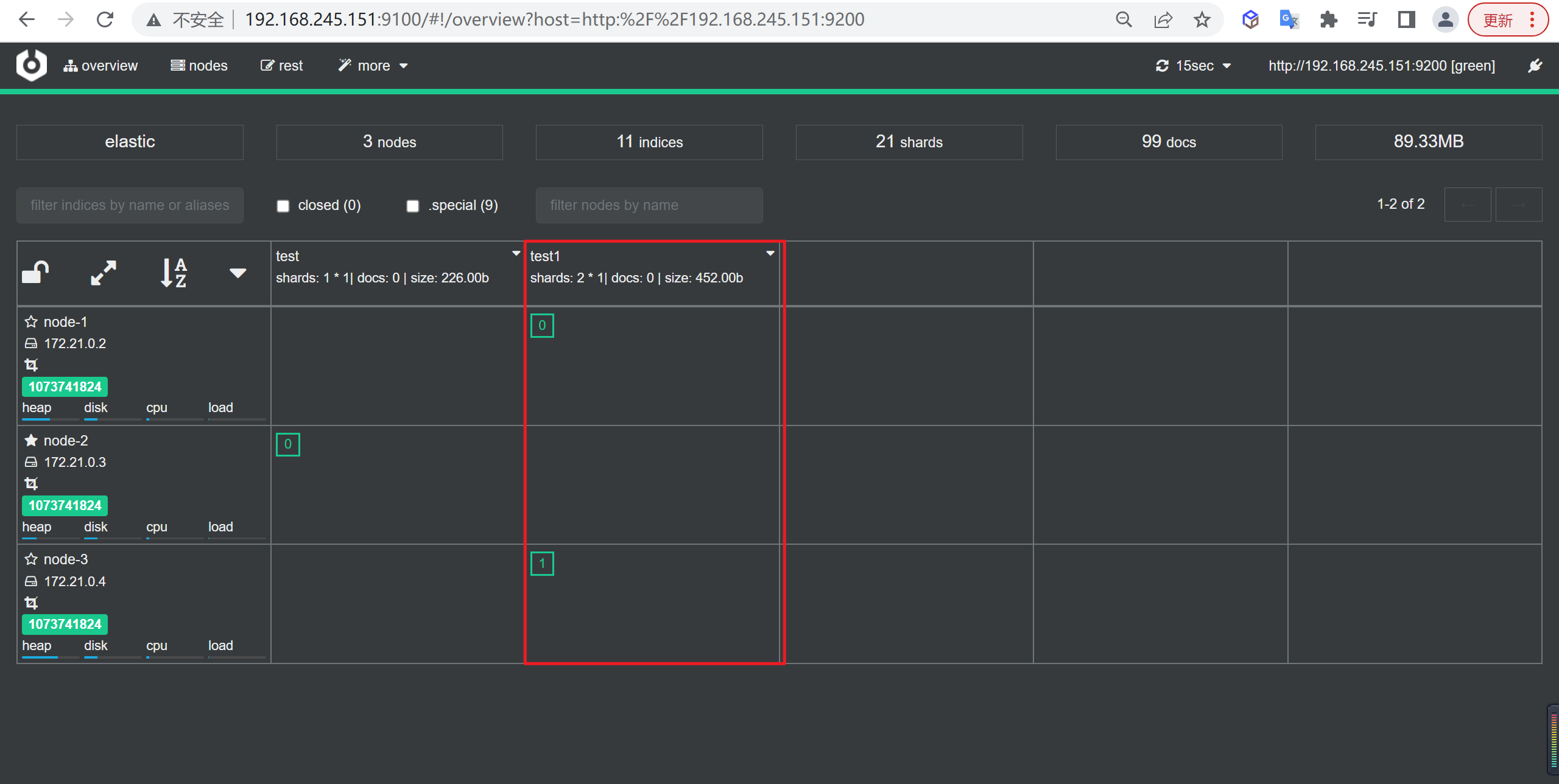

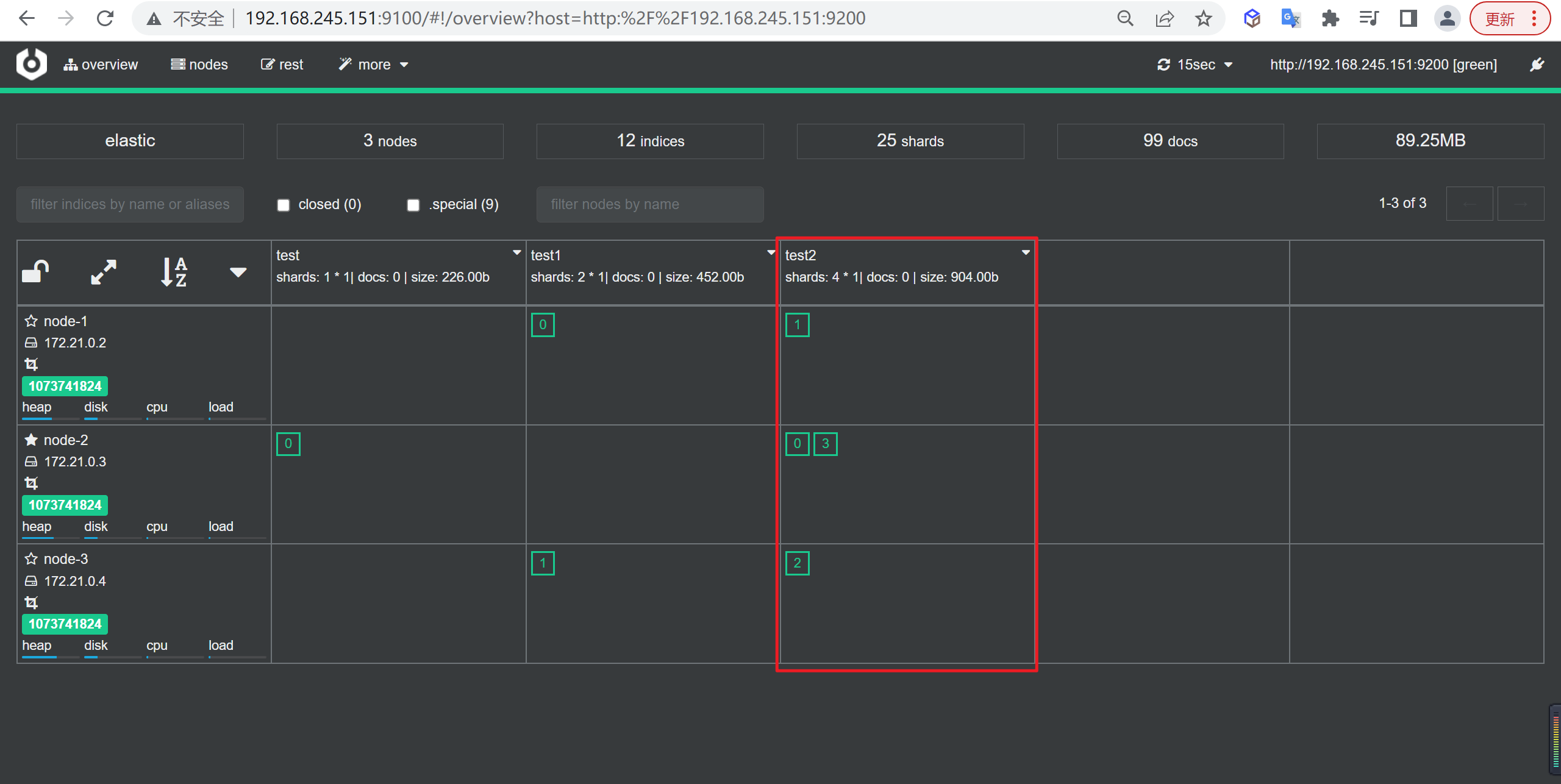

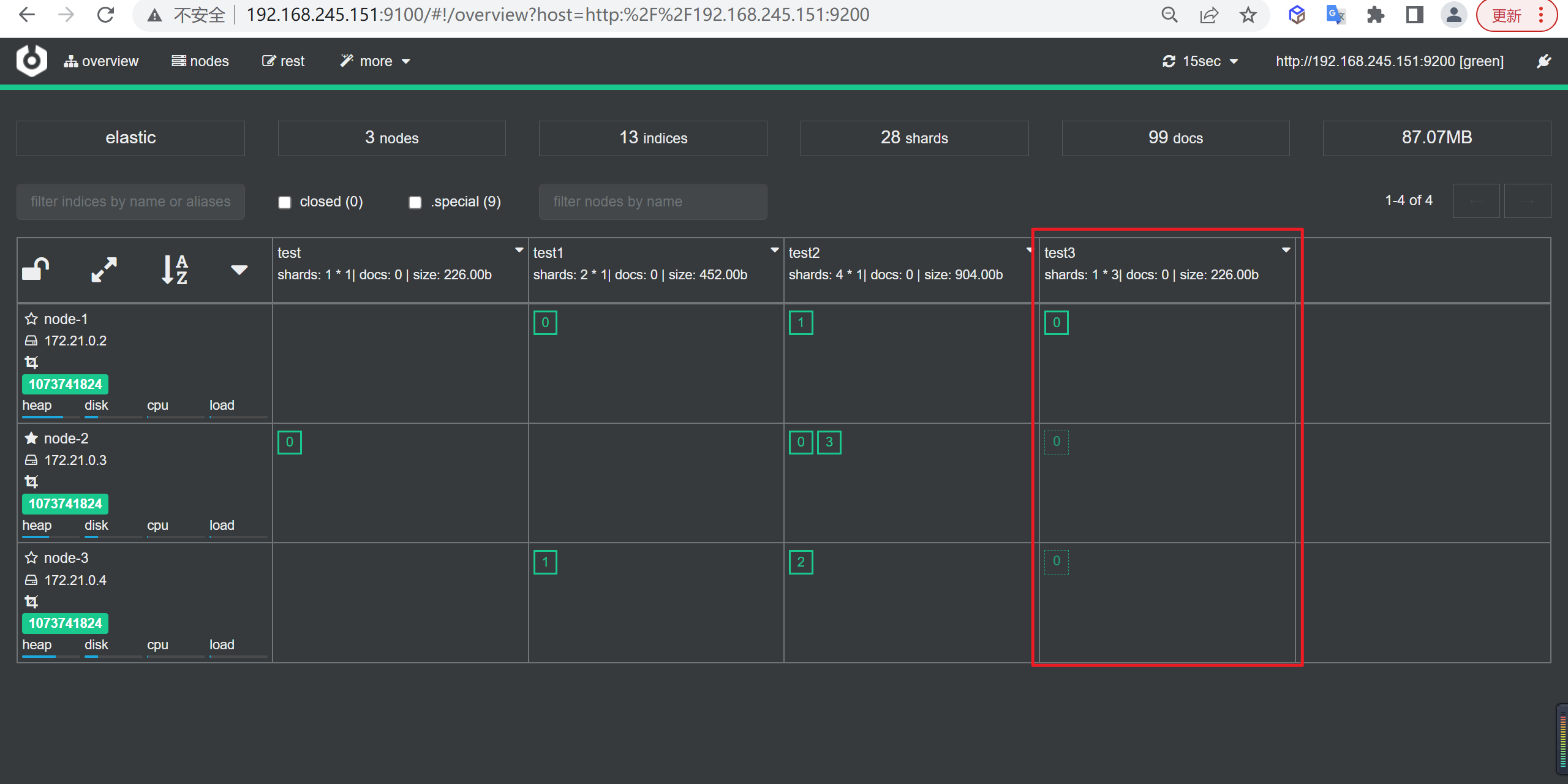

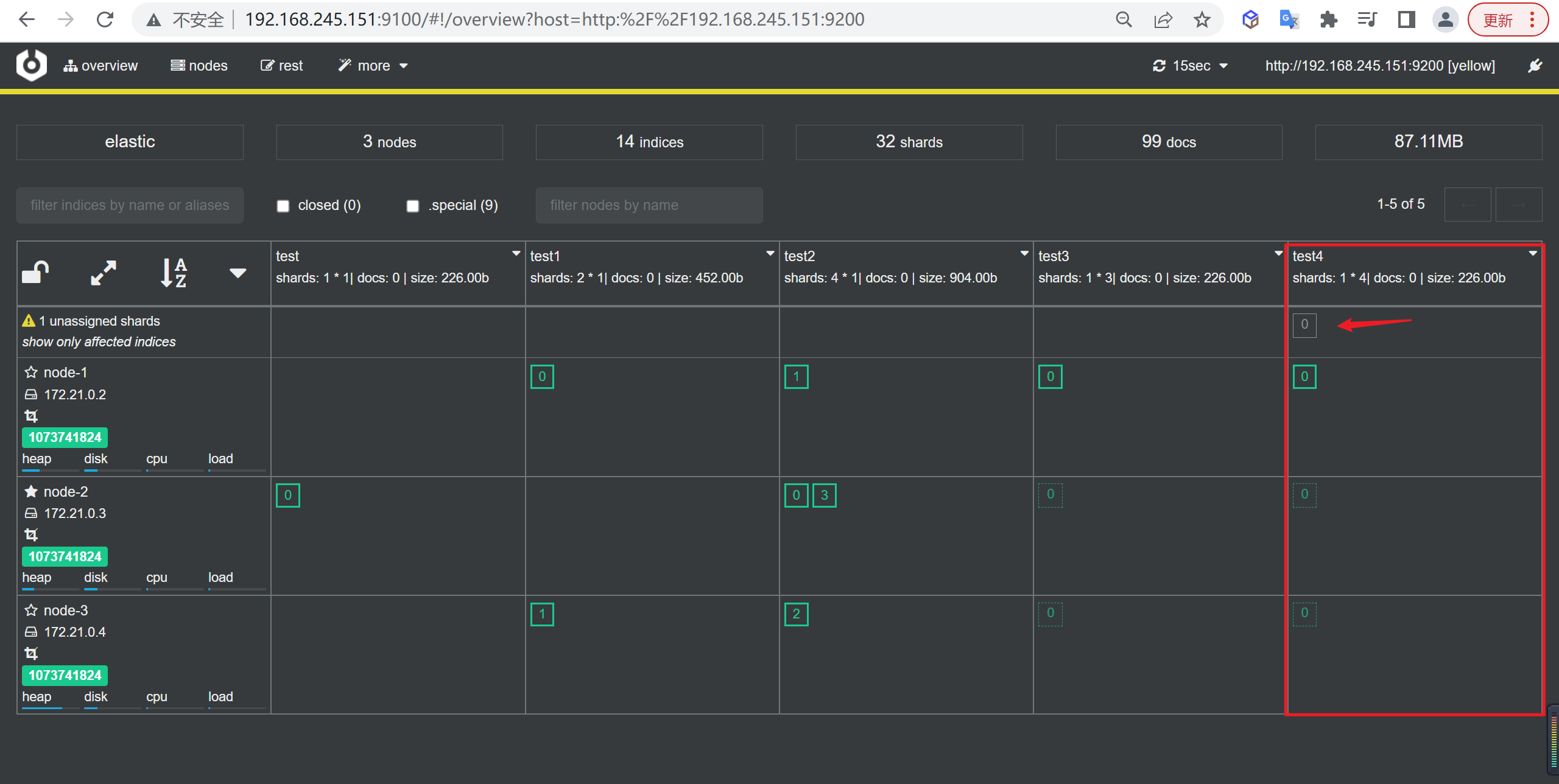

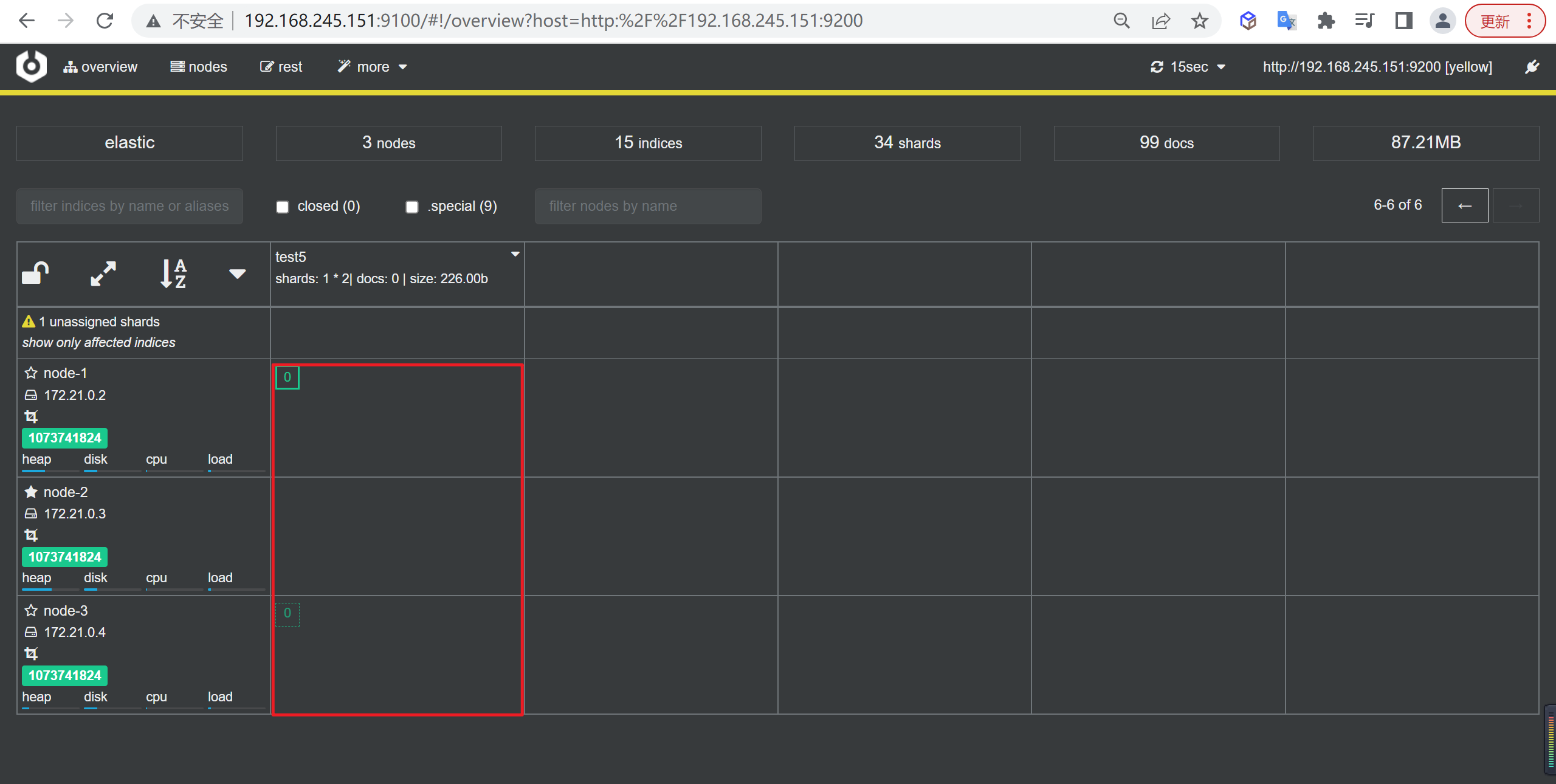

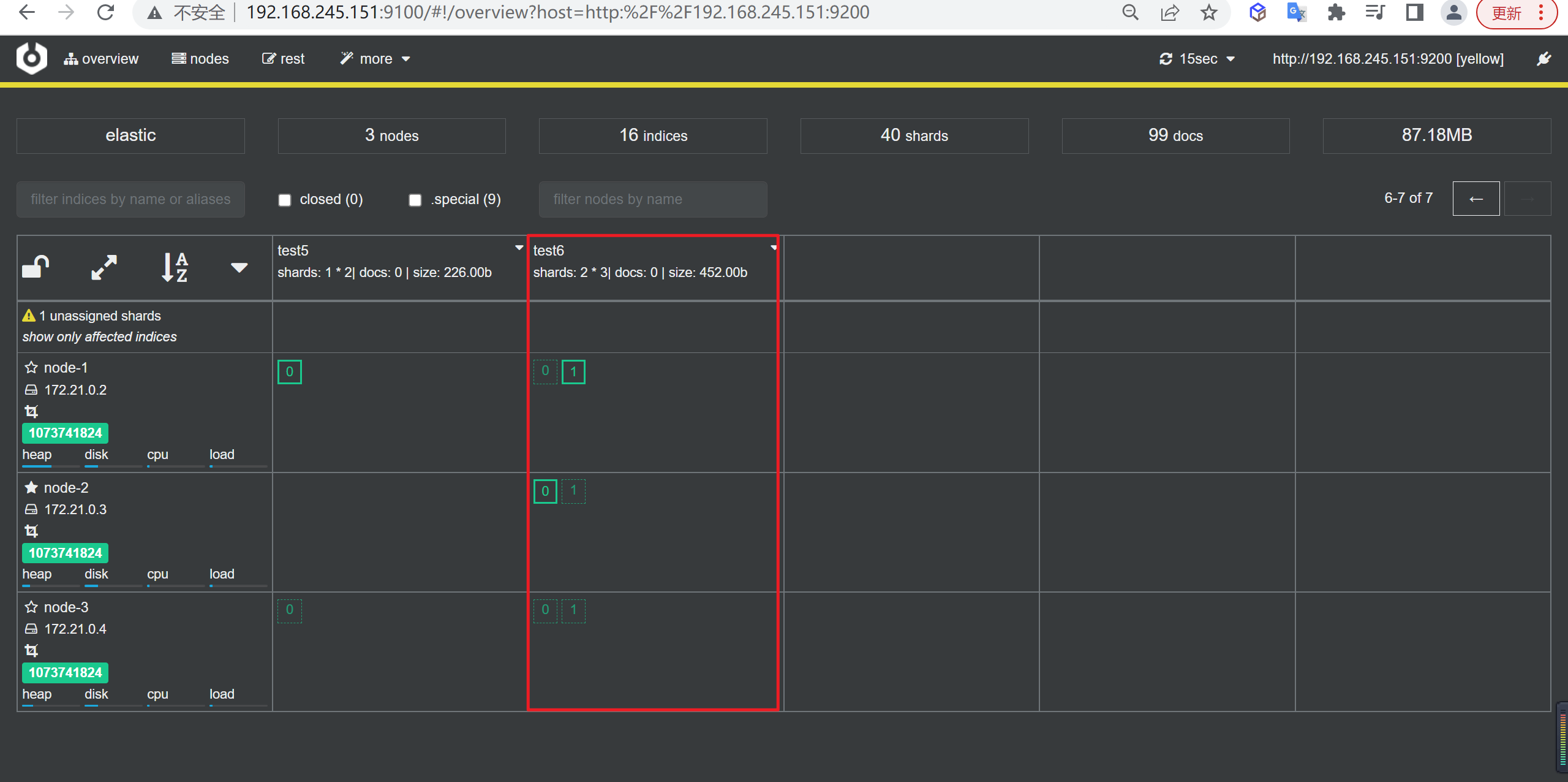

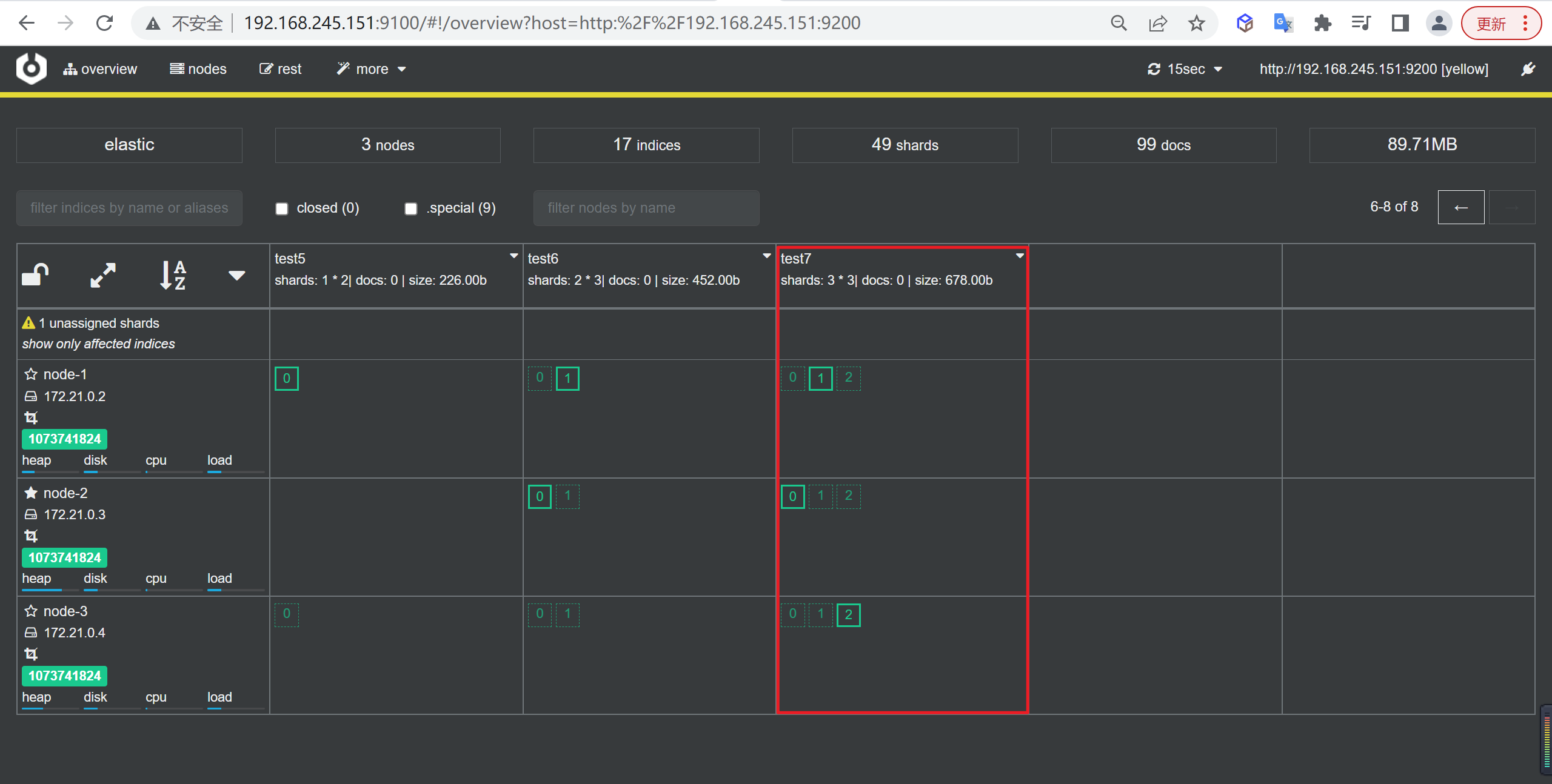

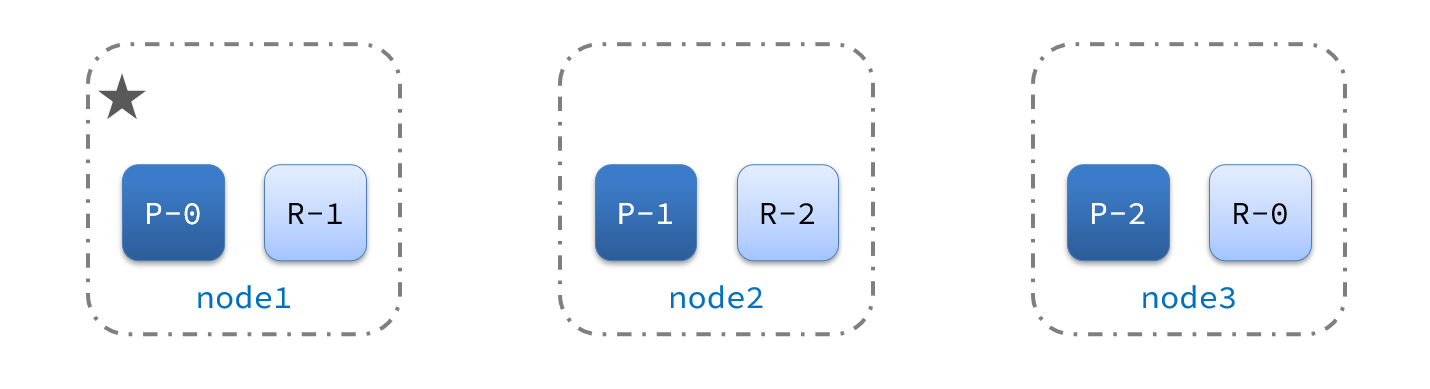

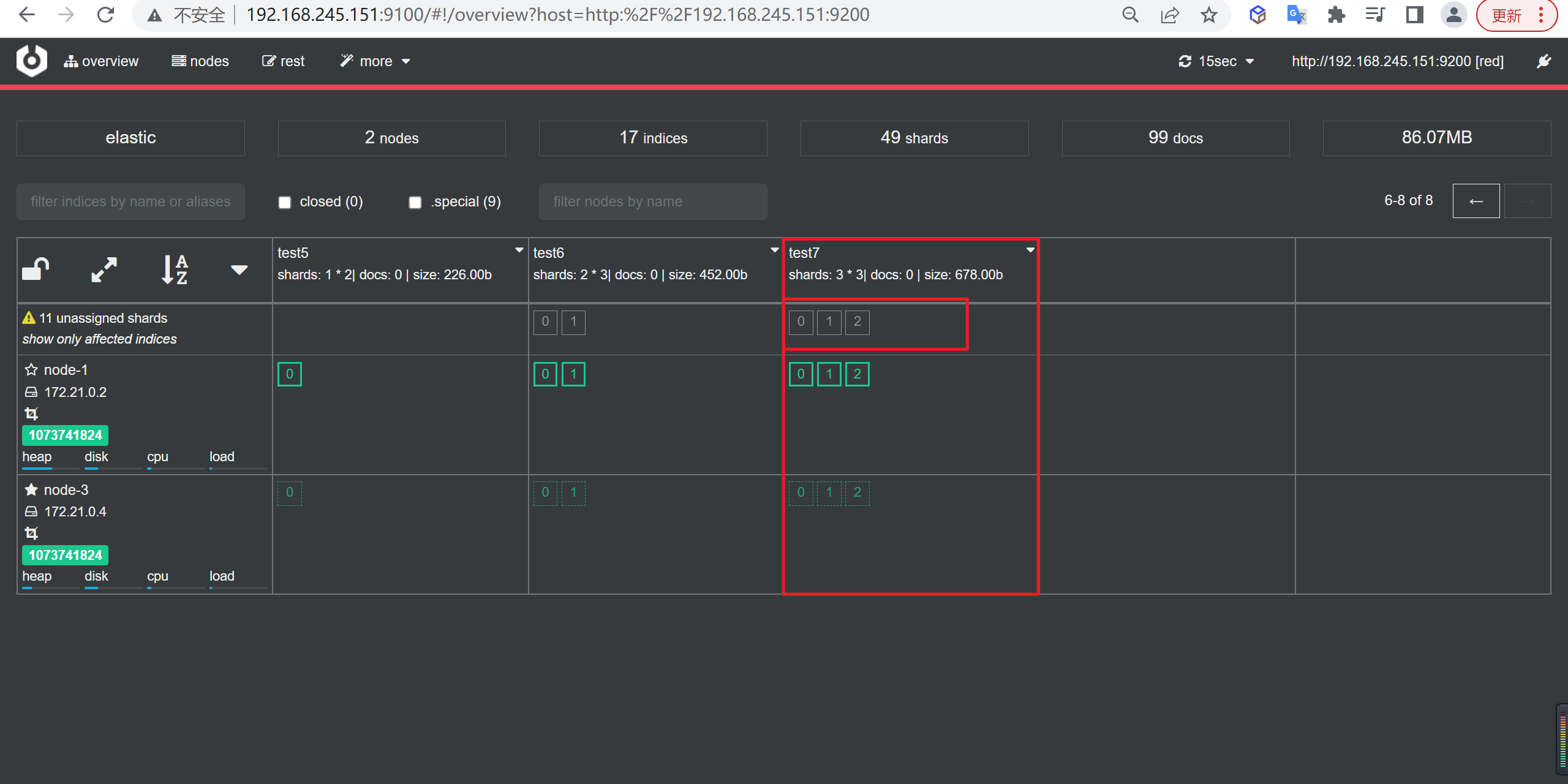

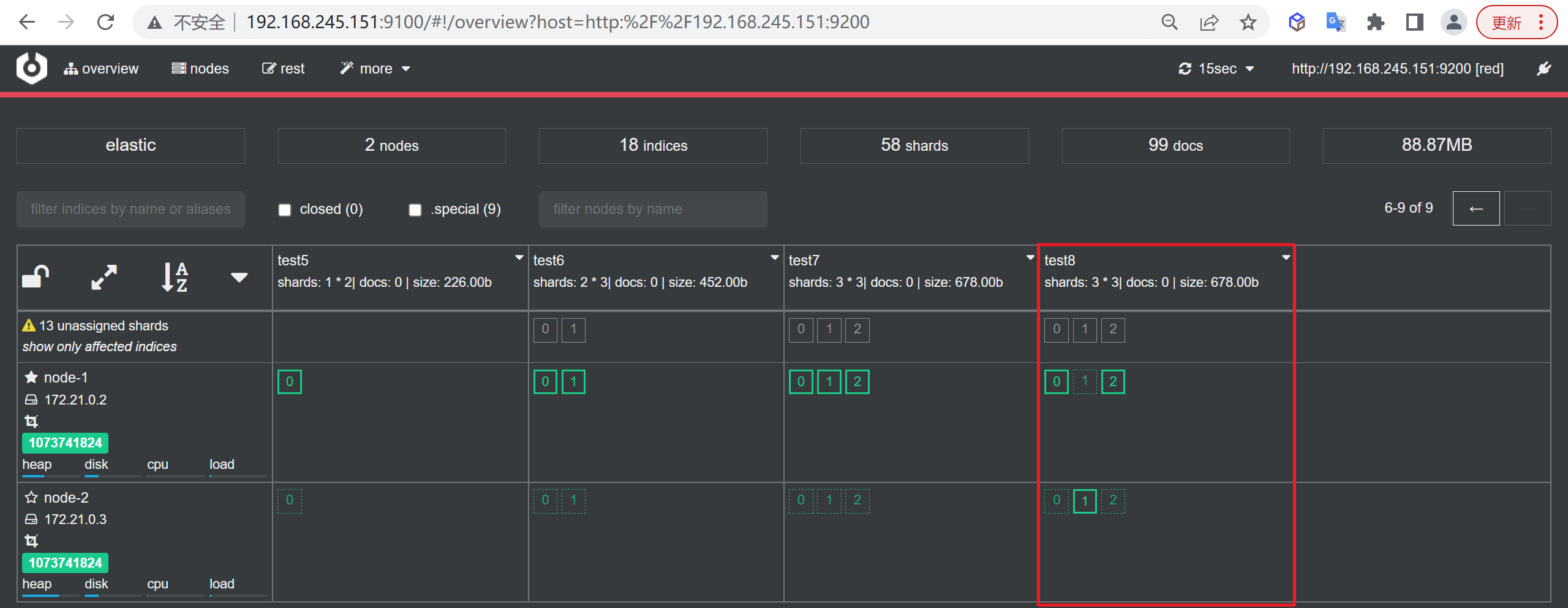

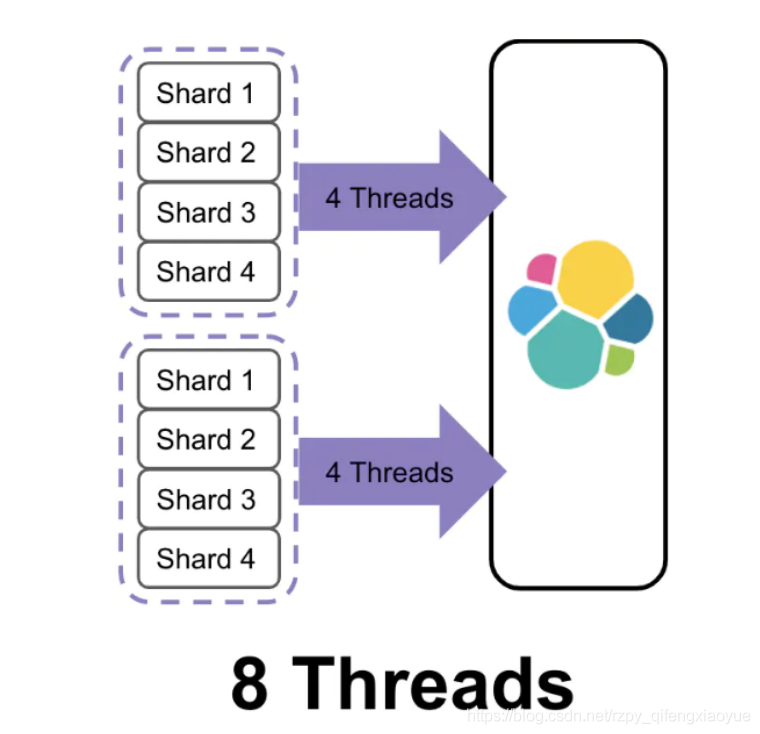

分片(Shards)

分片的存在是为了解决单个索引大量文档的存储问题、以及搜索是响应慢等问题。

比如,一个具有10亿文档的索引占据1TB的磁盘空间,而任一节点都没有这样大的磁盘空间,或者单个节点处理搜索请求,响应太慢,为了解决这个问题,Elasticsearch提供了将索引划分成多份的能力,这些份就叫做分片。

将一个索引划分成了多份,每一份就称之为分片,每个分片也是一个功能完善的“索引”,这个“索引”可以被放置到集群的任意节点上,通过”分”的思想,可以突破单机在存储空间和处理性能上的限制,这是分布式系统的核心目的

至于一个分片怎样分布,它的文档怎样聚合回搜索请求,是完全由Elasticsearch管理的,对于作为用户的你来说,这些都是透明的。

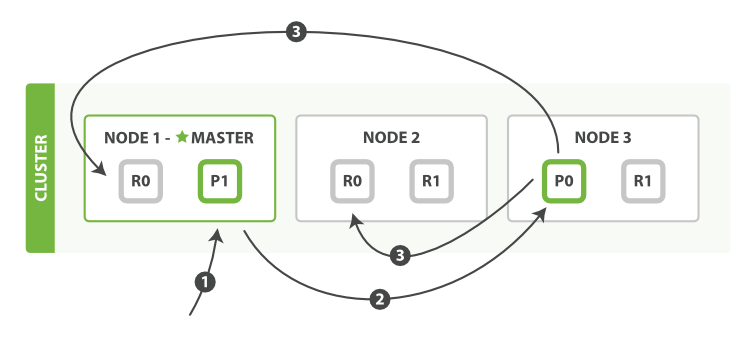

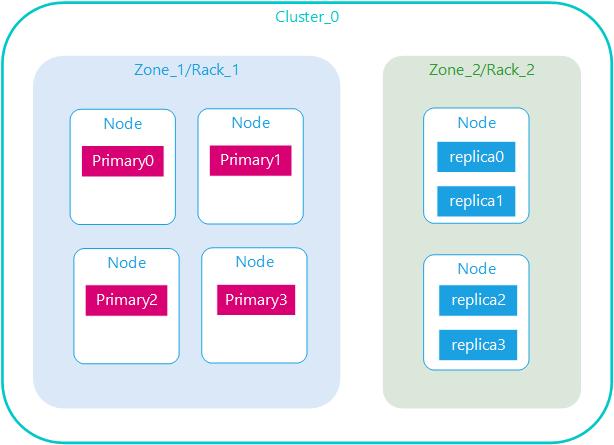

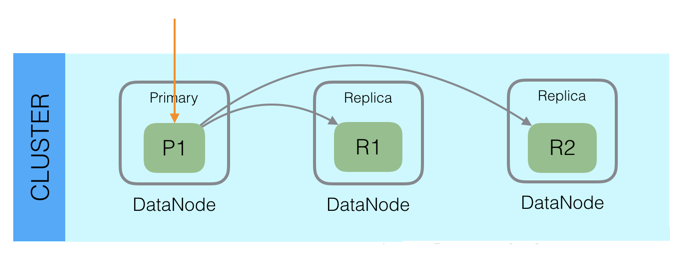

副本(Replicas)

而对于分布式存储而言,还有一个重要特性是”冗余”,因为分布式的前提是:接受系统中某个节点因为某些故障退出,为了保证在故障节点退出后数据不丢失,同一份数据需要拷贝多份存在不同节点上

在一个网络 / 云的环境里,失败随时都可能发生,在某个分片/节点不知怎么的就处于离线状态,或者由于任何原因消失了,这种情况下,有一个故障转移机制是非常有用并且是强烈推荐的。为此目的,Elasticsearch 允许你创建分片的一份或多份拷贝,这些拷贝叫做复制分片(副本)。

复制之所以重要,有两个主要原因: 在分片/节点失败的情况下,提供了高可用性。因为这个原因,注意到复制分片从不与原/主要(original/primary)分片置于同一节点上是非常重要的。扩展你的搜索量/吞吐量,因为搜索可以在所有的复制上并行运行。总之,每个索引可以被分成多个分片。一个索引也可以被复制0次(意思是没有复制)或多次。一旦复制了,每个索引就有了主分片(作为复制源的原来的分片)和复制分片(主分片的拷贝)之别。分片和复制的数量可以在索引创建的时候指定。在索引创建之后,你可以在任何时候动态地改变复制的数量,但是你事后不能改变分片的数量。

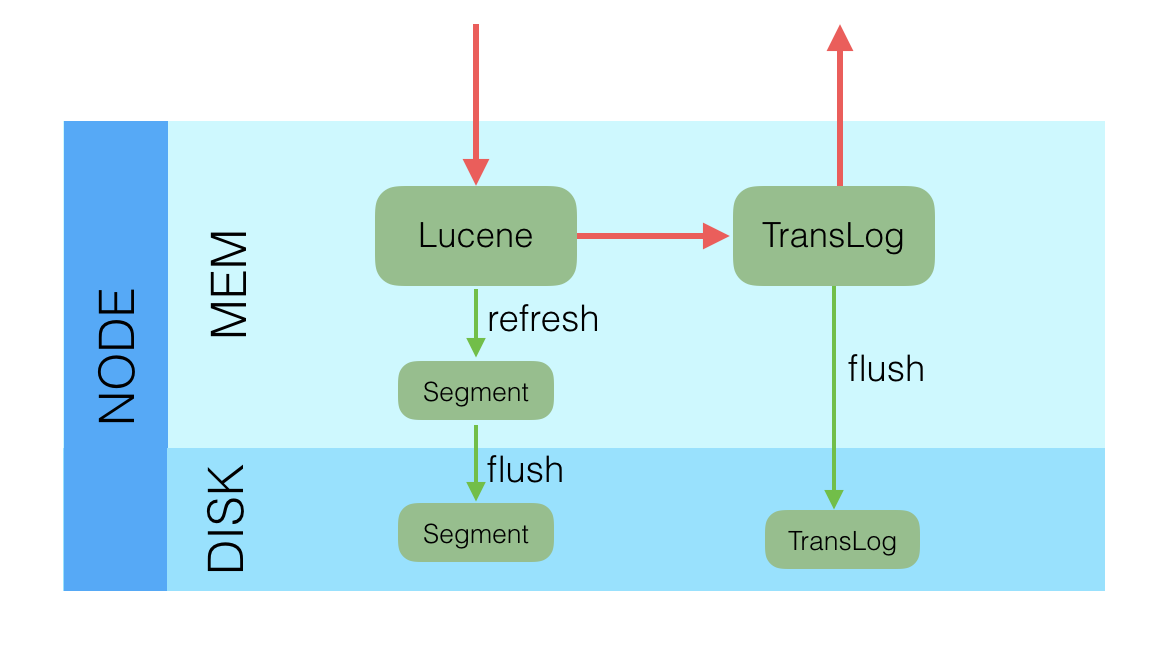

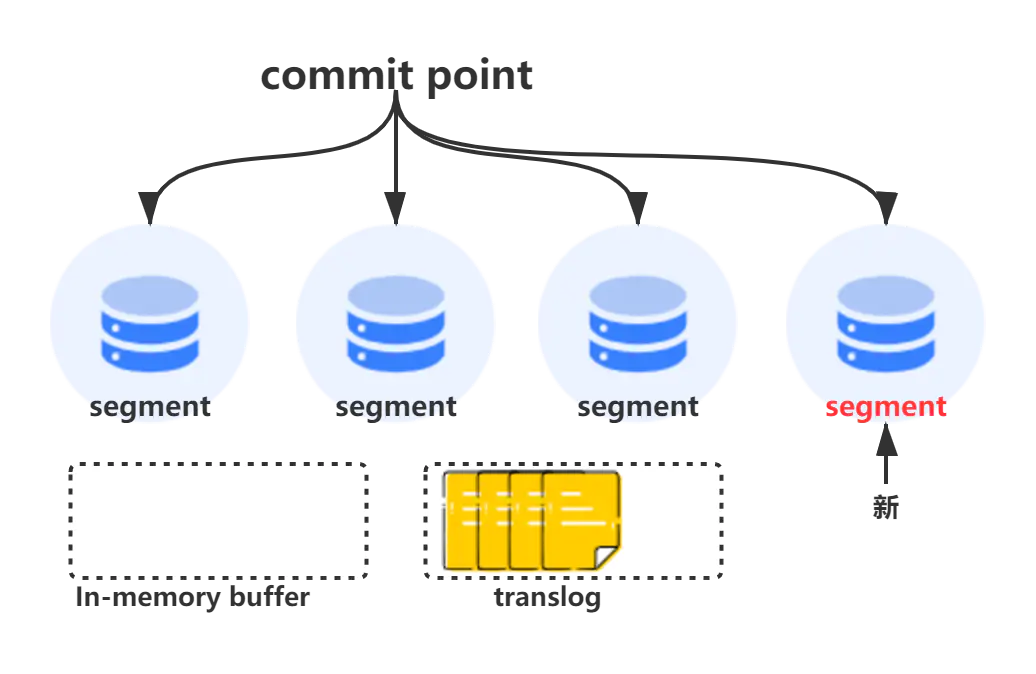

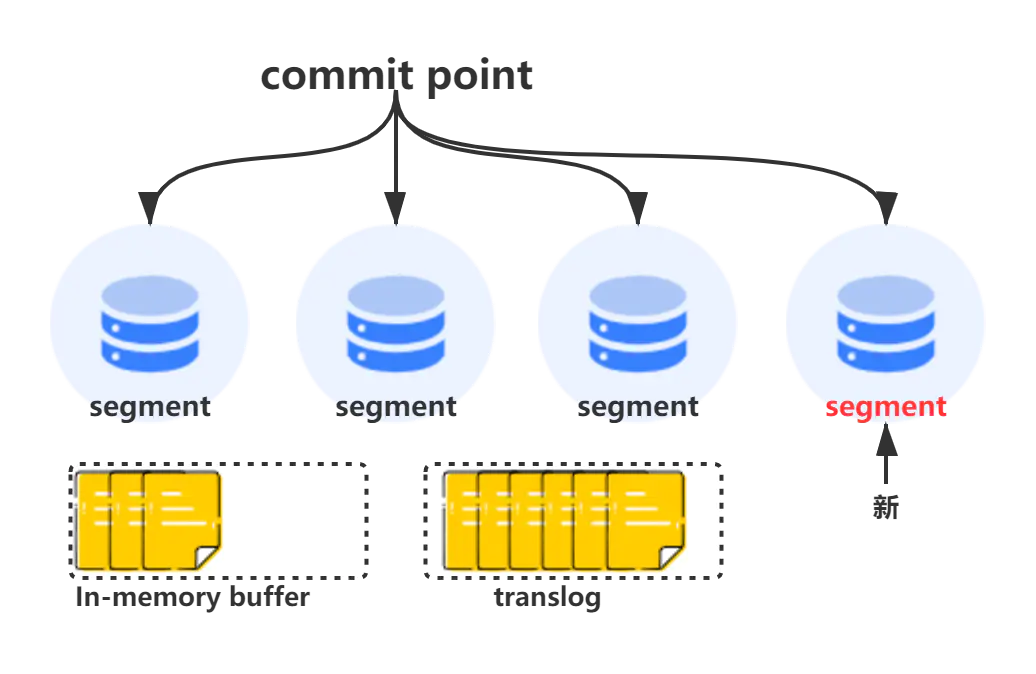

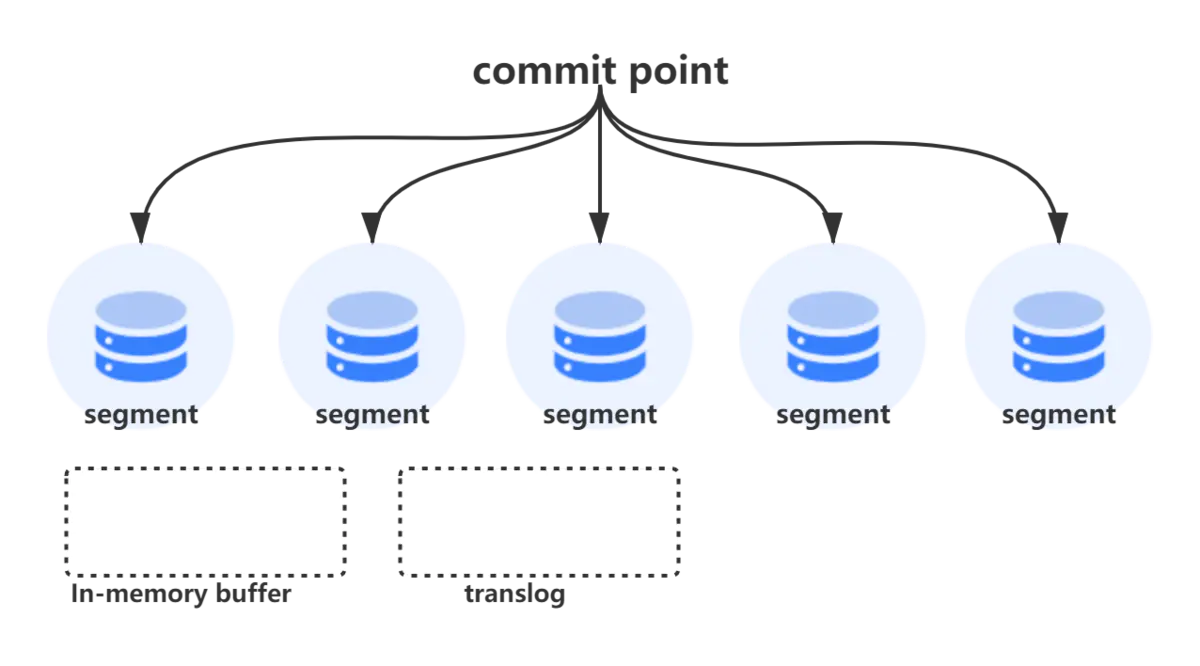

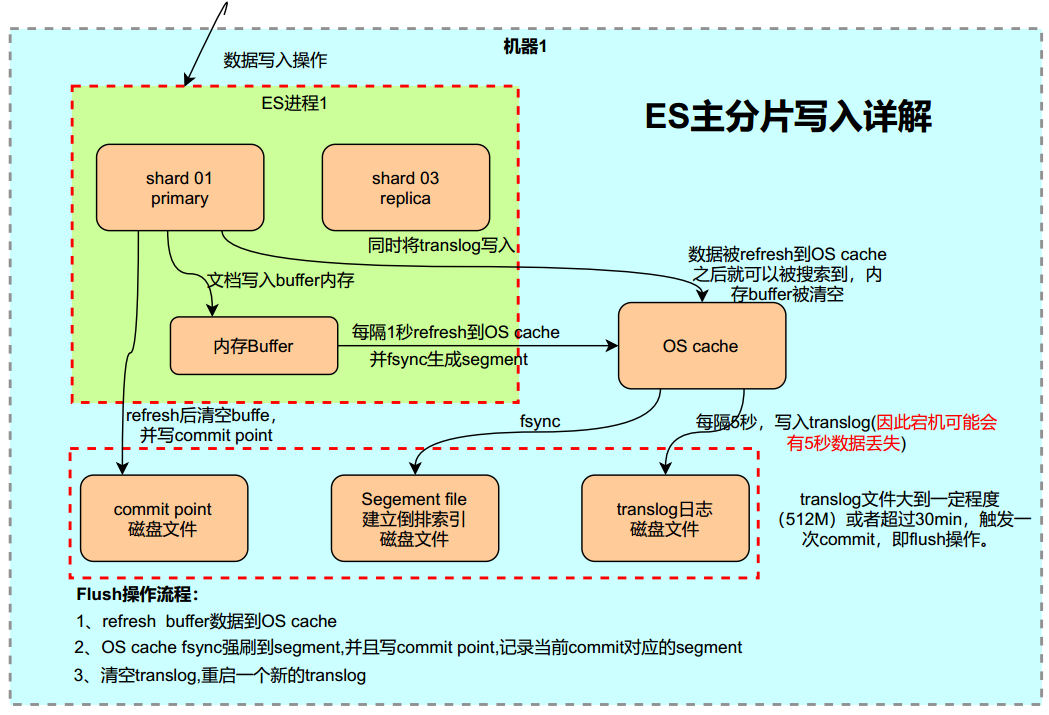

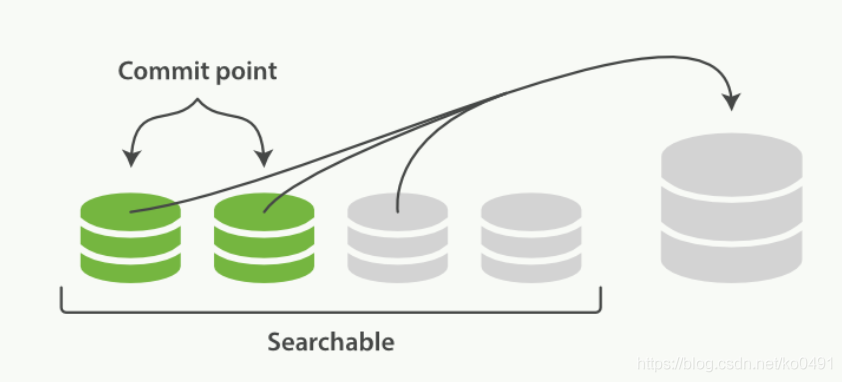

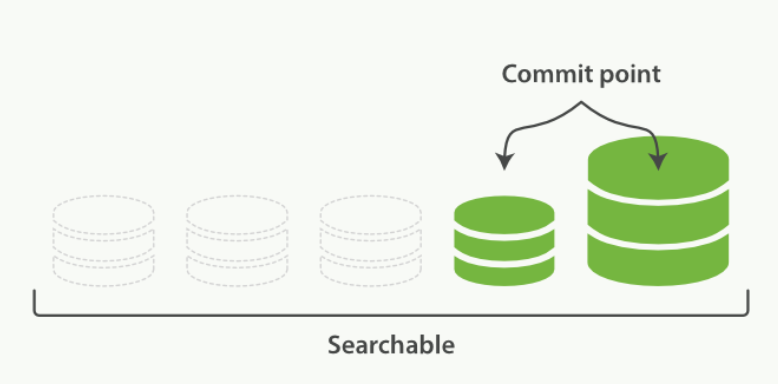

段(segment)

segment来自于lucene,因为ES底层就是使用的lucene,一个shard包含一组segment,segment是最小的数据单元

Elasticsearch每隔一段时间产生一个新的segment,里面包含了新写入的数据,lucene的数据写入会先写如到缓存(buffer)中,当达到一定数量以后,会flush成文一个segment,写入到磁盘当中,每个segement有自己独立的索引,可以单独查询。

segment不会被修改,数据的的写入都是进行批量的追加,避免了随机写的存在,提高了吞吐量,segement可以被删除,但也不是修改segement文件,而是由另外的文件记录需要被删除的documentId。

index的查询是对多个segement文件的查询,其中也包含了处理被删除文件的处理,并对查询结果进行合并,为了进行查询优化,lucene有策略对多个segment进行优化。

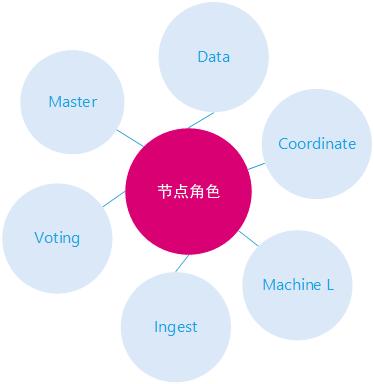

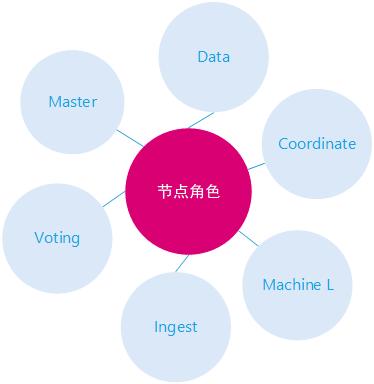

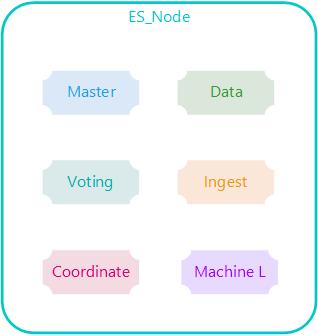

节点的角色

一个Elasticsearch实例代表了一个ES 节点,如果不通过 node.roles 设置节点的角色,一个ES节点默认的节点角色有:master 、data 、data_content、data_hot、data_warm、data_cold、ingest、ml、remote_cluster_client。

主节点介绍?元数据保存哪里,整体集群介绍

每个节点既可以是候选主节点也可以是数据节点,通过在配置文件../config/elasticsearch.yml中设置即可,默认都为true,ES节点有如下角色:

master角色

其实这个是master准确的来说是具有成为master节点资格的节点,即master-eligible node

候选主节点,master节点的职责是创建索引、删除索引、监控集群中的所有节点、决定分片应当分配到哪一个节点上,拥有一个稳定的主节点对集群非常重要,候选主节点可以通过节点选举过程被选举为主节点,主节点最好是专用的,不和其他角色共用,以免其他的操作对master节点负载造成影响,导致集群不可用

主节点负责轻量级集群范围的操作,例如创建或删除索引、跟踪哪些节点是集群的一部分以及决定将哪些分片分配给哪些节点,任何不是仅投票节点的主合格节点都可以通过主选举过程选举成为主节点。

主节点必须有一个path.data目录,其内容在重启后仍然存在,就像数据节点一样,因为这是存储集群元数据的地方,集群元数据描述了如何读取存储在数据节点上的数据,因此如果丢失,则无法读取存储在数据节点上的数据。

如果小型或轻负载集群的主节点具有其他角色和职责,则其可能运行良好,但是一旦您的集群包含多个节点,使用专用的主节点通常是有意义的。

voting_only 仅投票节点

只能参与主节点的投票选举环节,但是自己不能被选举为master

高可用性 (HA) 集群需要至少三个符合主节点的节点,其中至少两个不是仅投票节点,这样即使其中一个节点发生故障,集群也能够选举出一个主节点。

仅投票节点用来凑数的,如果只部署了两个候选主节点,当一个节点挂掉后集群将会不可用,加入了候选主节点则不一样,有了仅投票节点可以帮助快速选择一个主节点出来,并且仅投票节点不会选为主节点,不存储数据,所以消耗的资源也很小。

data 数据节点

负责数据的存储和相关的操作,例如对数据进行增、删、改、查和聚合等操作

保存包含已编入索引的文档的分片,数据节点处理数据相关操作,如 CRUD、搜索和聚合这些操作是 I/O 密集型、内存密集型和 CPU 密集型的,监控这些资源并在它们过载时添加更多数据节点非常重要

ingest 摄取节点

摄取节点可以执行由一个或多个摄取处理器组成的预处理管道

能执行预处理管道,有自己独立的任务要执行, 在索引数据之前可以先对数据做预处理操作, 不负责数据存储也不负责集群相关的事务,类似于 logstash 中 filter 的作用,功能相当强大。

在实际文档索引发生之前,使用Ingest节点预处理文档,Ingest节点拦截批量和索引请求,它应用转换,然后将文档传递回索引,在数据被索引之前,通过预定义好的处理管道对数据进行预处理。

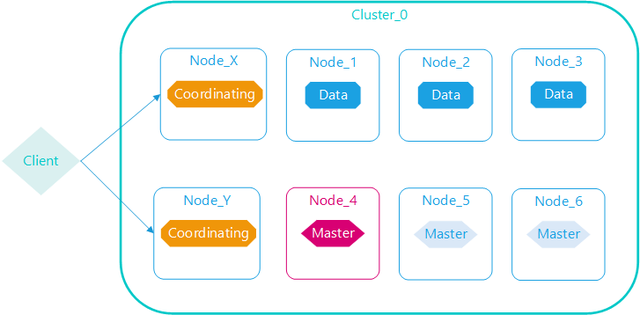

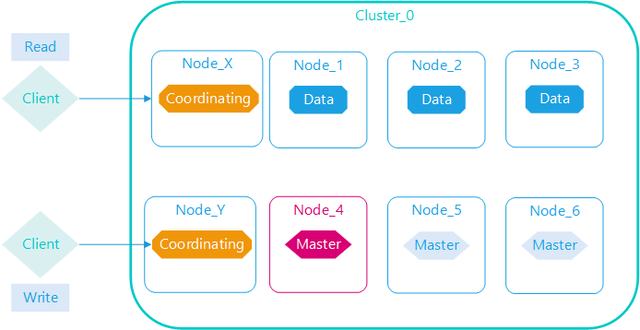

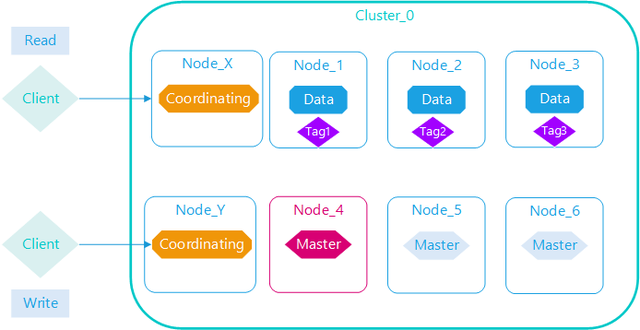

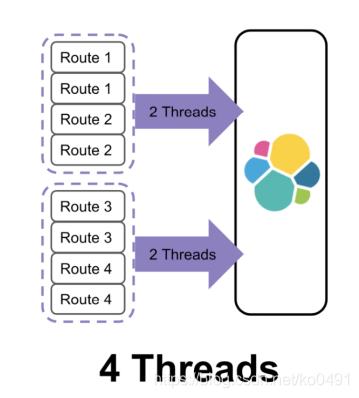

coordinating 仅协调节点

如果您取消了处理主职责、保存数据和预处理文档的能力,那么您就剩下一个只能路由请求、处理搜索减少阶段和分发批量索引的协调节点

本质上,仅协调节点的行为就像智能负载均衡器,通过从数据和符合主节点的节点卸载协调节点角色,仅协调节点可以使大型集群受益,他们加入集群并接收完整的集群状态,就像其他每个节点一样,他们使用集群状态将请求直接路由到适当的地方。

配置节点类型

| 节点类型 | 配置参数 | 默认值 |

|---|---|---|

| master eligible | node.master | true |

| data | node.data | true |

| ingest | node.ingest | true |

| Coordianting only | 无 | 每个节点默认都是 Coordianting。设置其他类型为 false |

| machine learning | node.ml | true (需要 enable x-pack) |

ElasticSearch集群概念

集群角色

一个Elasticsearch实例代表了一个ES 节点,如果不通过

node.roles设置节点的角色,一个ES节点默认的节点角色有很多个不同的角色

每个节点既可以是候选主节点也可以是数据节点,通过在配置文件../config/elasticsearch.yml中设置即可,默认都为true,ES节点有如下角色:

Master节点

其实这个是master准确的来说是具有成为master节点资格的节点,即

master-eligible node

主要职责

Master角色的主要职责是负责集群层面的相关操作,管理集群变更,如创建或删除索引,跟踪哪些节点是群集的一部分,并决定哪些分片分配给相关的节点。

拥有一个稳定的主节点对集群非常重要,候选主节点可以通过节点选举过程被选举为主节点,主节点最好是专用的,不和其他角色共用,以免其他的操作对master节点负载造成影响,导致集群不可用

角色介绍

主节点负责轻量级集群范围的操作,任何不是仅投票节点的合格节点都可以通过选举成为主节点

主节点必须有一个path.data目录,其内容在重启后仍然存在,就像数据节点一样,因为这是存储集群元数据的地方,集群元数据描述了如何读取存储在数据节点上的数据,因此如果丢失,则无法读取存储在数据节点上的数据。

仅投票节点

只能参与主节点的投票选举环节,但是自己不能被选举为master

主要职责

仅投票节点用来凑数的,如果只部署了两个候选主节点,当一个节点挂掉后集群将会不可用,加入了仅投票节点则不一样,有了仅投票节点可以帮助快速选择一个主节点出来,并且仅投票节点不会选为主节点,不存储数据,所以消耗的资源也很小。

角色介绍

高可用性 (HA) 集群需要至少三个符合主节点的节点,其中至少两个不是仅投票节点,这样即使其中一个节点发生故障,集群也能够选举出一个主节点。

数据节点

负责数据的存储和相关的操作,例如对数据进行增、删、改、查和聚合等操作

主要职责

数据节点主要是存储索引数据的节点,执行数据相关操作:CRUD、搜索,聚合操作等。

数据节点对cpu,内存,I/O要求较高, 在优化的时候需要监控数据节点的状态,当资源不够的时候,需要在集群中添加新的节点。

角色介绍

保存包含已编入索引的文档的分片,数据节点处理数据相关操作,如 CRUD、搜索和聚合这些操作是 I/O 密集型、内存密集型以及 CPU 密集型的,监控这些资源并在它们过载时添加更多数据节点非常重要

预处理节点

这是从5.0版本开始引入的概念,预处理节点可以执行由一个或多个摄取处理器组成的预处理管道

主要职责

预处理操作运行在索引文档之前,即写入数据之前,通过事先定义好的一系列processors(处理器)和pipeline(管道),对数据进行某种转换、富化

角色介绍

能执行预处理管道,有自己独立的任务要执行, 在索引数据之前可以先对数据做预处理操作, 不负责数据存储也不负责集群相关的事务,类似于 logstash 中 filter 的作用,功能相当强大。

在实际文档索引发生之前,使用Ingest节点预处理文档,Ingest节点拦截批量和索引请求,它应用转换,然后将文档传递回索引,在数据被索引之前,通过预定义好的处理管道对数据进行预处理。

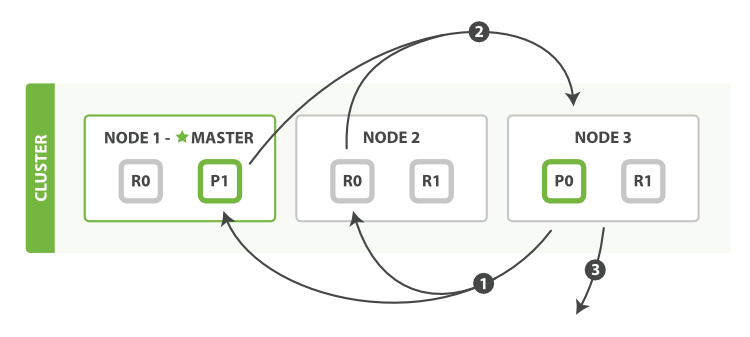

仅协调节点

如果您取消了候选主节点的职责、保存数据和预处理文档的能力,那么您就剩下一个只能路由请求、处理搜索减少阶段和分发批量索引的协调节点

只要职责

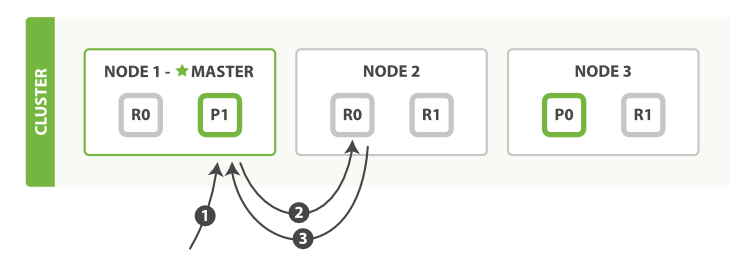

协调节点将请求转发给保存数据的数据节点,每个数据节点在本地执行请求,并将结果返回给协调节点。

协调节点收集完数据合,将每个数据节点的结果合并为单个全局结果,对结果收集和排序的过程可能需要很多CPU和内存资源。

角色介绍

本质上,仅协调节点的行为就像智能负载均衡器,通过从数据和符合主节点的节点卸载协调节点角色,仅协调节点可以使大型集群受益,他们加入集群并接收完整的集群状态,就像其他每个节点一样,他们使用集群状态将请求直接路由到适当的地方。

节点配置方式

以下是个个节点的配置方式

| 节点类型 | 配置参数 | 默认值 |

|---|---|---|

| master eligible | node.master | true |

| data | node.data | true |

| ingest | node.ingest | true |

| Coordianting only | 无 | 每个节点默认都是 Coordianting,设置其他类型为 false |

| machine learning | node.ml | true (需要 enable x-pack) |

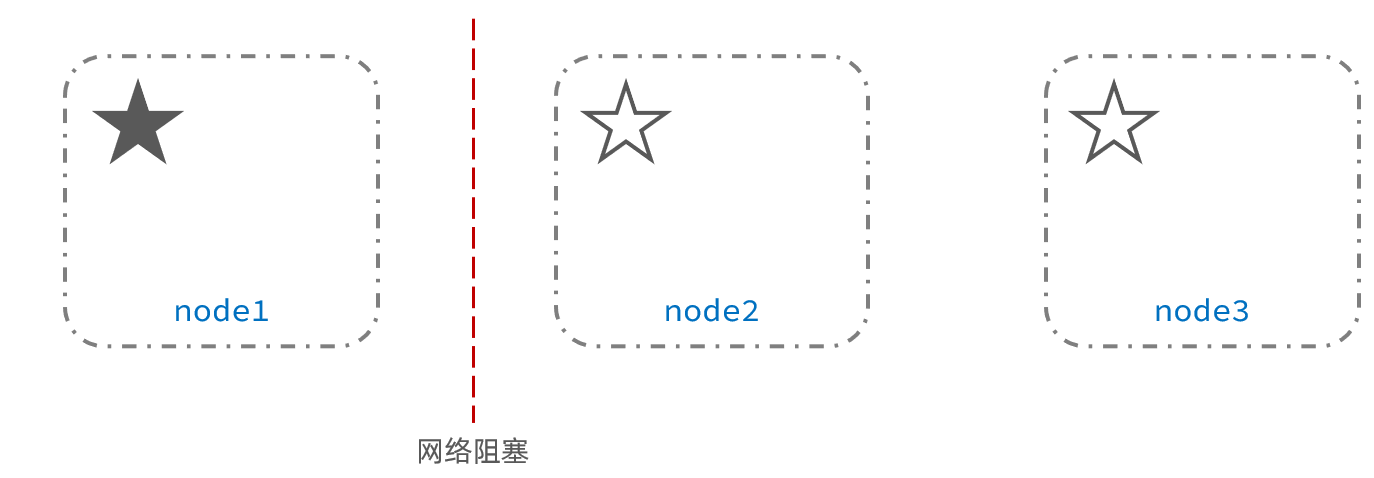

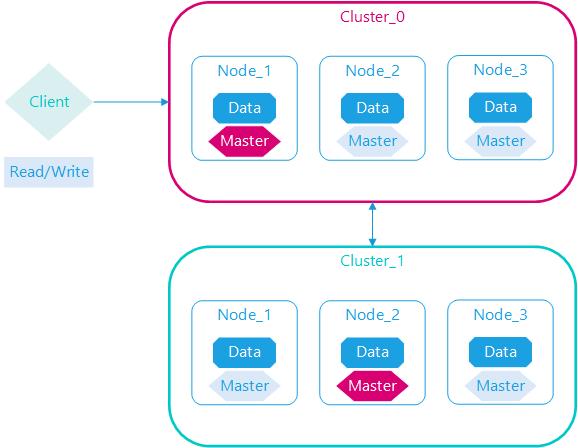

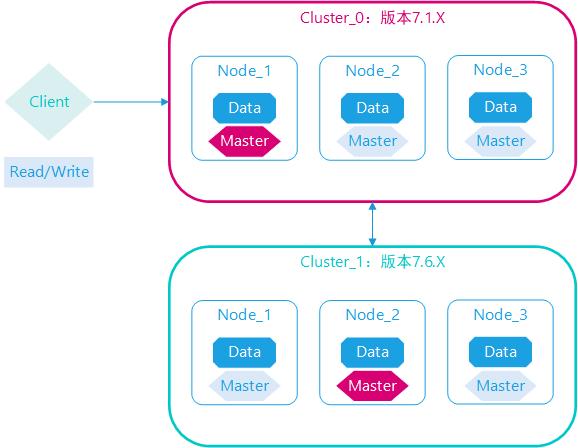

集群脑裂问题

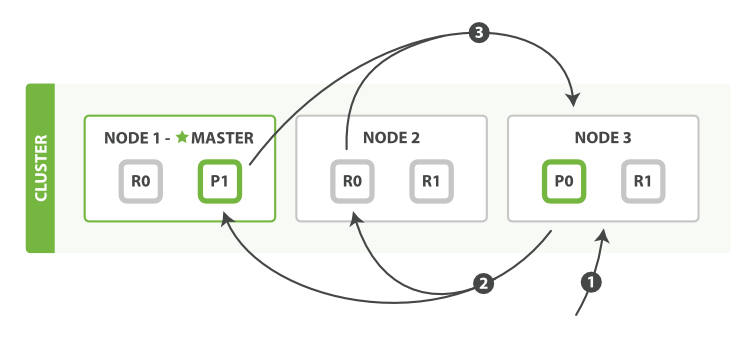

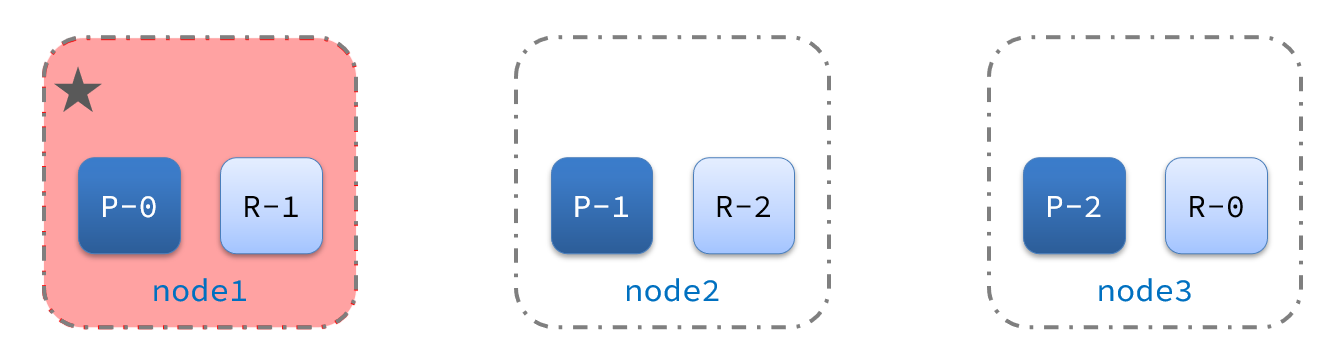

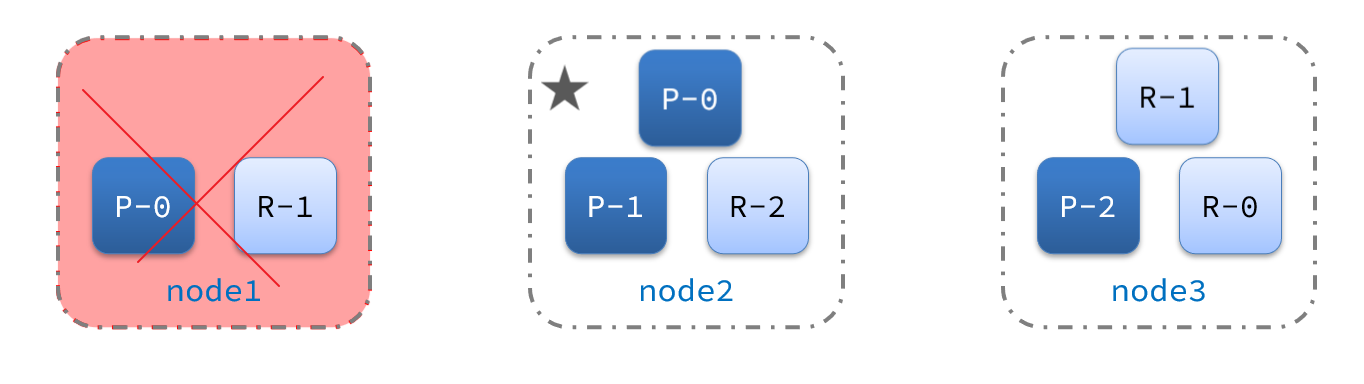

脑裂是因为集群中的节点失联导致的

脑裂分析

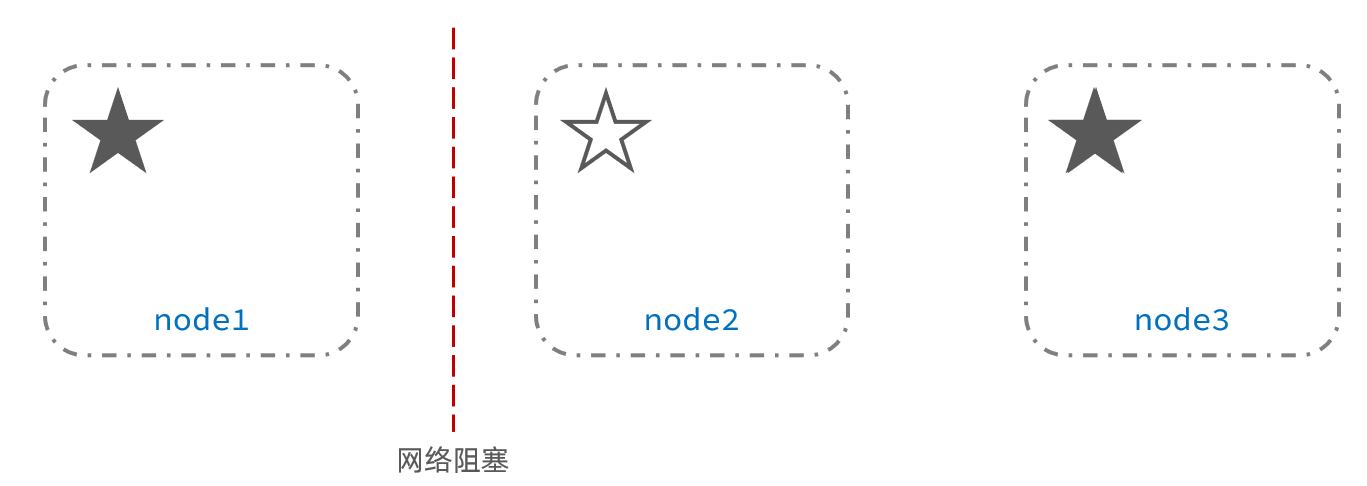

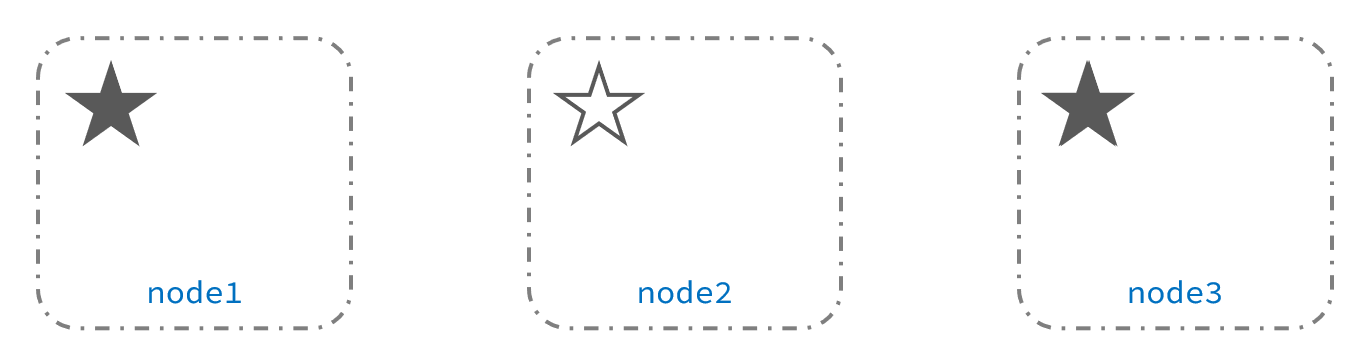

例如一个集群中,主节点与其它节点失联:

重新选主

此时,node2和node3认为node1宕机,就会重新选主:

出现脑裂

当node3当选后,集群继续对外提供服务,node2和node3自成集群,node1自成集群,两个集群数据不同步,出现数据差异,当网络恢复后,因为集群中有两个master节点,集群状态的不一致,出现脑裂的情况:

解决方案

解决脑裂的方案是,要求选票超过 ( 候选主节点数量 + 1 )/ 2 才能当选为主

因此候选主节点数量最好是奇数,对应配置项是discovery.zen.minimum_master_nodes,在es7.0以后,已经成为默认配置,因此一般不会发生脑裂问题

例如:3个节点形成的集群,选票必须超过 (3 + 1) / 2 ,也就是2票,node3得到node2和node3的选票,当选为主,node1只有自己1票,没有当选,集群中依然只有1个主节点,没有出现脑裂。

ElasticSearch 单机部署

单机部署

下载 Elasticsearch

我们下载的Elasticsearch 版本是 7.17.5,下载地址

https://www.elastic.co/cn/downloads/past-releases/elasticsearch-7-17-5

wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-7.17.5-linux-x86_64.tar.gz

tar -zvxf elasticsearch-7.17.5-linux-x86_64.tar.gz配置 Elasticsearch

关闭防火墙

systemctl status firewalld.service

systemctl stop firewalld.service

systemctl disable firewalld.service配置elasticsearch.yml

该配置文件是ES的主配置文件

vi elasticsearch.yml

#设置允许访问地址,配置位0.0.0.0允许任意主机访问

- #network.host: 192.168.0.1

+ network.host: 0.0.0.0

# 配置集群

# node.name: node-1

+ node.name: node-1

- #discovery.seed_hosts: ["host1", "host2"]

discovery.seed_hosts: ["node-1"]

- #cluster.initial_master_nodes: ["node-1", "node-2"]

+ cluster.initial_master_nodes: ["node-1"]修改Linux句柄数

查看当前最大句柄数

sysctl -a | grep vm.max_map_count修改句柄数

vi /etc/sysctl.conf

+ vm.max_map_count=262144生效配置

修改后需要重启才能生效,不想重启可以设置临时生效

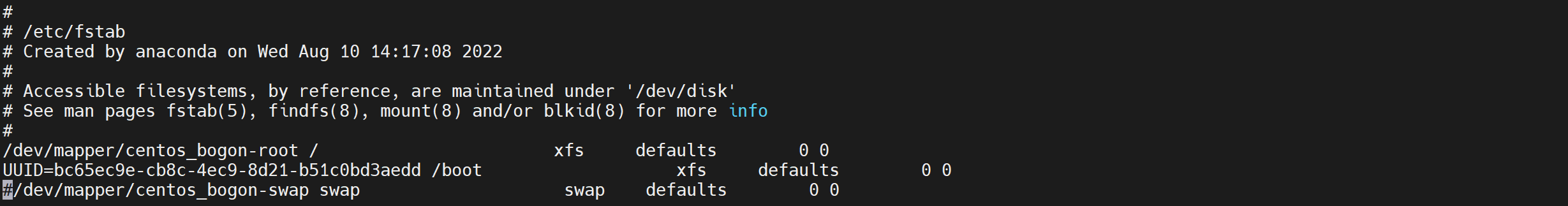

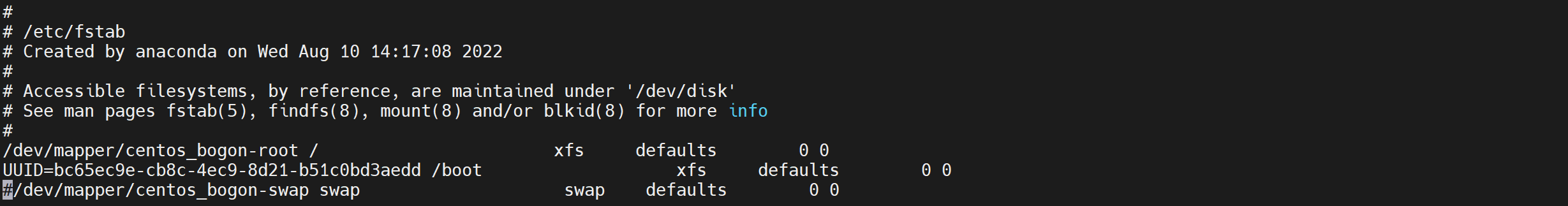

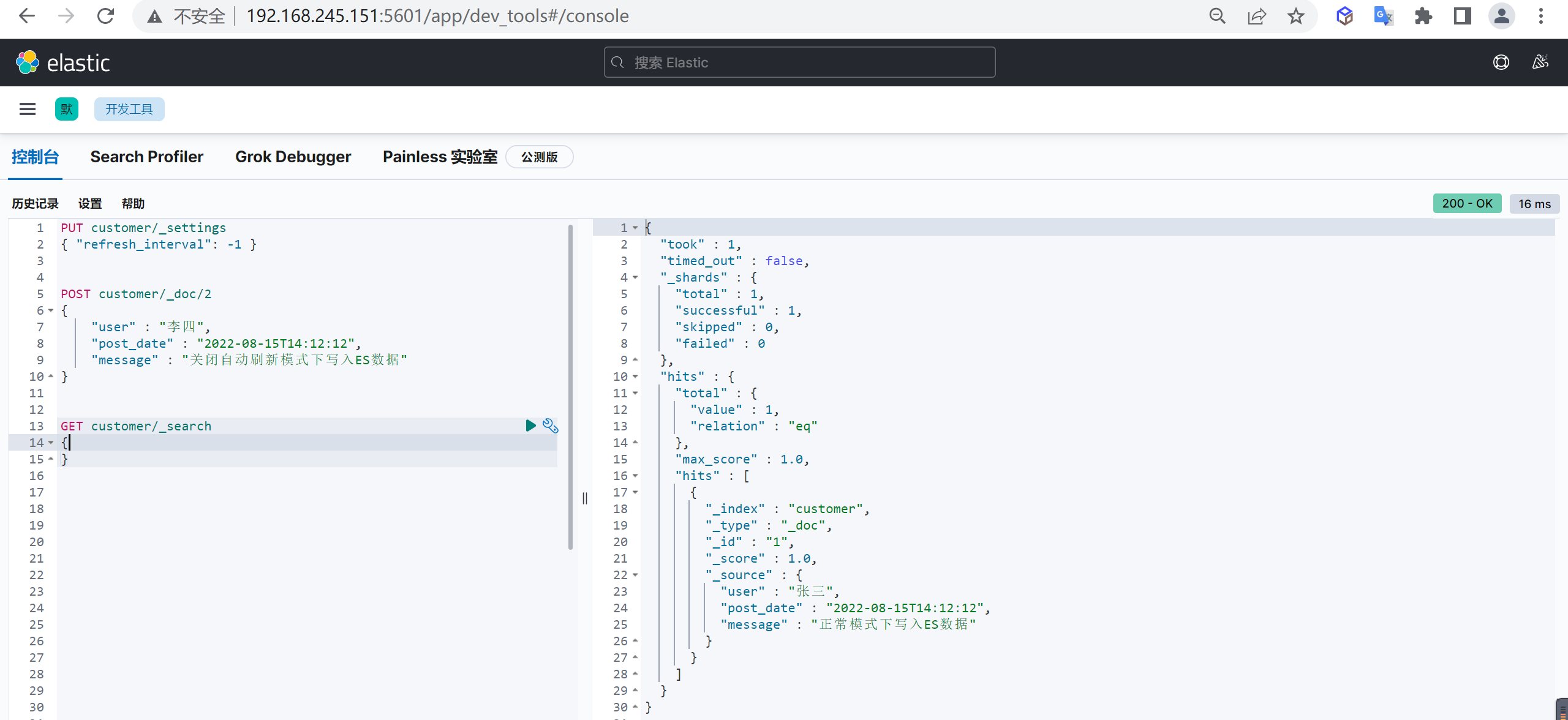

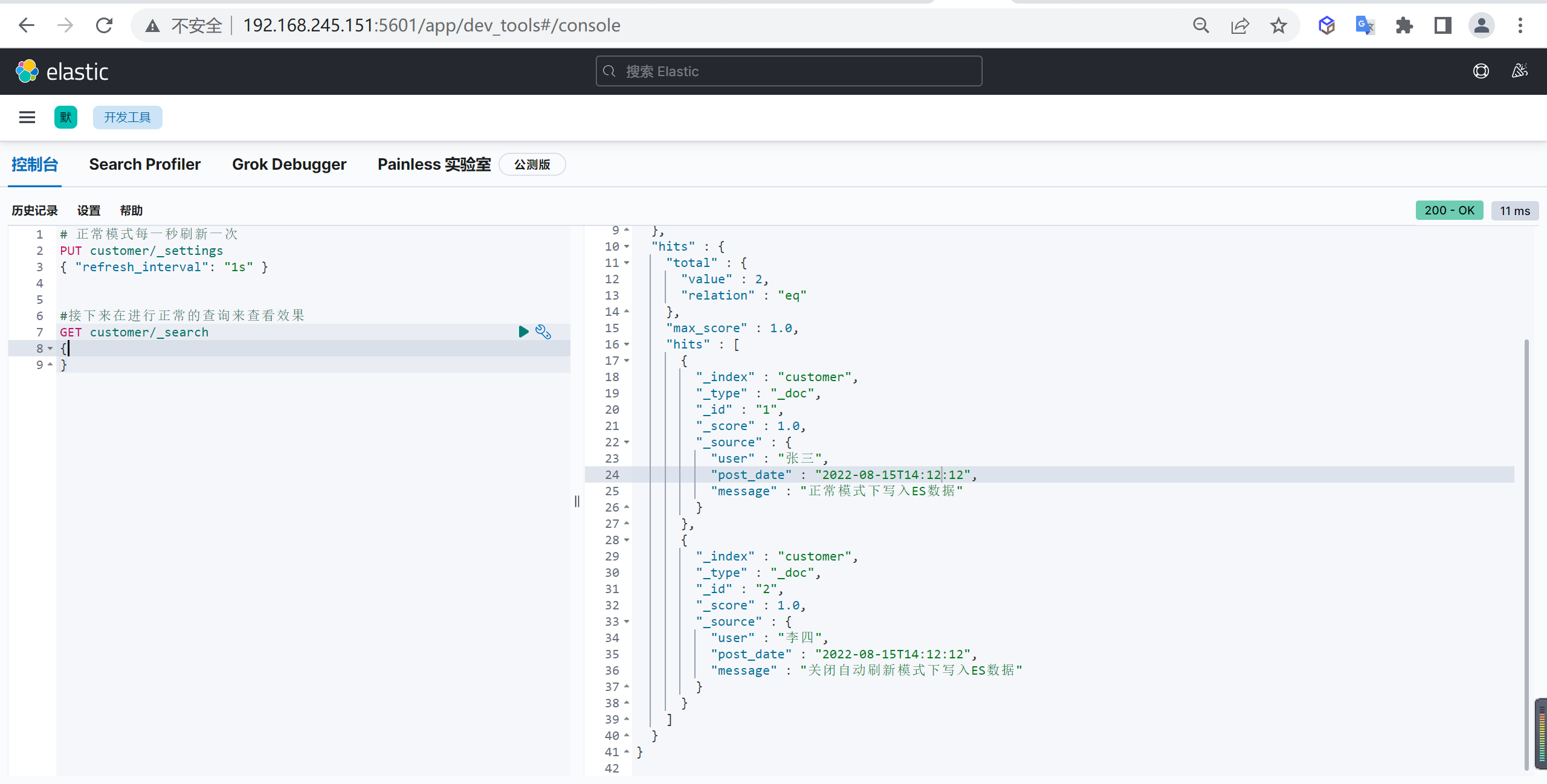

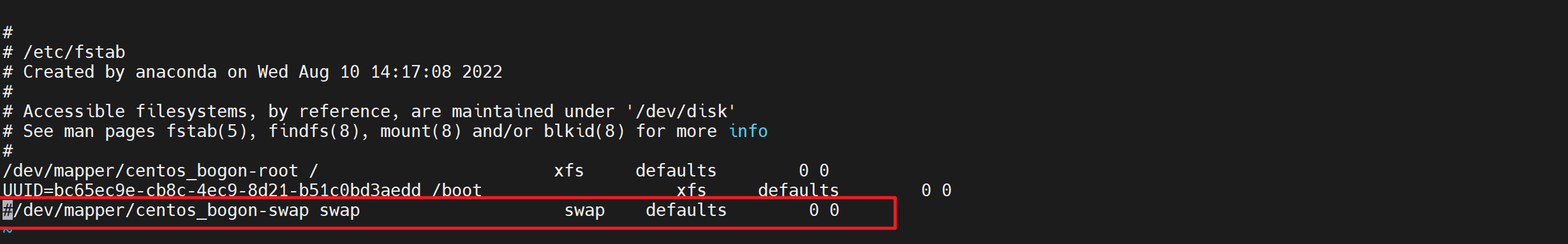

sysctl -w vm.max_map_count=262144关闭swap

因为ES的数据大量都是常驻内存的,一旦使用了虚拟内存就会导致查询速度下降,一般需要关闭swap,但是要保证有足够的内存

临时关闭

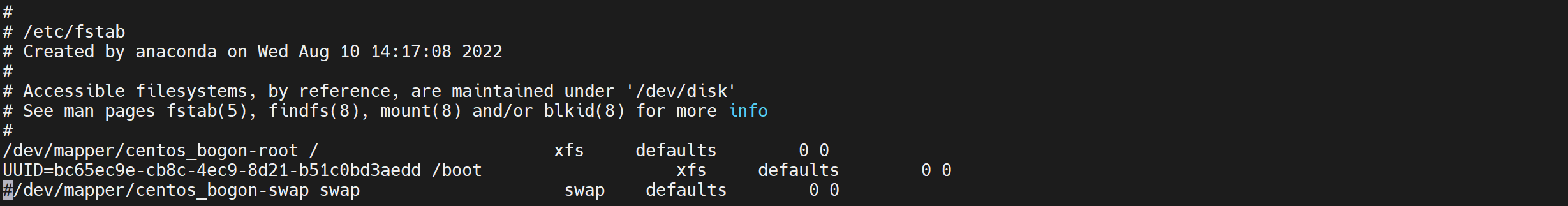

swapoff -a永久关闭

vi /etc/fstab注释掉

swap这一行的配置

修改最大线程数

因为ES运行期间可能创建大量线程,如果线程数支持较少可能报错

配置修改

修改后需要重新登录生效

vi /etc/security/limits.conf

# 添加以下内容

* soft nofile 65536

* hard nofile 65536

* soft nproc 4096

* hard nproc 4096重启服务

reboot创建ES用户

注意ES不能以 root 用户启动,否则会报错

添加用户

useradd elasticsearch

passwd elasticsearch增加管理员权限

增加sudoers权限

vi /etc/sudoers

+ elasticsearch ALL=(ALL) ALL修改Elasticsearch权限

给ES的安装目录进行授权

chown -R elasticsearch:elasticsearch elasticsearch-7.17.5JVM配置

根据自己的内存自行调整,内存不够则会启动失败

vi jvm.options

- ##-Xms4g

- ##-Xmx4g

+ -Xms4g

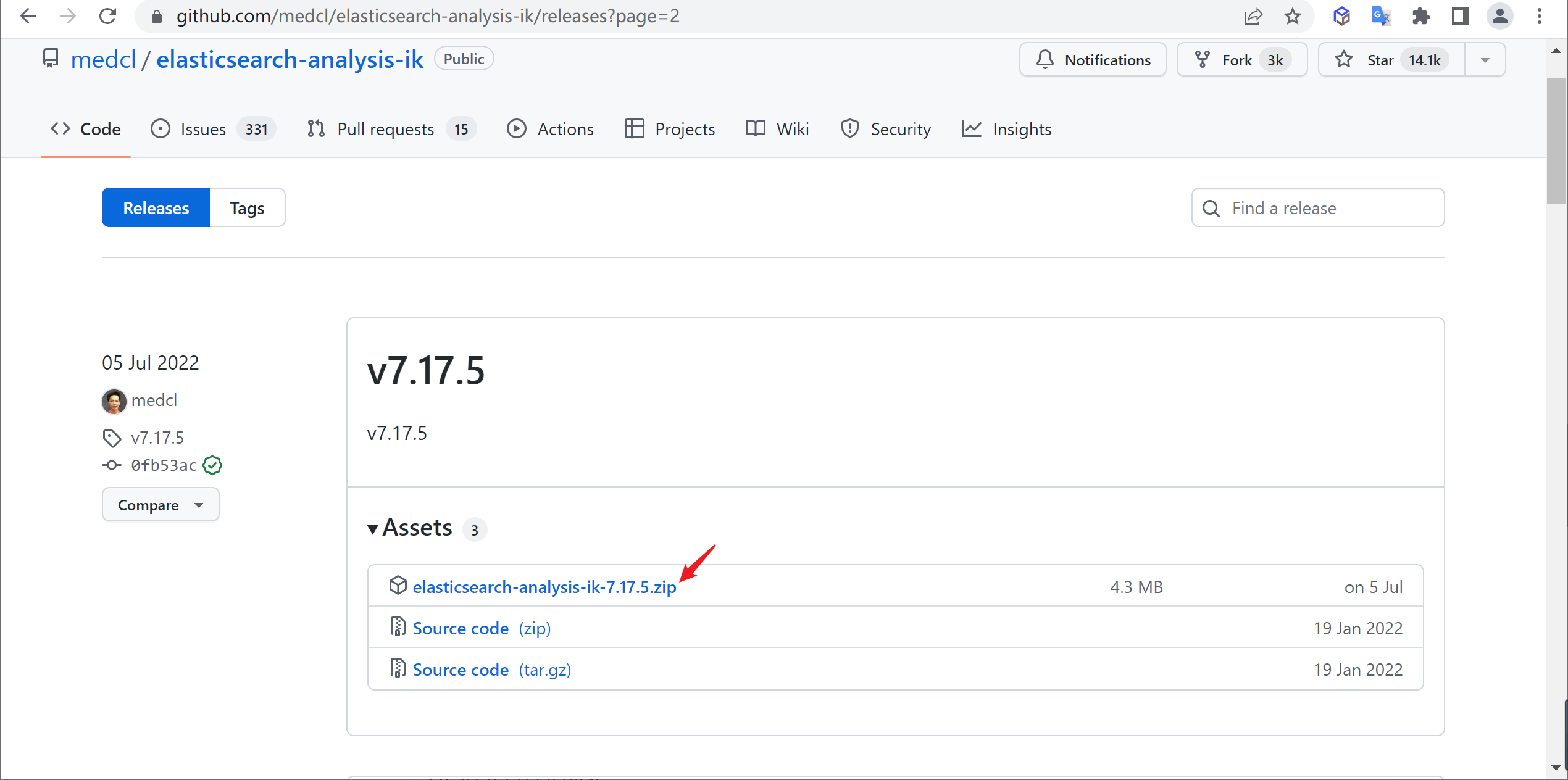

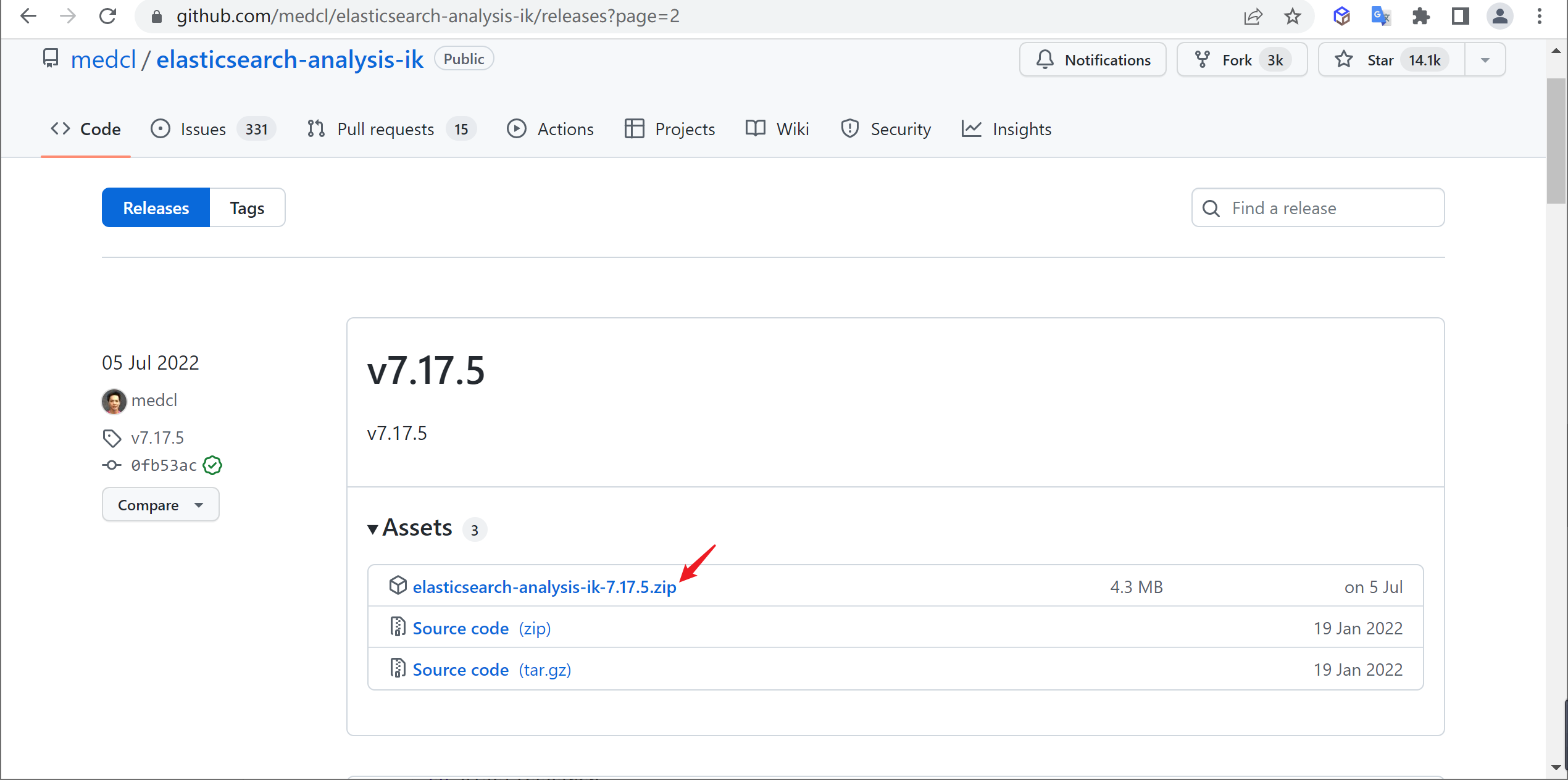

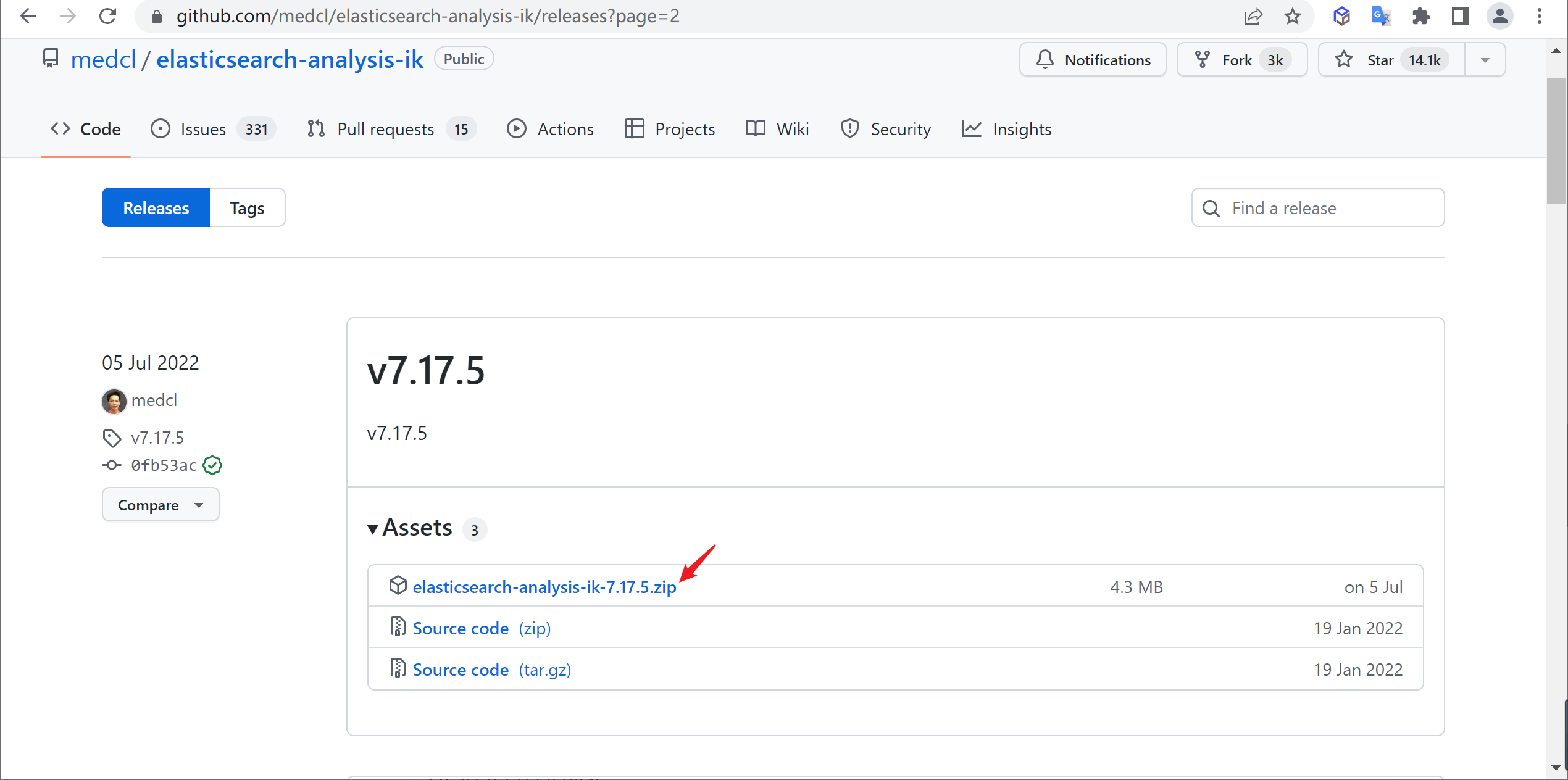

+ -Xmx4g添加IK分词器

因为后面要用到IK分词,所以我们要安装以下IK分词器

查找

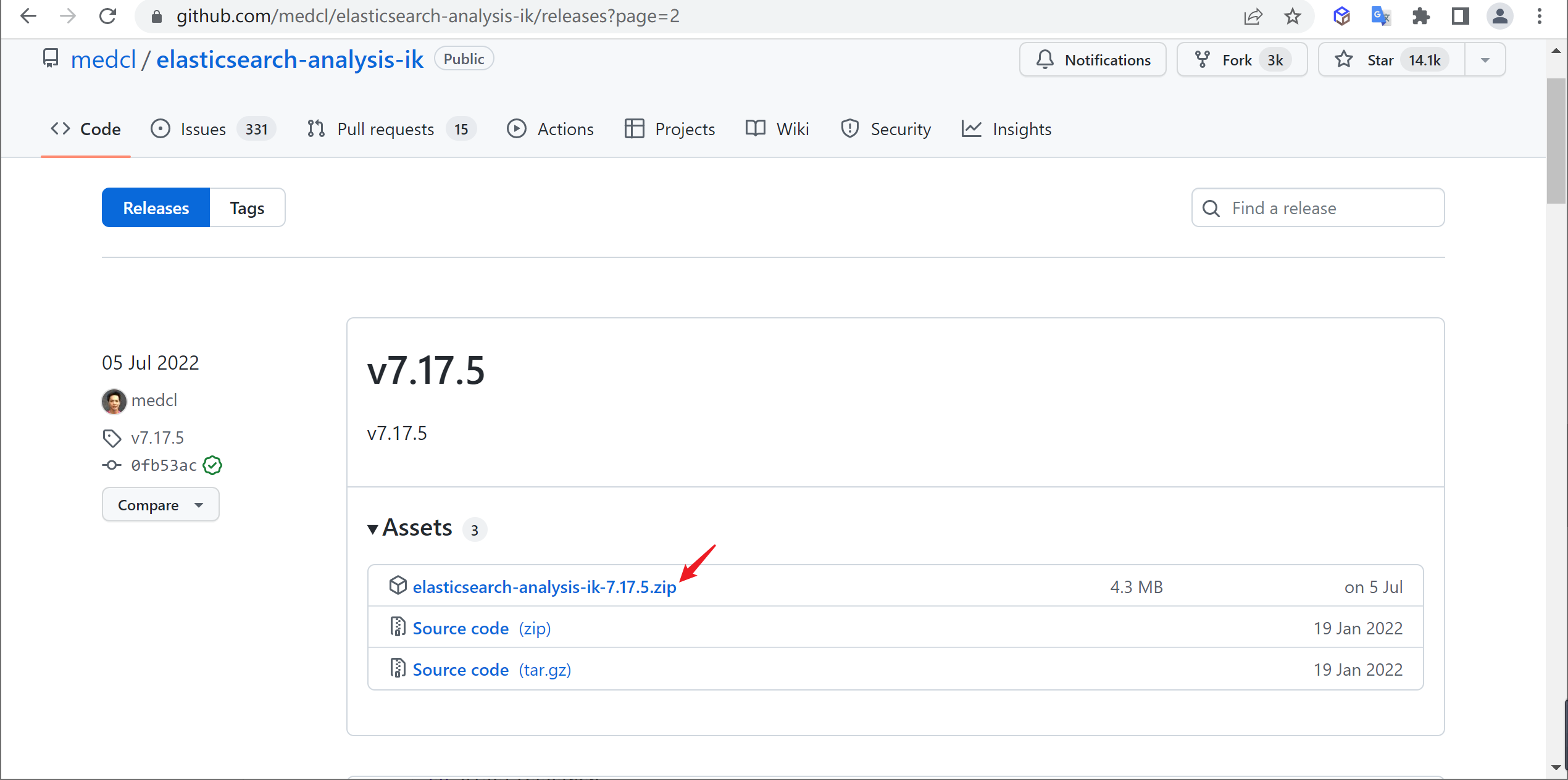

在github中下载对应版本的分词器

https://github.com/medcl/elasticsearch-analysis-ik/releases根据自己的ES版本选择相应版本的IK分词器,因为安装的ES是

7.17.5,所以也下载相应的IK分词器

解压

将下载的分词器复制到ES安装目录的

plugins目录中并进行解压

mkdir ik && cd ik

unzip elasticsearch-analysis-ik-7.17.5.zip启动ElasticSearch

切换用户

切换到刚刚创建的

elasticsearch用户

su elasticsearch启动命令

我们可以使用以下命令来进行使用

# 前台启动

sh bin/elasticsearch

# 后台启动

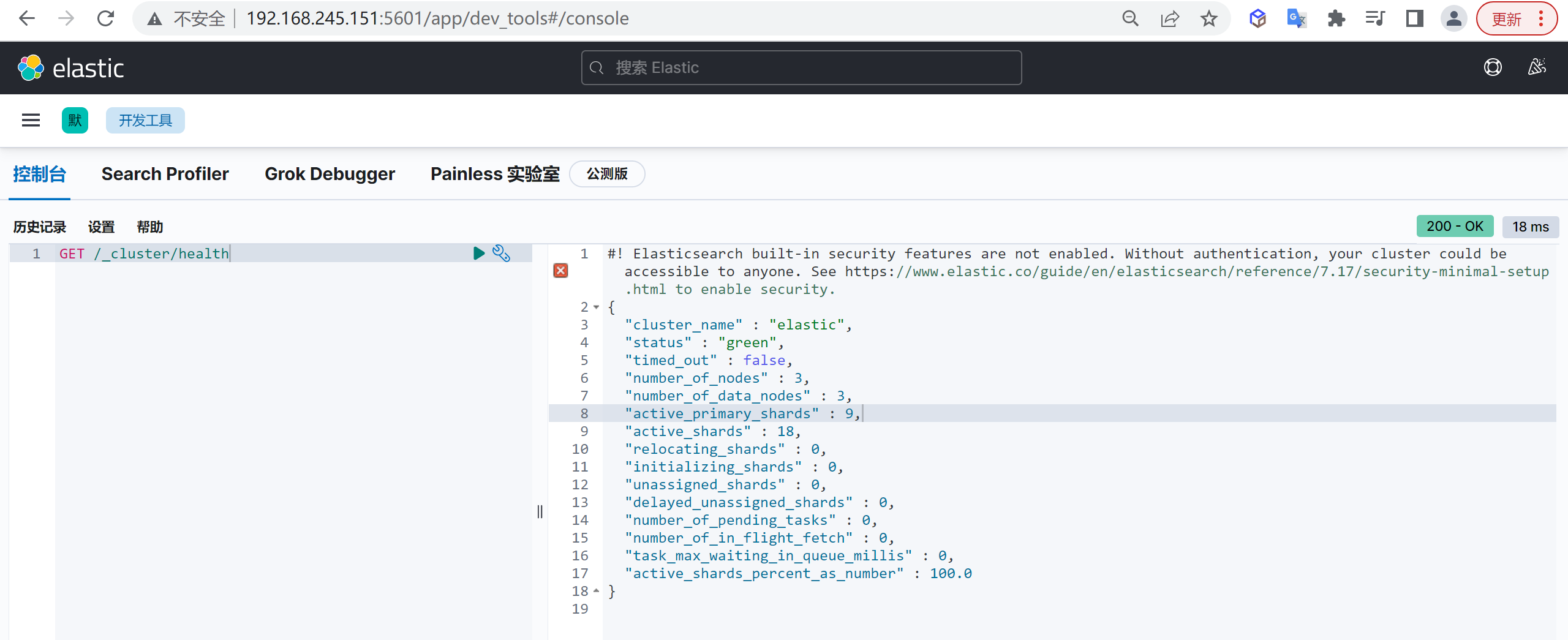

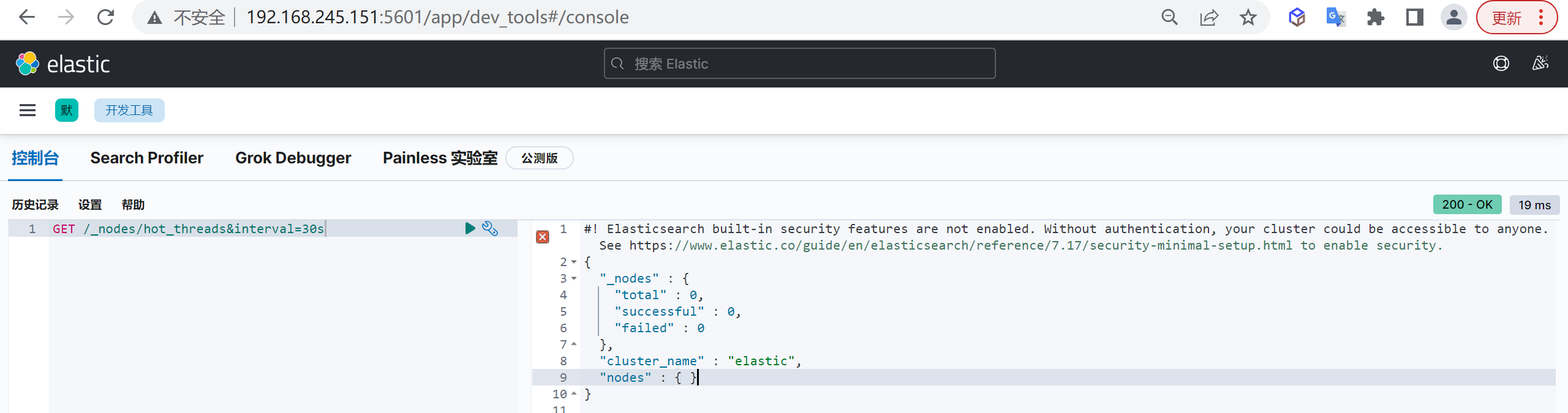

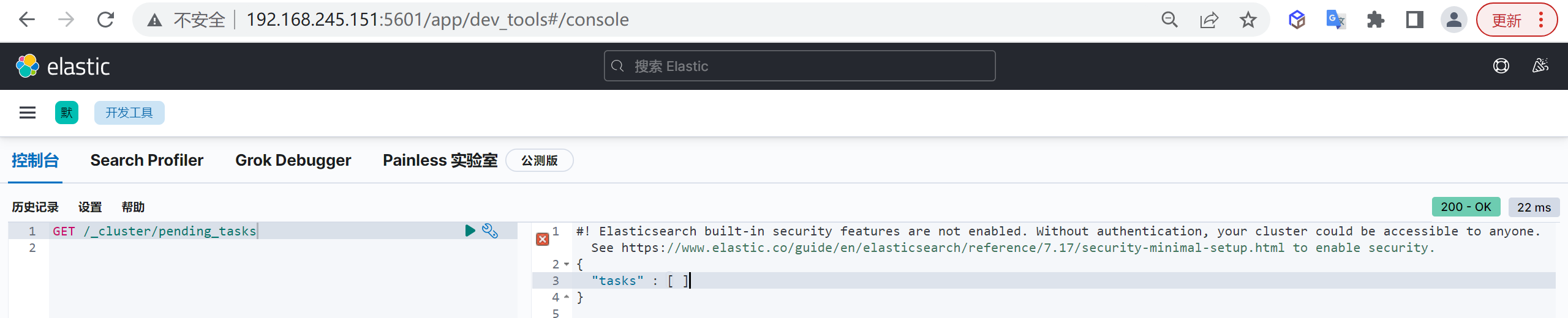

sh bin/elasticsearch -d访问测试

访问对应宿主机的

9200端口

http://192.168.245.151:9200/重启ElasticSearch

查找进程

先查找ElasticSearch的进程号

ps -ef | grep elastic杀死进程

杀死对应的进程

kill -9 49736启动ElasticSearch

注意不要使用ROOT用户启动

sh bin/elasticsearch -dkibana安装

下载安装 Kibana

kibana 版本 7.17.5

下载地址:https://www.elastic.co/cn/downloads/past-releases/kibana-7-17-5

wget https://artifacts.elastic.co/downloads/kibana/kibana-7.17.5-linux-x86_64.tar.gz

tar -zvxf kibana-7.17.5-linux-x86_64.tar.gz

mv kibana-7.17.5-linux-x86_64 kibana-7.17.5配置 Kibana

vi config/kibana.yml

- #server.port: 5601

+ server.port: 5601

- #server.host: "localhost"

+ server.host: "0.0.0.0"

- #elasticsearch.hosts: ["http://localhost:9200"]

+ elasticsearch.hosts: ["http://localhost:9200"]启动 Kibana

切换用户

Kibana也不能以root用户运行,需要切换到

elasticsearch权限

su elasticsearch启动kibaba

#前台运行

sh bin/kibana

#后台运行

nohup sh bin/kibana >/dev/null 2>&1 &访问测试

访问对应宿主机的

5601端口

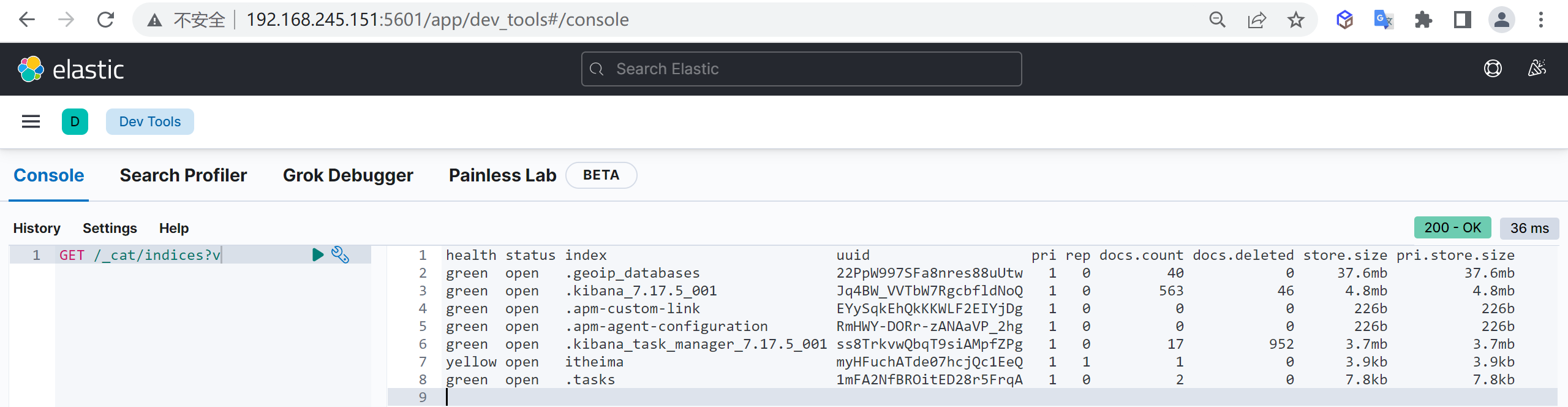

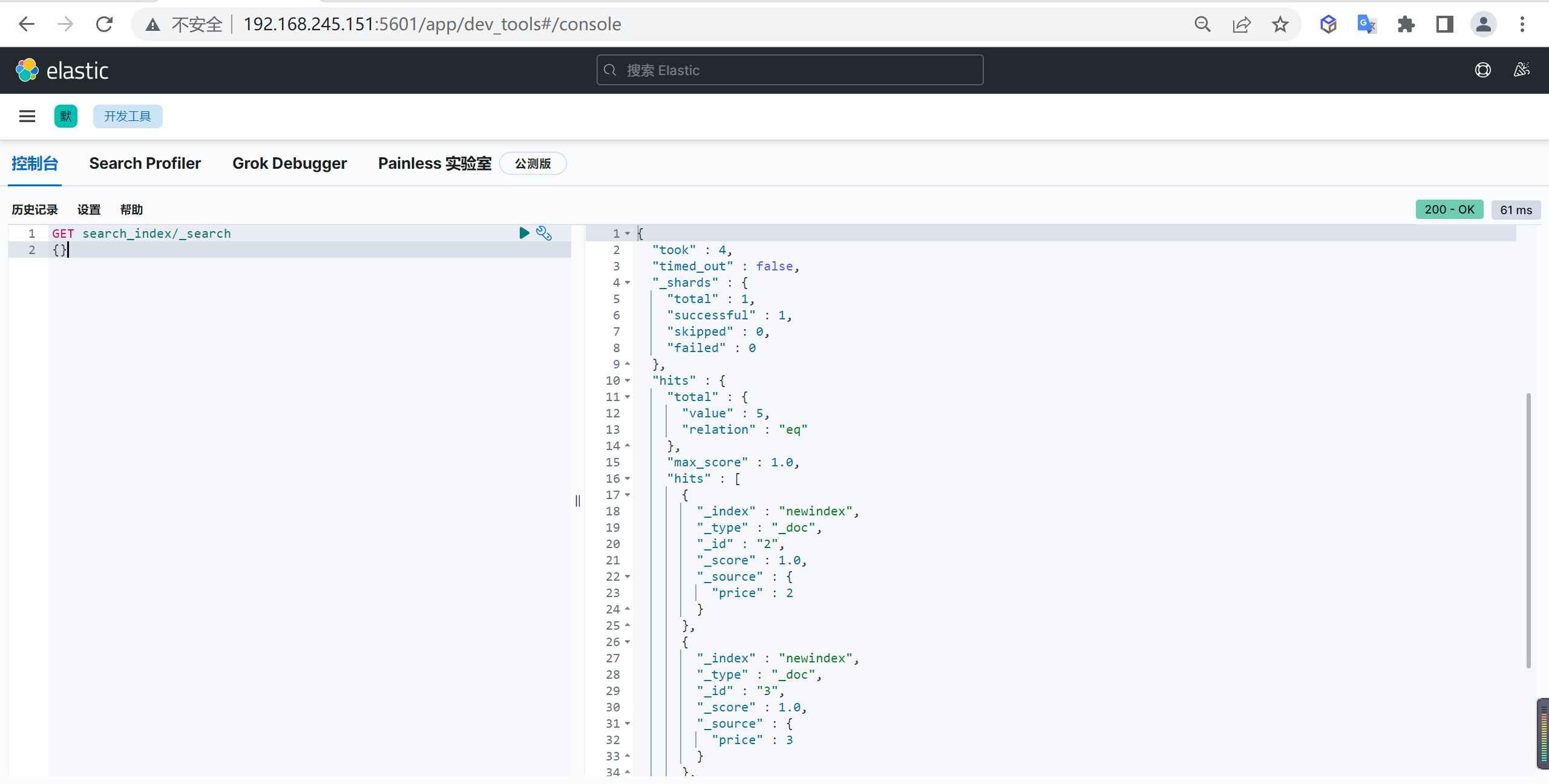

http://192.168.245.151:5601/ES快速入门

下面我们看下ES的一些基本使用

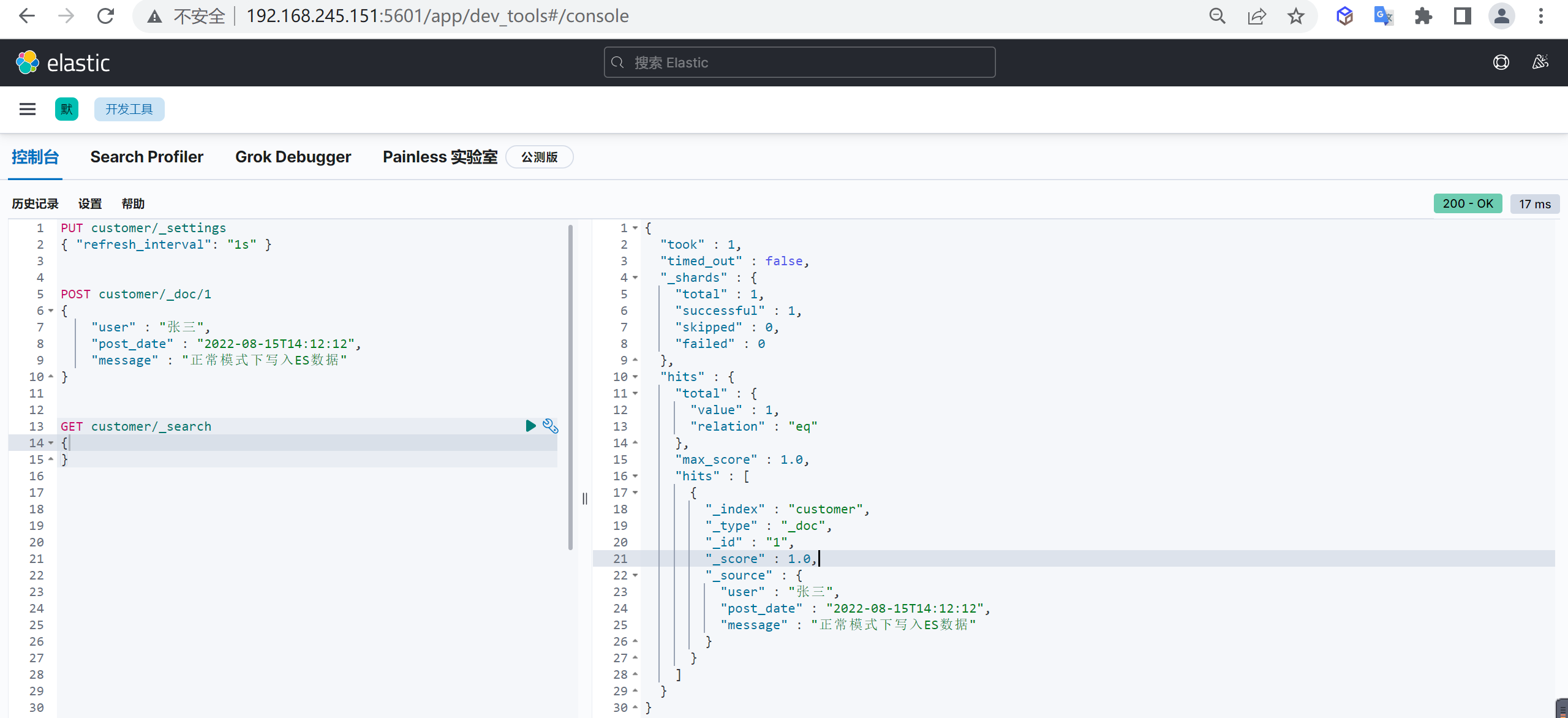

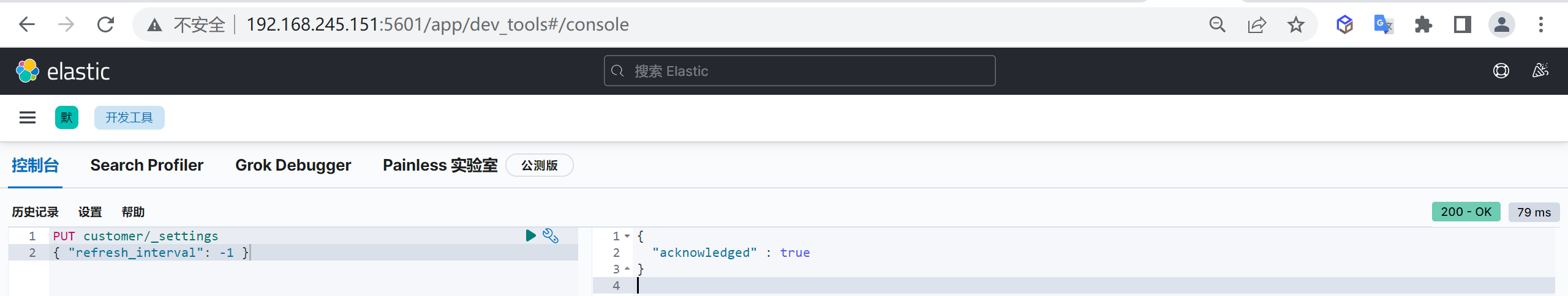

索引管理

我们使用数据库的第一步就是创建数据库,同样ES也是一样的,第一步也是对索引进行管理

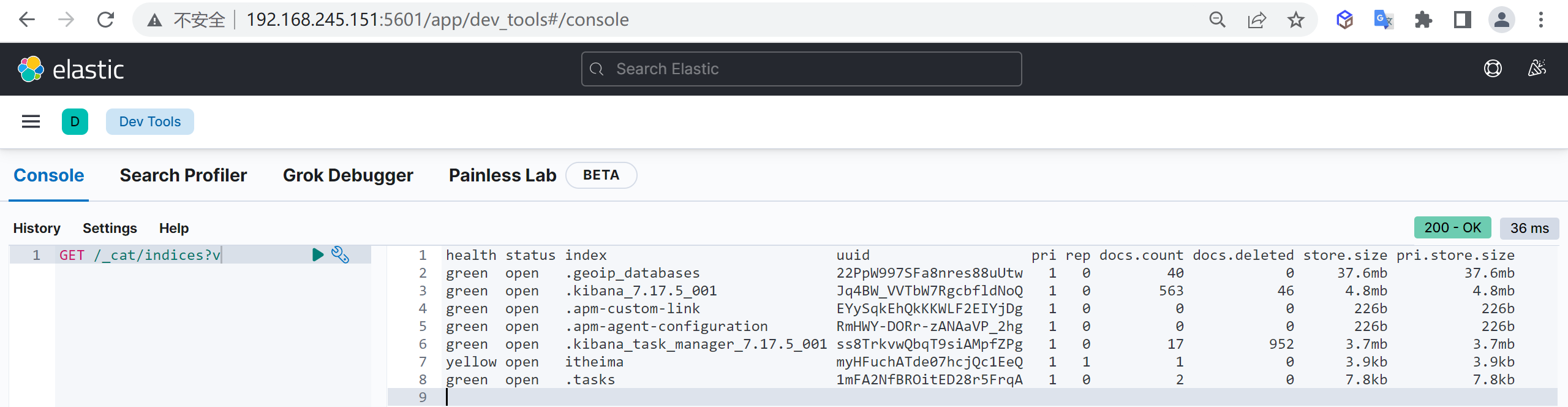

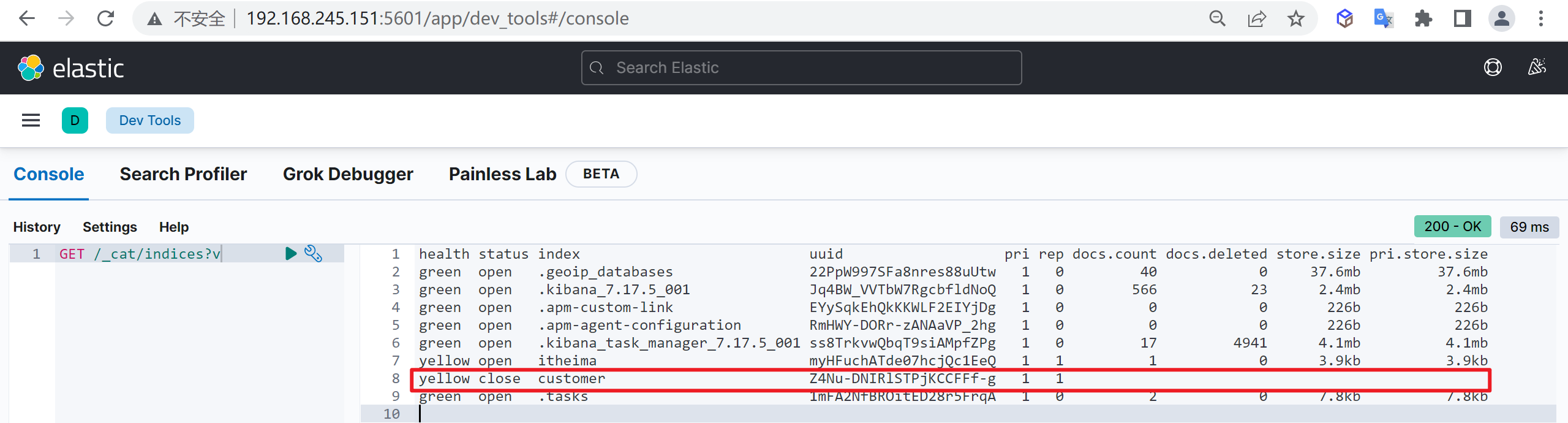

列出索引

我们使用索引的第一步就是列出索引,查看当前数据库有哪些索引

GET /_cat/indices?v

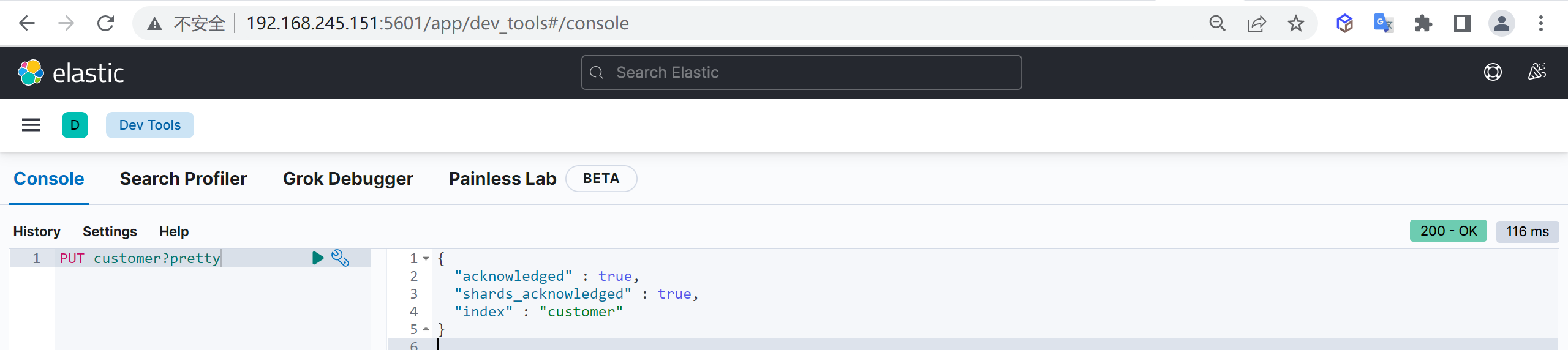

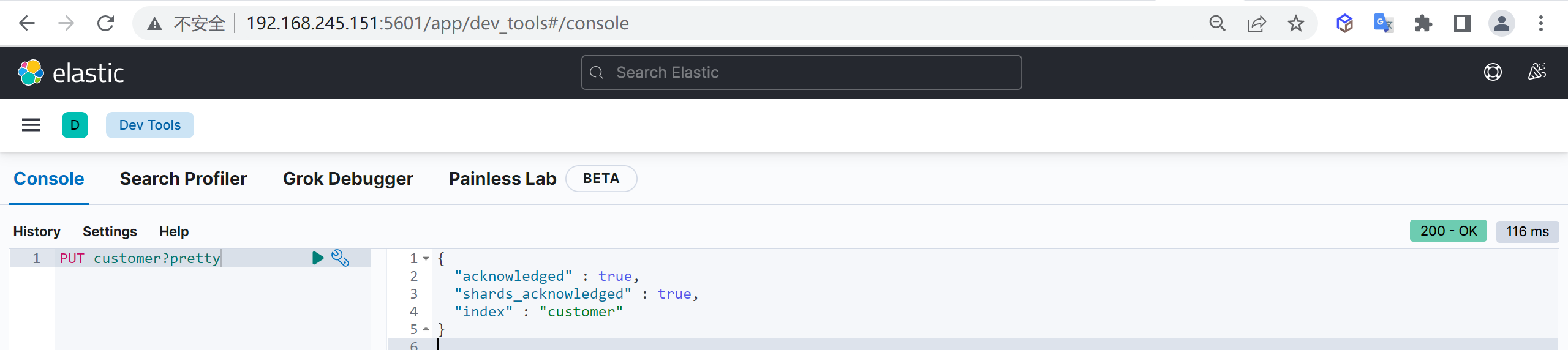

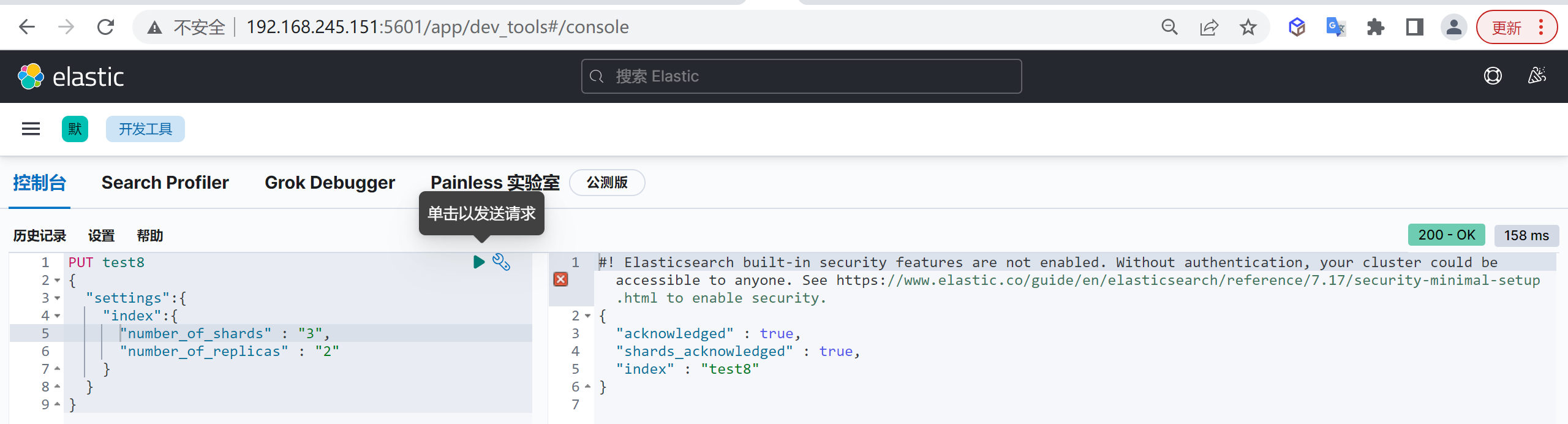

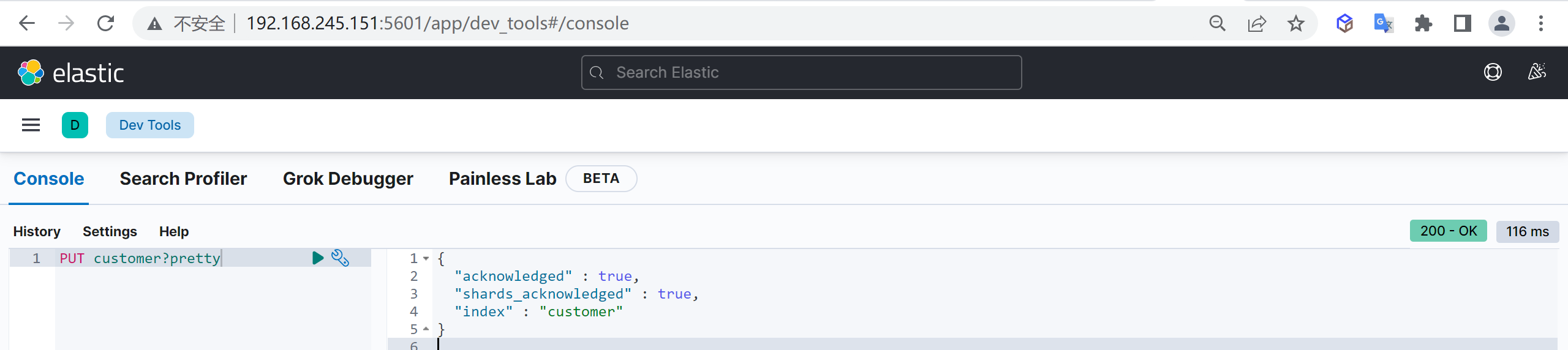

创建索引

我们接下来要使用索引就需要创建索引了,Elasticsearch使用PUT方式来实现索引的新增

可以在创建索引的时候不添加任何参数,系统会为你创建一个默认的索引,当然你可以添加附加一些配置信息

PUT customer这样我们就创建了一个索引

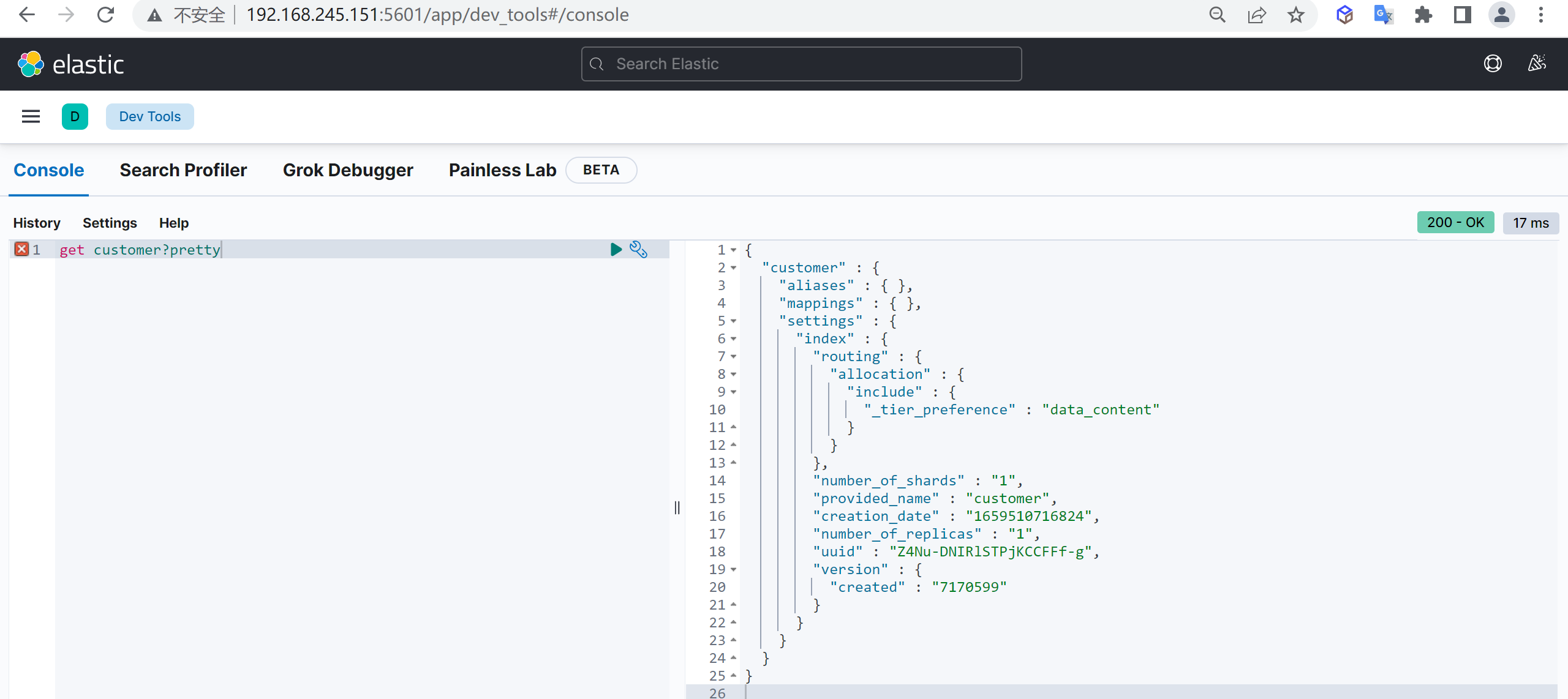

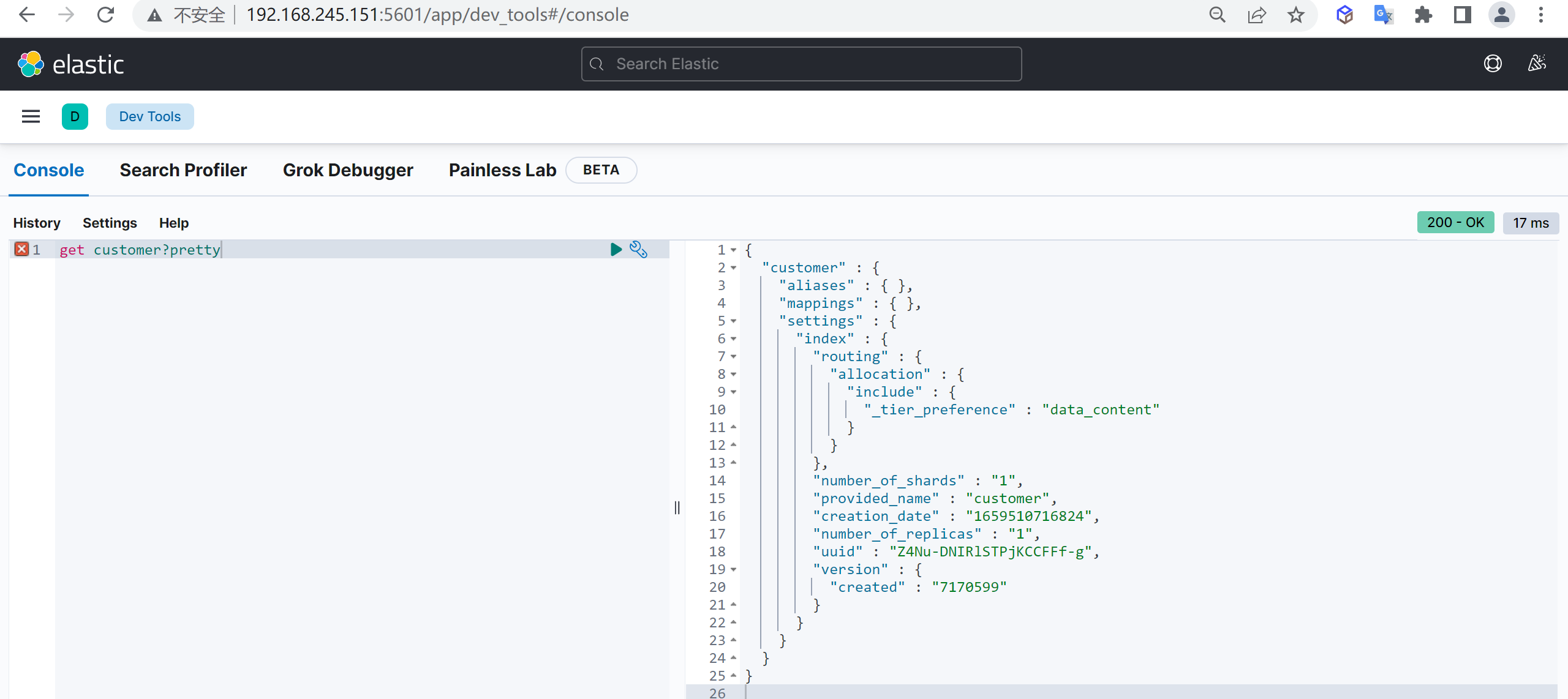

查看索引

索引创建完成后,我们接下来就需要对索引进行查询

get customer

结果说明

这里返回了一堆数据,具体什么含义呢,我们需要查看字段的详细信息

| 字段 | 内容 |

|---|---|

| aliases | 别名 |

| mappings | 映射 |

| settings | 配置 |

| settings.index.creation_date | 创建时间 |

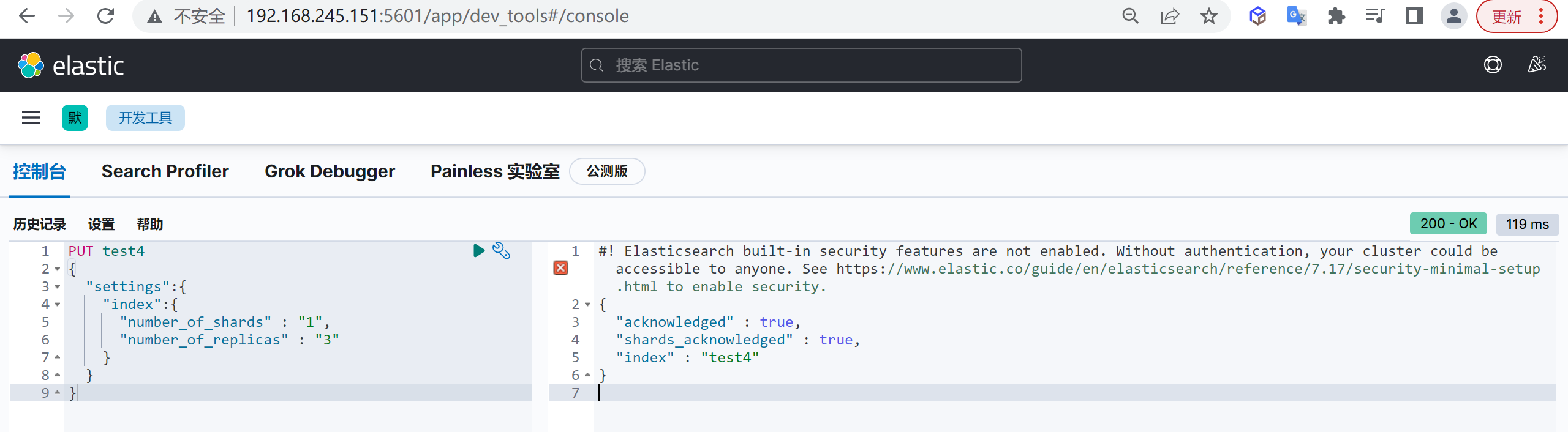

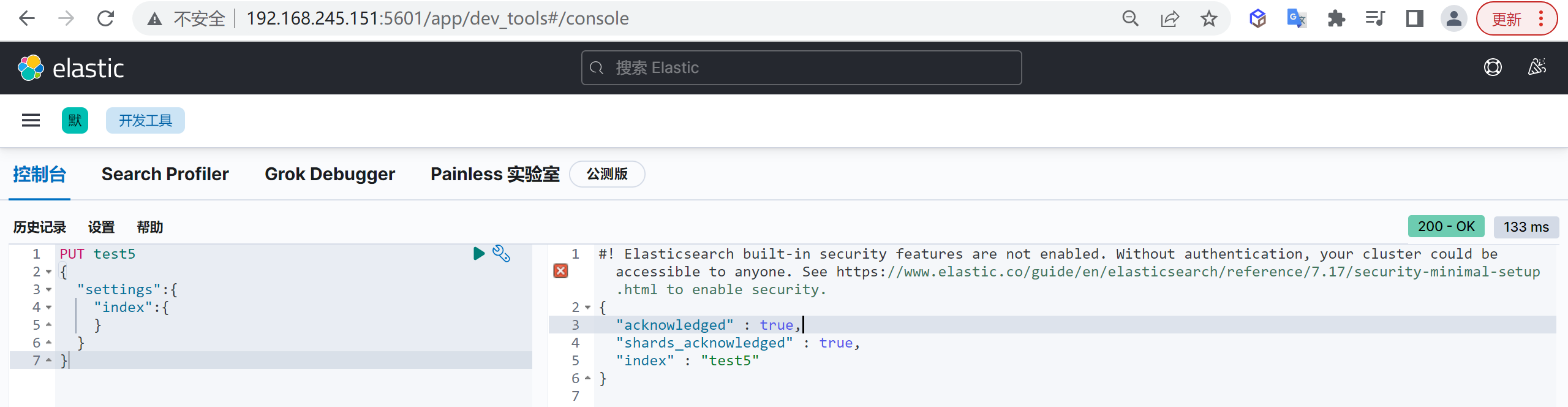

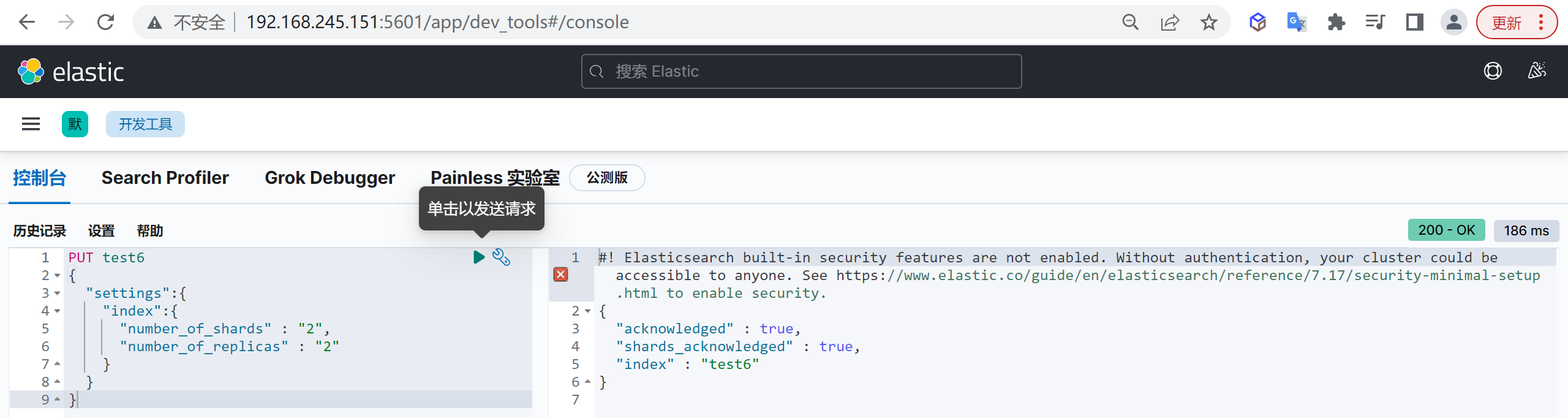

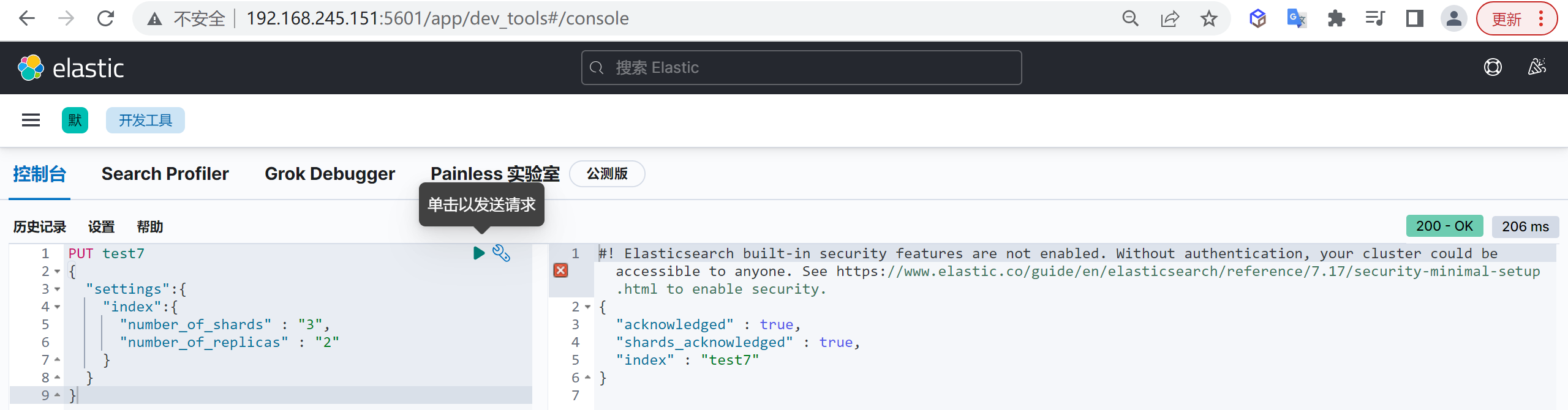

| settings.index.number_of_shards | 数据分片数,索引要做多少个分片,只能在创建索引时指定,后期无法修改 |

| settings.index.number_of_replicas | 数据备份数,每个分片有多少个副本,后期可以动态修改 |

| settings.index.uuid | 索引id |

| settings.index.provided_name | 名称 |

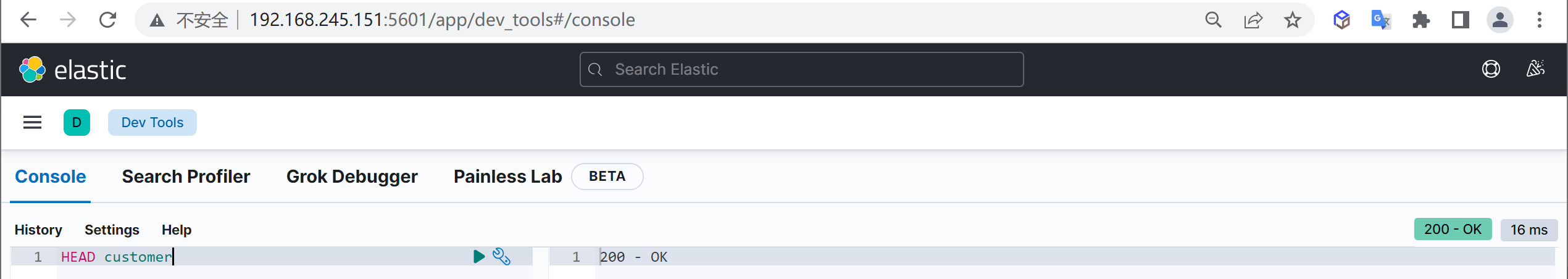

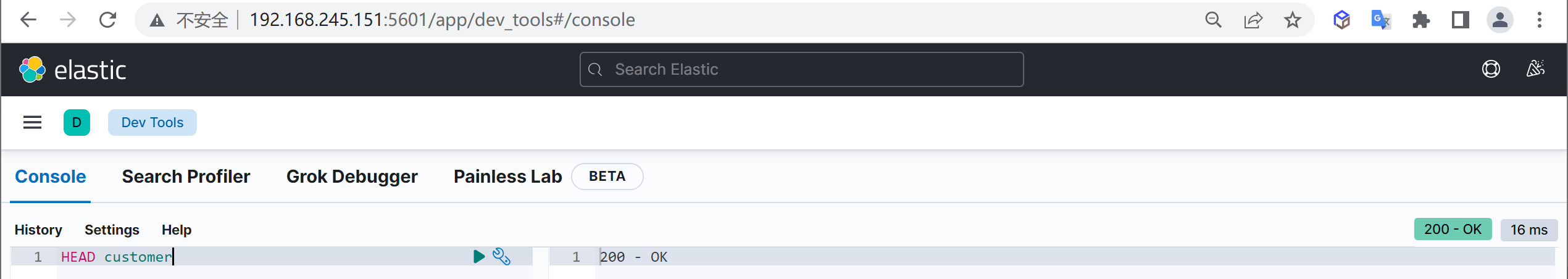

索引是否存在

有时候我们需要检查索引时候存在,我们可以使用HEAD命令验证索引是否存在

HEAD customer出现200表示索引存在

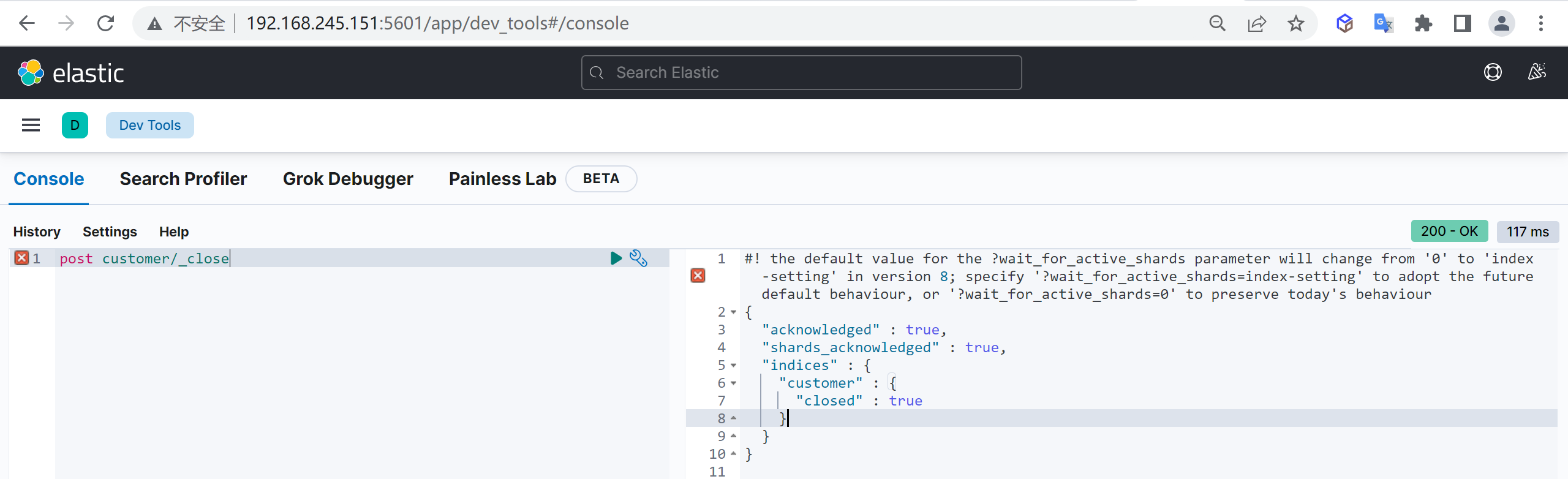

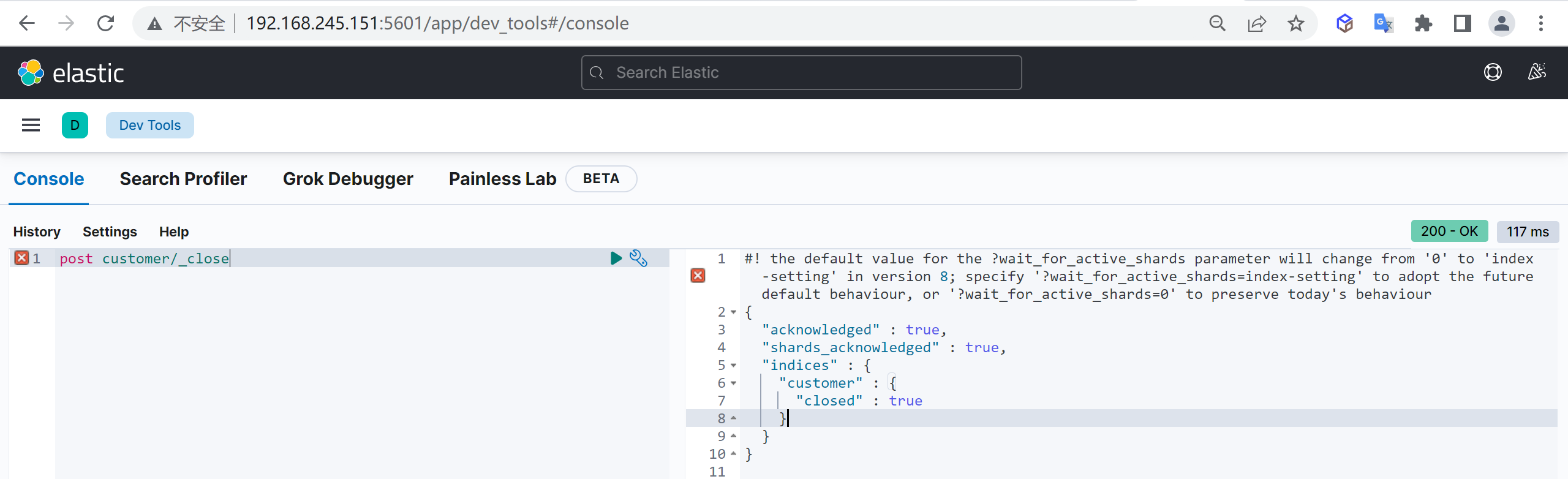

关闭索引

在一些业务场景,我们可能需要禁止掉某些索引的访问功能,但是又不想删除这个索引

post customer/_close这里我们就把这个索引给关闭了

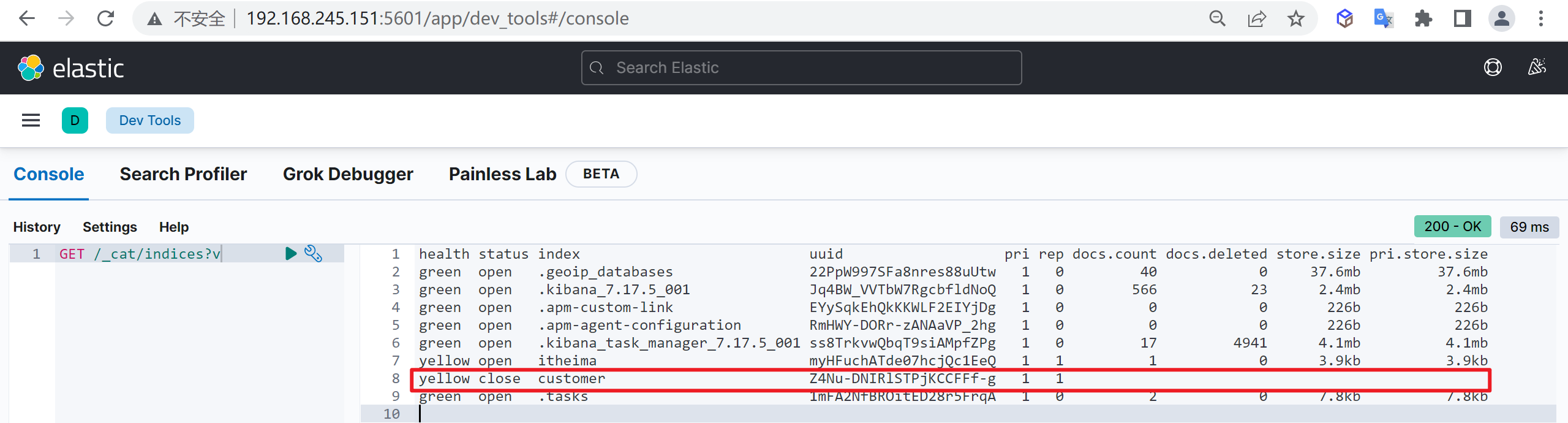

查看索引列表

再次查看索引列表,查看索引的状态

GET /_cat/indices?v我们发现索引已经被关闭了

为什么关闭索引

如果关闭了一个索引,就无法通过Elasticsearch 来读取和写人其中的数据,直到再次打开它

在现实世界中,最好永久地保存应用日志,以防要查看很久之前的信息,另一方面,在Elasticsearch中存放大量数据需要增加资源,对于这种使用案例,关闭旧的索引非常有意义,你可能并不需要那些数据,但是也不想删除它们。

一旦索引被关闭,它在Elasticsearch内存中唯一的痕迹是其元数据,如名字以及分片的位置,如果有足够的磁盘空间,而且也不确定是否需要在那个数据中再次搜索,关闭索引要比删除索引更好,关闭它们会让你非常安心,随时可以重新打开被关闭的索引,然后在其中再次搜索

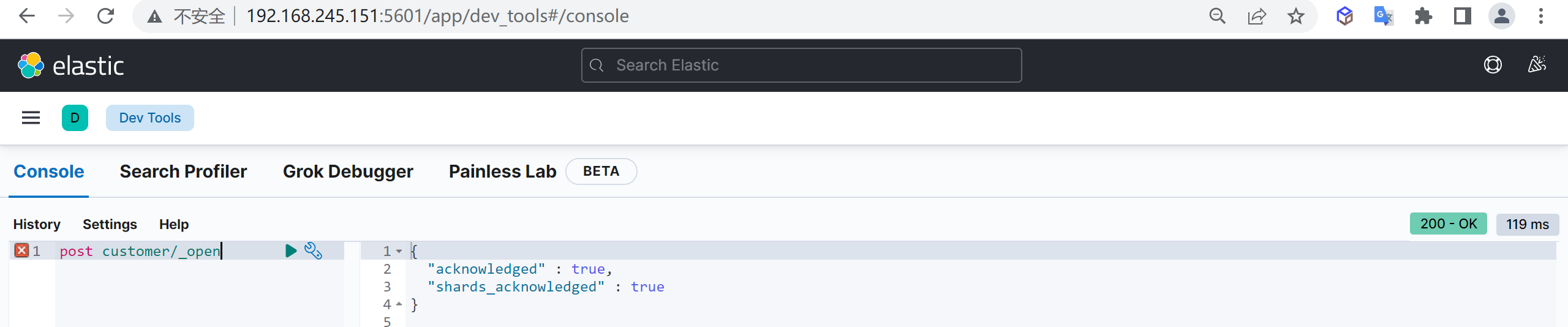

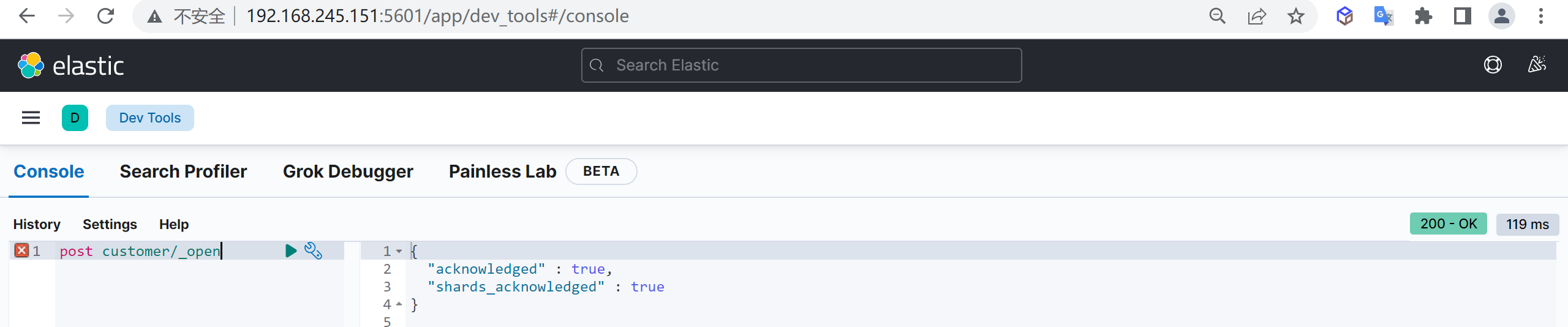

打开索引

如果我们需要继续启动索引可以直接打开索引

post customer/_open现在我们已经打开了索引

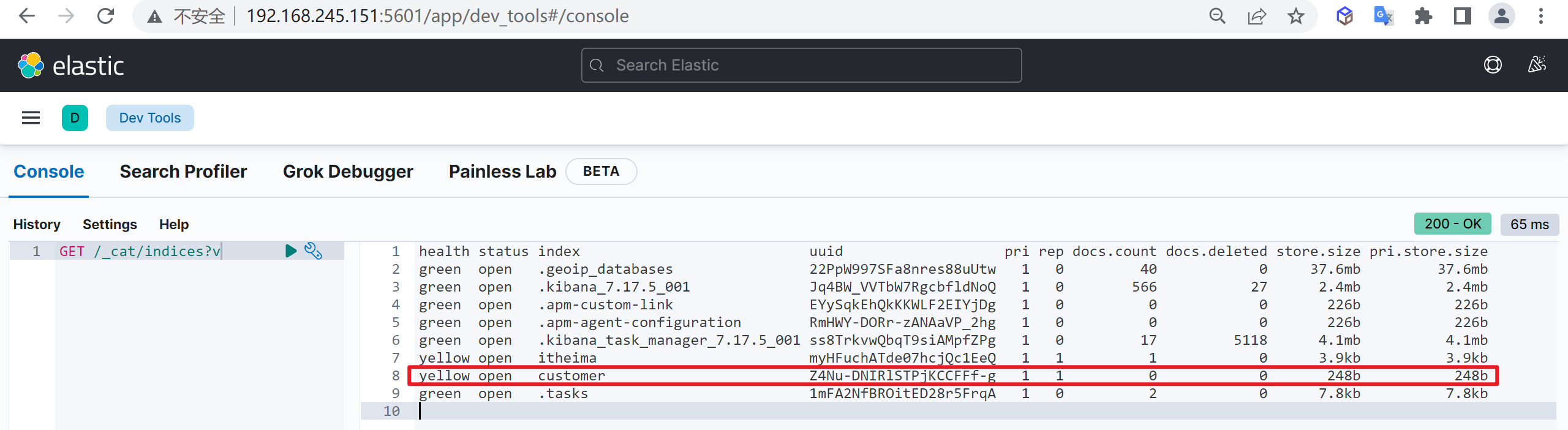

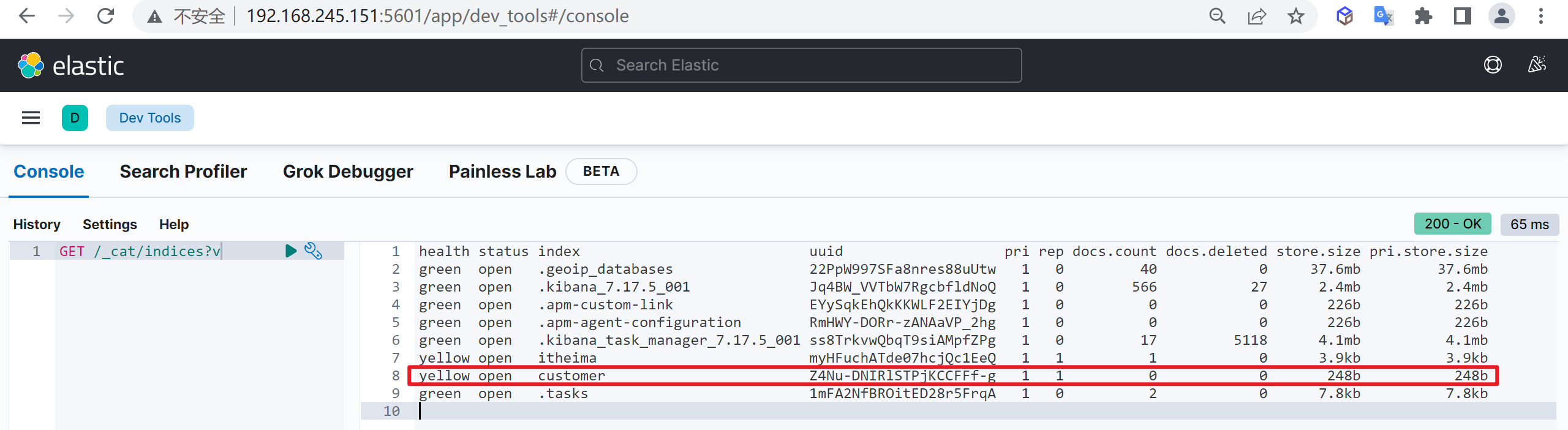

查看索引列表

GET /_cat/indices?v现在索引的状态已经是打开的状态了

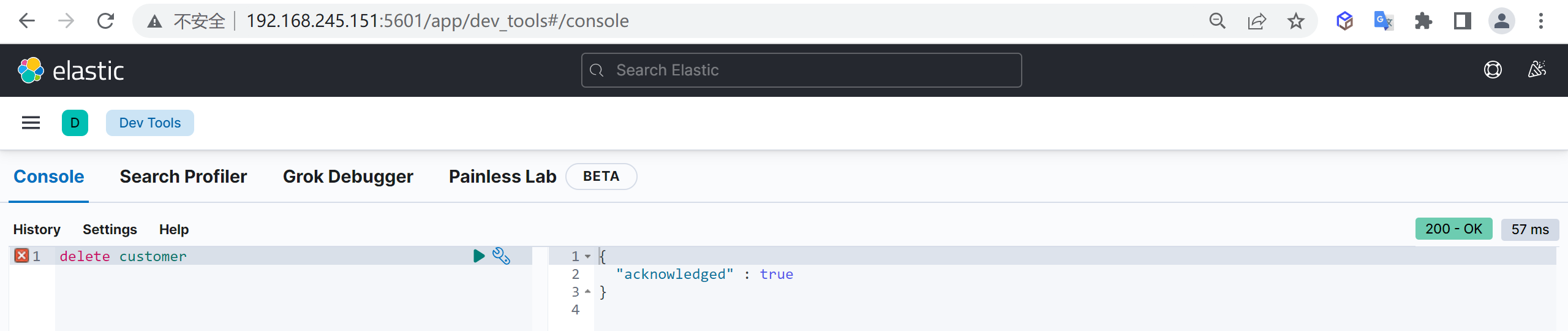

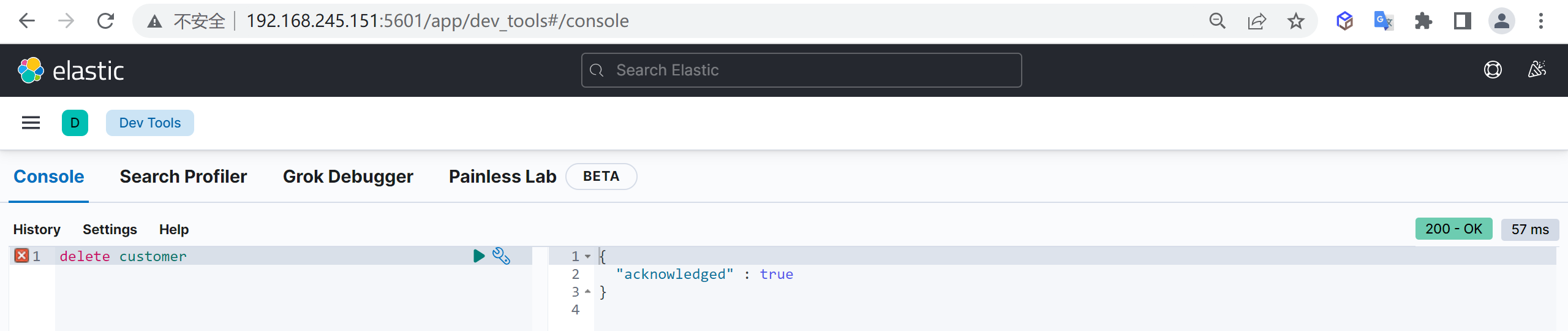

删除索引

如果索引中的数据已经不需要了,可以被删除,我们是可以删除索引的,使用以下命令可以删除索引

delete customer这样我们就把索引给删除了

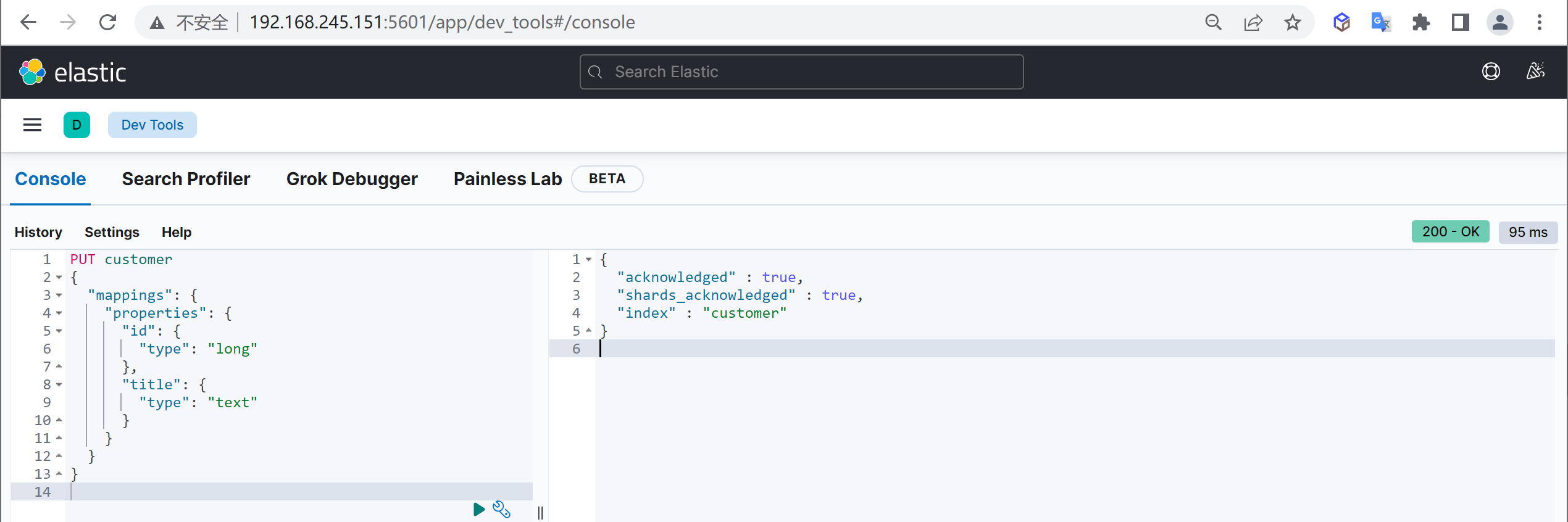

映射管理

映射的创建时基于索引的,你必须要先创建索引才能创建映射,es中的映射相当于传统数据库中的表结构,数据存储的格式就是通过映射来规定的

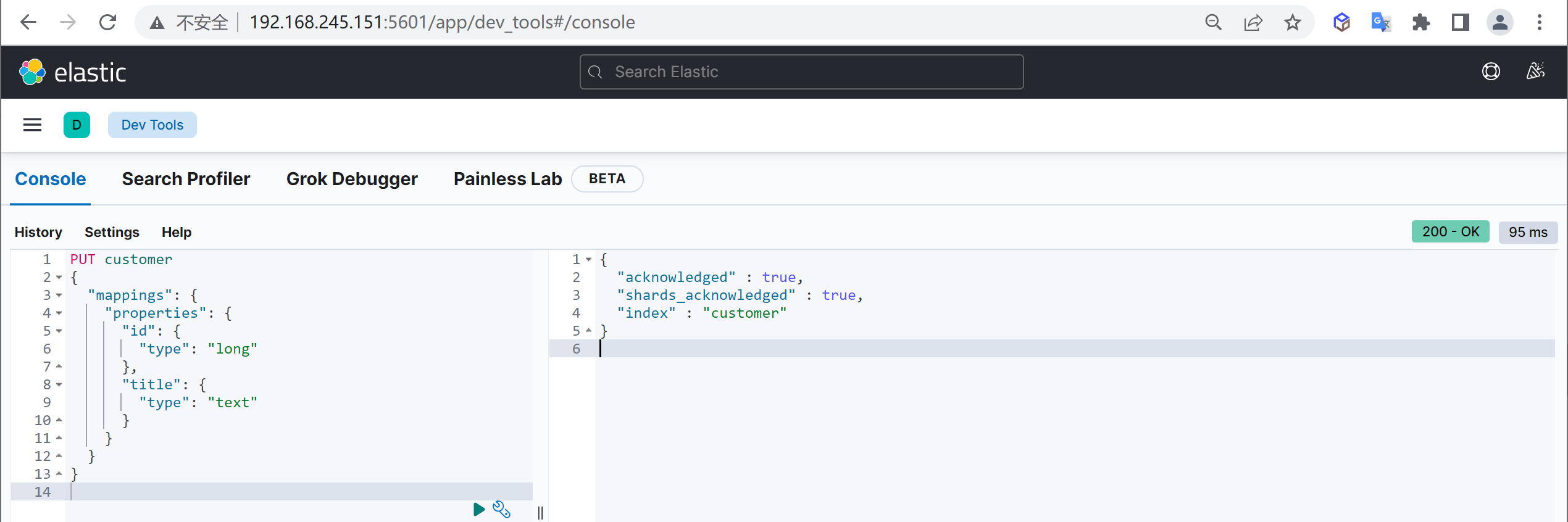

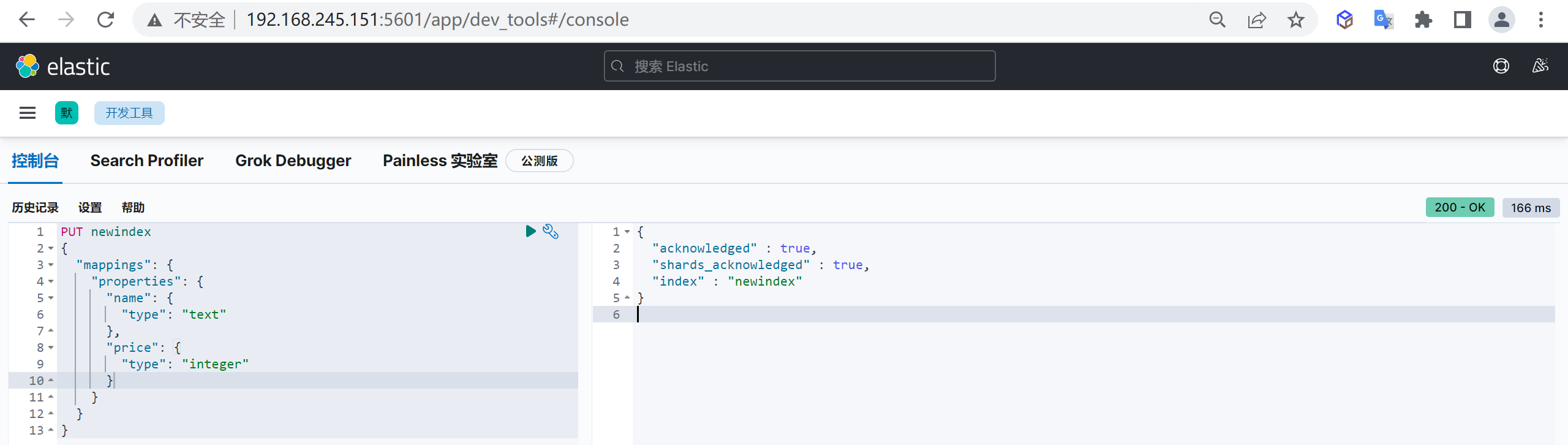

创建映射

可以在创建索引时指定映射,其中

mappings.properties为固定结构,指定创建映射属性

PUT customer

{

"mappings": {

"properties": {

"name": {

"type": "keyword"

},

"age": {

"type": "integer"

}

}

}

}

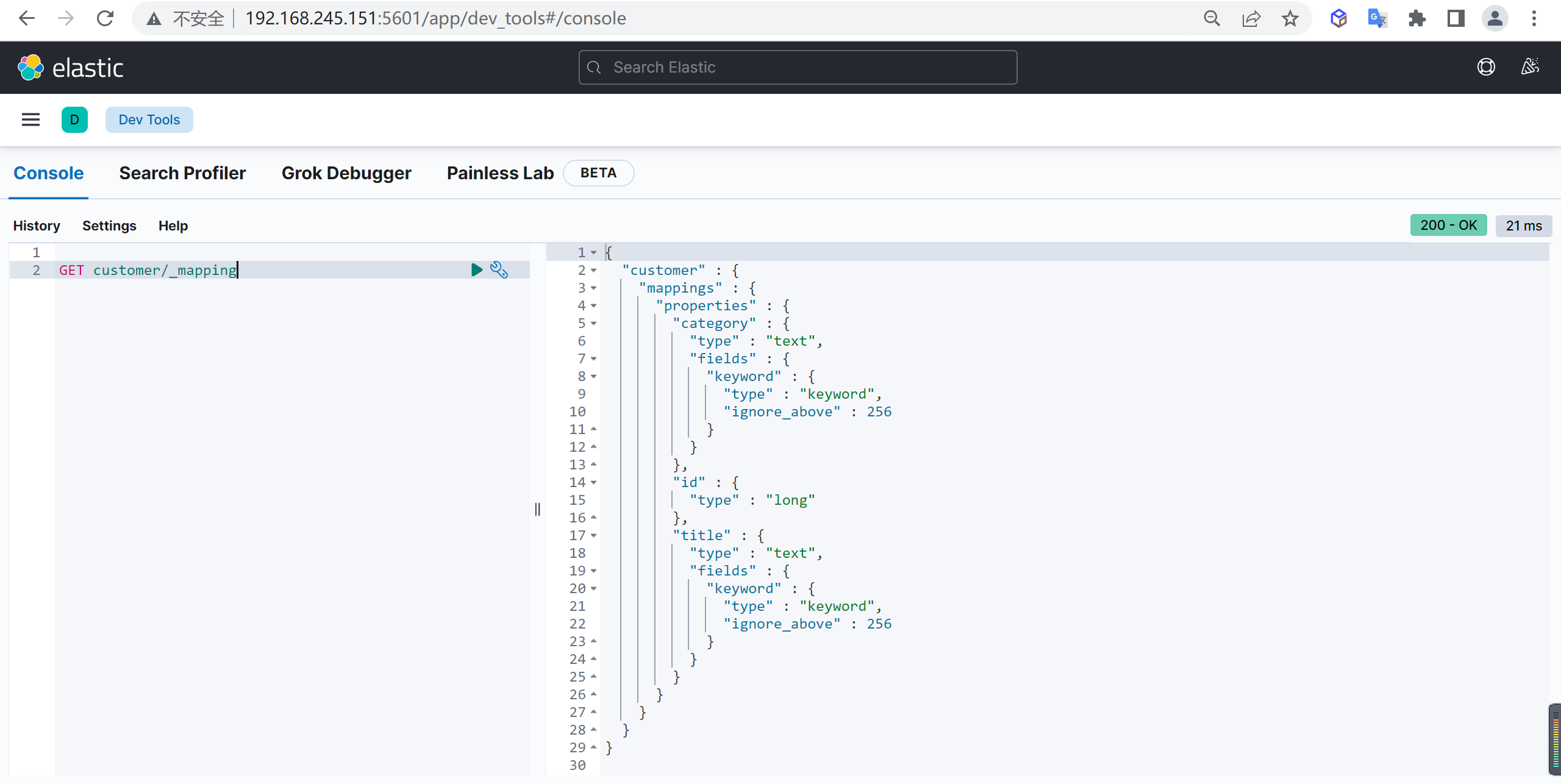

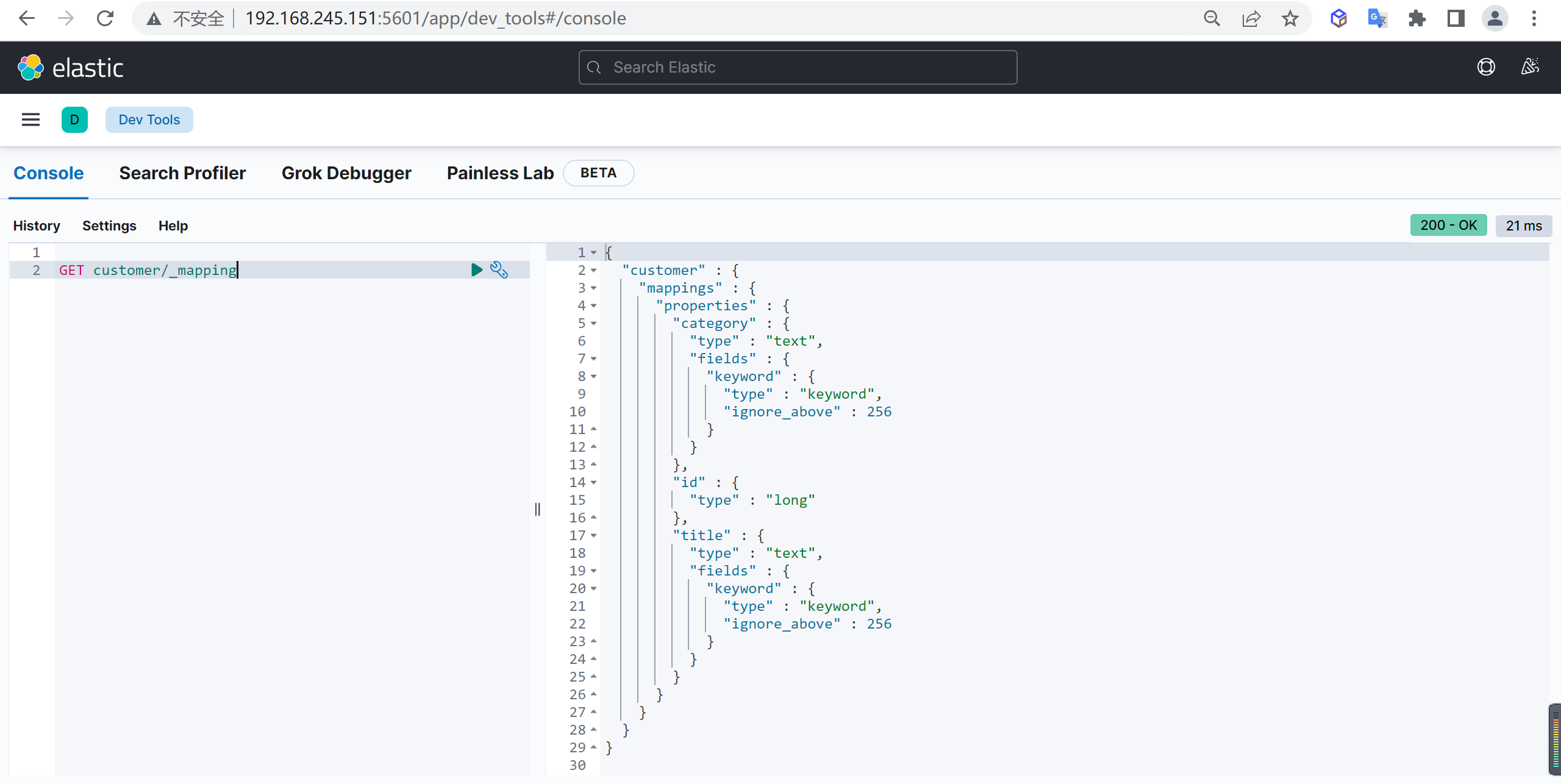

查看映射

查看索引完全信息,内容包含映射信息

GET customer/_mapping

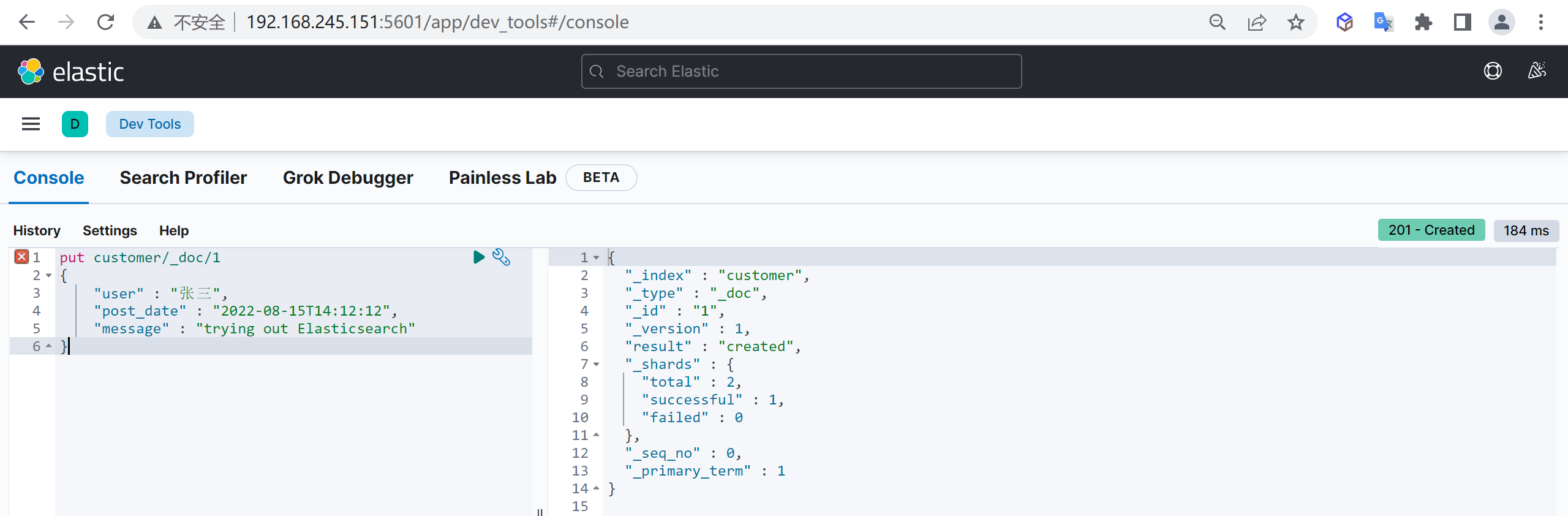

文档管理

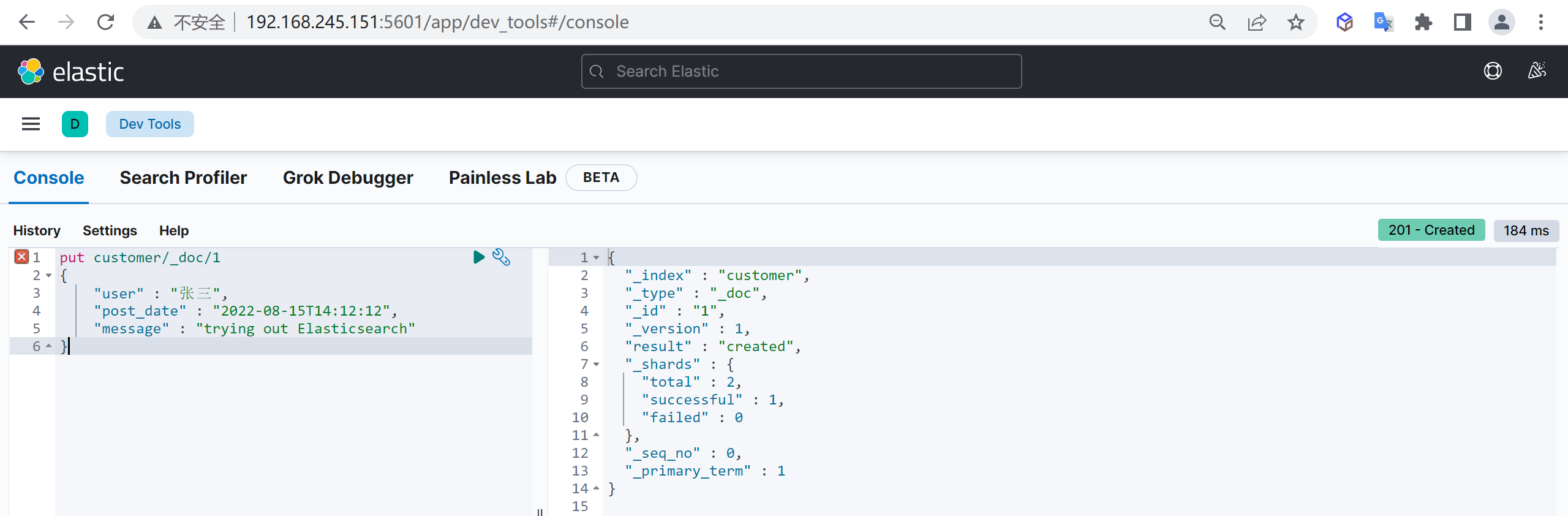

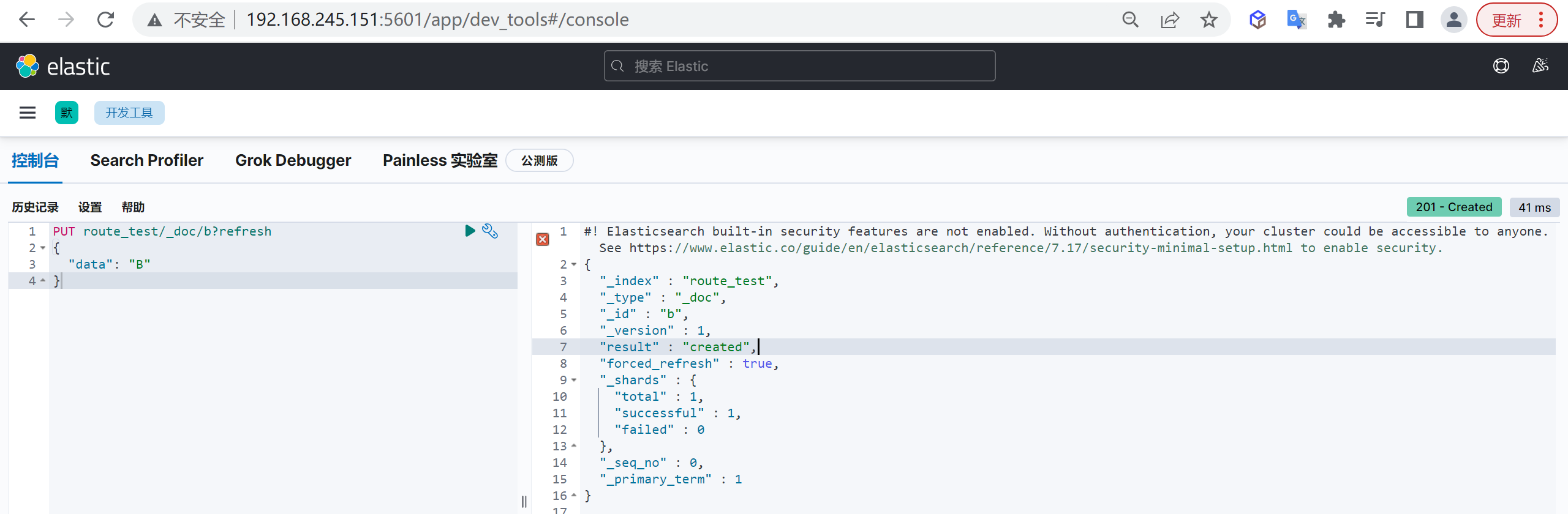

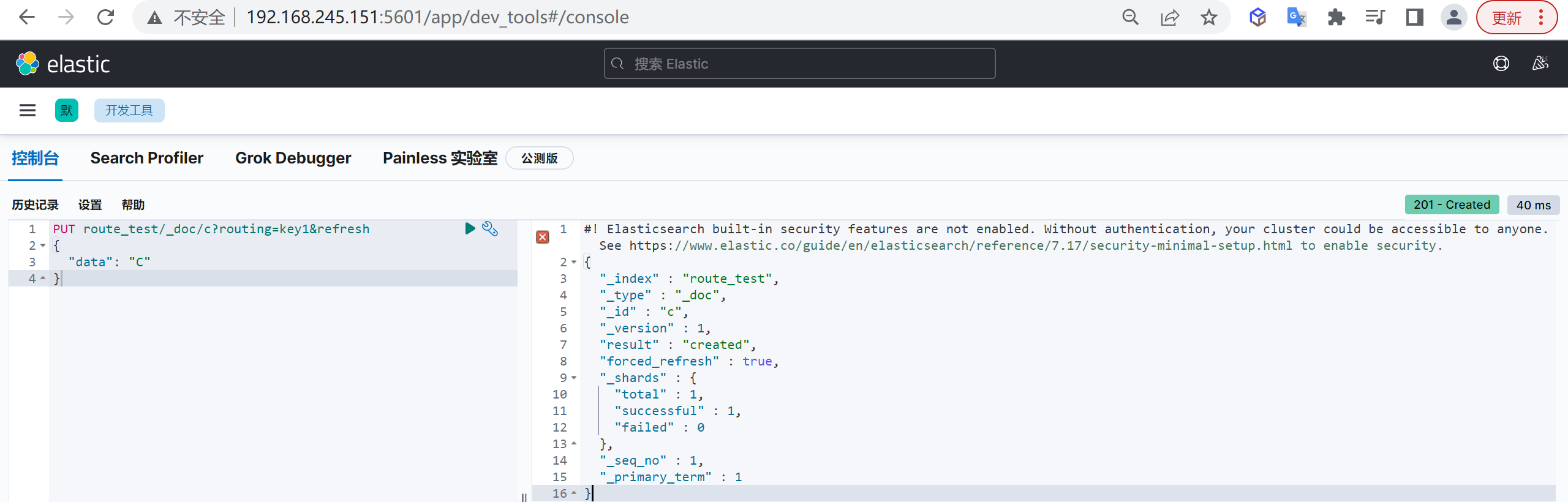

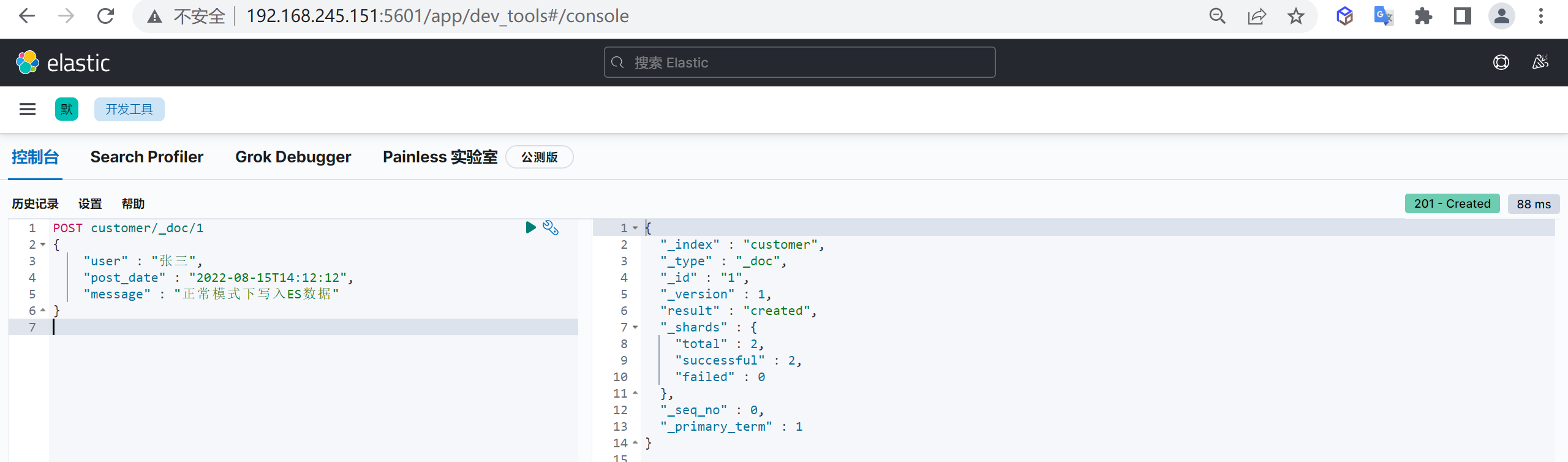

创建文档(业务ID)

创建文档的时候我们可以手动来指定ID,但是一般不推荐,回对ES插入性能造成影响

如果手动指定ID,为了保证ID不冲突,会先查询一次文档库,如果不存在则进行插入,手动插入多了一次查询操作,性能会有损失。

操作说明

- 文档可以类比为关系型数据库中的表数据,添加的数据格式为 JSON 格式

- 注意需要在索引后面添加

_doc,表示操作文档 - 在未指定id生成情况,每执行一次post将生成一个新文档

- 如果index不存在,将会默认创建

使用示例

新增文档,自动生成文档id,并且如果如果添加文档的索引不存在时会自动创建索引

post customer/_doc/1

{

"name" : "张三",

"age" : 15

}这样我们就创建了一个文档

返回结果说明

{

"_index" : "customer", #所属索引

"_type" : "_doc", #所属mapping type

"_id" : "1", #文档id

"_version" : 1, #文档版本

"result" : "created", #文档创建成功

"_shards" : {

"total" : 2, #所在分片有两个分片

"successful" : 1, #只有一个副本成功写入,可能节点机器只有一台

"failed" : 0 #失败副本数

},

"_seq_no" : 0, #第几次操作该文档

"_primary_term" : 1 #词项数

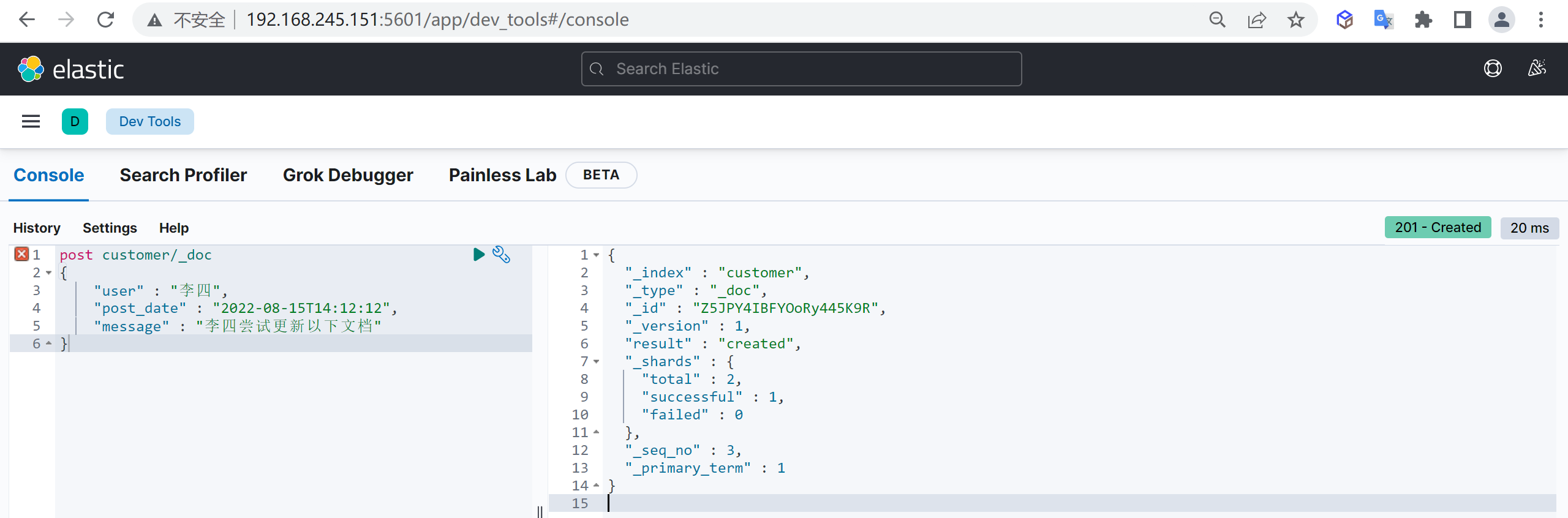

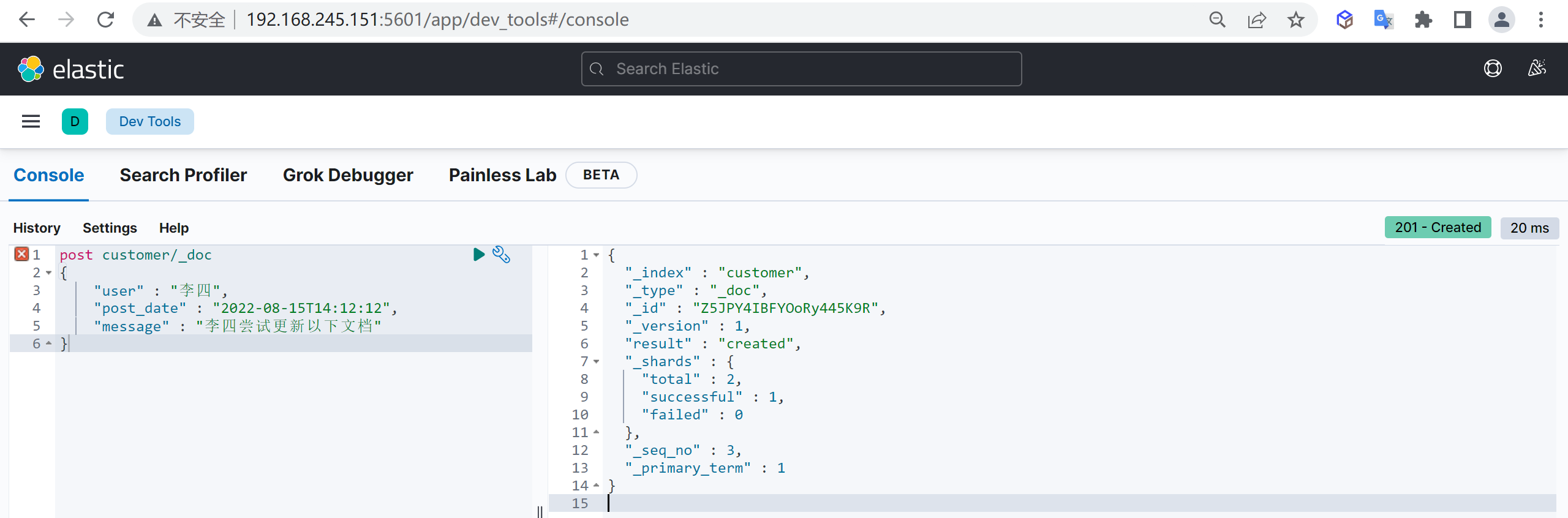

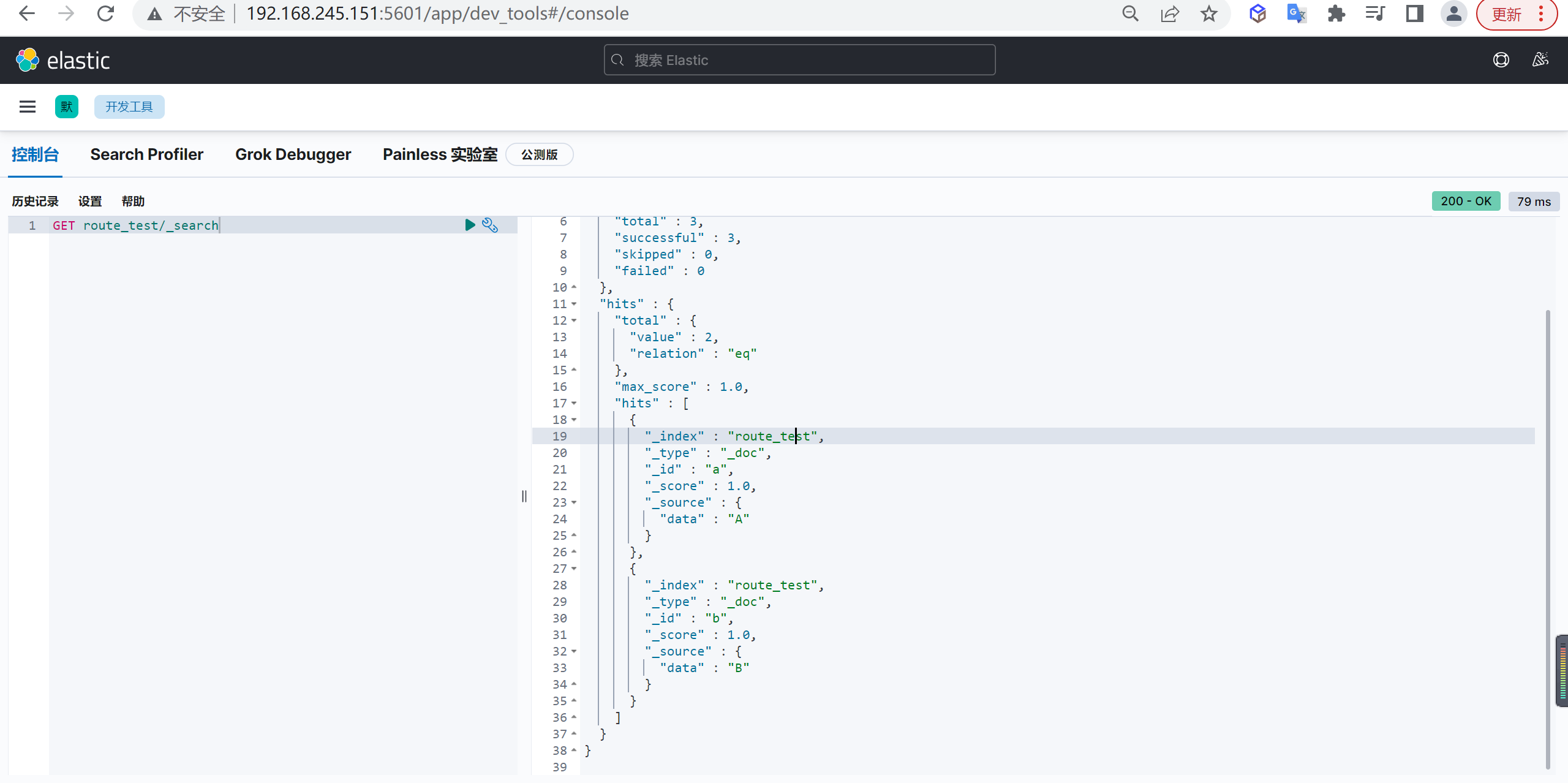

}创建文档(自动ID)

为了提高插入文档效率,我们一般会使用自动生成ID,这样减少一次插入时的查询性能损耗,插入时不指定文档ID,ES就会自动生成ID

自动生成的ID是一个不会重复的随机数,使用GUID算法,可以保证在分布式环境下,不同节点同一时间创建的_id一定是不冲突的

post customer/_doc

{

"name" : "李四",

"age" : 50

}这样创建了一个文档,并且文档ID是系统自动生成的

_id

更新文档

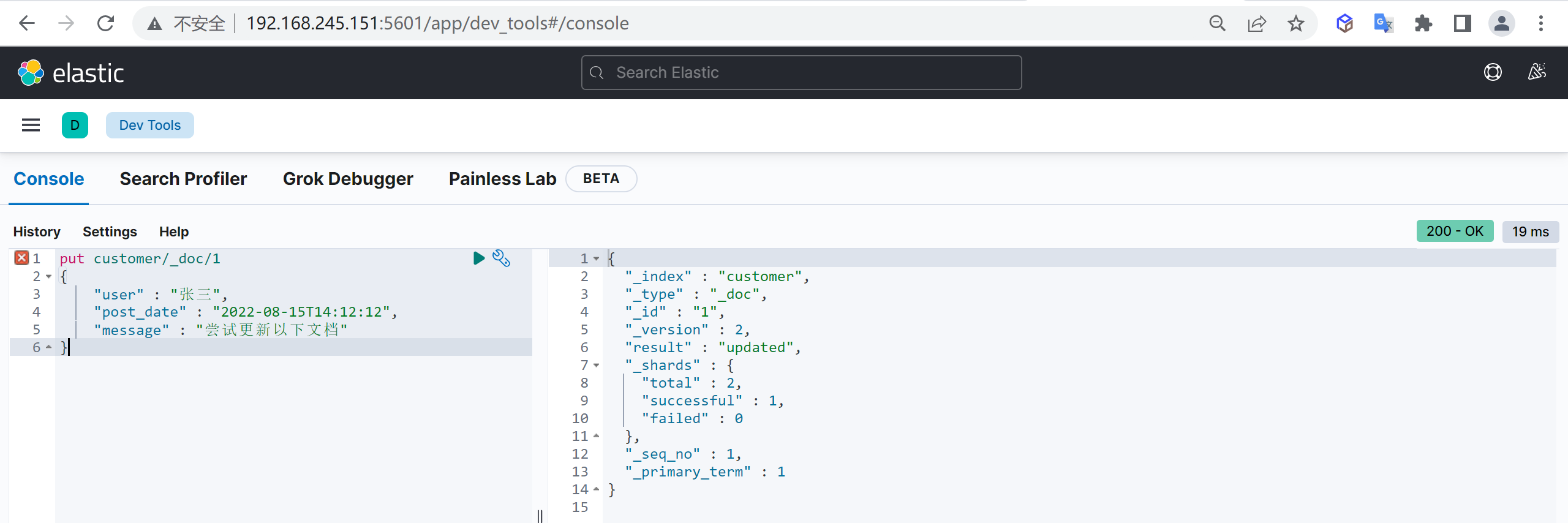

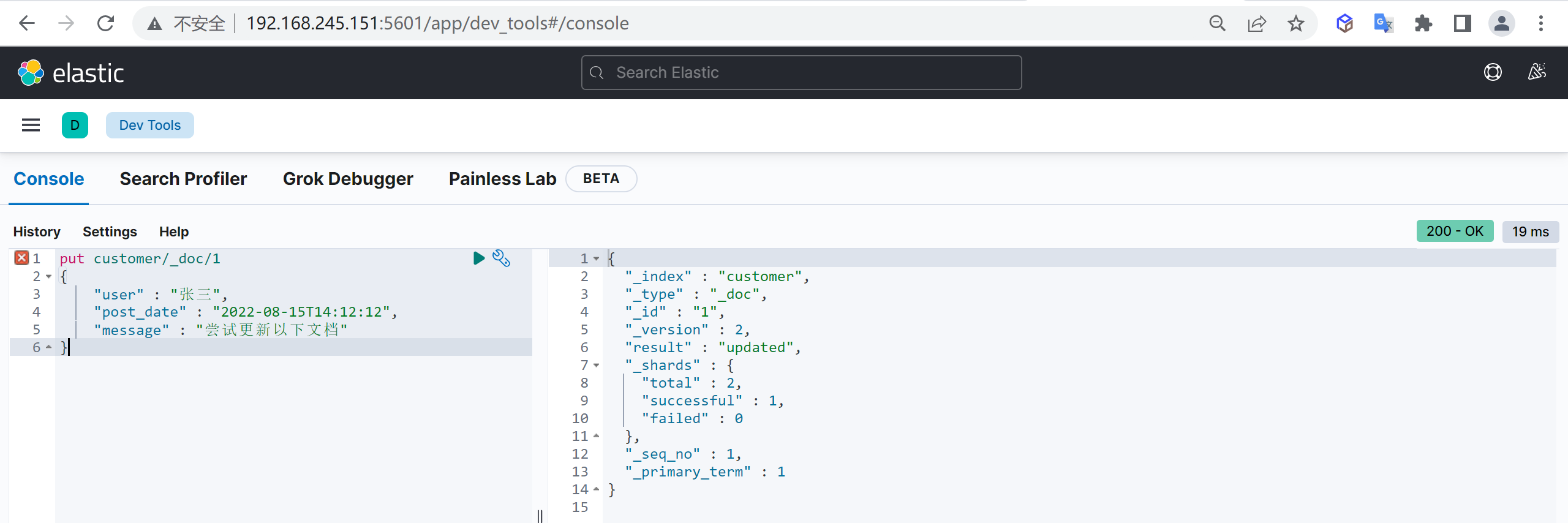

更新文档和插入文档一样,如果文档ID一致则会进行覆盖更新,而更新又分为全量更新和增量更新

全量更新

和新增文档一样,输入相同的 URL 地址请求,如果请求体变化,会将原有的数据内容覆盖

post customer/_doc/1

{

"name" : "张三",

"age" : 50

}

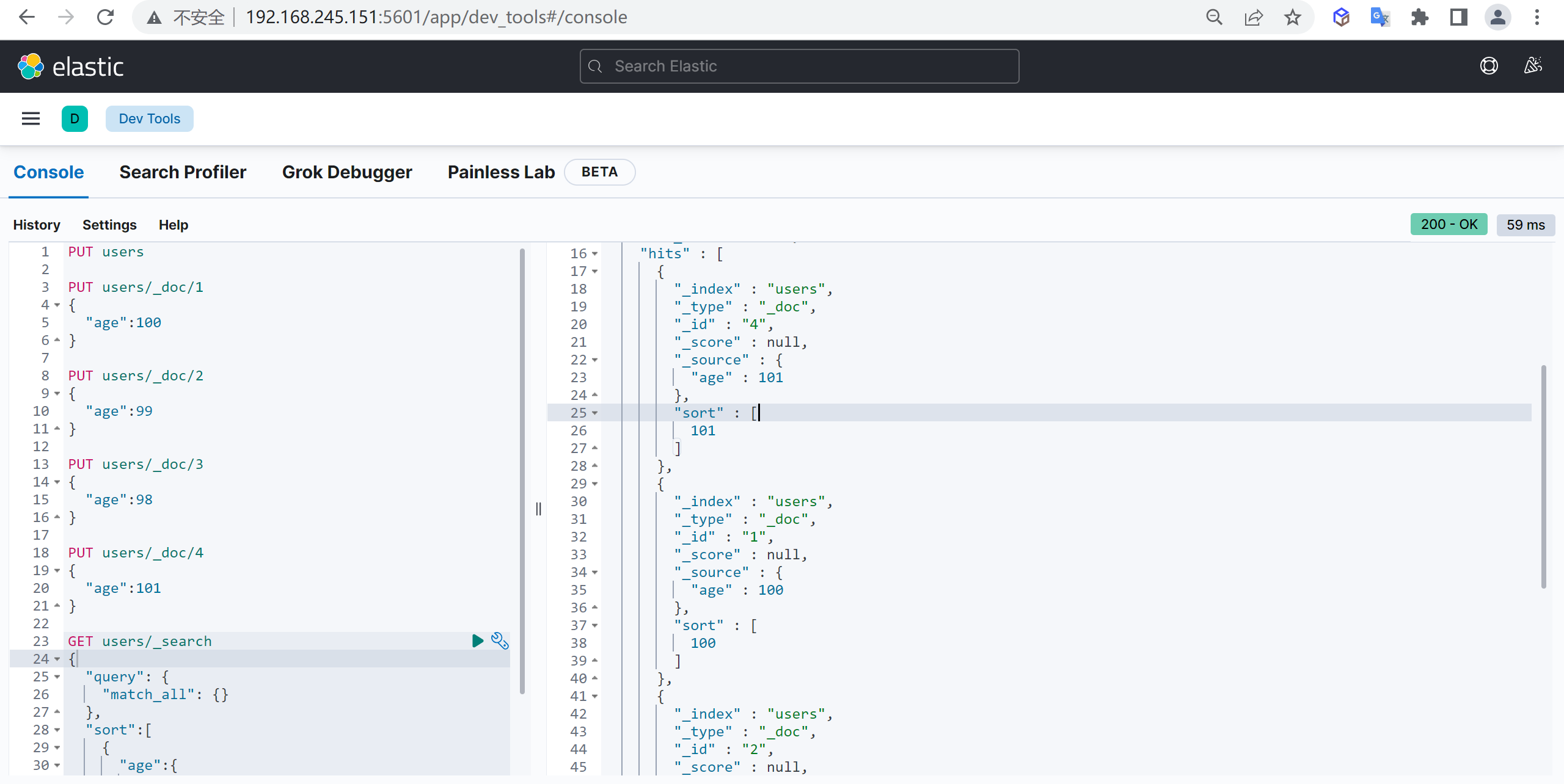

增量更新

通过指定

_doc方式默认是全量更新,如果需要更新指定字段则需要将_doc改为_update,请求内容需要增加doc表示,原始{“key”: value},更新{“doc”: {“key”: value}}

post customer/_update/1

{

"doc": {

"age" : 55

}

}查询文档

验证是否存在

可以通过以下命令检查文档是否存在

HEAD customer/_doc/1 #查看是否存储,返回200表示已存储查询文档

GET customer/_doc/1 #返回源数据的查询不返回source

有时候只是查询,不需要具体的源文档字段,这样可以提高查询速度,可以使用以下方式

GET customer/_doc/1?_source=false查询所有

上述只能查询单个,可以查询所有文档,将

_doc替换为_search

GET customer/_search删除文档

根据文档ID删除

我们可以根据文档ID进行删除

DELETE customer/_doc/1 #指定文档id进行删除根据条件删除

根据查询条件删除,会先查询然后在删除,可能耗时会比较长

post customer/_delete_by_query

{

"query": {

"match": {

"age": "15"

}

}

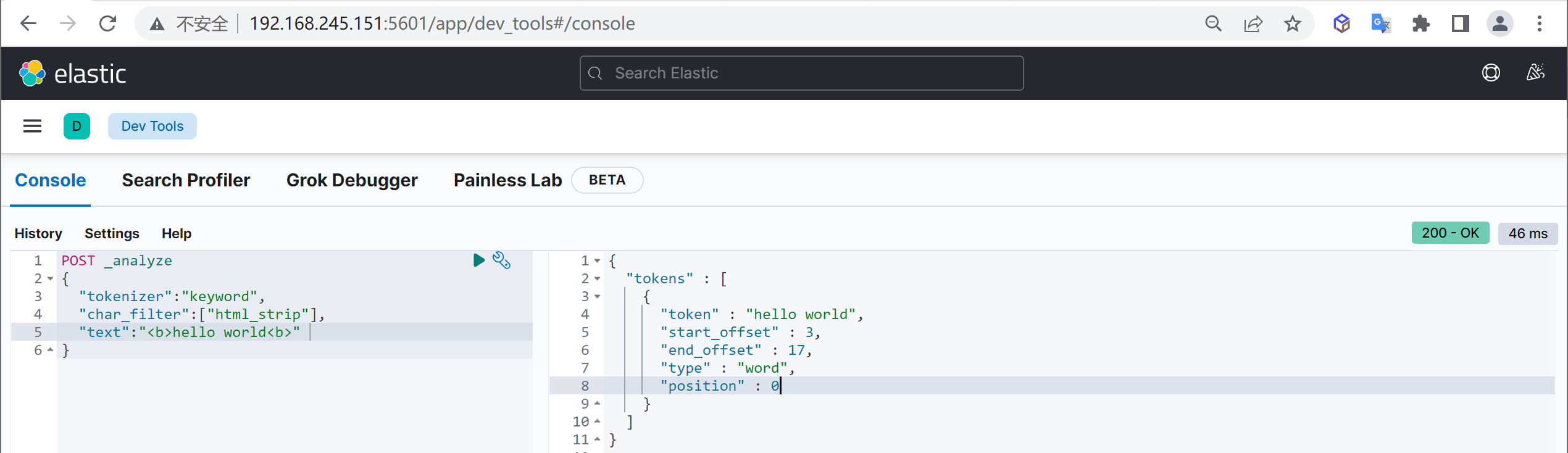

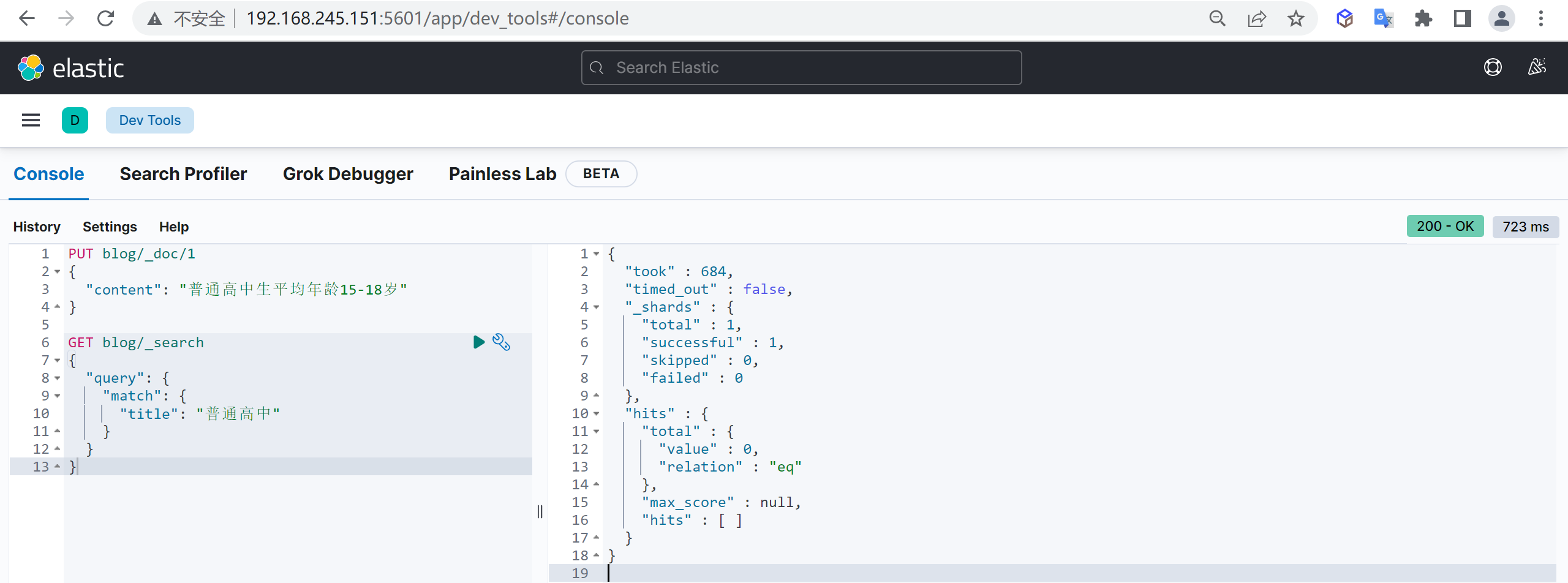

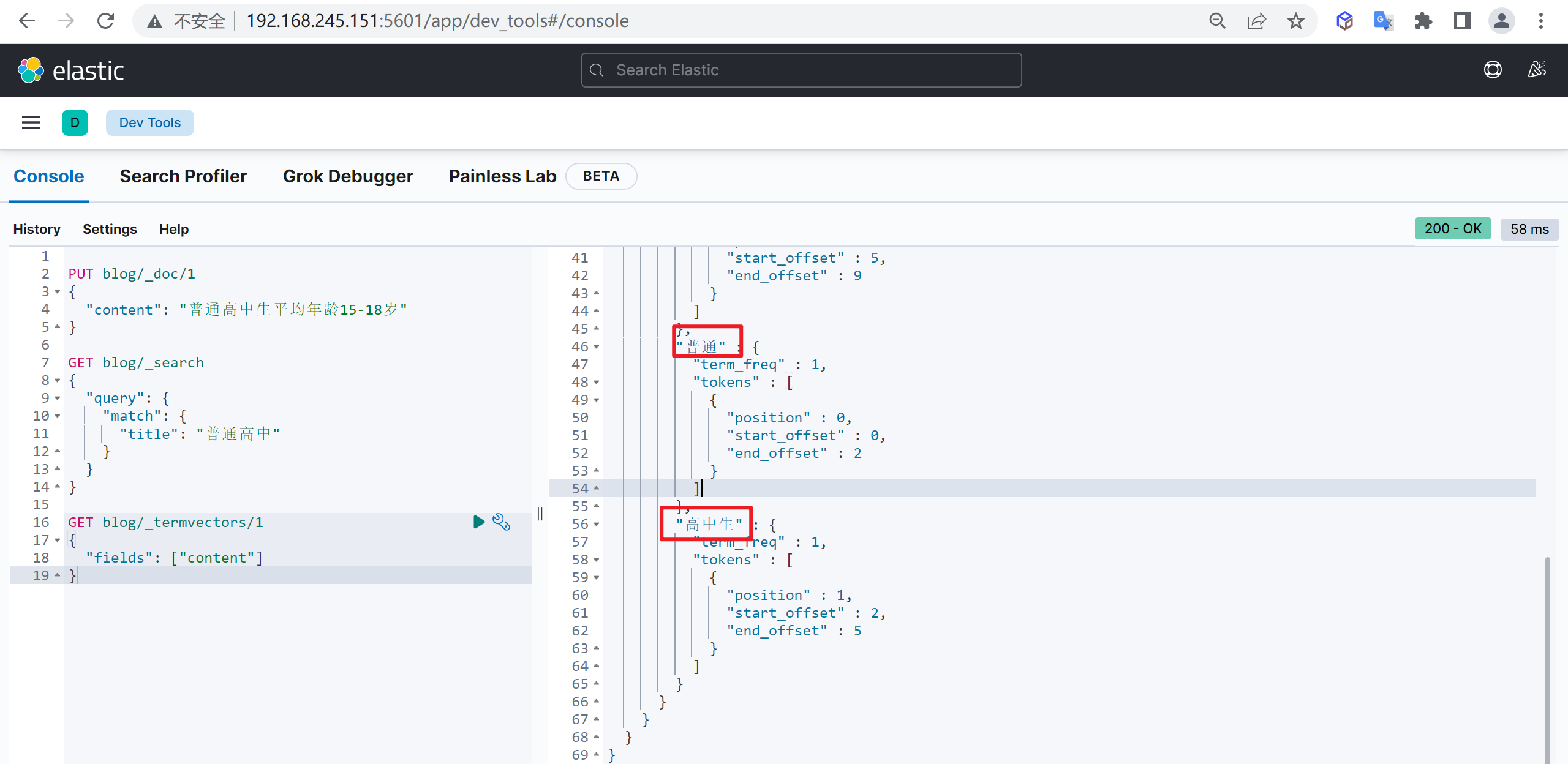

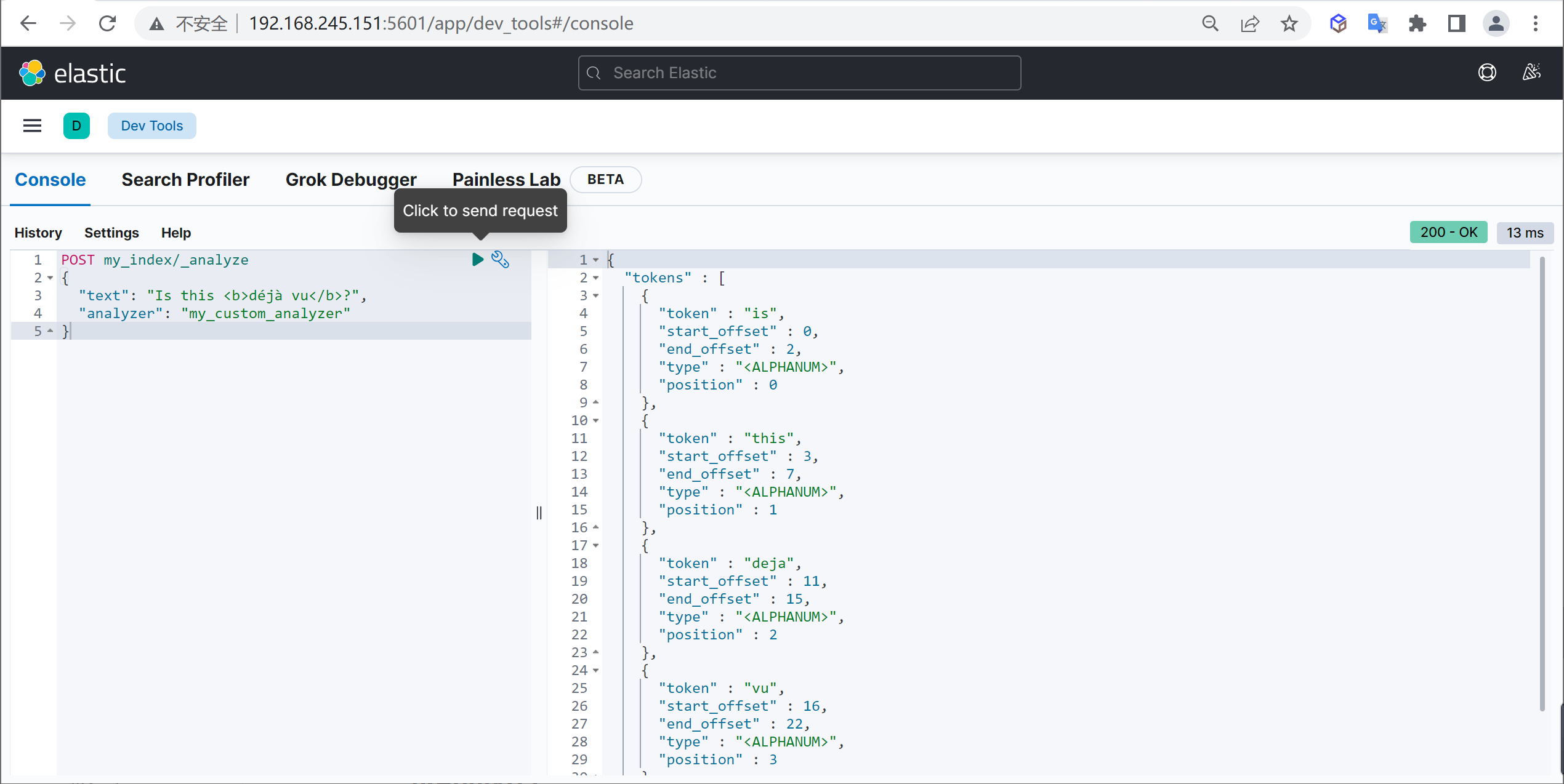

}中文分词器

IKAnalyzer

IKAnalyzer是一个开源的,基于java的语言开发的轻量级的中文分词工具包

从2006年12月推出1.0版开始,IKAnalyzer已经推出了3个大版本,在 2012 版本中,IK 实现了简单的分词歧义排除算法,标志着 IK 分词器从单纯的词典分词向模拟语义分词衍化

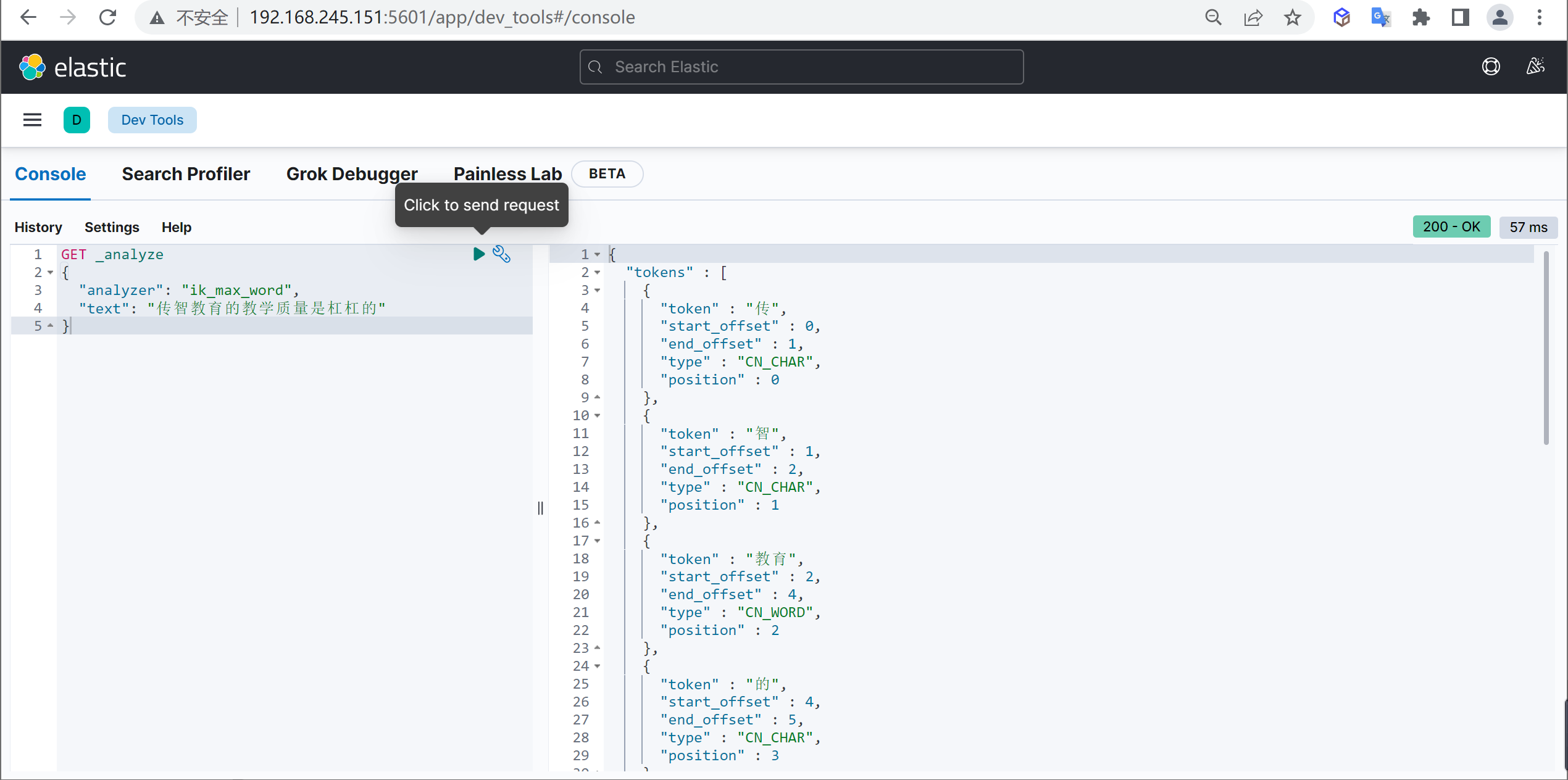

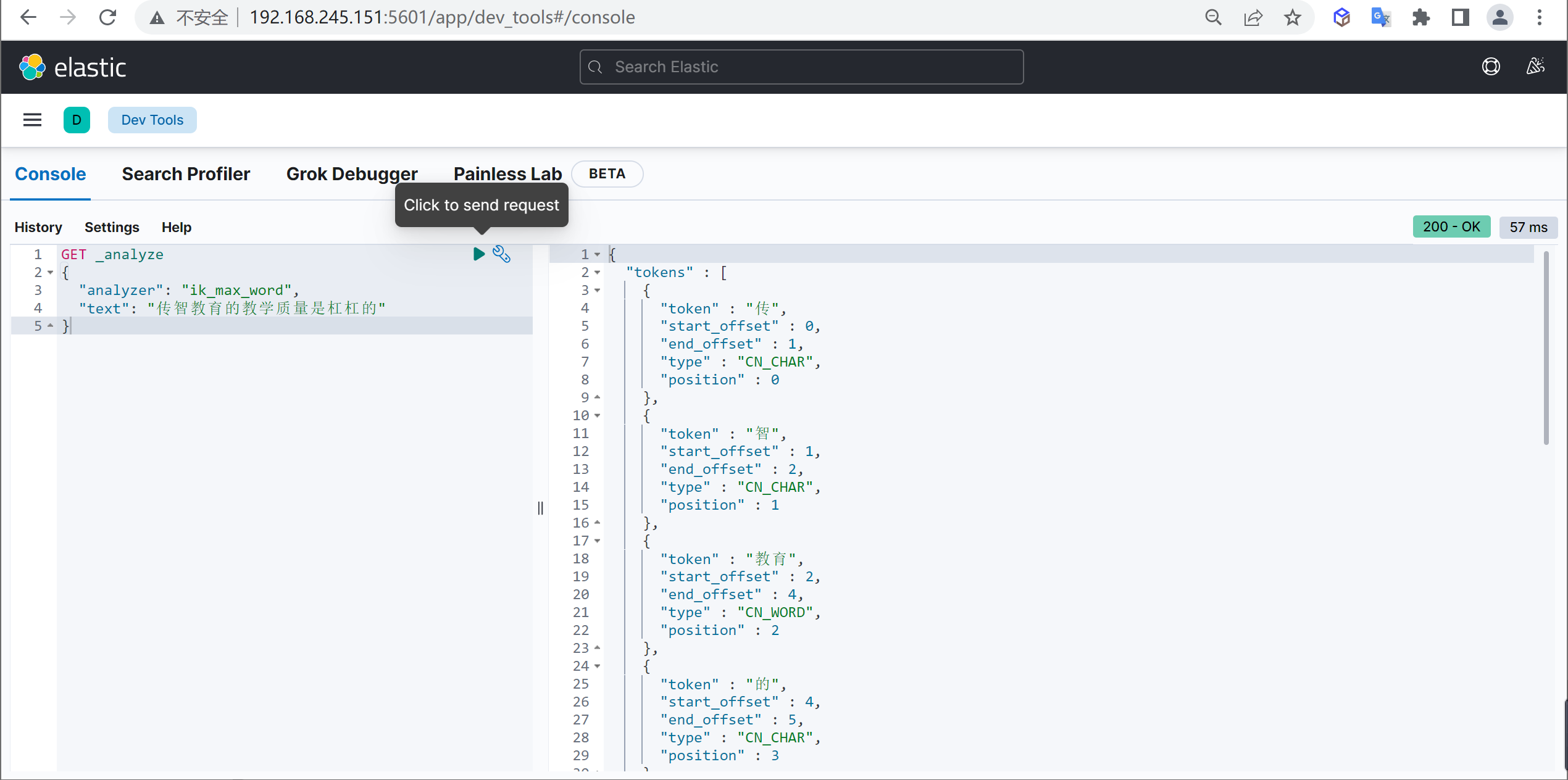

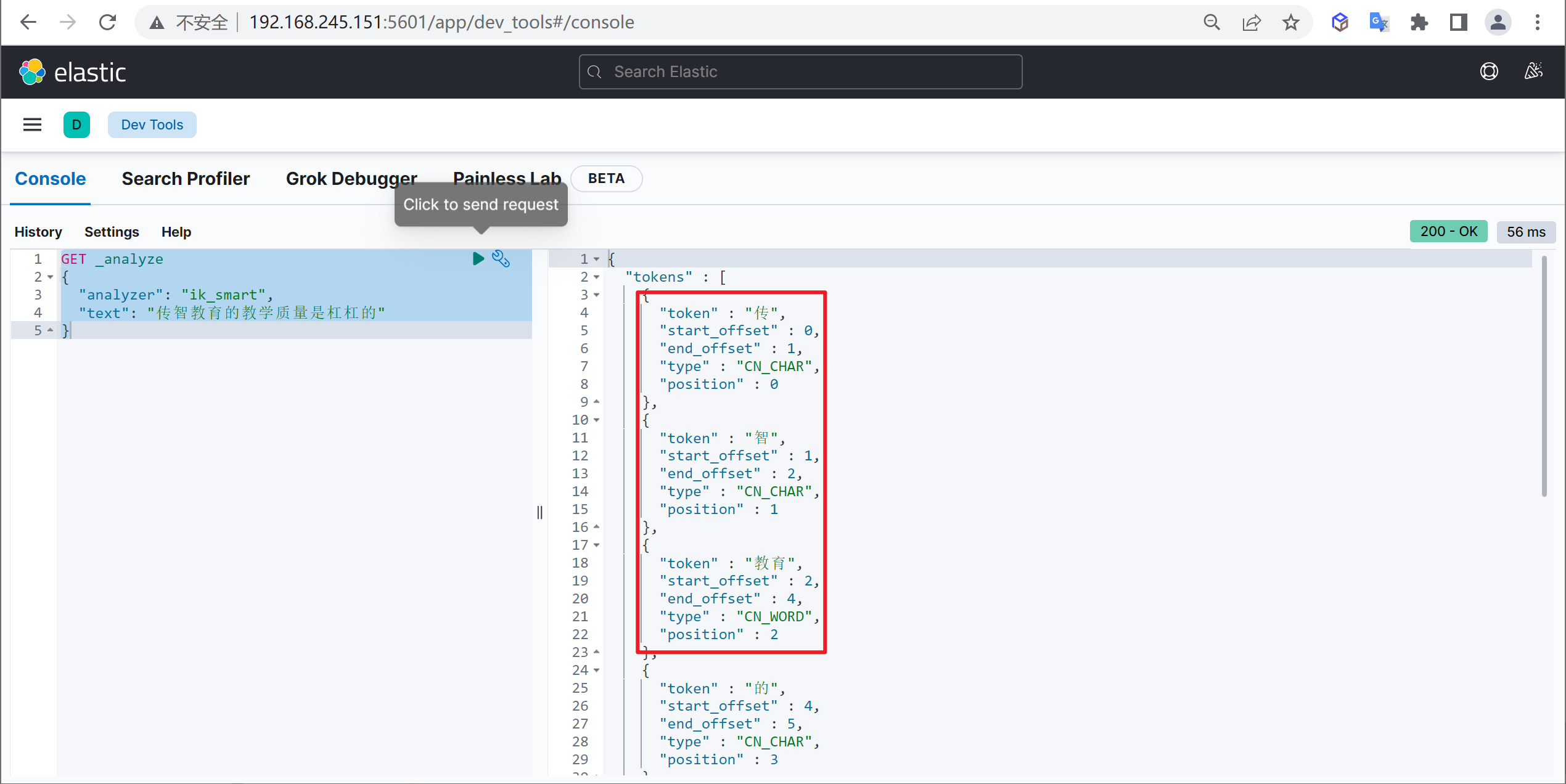

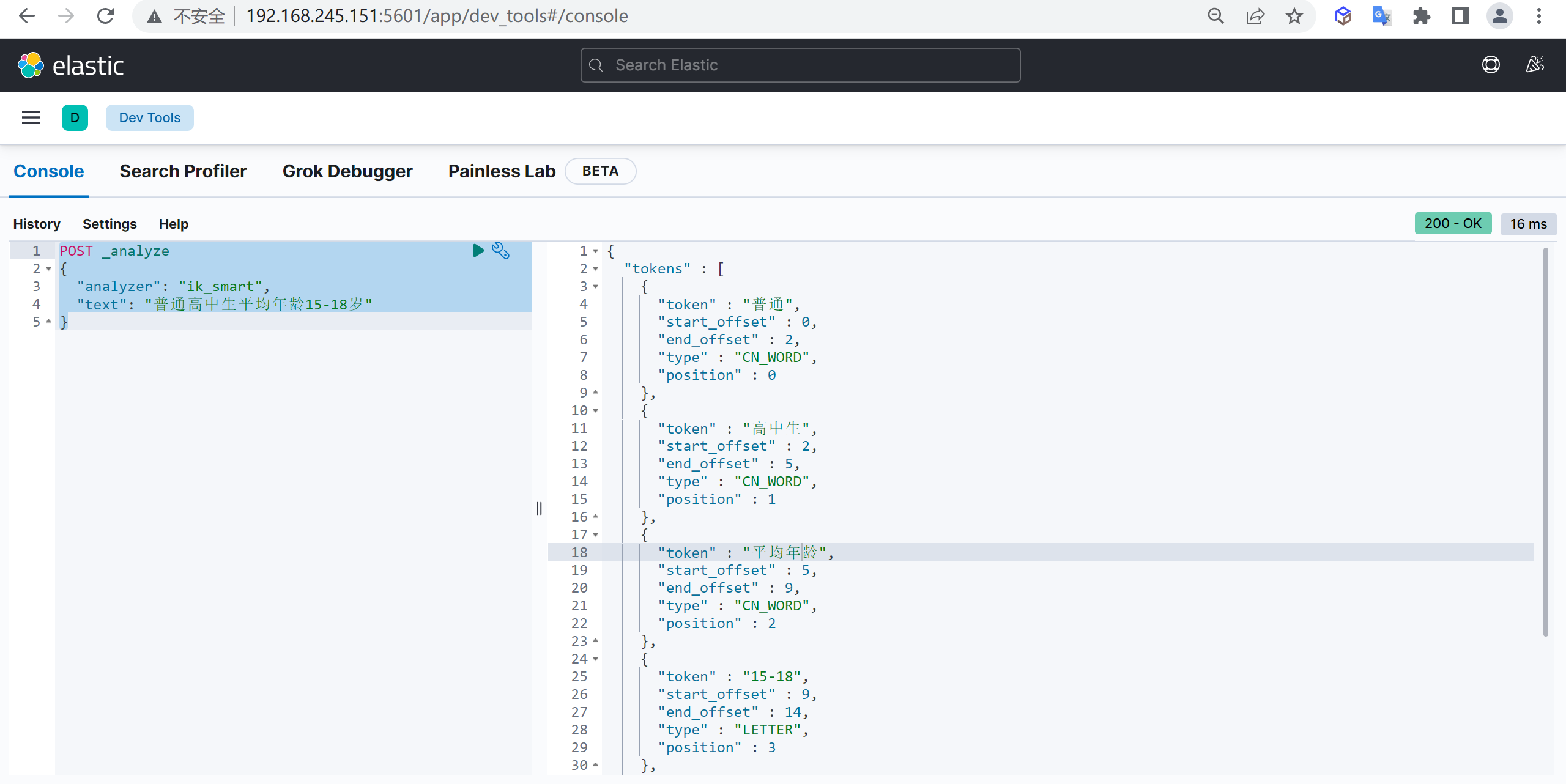

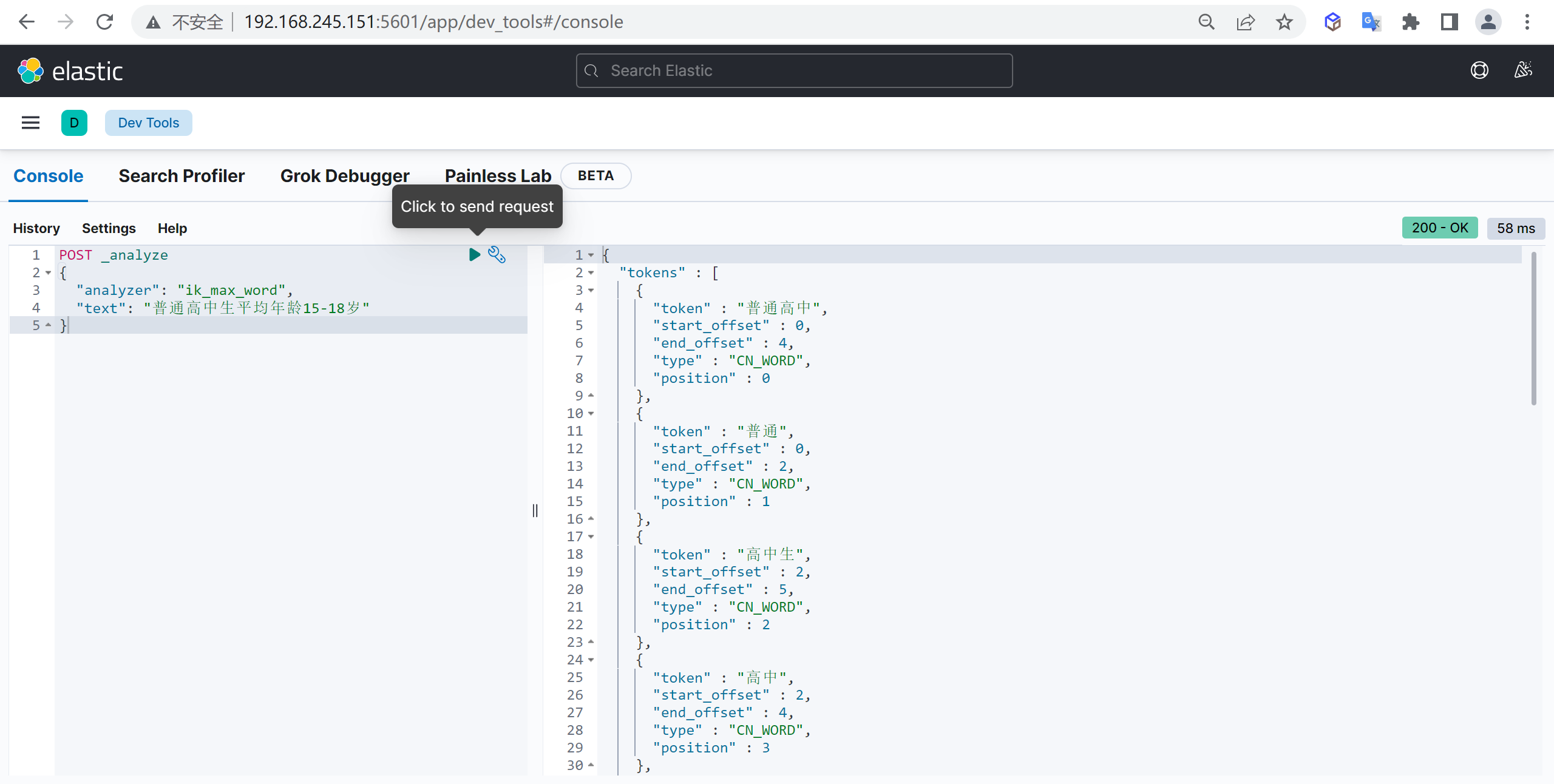

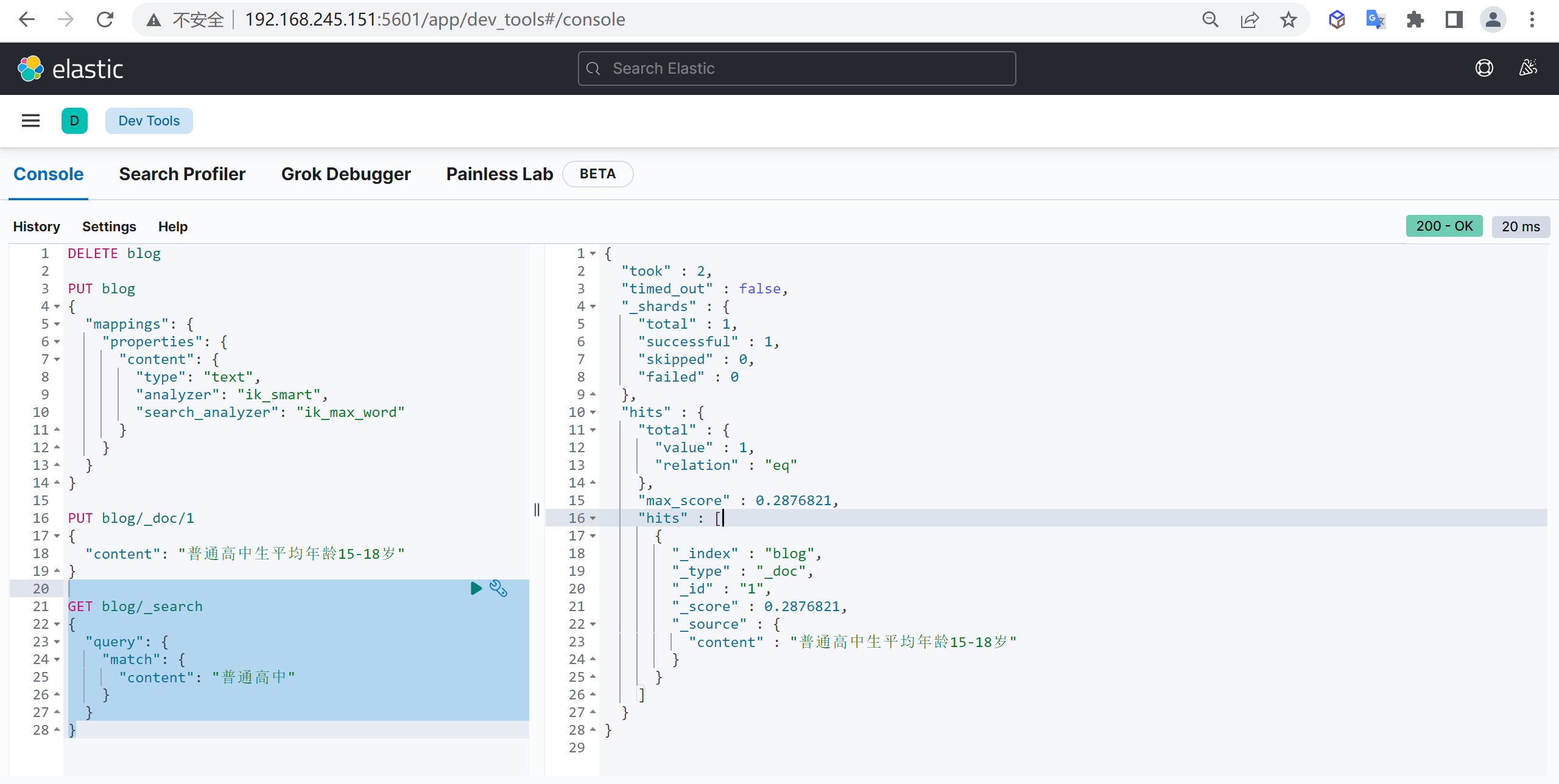

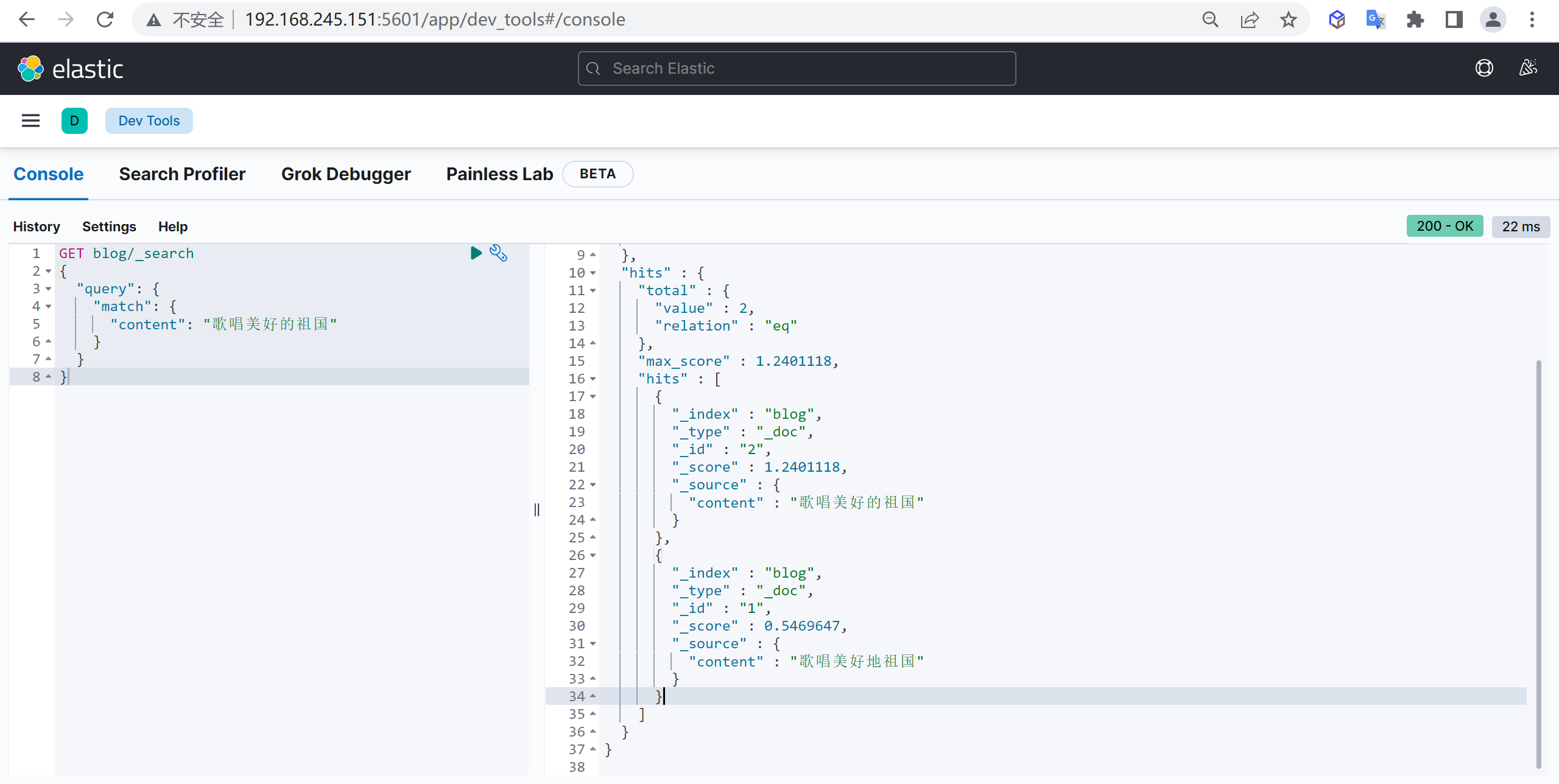

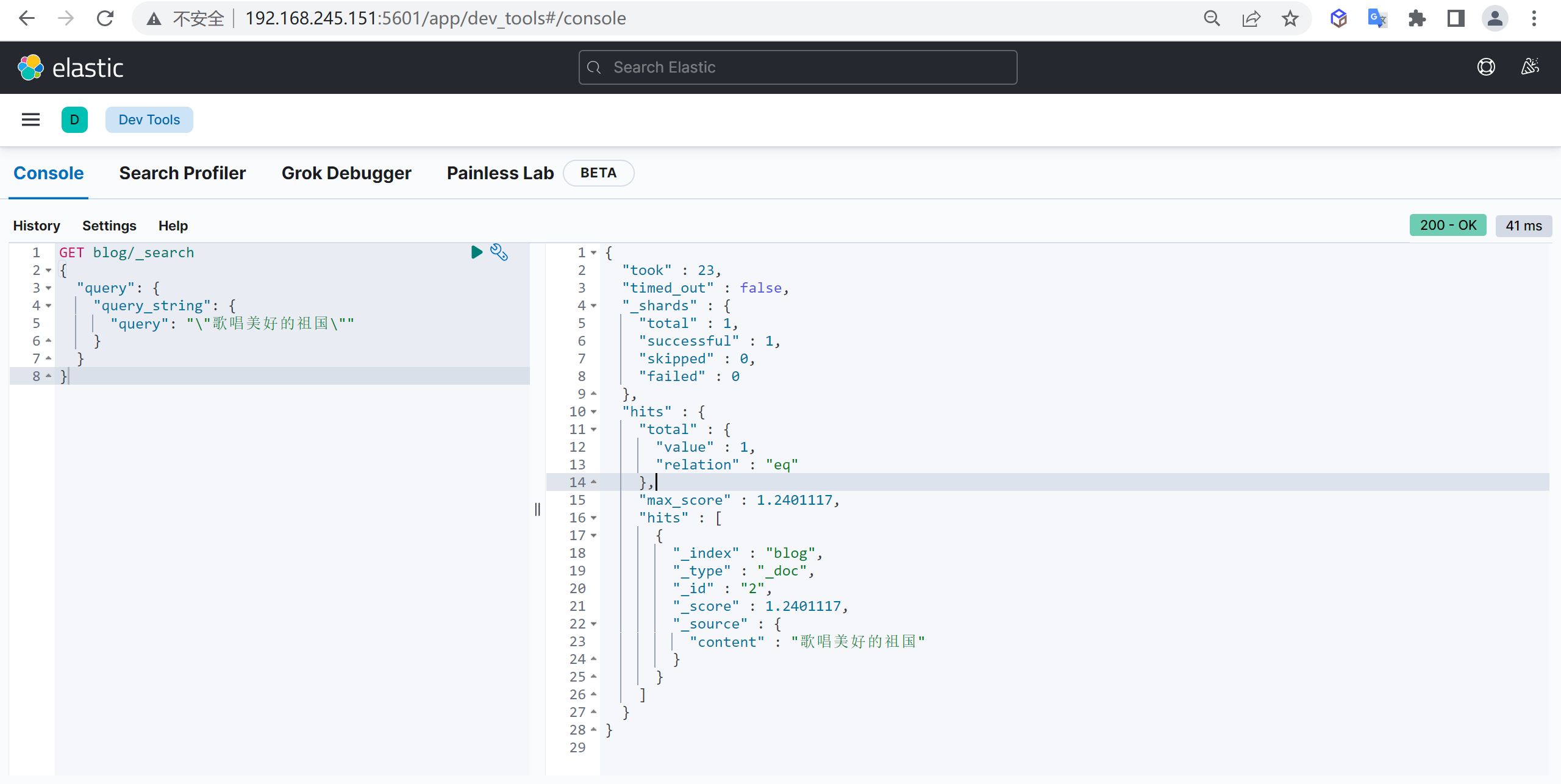

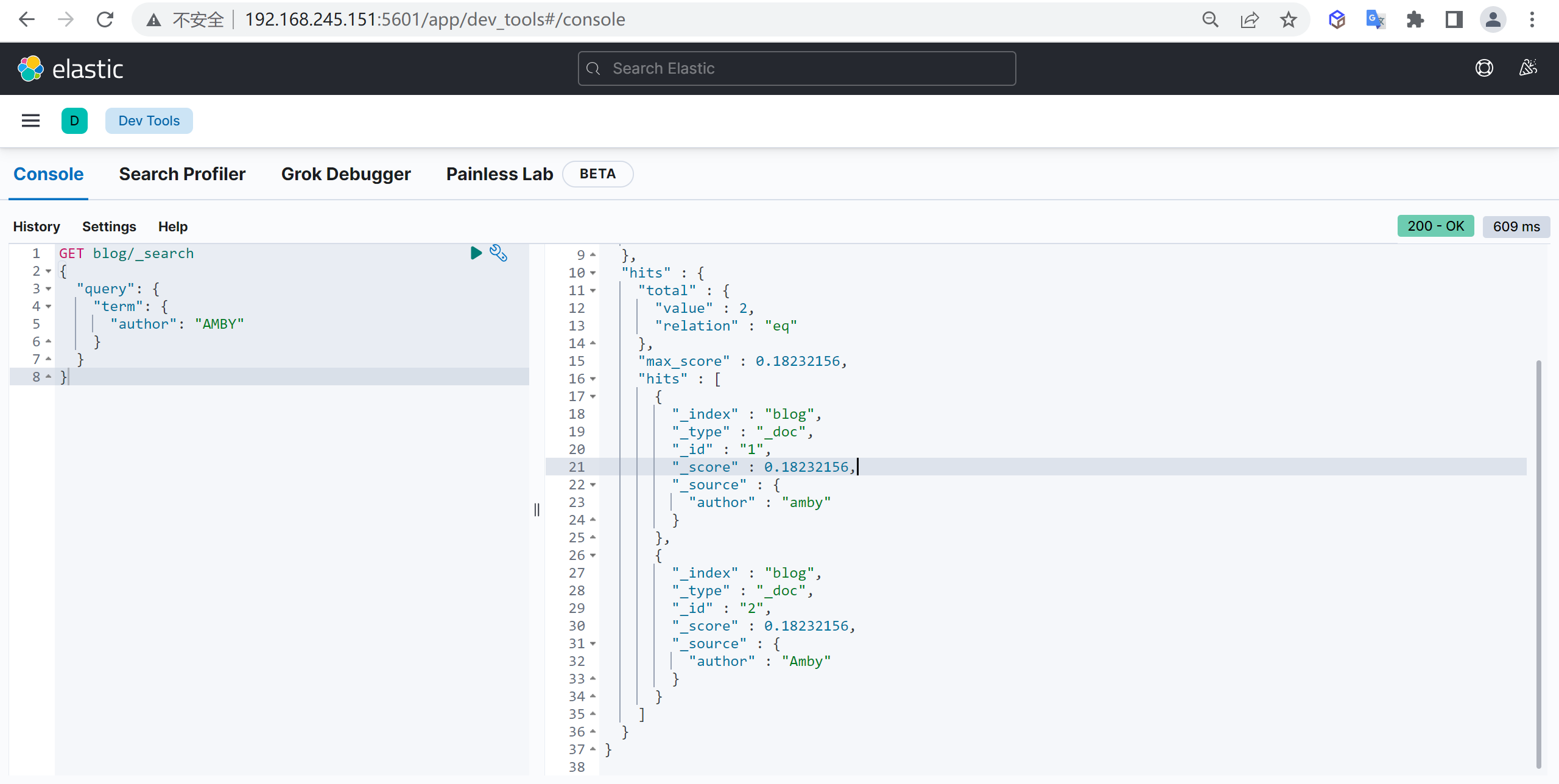

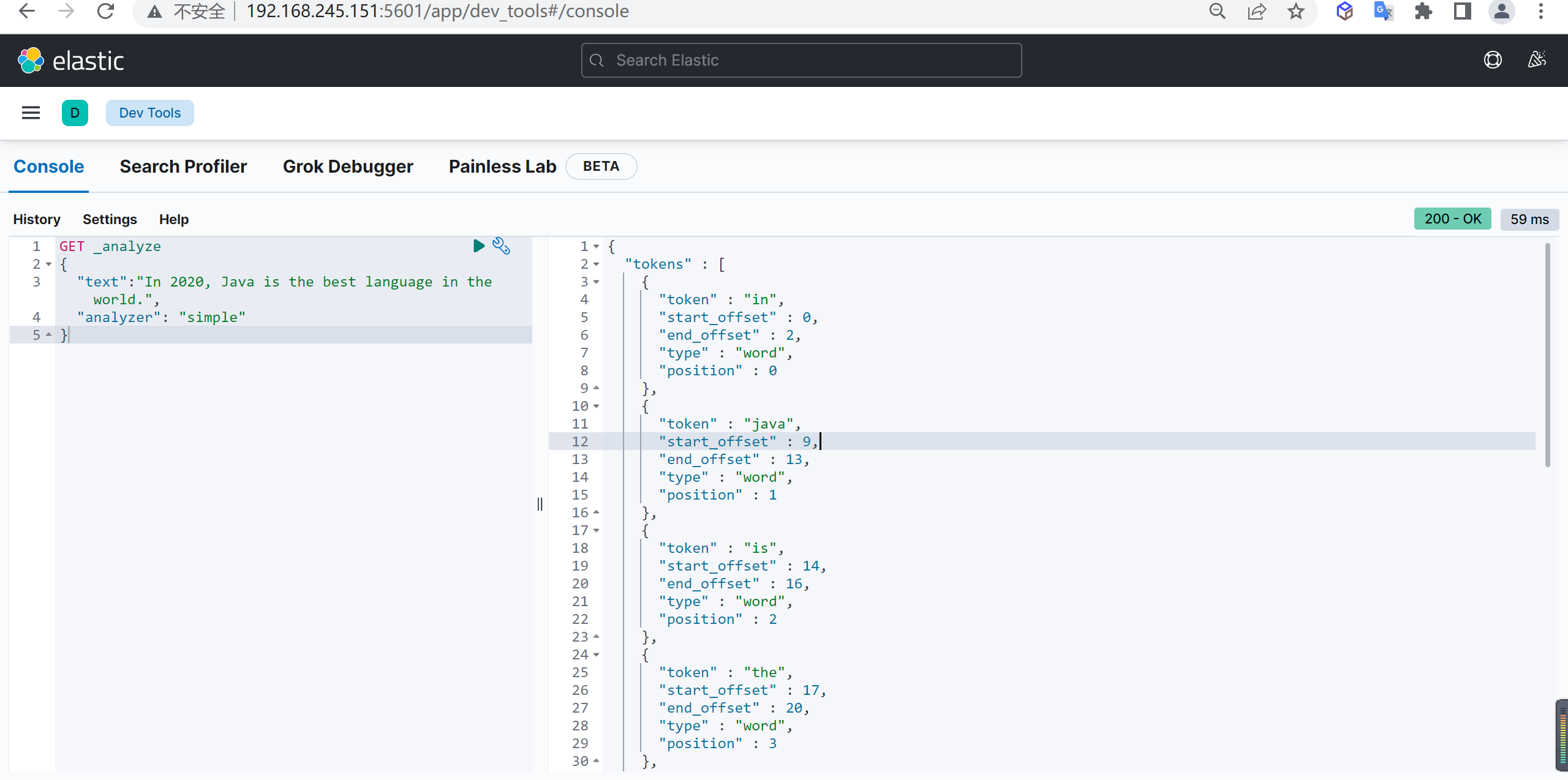

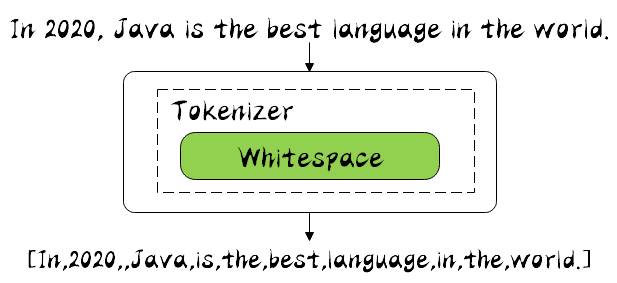

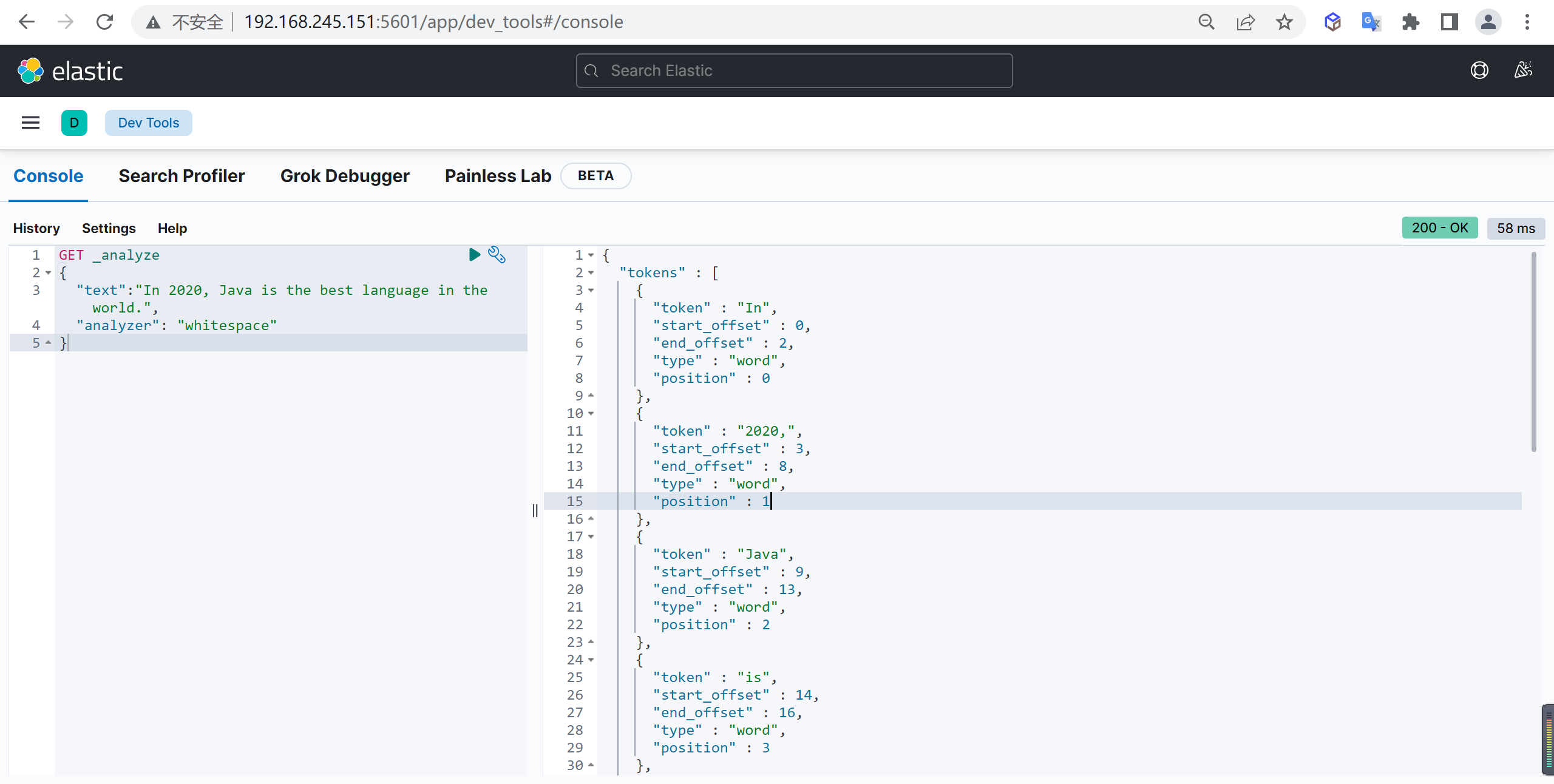

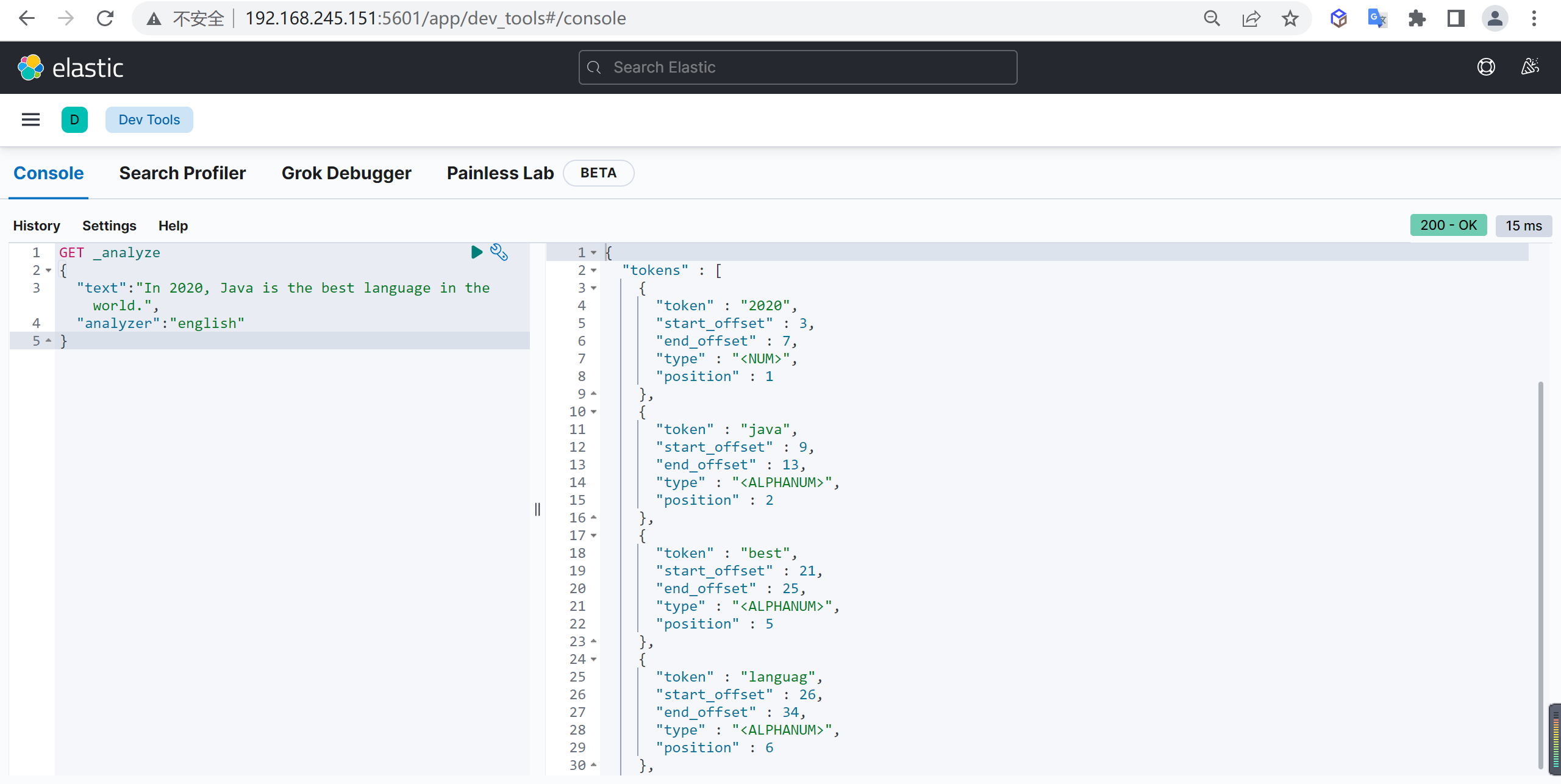

使用IK分词器

IK提供了两个分词算法:

- ik_smart:最少切分。

- ik_max_word:最细粒度划分。

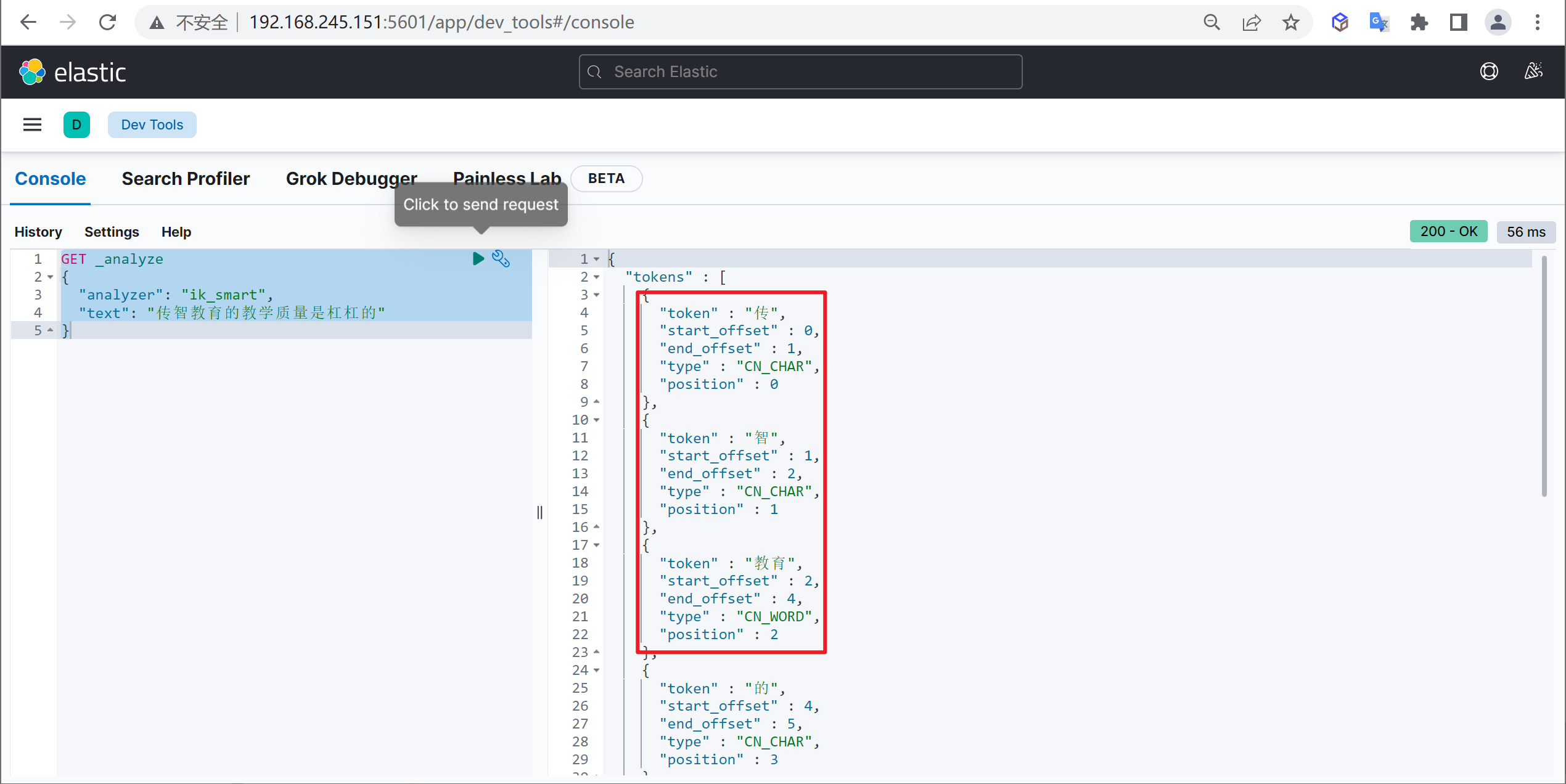

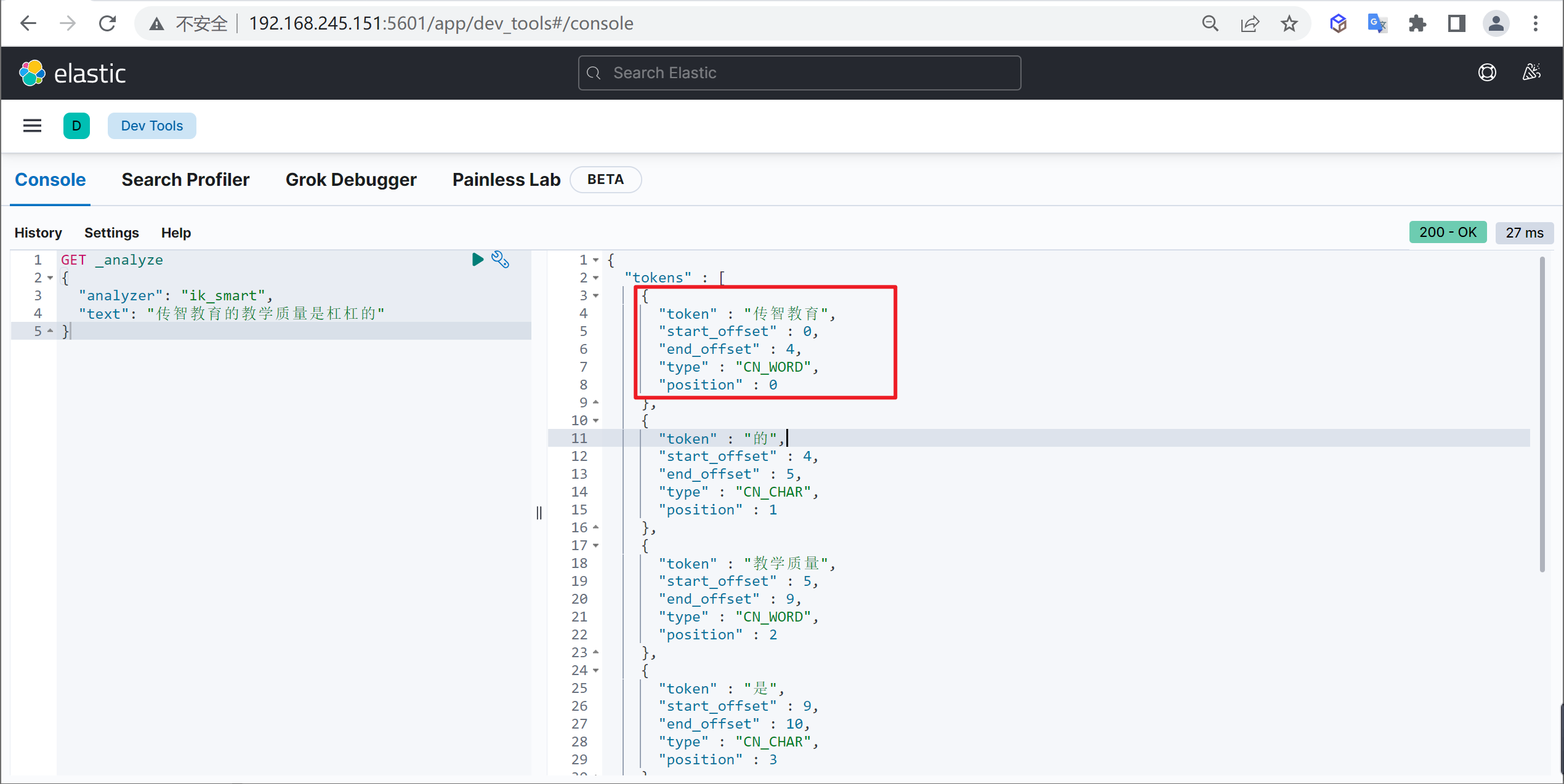

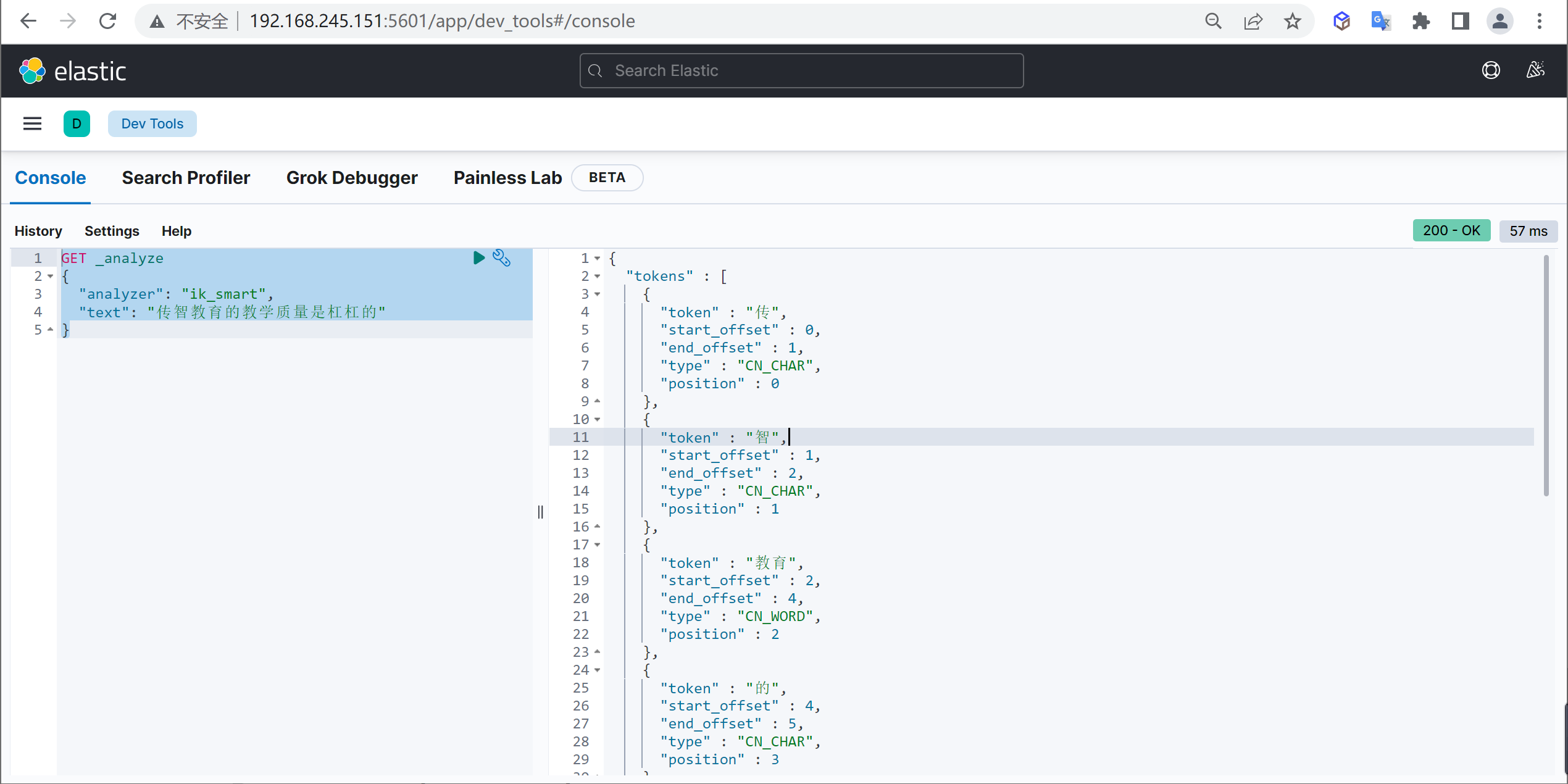

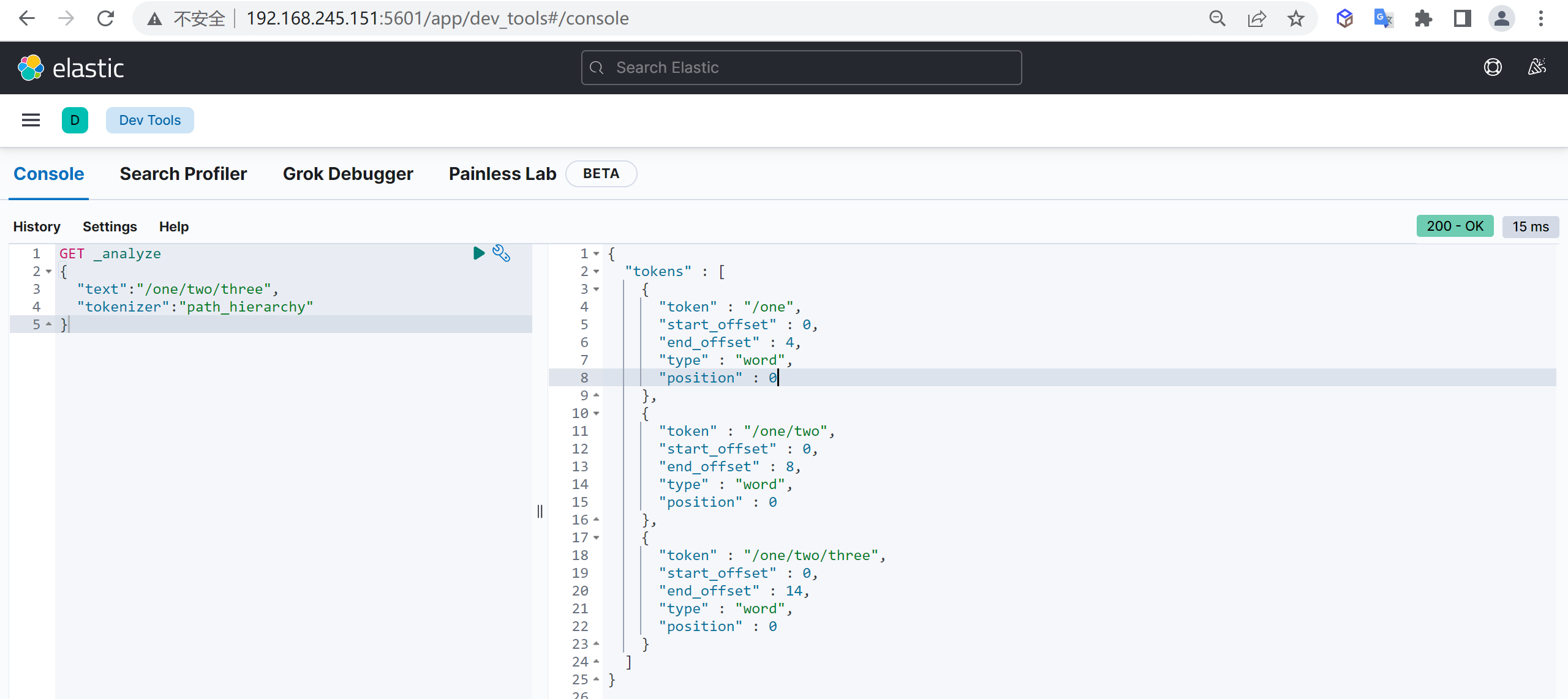

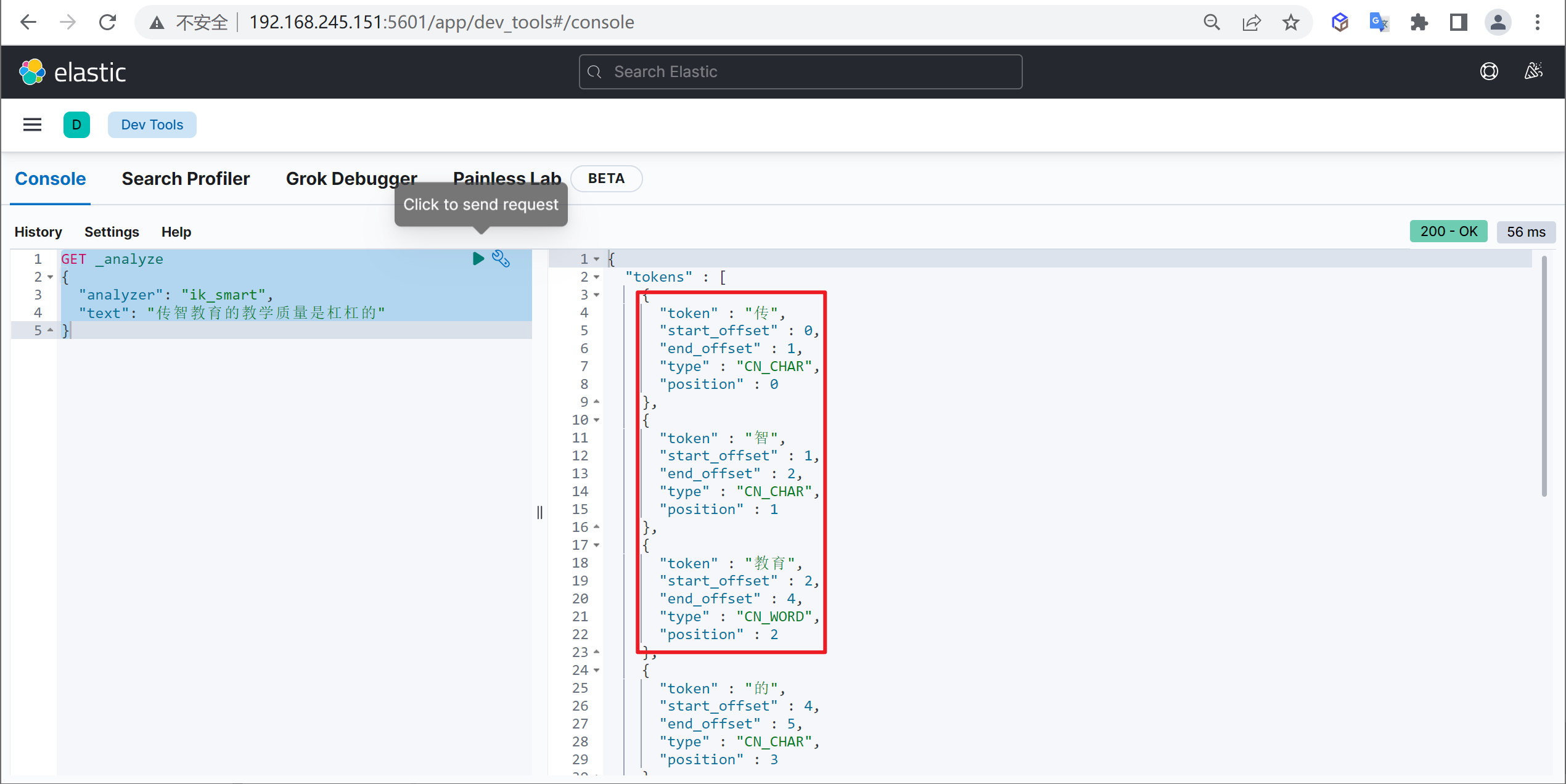

ik_smart

使用案例

原始内容

传智教育的教学质量是杠杠的测试分词

GET _analyze

{

"analyzer": "ik_smart",

"text": "传智教育的教学质量是杠杠的"

}

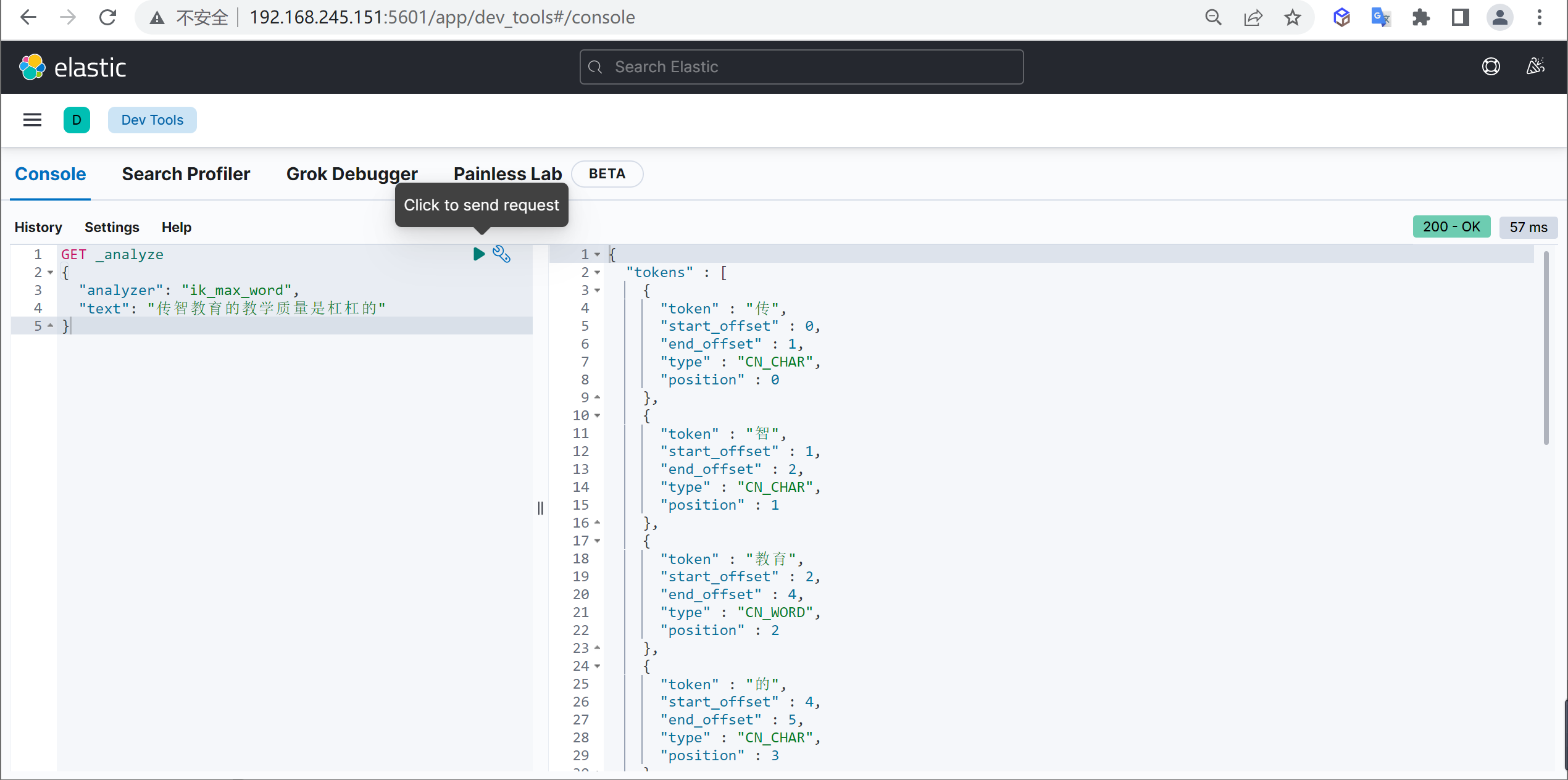

ik_max_word

使用案例

原始内容

传智教育的教学质量是杠杠的测试分词

GET _analyze

{

"analyzer": "ik_max_word",

"text": "传智教育的教学质量是杠杠的"

}

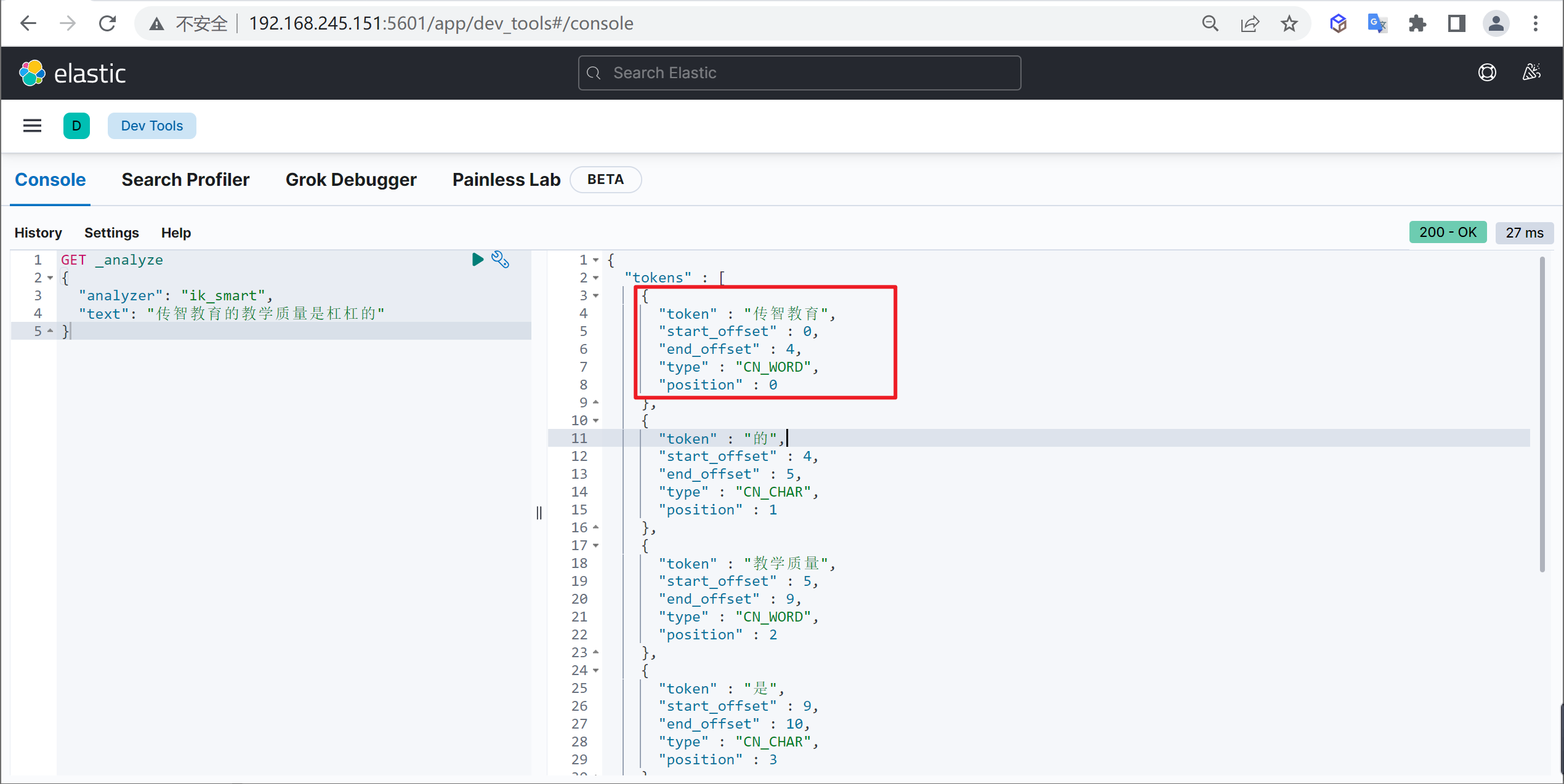

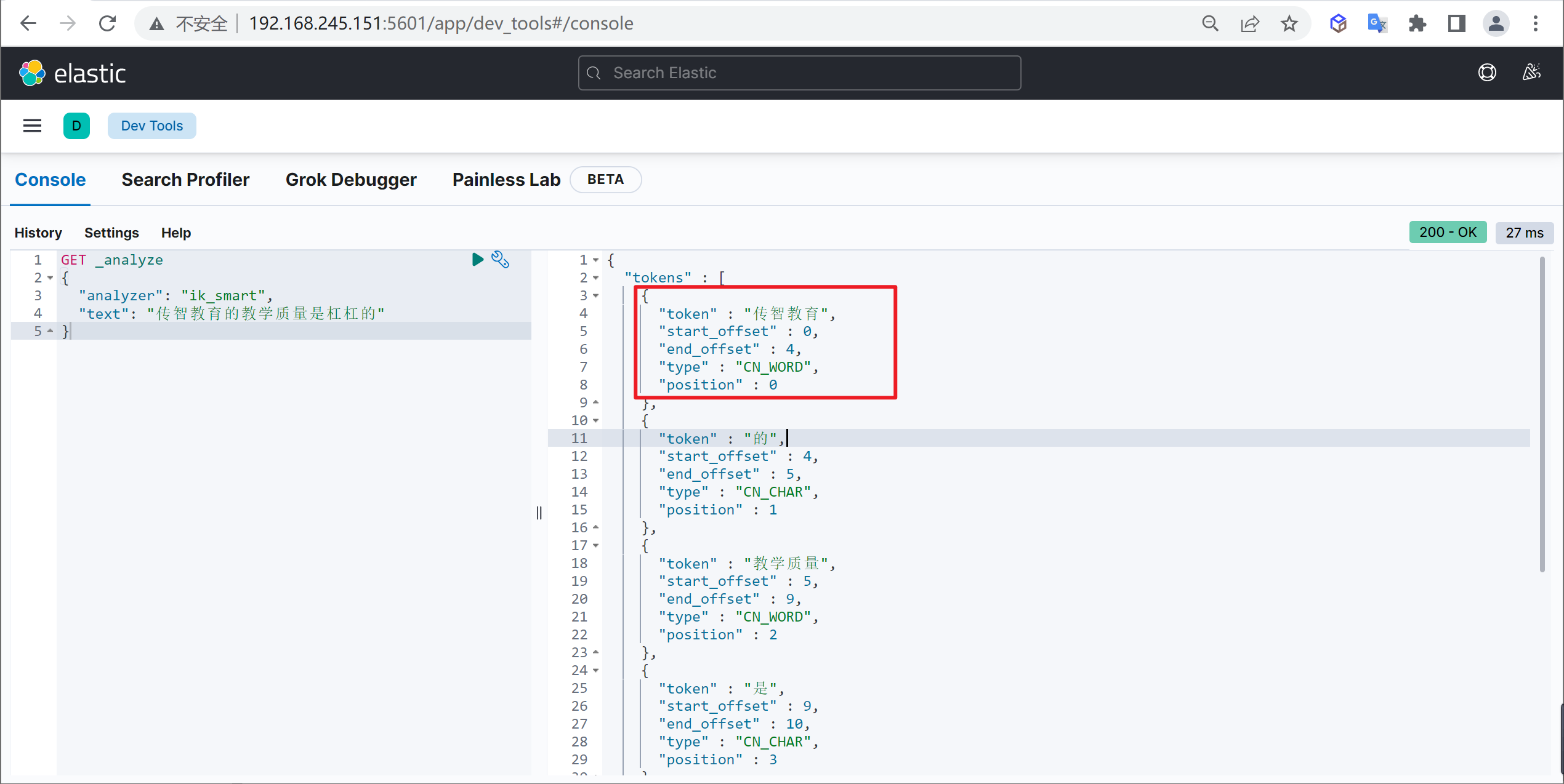

自定义词库

我们在使用IK分词器时会发现其实有时候分词的效果也并不是我们所期待的

问题描述

例如我们输入“传智教育的教学质量是杠杠的”,但是分词器会把“传智教育”进行拆开,分为了“传”,“智”,“教育”,但我们希望的是“传智教育”可以不被拆开。

解决方案

对于以上的问题,我们只需要将自己要保留的词,加到我们的分词器的字典中即可

编辑字典内容

进入elasticsearch目录

plugins/ik/config中,创建我们自己的字典文件yixin.dic,并添加内容:

cd plugins/ik/config

echo "传智教育" > custom.dic

扩展字典

进入我们的elasticsearch目录 :

plugins/ik/config,打开IKAnalyzer.cfg.xml文件,进行如下配置:

vi IKAnalyzer.cfg.xml

#增加如下内容

<entry key="ext_dict">custom.dic</entry>再次测试

重启ElasticSearch,再次使用kibana测试

GET _analyze

{

"analyzer": "ik_max_word",

"text": "传智教育的教学质量是杠杠的"

}可以发现,现在我们的词汇”传智教育”就不会被拆开了,达到我们想要的效果了

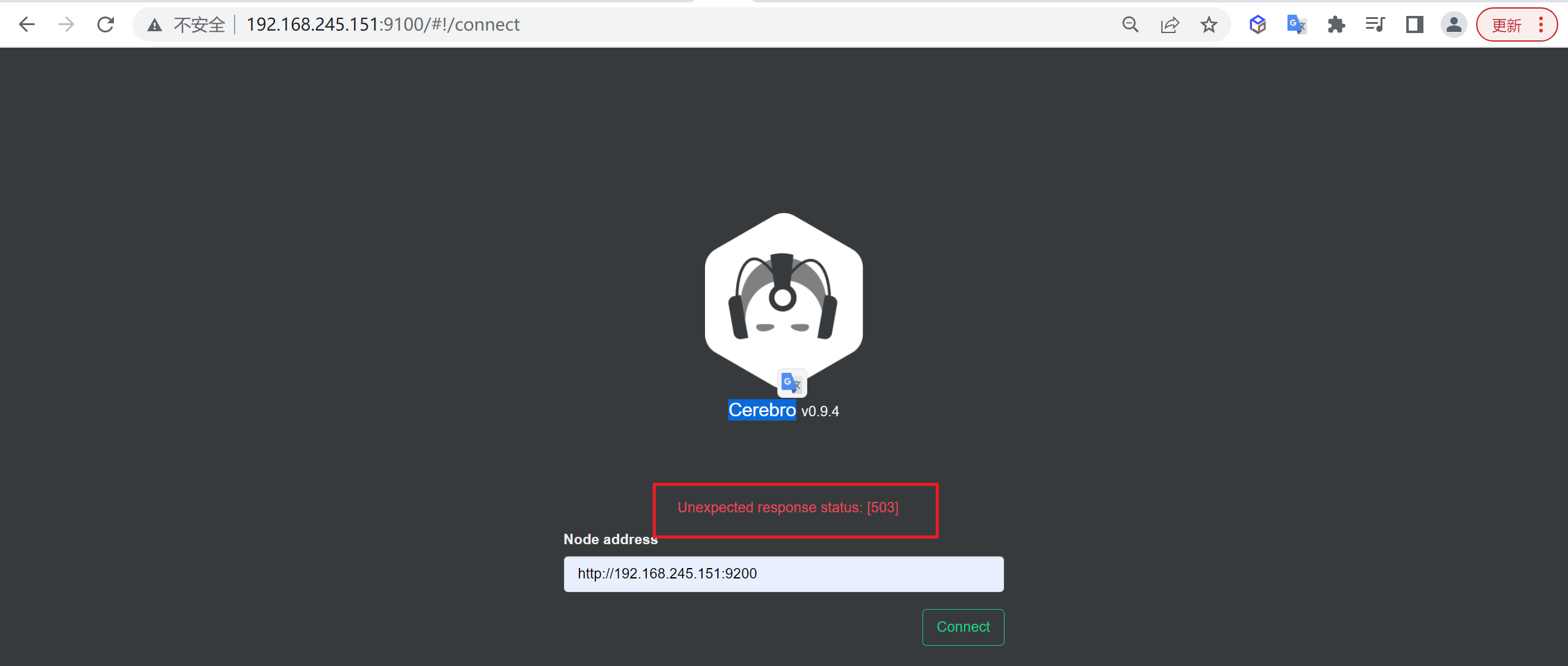

ElasticSearch 集群部署

概述

我们将ES的服务部署和同步服务部署分为两套,因为后期我们数据同步完成可以将异构数据同步的服务停止掉

服务布局

我们整体采用Docker方式进行布局,以下是我们需要部署的服务

| 服务名称 | 服务名称 | 开放端口 | 内存限制 |

|---|---|---|---|

| ES-node1 | node-1 | 9200 | 1G |

| ES-node2 | node-2 | 9201 | 1G |

| ES-node3 | node-3 | 9202 | 1G |

| ES-cerebro | cerebro | 9100 | 不限 |

| kibana | kibana | 5601 | 不限 |

准备工作

创建挂载目录

#创建配置目录

mkdir -p /tmp/etc/elasticsearch/node-{1..3}/{config,plugins}

# 创建kibana的配置目录

mkdir -p /tmp/data/kibana/config

# 创建数据目录

mkdir -p /tmp/data/elasticsearch/node-{1..3}/{data,log}目录授权

chmod 777 /tmp/etc/elasticsearch/node-{1..3}/{config,plugins}

chmod 777 /tmp/etc/kibana/config

chmod 777 /tmp/data/elasticsearch/node-{1..3}/{data,log}修改Linux句柄数

查看当前最大句柄数

sysctl -a | grep vm.max_map_count修改句柄数

vi /etc/sysctl.conf

+ vm.max_map_count=262144生效配置

修改后需要重启才能生效,不想重启可以设置临时生效

sysctl -w vm.max_map_count=262144修改句柄数和最大线程数

配置修改

修改后需要重新登录生效

vi /etc/security/limits.conf

# 添加以下内容

* soft nofile 65536

* hard nofile 65536

* soft nproc 4096

* hard nproc 4096重启服务

reboot添加IK分词器

因为后面要用到IK分词,所以我们要安装以下IK分词器

查找

在github中下载对应版本的分词器

https://github.com/medcl/elasticsearch-analysis-ik/releases根据自己的ES版本选择相应版本的IK分词器,因为安装的ES是

7.17.5,所以也下载相应的IK分词器

解压

将下载的分词器复制到ES安装目录的

plugins目录中并进行解压

mkdir ik && cd ik

unzip elasticsearch-analysis-ik-7.17.5.zip安装

cp -R ik/ /tmp/etc/elasticsearch/node-1/plugins/

cp -R ik/ /tmp/etc/elasticsearch/node-2/plugins/

cp -R ik/ /tmp/etc/elasticsearch/node-3/plugins/编写配置文件

node-1

vi /tmp/data/elasticsearch/node-1/config/elasticsearch.yml

#集群名称

cluster.name: elastic

#当前该节点的名称

node.name: node-1

#是不是有资格竞选主节点

node.master: true

#是否存储数据

node.data: true

#最大集群节点数

node.max_local_storage_nodes: 3

#给当前节点自定义属性(可以省略)

#node.attr.rack: r1

#数据存档位置

path.data: /usr/share/elasticsearch/data

#日志存放位置

path.logs: /usr/share/elasticsearch/log

#是否开启时锁定内存(默认为是)

#bootstrap.memory_lock: true

#设置网关地址,我是被这个坑死了,这个地址我原先填写了自己的实际物理IP地址,

#然后启动一直报无效的IP地址,无法注入9300端口,这里只需要填写0.0.0.0

network.host: 0.0.0.0

#设置映射端口

http.port: 9200

#内部节点之间沟通端口

transport.tcp.port: 9300

#集群发现默认值为127.0.0.1:9300,如果要在其他主机上形成包含节点的群集,如果搭建集群则需要填写

#es7.x 之后新增的配置,写入候选主节点的设备地址,在开启服务后可以被选为主节点,也就是说把所有的节点都写上

discovery.seed_hosts: ["node-1","node-2","node-3"]

#当你在搭建集群的时候,选出合格的节点集群,有些人说的太官方了,

#其实就是,让你选择比较好的几个节点,在你节点启动时,在这些节点中选一个做领导者,

#如果你不设置呢,elasticsearch就会自己选举,这里我们把三个节点都写上

cluster.initial_master_nodes: ["node-1","node-2","node-3"]

#在群集完全重新启动后阻止初始恢复,直到启动N个节点

#简单点说在集群启动后,至少复活多少个节点以上,那么这个服务才可以被使用,否则不可以被使用,

gateway.recover_after_nodes: 2

#删除索引是是否需要显示其名称,默认为显示

#action.destructive_requires_name: true

# 禁用安全配置,否则查询的时候会提示警告

xpack.security.enabled: falsenode-2

vi /tmp/data/elasticsearch/node-2/config/elasticsearch.yml

#集群名称

cluster.name: elastic

#当前该节点的名称

node.name: node-2

#是不是有资格竞选主节点

node.master: true

#是否存储数据

node.data: true

#最大集群节点数

node.max_local_storage_nodes: 3

#给当前节点自定义属性(可以省略)

#node.attr.rack: r1

#数据存档位置

path.data: /usr/share/elasticsearch/data

#日志存放位置

path.logs: /usr/share/elasticsearch/log

#是否开启时锁定内存(默认为是)

#bootstrap.memory_lock: true

#设置网关地址,我是被这个坑死了,这个地址我原先填写了自己的实际物理IP地址,

#然后启动一直报无效的IP地址,无法注入9300端口,这里只需要填写0.0.0.0

network.host: 0.0.0.0

#设置映射端口

http.port: 9200

#内部节点之间沟通端口

transport.tcp.port: 9300

#集群发现默认值为127.0.0.1:9300,如果要在其他主机上形成包含节点的群集,如果搭建集群则需要填写

#es7.x 之后新增的配置,写入候选主节点的设备地址,在开启服务后可以被选为主节点,也就是说把所有的节点都写上

discovery.seed_hosts: ["node-1","node-2","node-3"]

#当你在搭建集群的时候,选出合格的节点集群,有些人说的太官方了,

#其实就是,让你选择比较好的几个节点,在你节点启动时,在这些节点中选一个做领导者,

#如果你不设置呢,elasticsearch就会自己选举,这里我们把三个节点都写上

cluster.initial_master_nodes: ["node-1","node-2","node-3"]

#在群集完全重新启动后阻止初始恢复,直到启动N个节点

#简单点说在集群启动后,至少复活多少个节点以上,那么这个服务才可以被使用,否则不可以被使用,

gateway.recover_after_nodes: 2

#删除索引是是否需要显示其名称,默认为显示

#action.destructive_requires_name: true

# 禁用安全配置,否则查询的时候会提示警告

xpack.security.enabled: falsenode-3

vi /tmp/data/elasticsearch/node-3/config/elasticsearch.yml

#集群名称

cluster.name: elastic

#当前该节点的名称

node.name: node-3

#是不是有资格竞选主节点

node.master: true

#是否存储数据

node.data: true

#最大集群节点数

node.max_local_storage_nodes: 3

#给当前节点自定义属性(可以省略)

#node.attr.rack: r1

#数据存档位置

path.data: /usr/share/elasticsearch/data

#日志存放位置

path.logs: /usr/share/elasticsearch/log

#是否开启时锁定内存(默认为是)

#bootstrap.memory_lock: true

#设置网关地址,我是被这个坑死了,这个地址我原先填写了自己的实际物理IP地址,

#然后启动一直报无效的IP地址,无法注入9300端口,这里只需要填写0.0.0.0

network.host: 0.0.0.0

#设置映射端口

http.port: 9200

#内部节点之间沟通端口

transport.tcp.port: 9300

#集群发现默认值为127.0.0.1:9300,如果要在其他主机上形成包含节点的群集,如果搭建集群则需要填写

#es7.x 之后新增的配置,写入候选主节点的设备地址,在开启服务后可以被选为主节点,也就是说把所有的节点都写上

discovery.seed_hosts: ["node-1","node-2","node-3"]

#当你在搭建集群的时候,选出合格的节点集群,有些人说的太官方了,

#其实就是,让你选择比较好的几个节点,在你节点启动时,在这些节点中选一个做领导者,

#如果你不设置呢,elasticsearch就会自己选举,这里我们把三个节点都写上

cluster.initial_master_nodes: ["node-1","node-2","node-3"]

#在群集完全重新启动后阻止初始恢复,直到启动N个节点

#简单点说在集群启动后,至少复活多少个节点以上,那么这个服务才可以被使用,否则不可以被使用,

gateway.recover_after_nodes: 2

#删除索引是是否需要显示其名称,默认为显示

#action.destructive_requires_name: true

# 禁用安全配置,否则查询的时候会提示警告

xpack.security.enabled: falsekibana

vi /tmp/data/kibana/config/kibana.yml

server.host: 0.0.0.0

# 监听端口

server.port: 5601

server.name: "kibana"

# kibana访问es服务器的URL,就可以有多个,以逗号","隔开

elasticsearch.hosts: ["http://node-1:9200","http://node-2:9201","http://node-3:9202"]

monitoring.ui.container.elasticsearch.enabled: true

# kibana访问Elasticsearch的账号与密码(如果ElasticSearch设置了的话)

elasticsearch.username: "kibana"

elasticsearch.password: "12345"

# kibana日志文件存储路径

logging.dest: stdout

# 此值为true时,禁止所有日志记录输出

logging.silent: false

# 此值为true时,禁止除错误消息之外的所有日志记录输出

logging.quiet: false

# 此值为true时,记录所有事件,包括系统使用信息和所有请求

logging.verbose: false

ops.interval: 5000

# kibana web语言

i18n.locale: "zh-CN"编写部署文档

vi docker-compose.yml

version: "3"

services:

node-1:

image: elasticsearch:7.17.5

container_name: node-1

environment:

- "ES_JAVA_OPTS=-Xms1024m -Xmx1024m"

- "TZ=Asia/Shanghai"

ulimits:

memlock:

soft: -1

hard: -1

nofile:

soft: 65536

hard: 65536

ports:

- "9200:9200"

logging:

driver: "json-file"

options:

max-size: "50m"

volumes:

- /tmp/etc/elasticsearch/node-1/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml

- /tmp/etc/elasticsearch/node-1/plugins:/usr/share/elasticsearch/plugins

- /tmp/data/elasticsearch/node-1/data:/usr/share/elasticsearch/data

- /tmp/data/elasticsearch/node-1/log:/usr/share/elasticsearch/log

networks:

- elastic

node-2:

image: elasticsearch:7.17.5

container_name: node-2

environment:

- "ES_JAVA_OPTS=-Xms1024m -Xmx1024m"

- "TZ=Asia/Shanghai"

ulimits:

memlock:

soft: -1

hard: -1

nofile:

soft: 65536

hard: 65536

ports:

- "9201:9200"

logging:

driver: "json-file"

options:

max-size: "50m"

volumes:

- /tmp/etc/elasticsearch/node-2/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml

- /tmp/etc/elasticsearch/node-2/plugins:/usr/share/elasticsearch/plugins

- /tmp/data/elasticsearch/node-2/data:/usr/share/elasticsearch/data

- /tmp/data/elasticsearch/node-2/log:/usr/share/elasticsearch/log

networks:

- elastic

node-3:

image: elasticsearch:7.17.5

container_name: node-3

environment:

- "ES_JAVA_OPTS=-Xms1024m -Xmx1024m"

- "TZ=Asia/Shanghai"

ulimits:

memlock:

soft: -1

hard: -1

nofile:

soft: 65536

hard: 65536

ports:

- "9202:9200"

logging:

driver: "json-file"

options:

max-size: "50m"

volumes:

- /tmp/etc/elasticsearch/node-3/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml

- /tmp/etc/elasticsearch/node-3/plugins:/usr/share/elasticsearch/plugins

- /tmp/data/elasticsearch/node-3/data:/usr/share/elasticsearch/data

- /tmp/data/elasticsearch/node-3/log:/usr/share/elasticsearch/log

networks:

- elastic

kibana:

container_name: kibana

image: kibana:7.17.5

volumes:

- /tmp/data/kibana/config/kibana.yml:/usr/share/kibana/config/kibana.yml

ports:

- 5601:5601

networks:

- elastic

elasticsearch-head:

image: wallbase/elasticsearch-head:6-alpine

container_name: elasticsearch-head

environment:

TZ: 'Asia/Shanghai'

ports:

- '9100:9100'

networks:

- elastic

networks:

elastic:

driver: bridge启动服务

使用以下命令就可以启动服务了

docker-compose up -dELK异构数据同步

概述

什么是ELK

ELK是三个开源软件的缩写,分别表示:Elasticsearch , Logstash, Kibana , 它们都是开源软件

- Elasticsearch是强大的数据搜索引擎,并且是分布式、能够通过restful方式进行交互的近实时搜索平台框架

- Logstash是免费且开源的服务器端数据处理通道,能够从多个来源收集数据,能够对数据进行转换和清洗,将转换数据后将数据发送到数据存储库中,并且不受格式和复杂度的影响。

- Kibana是针对Elasticsearch的开源分析及可视化平台,用于搜索、查看交互存储在Elasticsearch索引中的数据。

ELK能做什么

日志收集

一般我们需要进行日志分析场景:直接在日志文件中 grep、awk 就可以获得自己想要的信息

但在规模较大的场景中,此方法效率低下,面临问题包括日志量太大如何归档、文本搜索太慢怎么办、如何多维度查询,需要集中化的日志管理,所有服务器上的日志收集汇总,常见解决思路是建立集中式日志收集系统,将所有节点上的日志统一收集,管理,访问。

一般大型系统是一个分布式部署的架构,不同的服务模块部署在不同的服务器上,问题出现时,大部分情况需要根据问题暴露的关键信息,定位到具体的服务器和服务模块,构建一套集中式日志系统,可以提高定位问题的效率。

一个完整的集中式日志系统,需要包含以下几个主要特点:

- 收集-能够采集多种来源的日志数据

- 传输-能够稳定的把日志数据传输到中央系统

- 存储-如何存储日志数据

- 分析-可以支持 UI 分析

- 警告-能够提供错误报告,监控机制

ELK提供了一整套解决方案,并且都是开源软件,之间互相配合使用,完美衔接,高效的满足了很多场合的应用,是目前主流的一种日志分析平台。

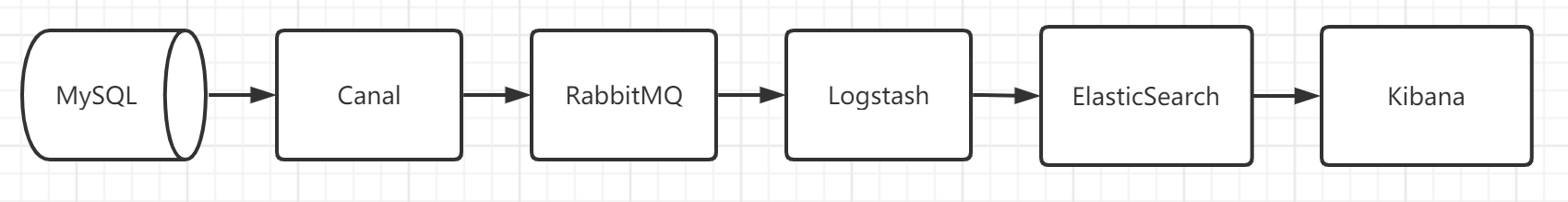

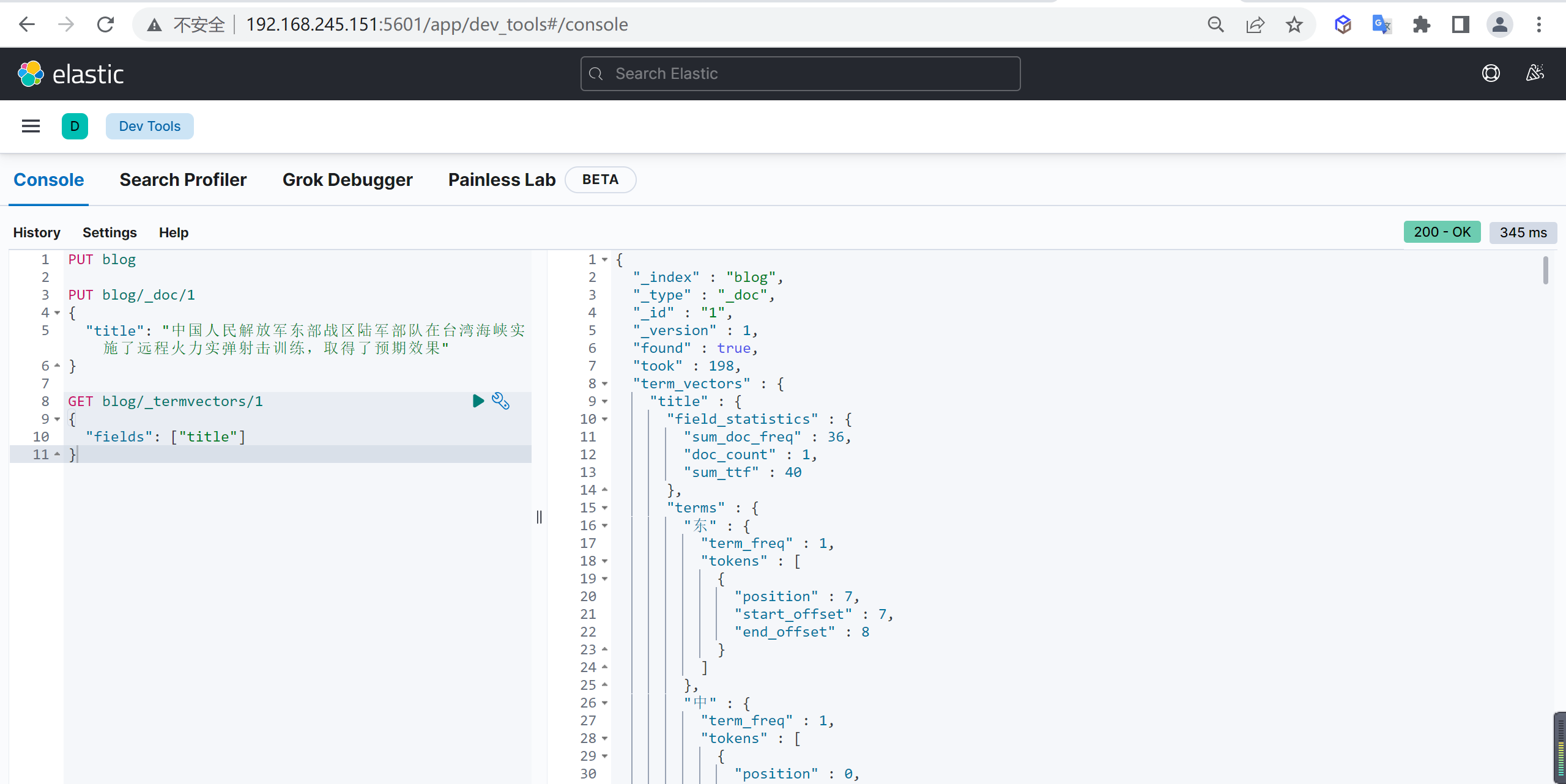

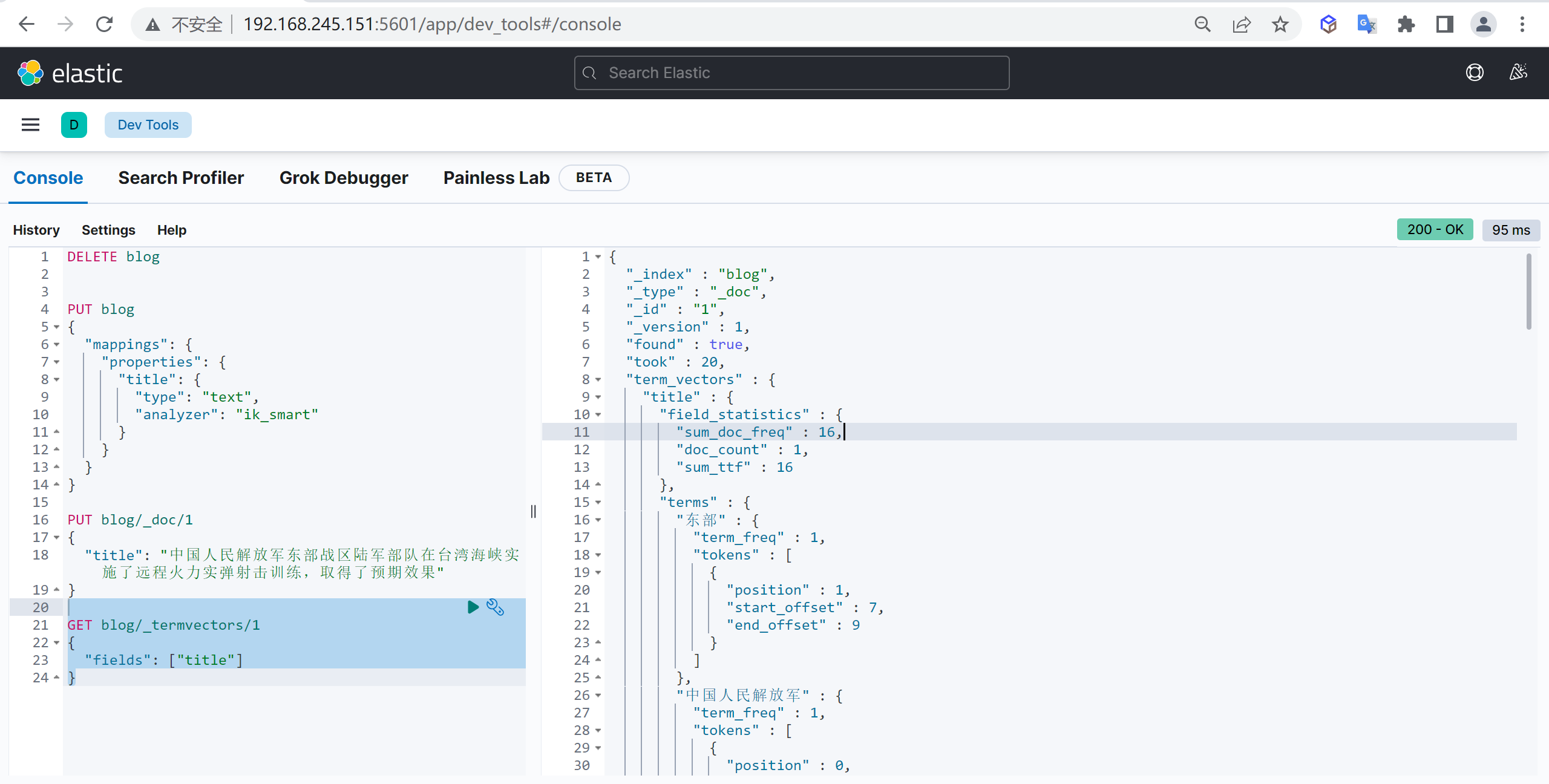

异构数据同步

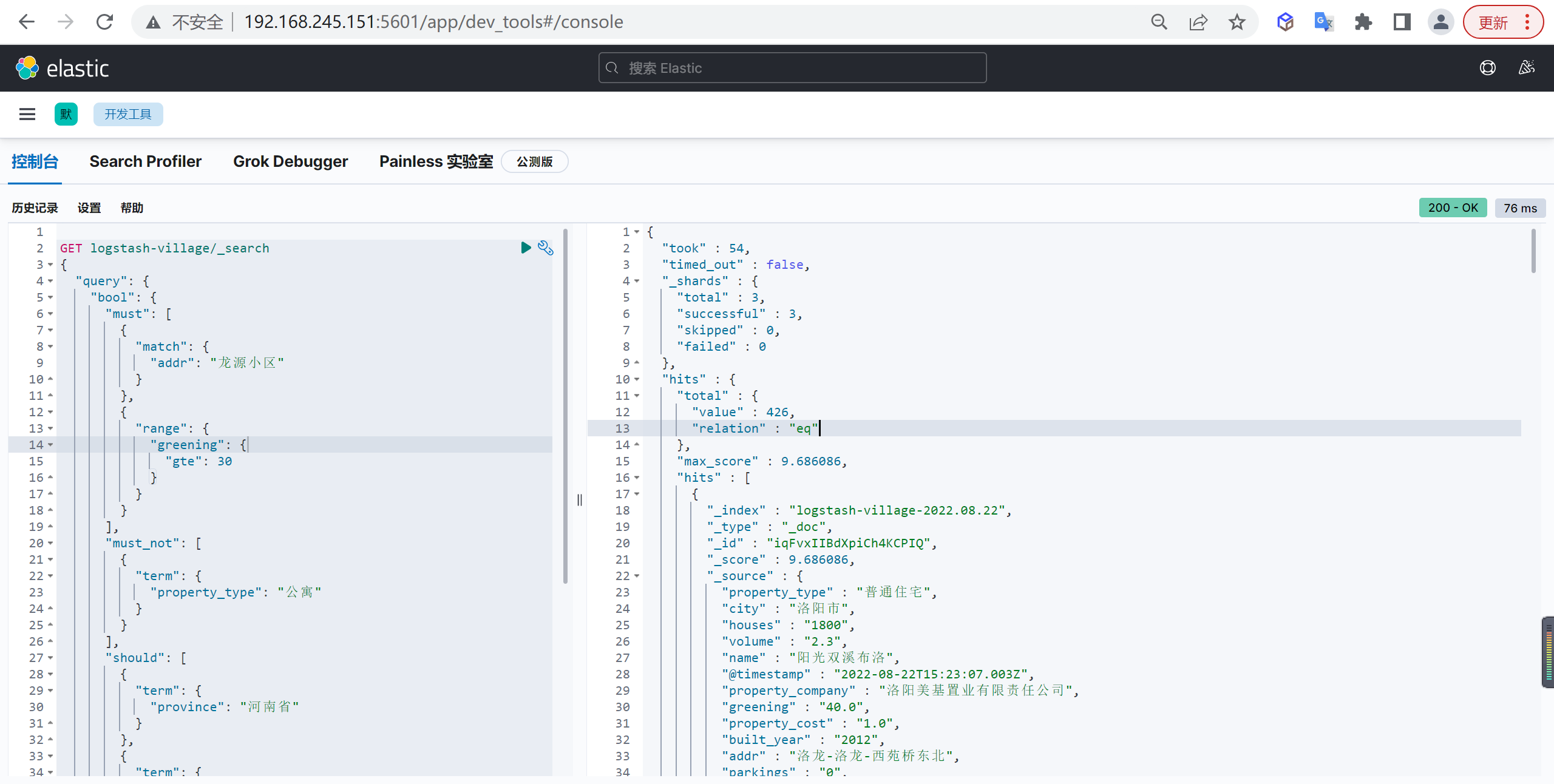

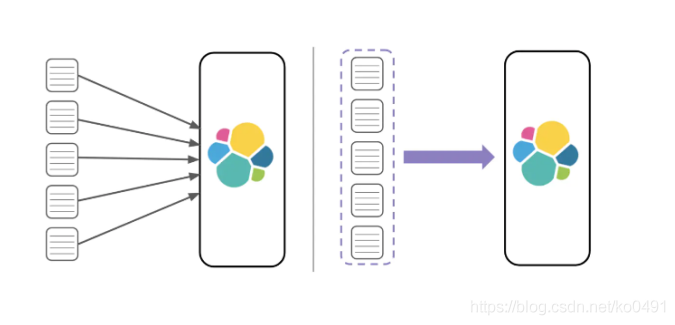

我们可以借助ELK来帮助我们将数据库中的数据同步到ES中

我们要将MySQL中的数据同步到ES中可能比较麻烦,但是我们借助ELK+Canal可以很轻易的就可以实现,我们现在要做一个全国小区房产的全文检索系统,但是使用MySQL进行全文检索会很麻烦,我们要使用ElasticSearch进行全文检索,就要涉及到异构数据的同步。

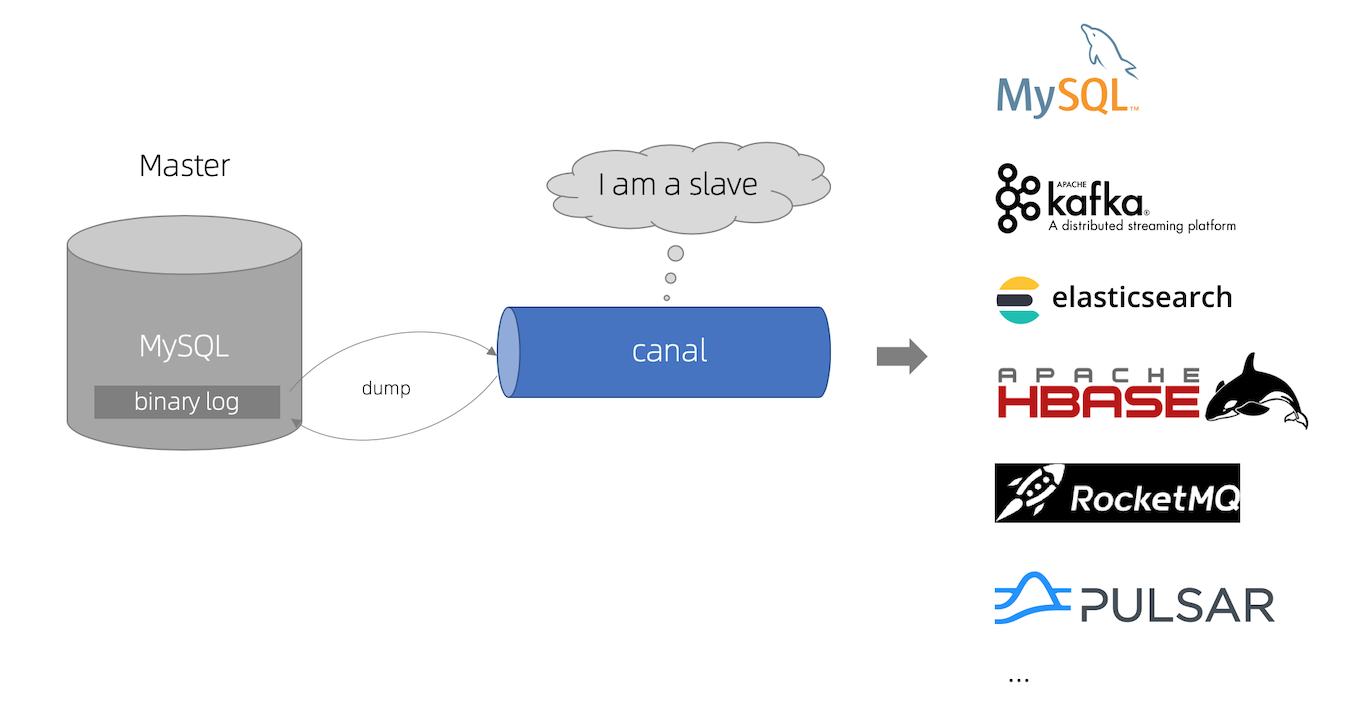

下面是我们的整体架构图

常用组件介绍

我们实现异构数据同步平台涉及到一下的组件

MySQL服务

MySQL是我们的主数据库,所有的操作都会写入到MySQL数据库,这个是我们的主要的数据库,因为MySQL不适合于全文检索,所以我们需要将数据同步的ES中,通过ES来进行全文检索

Canal

canal是用java开发的基于数据库增量日志解析,提供增量数据订阅&消费的中间件。

目前,canal主要支持了MySQL的binlog解析,解析完成后才利用canal client 用来处理获得的相关数据。(数据库同步需要阿里的otter中间件,基于canal)

我们这里使用Canal同步来将我们的MySQL的数据同步到ES中

canal 原理

canal的工作原理就是把自己伪装成MySQL slave,模拟MySQL slave的交互协议向MySQL Mater发送 dump协议,MySQL mater收到canal发送过来的dump请求,开始推送binary log给canal,然后canal解析binary log,再发送到存储目的地,比如MySQL,Kafka,Elastic Search等等。

RabbitMQ

RabbitMQ是实现了高级消息队列协议(AMQP)的开源消息代理软件(亦称面向消息的中间件)

我们这里使用RabbitMQ来进行消息的削峰填谷,因为全国的房产数据的操作会很频繁,数据量很大的情况下我们需要使用MQ来进行缓冲数据,这样可以进行大量数据的快速同步

Logstash

Logstash是具有实时流水线能力的开源的数据收集引擎

Logstash可以动态统一不同来源的数据,并将数据标准化到您选择的目标输出,它提供了大量插件,可帮助我们解析,丰富,转换和缓冲任何类型的数据。

我们需要使用logstash对RabbitMQ过来的数据进行解析以及清晰,并将清洗过的数据放进ES中

ElasticSearch

Elasticsearch 是一个分布式的开源搜索和分析引擎,在 Apache Lucene 的基础上开发而成。

我们使用ElasticSearch存储logstash清洗完成的数据,通过ES可以对数据进行全文检索,Elasticsearch还是一个分布式文档数据库,其中每个字段均可被索引,而且每个字段的数据均可被搜索,ES能够横向扩展至数以百计的服务器存储以及处理PB级的数据,可以在极短的时间内存储、搜索和分析大量的数据

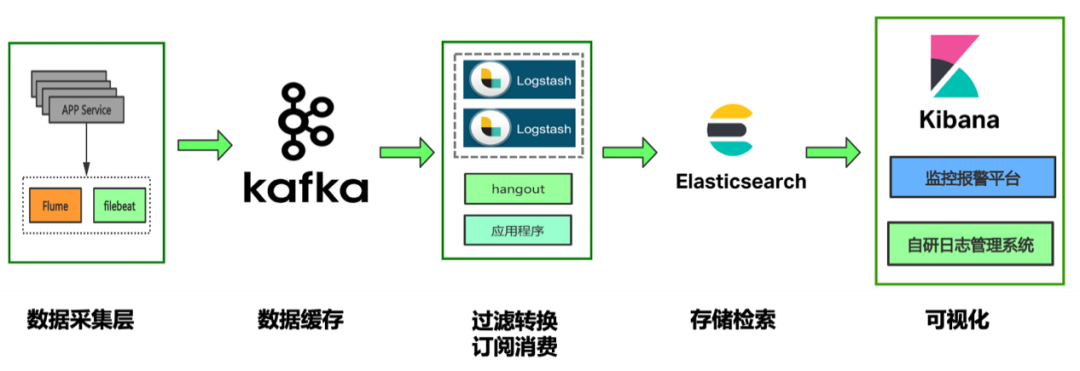

kibana

针对es的ES的开源分析可视化工具,与存储在ES的数据进行交互

Kibana是一个开源的分析与可视化平台,设计出来用于和Elasticsearch一起使用的,你可以用kibana搜索、查看存放在Elasticsearch中的数据,Kibana与Elasticsearch的交互方式是各种不同的图表、表格、地图等,直观的展示数据,从而达到高级的数据分析与可视化的目的。

ES物理部署

ES单机部署

下载 Elasticsearch

我们下载的Elasticsearch 版本是 7.17.5,下载地址

https://www.elastic.co/cn/downloads/past-releases/elasticsearch-7-17-5

wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-7.17.5-linux-x86_64.tar.gz

tar -zvxf elasticsearch-7.17.5-linux-x86_64.tar.gz配置 Elasticsearch

关闭防火墙

systemctl status firewalld.service

systemctl stop firewalld.service

systemctl disable firewalld.service配置elasticsearch.yml

该配置文件是ES的主配置文件

vi elasticsearch.yml

#设置允许访问地址,配置位0.0.0.0允许任意主机访问

- #network.host: 192.168.0.1

+ network.host: 0.0.0.0

# 配置集群

# node.name: node-1

+ node.name: node-1

- #discovery.seed_hosts: ["host1", "host2"]

discovery.seed_hosts: ["node-1"]

- #cluster.initial_master_nodes: ["node-1", "node-2"]

+ cluster.initial_master_nodes: ["node-1"]修改Linux句柄数

查看当前最大句柄数

sysctl -a | grep vm.max_map_count修改句柄数

vi /etc/sysctl.conf

+ vm.max_map_count=262144生效配置

修改后需要重启才能生效,不想重启可以设置临时生效

sysctl -w vm.max_map_count=262144关闭swap

因为ES的数据大量都是常驻内存的,一旦使用了虚拟内存就会导致查询速度下降,一般需要关闭swap,但是要保证有足够的内存

临时关闭

swapoff -a永久关闭

vi /etc/fstab注释掉

swap这一行的配置

修改最大线程数

因为ES运行期间可能创建大量线程,如果线程数支持较少可能报错

配置修改

修改后需要重新登录生效

vi /etc/security/limits.conf

# 添加以下内容

* soft nofile 65536

* hard nofile 65536

* soft nproc 4096

* hard nproc 4096重启服务

reboot创建ES用户

注意ES不能以 root 用户启动,否则会报错

添加用户

useradd elasticsearch

passwd elasticsearch增加管理员权限

增加sudoers权限

vi /etc/sudoers

+ elasticsearch ALL=(ALL) ALL修改Elasticsearch权限

给ES的安装目录进行授权

chown -R elasticsearch:elasticsearch elasticsearch-7.17.5JVM配置

根据自己的内存自行调整,内存不够则会启动失败

vi jvm.options

- ##-Xms4g

- ##-Xmx4g

+ -Xms4g

+ -Xmx4g添加IK分词器

因为后面要用到IK分词,所以我们要安装以下IK分词器

查找

在github中下载对应版本的分词器

https://github.com/medcl/elasticsearch-analysis-ik/releases根据自己的ES版本选择相应版本的IK分词器,因为安装的ES是

7.17.5,所以也下载相应的IK分词器

解压

将下载的分词器复制到ES安装目录的

plugins目录中并进行解压

mkdir ik && cd ik

unzip elasticsearch-analysis-ik-7.17.5.zip启动ElasticSearch

切换用户

切换到刚刚创建的

elasticsearch用户

su elasticsearch启动命令

我们可以使用以下命令来进行使用

# 前台启动

sh bin/elasticsearch

# 后台启动

sh bin/elasticsearch -d访问测试

访问对应宿主机的

9200端口

http://192.168.245.151:9200/重启ElasticSearch

查找进程

先查找ElasticSearch的进程号

ps -ef | grep elastic杀死进程

杀死对应的进程

kill -9 49736启动ElasticSearch

注意不要使用ROOT用户启动

sh bin/elasticsearch -dkibana安装

下载安装 Kibana

kibana 版本 7.17.5

下载地址:https://www.elastic.co/cn/downloads/past-releases/kibana-7-17-5

wget https://artifacts.elastic.co/downloads/kibana/kibana-7.17.5-linux-x86_64.tar.gz

tar -zvxf kibana-7.17.5-linux-x86_64.tar.gz

mv kibana-7.17.5-linux-x86_64 kibana-7.17.5配置 Kibana

vi config/kibana.yml

- #server.port: 5601

+ server.port: 5601

- #server.host: "localhost"

+ server.host: "0.0.0.0"

- #elasticsearch.hosts: ["http://localhost:9200"]

+ elasticsearch.hosts: ["http://localhost:9200"]启动 Kibana

切换用户

Kibana也不能以root用户运行,需要切换到

elasticsearch权限

su elasticsearch启动kibaba

#前台运行

sh bin/kibana

#后台运行

nohup sh bin/kibana >/dev/null 2>&1 &访问测试

访问对应宿主机的

5601端口

http://192.168.245.151:5601/ES快速入门

下面我们看下ES的一些基本使用

索引管理

我们使用数据库的第一步就是创建数据库,同样ES也是一样的,第一步也是对索引进行管理

列出索引

我们使用索引的第一步就是列出索引,查看当前数据库有哪些索引

GET /_cat/indices?v

创建索引

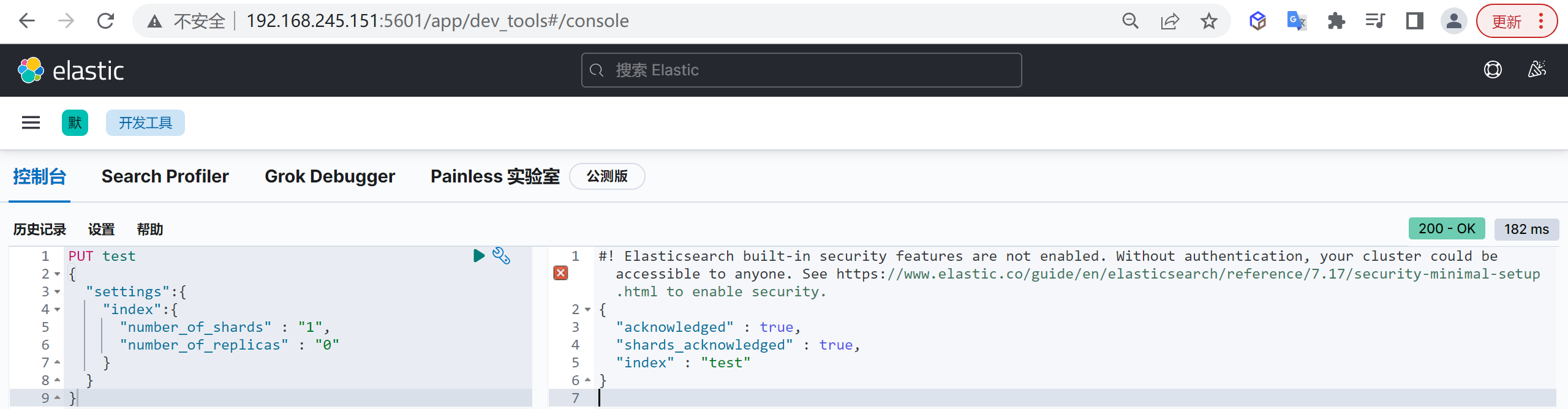

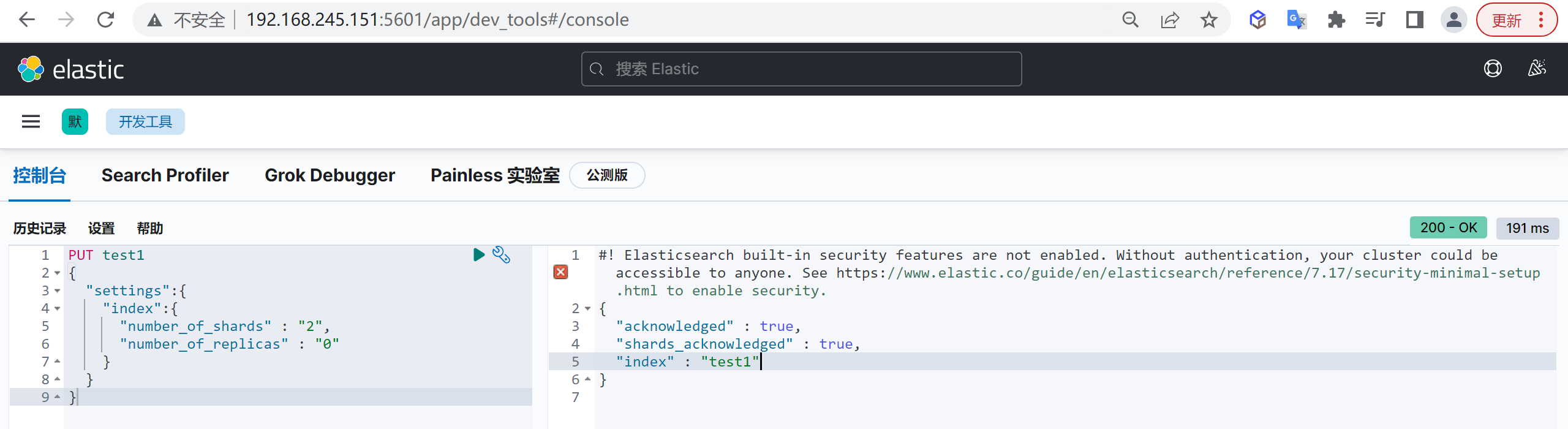

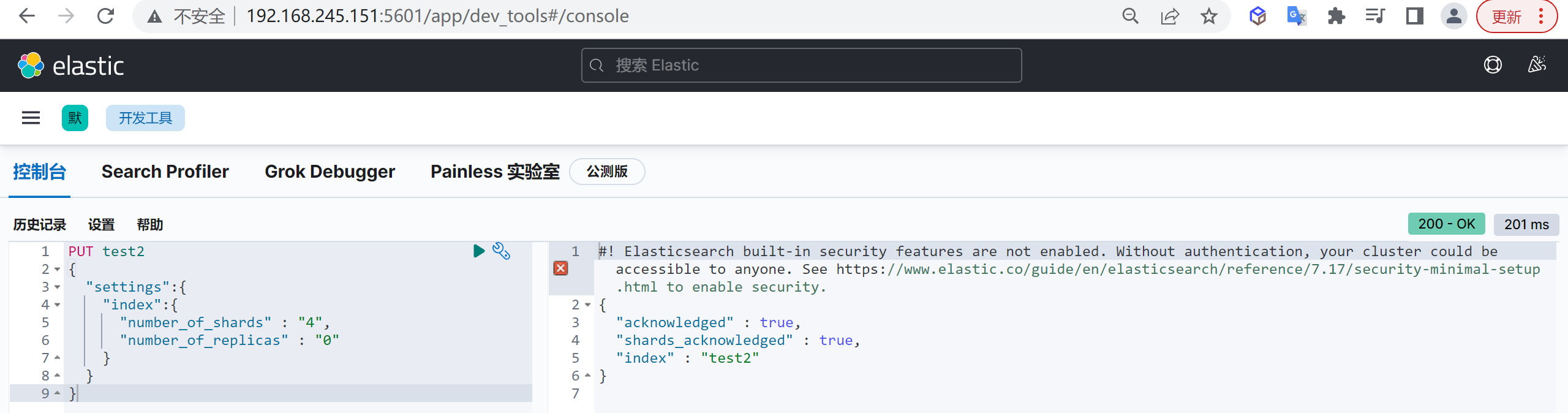

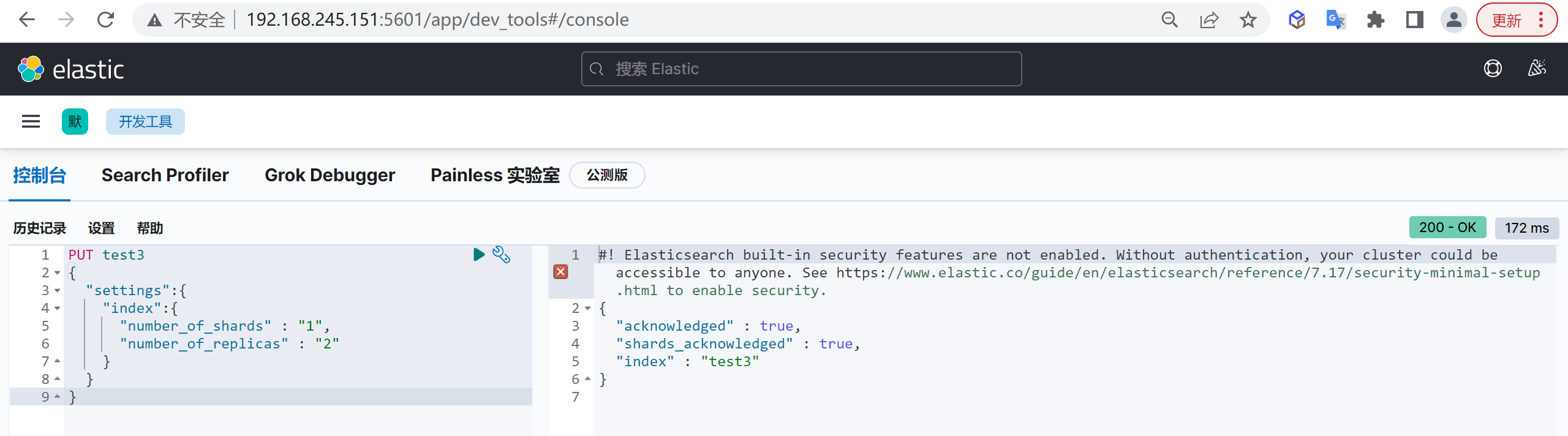

我们接下来要使用索引就需要创建索引了,Elasticsearch使用PUT方式来实现索引的新增

可以在创建索引的时候不添加任何参数,系统会为你创建一个默认的索引,当然你可以添加附加一些配置信息

PUT customer这样我们就创建了一个索引

查看索引

索引创建完成后,我们接下来就需要对索引进行查询

get customer

结果说明

这里返回了一堆数据,具体什么含义呢,我们需要查看字段的详细信息

| 字段 | 内容 |

|---|---|

| aliases | 别名 |

| mappings | 映射 |

| settings | 配置 |

| settings.index.creation_date | 创建时间 |

| settings.index.number_of_shards | 数据分片数,索引要做多少个分片,只能在创建索引时指定,后期无法修改 |

| settings.index.number_of_replicas | 数据备份数,每个分片有多少个副本,后期可以动态修改 |

| settings.index.uuid | 索引id |

| settings.index.provided_name | 名称 |

索引是否存在

有时候我们需要检查索引时候存在,我们可以使用HEAD命令验证索引是否存在

HEAD customer出现200表示索引存在

关闭索引

在一些业务场景,我们可能需要禁止掉某些索引的访问功能,但是又不想删除这个索引

post customer/_close这里我们就把这个索引给关闭了

查看索引列表

再次查看索引列表,查看索引的状态

GET /_cat/indices?v我们发现索引已经被关闭了

为什么关闭索引

如果关闭了一个索引,就无法通过Elasticsearch 来读取和写人其中的数据,直到再次打开它

在现实世界中,最好永久地保存应用日志,以防要查看很久之前的信息,另一方面,在Elasticsearch中存放大量数据需要增加资源,对于这种使用案例,关闭旧的索引非常有意义,你可能并不需要那些数据,但是也不想删除它们。

一旦索引被关闭,它在Elasticsearch内存中唯一的痕迹是其元数据,如名字以及分片的位置,如果有足够的磁盘空间,而且也不确定是否需要在那个数据中再次搜索,关闭索引要比删除索引更好,关闭它们会让你非常安心,随时可以重新打开被关闭的索引,然后在其中再次搜索

打开索引

如果我们需要继续启动索引可以直接打开索引

post customer/_open现在我们已经打开了索引

查看索引列表

GET /_cat/indices?v现在索引的状态已经是打开的状态了

删除索引

如果索引中的数据已经不需要了,可以被删除,我们是可以删除索引的,使用以下命令可以删除索引

delete customer这样我们就把索引给删除了

映射管理

映射的创建时基于索引的,你必须要先创建索引才能创建映射,es中的映射相当于传统数据库中的表结构,数据存储的格式就是通过映射来规定的

创建映射

可以在创建索引时指定映射,其中

mappings.properties为固定结构,指定创建映射属性

PUT customer

{

"mappings": {

"properties": {

"name": {

"type": "keyword"

},

"age": {

"type": "integer"

}

}

}

}

查看映射

查看索引完全信息,内容包含映射信息

GET customer/_mapping

文档管理

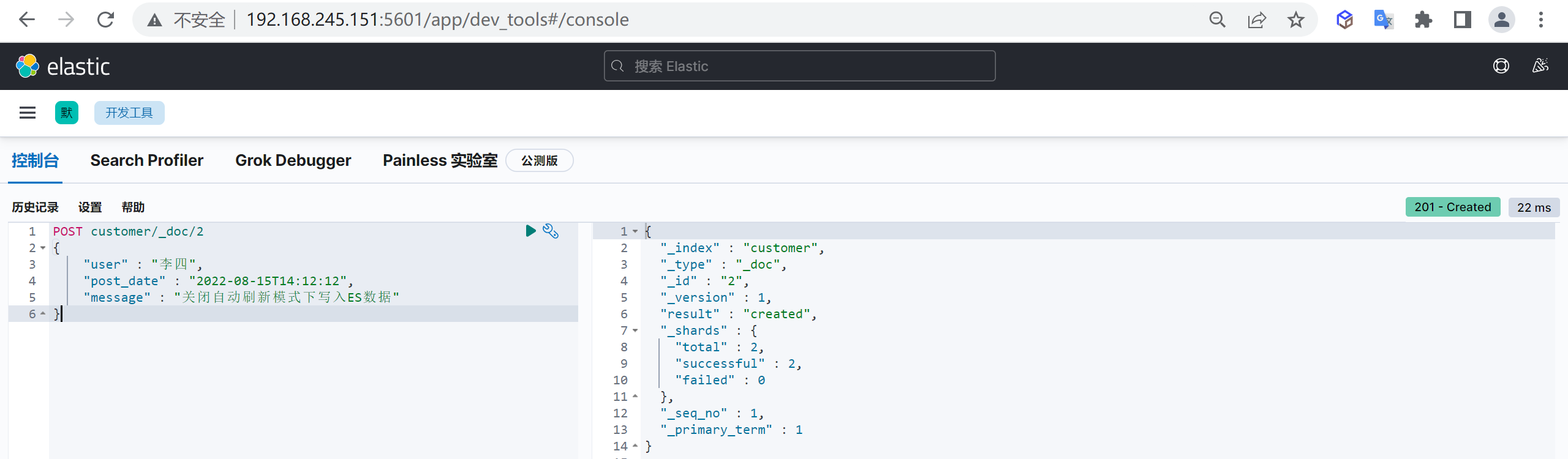

创建文档(业务ID)

创建文档的时候我们可以手动来指定ID,但是一般不推荐,回对ES插入性能造成影响

如果手动指定ID,为了保证ID不冲突,会先查询一次文档库,如果不存在则进行插入,手动插入多了一次查询操作,性能会有损失。

操作说明

- 文档可以类比为关系型数据库中的表数据,添加的数据格式为 JSON 格式

- 注意需要在索引后面添加

_doc,表示操作文档 - 在未指定id生成情况,每执行一次post将生成一个新文档

- 如果index不存在,将会默认创建

使用示例

新增文档,自动生成文档id,并且如果如果添加文档的索引不存在时会自动创建索引

post customer/_doc/1

{

"name" : "张三",

"age" : 15

}这样我们就创建了一个文档

返回结果说明

{

"_index" : "customer", #所属索引

"_type" : "_doc", #所属mapping type

"_id" : "1", #文档id

"_version" : 1, #文档版本

"result" : "created", #文档创建成功

"_shards" : {

"total" : 2, #所在分片有两个分片

"successful" : 1, #只有一个副本成功写入,可能节点机器只有一台

"failed" : 0 #失败副本数

},

"_seq_no" : 0, #第几次操作该文档

"_primary_term" : 1 #词项数

}创建文档(自动ID)

为了提高插入文档效率,我们一般会使用自动生成ID,这样减少一次插入时的查询性能损耗,插入时不指定文档ID,ES就会自动生成ID

自动生成的ID是一个不会重复的随机数,使用GUID算法,可以保证在分布式环境下,不同节点同一时间创建的_id一定是不冲突的

post customer/_doc

{

"name" : "李四",

"age" : 50

}这样创建了一个文档,并且文档ID是系统自动生成的

_id

更新文档

更新文档和插入文档一样,如果文档ID一致则会进行覆盖更新,而更新又分为全量更新和增量更新

全量更新

和新增文档一样,输入相同的 URL 地址请求,如果请求体变化,会将原有的数据内容覆盖

post customer/_doc/1

{

"name" : "张三",

"age" : 50

}

增量更新

通过指定

_doc方式默认是全量更新,如果需要更新指定字段则需要将_doc改为_update,请求内容需要增加doc表示,原始{“key”: value},更新{“doc”: {“key”: value}}

post customer/_update/1

{

"doc": {

"age" : 55

}

}查询文档

验证是否存在

可以通过以下命令检查文档是否存在

HEAD customer/_doc/1 #查看是否存储,返回200表示已存储查询文档

GET customer/_doc/1 #返回源数据的查询不返回source

有时候只是查询,不需要具体的源文档字段,这样可以提高查询速度,可以使用以下方式

GET customer/_doc/1?_source=false查询所有

上述只能查询单个,可以查询所有文档,将

_doc替换为_search

GET customer/_search删除文档

根据文档ID删除

我们可以根据文档ID进行删除

DELETE customer/_doc/1 #指定文档id进行删除根据条件删除

根据查询条件删除,会先查询然后在删除,可能耗时会比较长

post customer/_delete_by_query

{

"query": {

"match": {

"age": "15"

}

}

}中文分词器

IKAnalyzer

IKAnalyzer是一个开源的,基于java的语言开发的轻量级的中文分词工具包

从2006年12月推出1.0版开始,IKAnalyzer已经推出了3个大版本,在 2012 版本中,IK 实现了简单的分词歧义排除算法,标志着 IK 分词器从单纯的词典分词向模拟语义分词衍化

使用IK分词器

IK提供了两个分词算法:

- ik_smart:最少切分。

- ik_max_word:最细粒度划分。

ik_smart

使用案例

原始内容

传智教育的教学质量是杠杠的测试分词

GET _analyze

{

"analyzer": "ik_smart",

"text": "传智教育的教学质量是杠杠的"

}

ik_max_word

使用案例

原始内容

传智教育的教学质量是杠杠的测试分词

GET _analyze

{

"analyzer": "ik_max_word",

"text": "传智教育的教学质量是杠杠的"

}

自定义词库

我们在使用IK分词器时会发现其实有时候分词的效果也并不是我们所期待的

问题描述

例如我们输入“传智教育的教学质量是杠杠的”,但是分词器会把“传智教育”进行拆开,分为了“传”,“智”,“教育”,但我们希望的是“传智教育”可以不被拆开。

解决方案

对于以上的问题,我们只需要将自己要保留的词,加到我们的分词器的字典中即可

编辑字典内容

进入elasticsearch目录

plugins/ik/config中,创建我们自己的字典文件yixin.dic,并添加内容:

cd plugins/ik/config

echo "传智教育" > custom.dic

扩展字典

进入我们的elasticsearch目录 :

plugins/ik/config,打开IKAnalyzer.cfg.xml文件,进行如下配置:

vi IKAnalyzer.cfg.xml

#增加如下内容

<entry key="ext_dict">custom.dic</entry>再次测试

重启ElasticSearch,再次使用kibana测试

GET _analyze

{

"analyzer": "ik_max_word",

"text": "传智教育的教学质量是杠杠的"

}可以发现,现在我们的词汇”传智教育”就不会被拆开了,达到我们想要的效果了

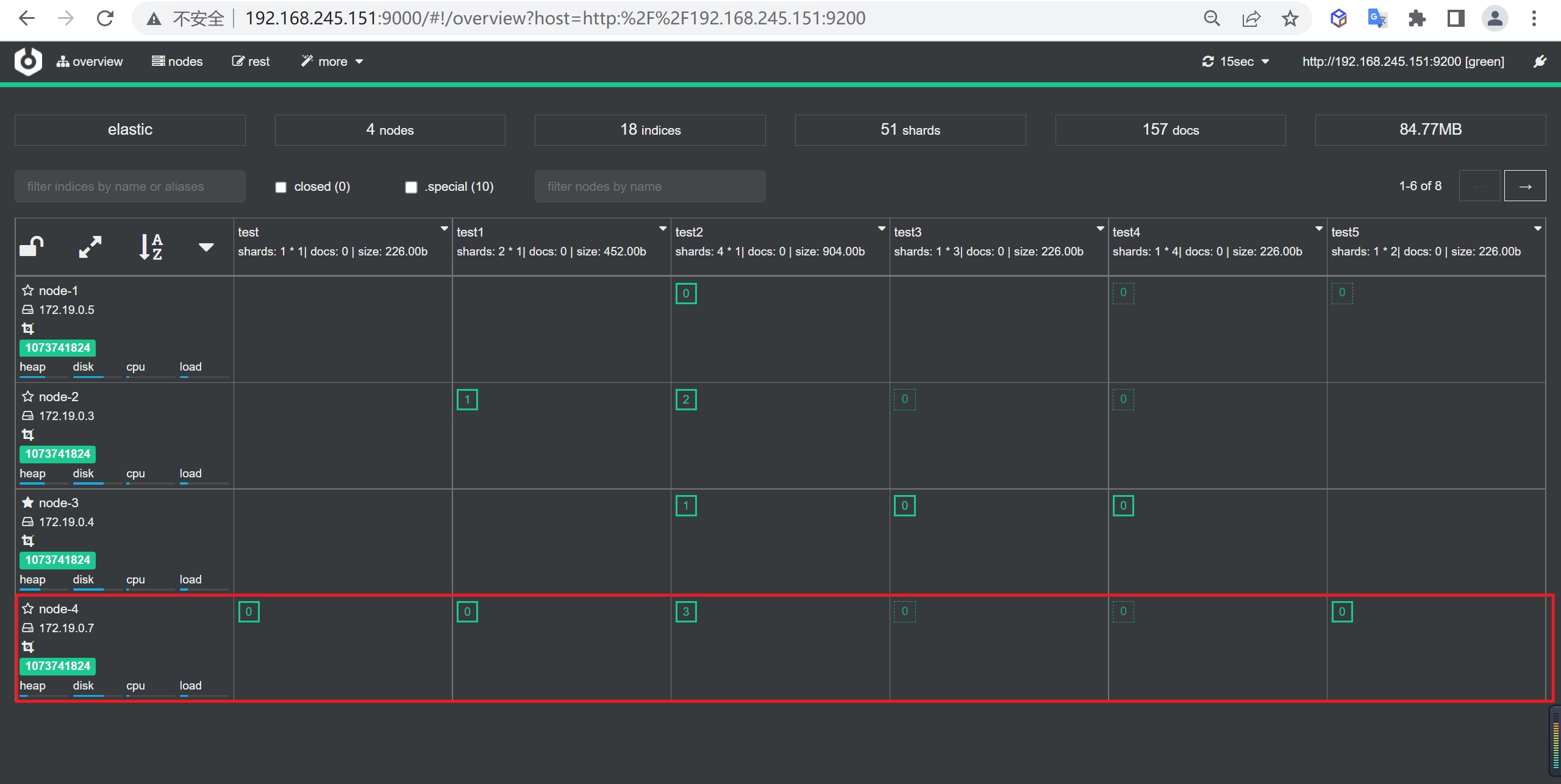

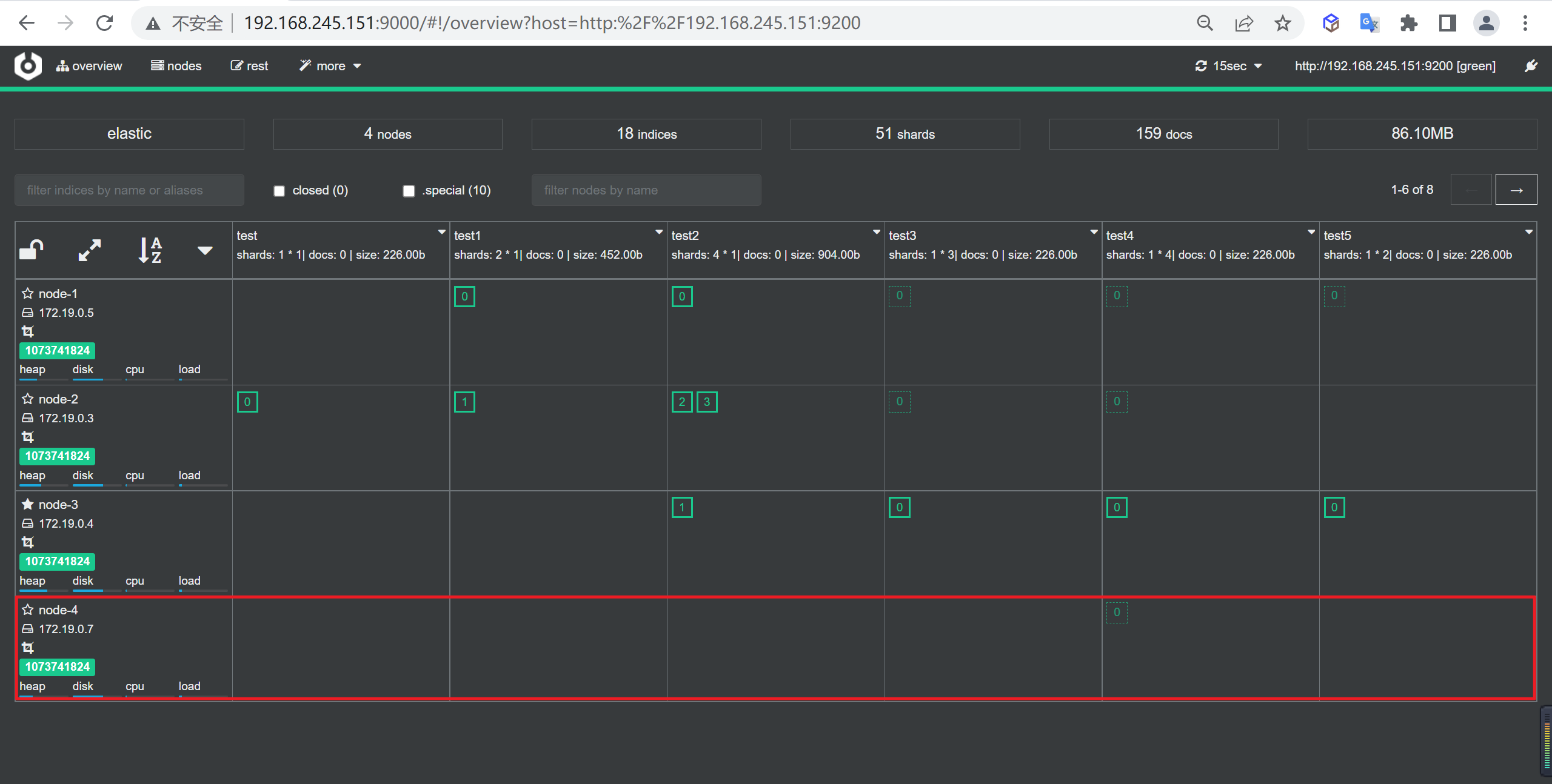

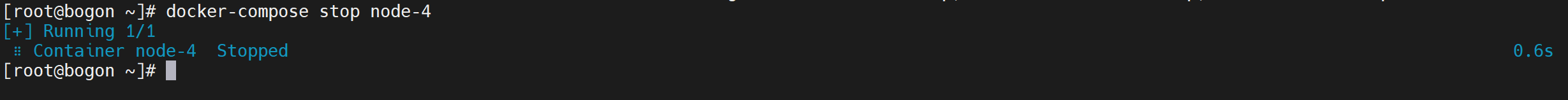

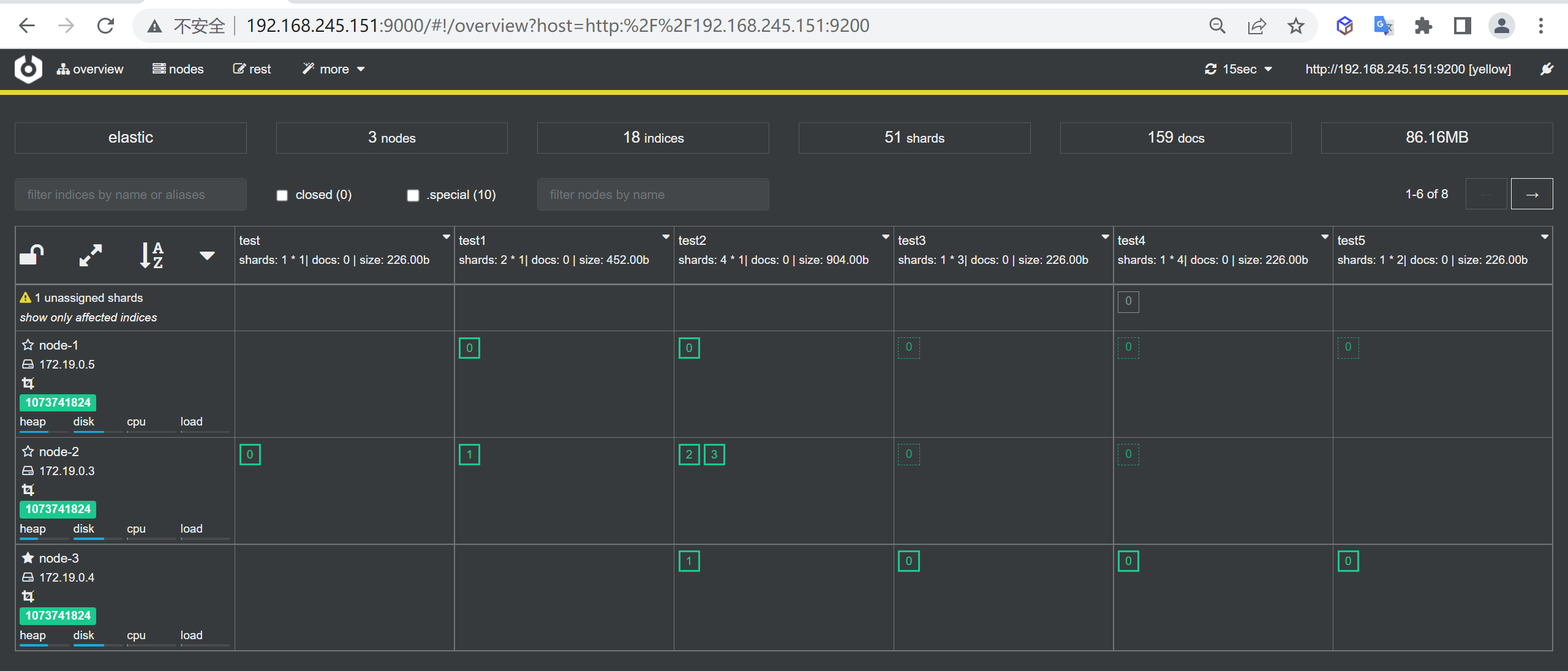

ES服务集群部署

我们将ES的服务部署和同步服务部署分为两套,因为后期我们数据同步完成可以将异构数据同步的服务停止掉

服务布局

我们整体采用Docker方式进行布局,以下是我们需要部署的服务

| 服务名称 | 服务名称 | 开放端口 | 内存限制 |

|---|---|---|---|

| ES-node1 | node-1 | 9200 | 1G |

| ES-node2 | node-2 | 9201 | 1G |

| ES-node3 | node-3 | 9202 | 1G |

| ES-cerebro | cerebro | 9000 | 不限 |

| kibana | kibana | 5601 | 不限 |

准备工作

创建挂载目录

#创建ES的数据和配置目录

mkdir -p /tmp/data/elasticsearch/node-{1..3}/{config,plugins,data,log}

# 创建kibana的配置目录

mkdir -p /tmp/data/kibana/config目录授权

chmod 777 /tmp/data/elasticsearch/node-{1..3}/{config,plugins,data,log}

chmod 777 /tmp/data/kibana/config修改Linux句柄数

查看当前最大句柄数

sysctl -a | grep vm.max_map_count修改句柄数

vi /etc/sysctl.conf

+ vm.max_map_count=262144生效配置

修改后需要重启才能生效,不想重启可以设置临时生效

sysctl -w vm.max_map_count=262144关闭swap

因为ES的数据大量都是常驻内存的,一旦使用了虚拟内存就会导致查询速度下降,一般需要关闭swap,但是要保证有足够的内存

临时关闭

swapoff -a永久关闭

vi /etc/fstab注释掉

swap这一行的配置

修改最大线程数

因为ES运行期间可能创建大量线程,如果线程数支持较少可能报错

配置修改

修改后需要重新登录生效

vi /etc/security/limits.conf

# 添加以下内容

* soft nofile 65536

* hard nofile 65536

* soft nproc 4096

* hard nproc 4096重启服务

reboot添加IK分词器

因为后面要用到IK分词,所以我们要安装以下IK分词器

查找

在github中下载对应版本的分词器

https://github.com/medcl/elasticsearch-analysis-ik/releases根据自己的ES版本选择相应版本的IK分词器,因为安装的ES是

7.17.5,所以也下载相应的IK分词器

解压

将下载的分词器复制到ES安装目录的

plugins目录中并进行解压

mkdir ik && cd ik

unzip elasticsearch-analysis-ik-7.17.5.zip安装

cp -R ik/ /tmp/data/elasticsearch/node-1/plugins/

cp -R ik/ /tmp/data/elasticsearch/node-2/plugins/

cp -R ik/ /tmp/data/elasticsearch/node-3/plugins/编写配置文件

下面我们对三个节点的配置进行配置

node-1

vi /tmp/data/elasticsearch/node-1/config/elasticsearch.yml

#集群名称

cluster.name: elastic

#当前该节点的名称

node.name: node-1

#是不是有资格竞选主节点

node.master: true

#是否存储数据

node.data: true

#最大集群节点数

node.max_local_storage_nodes: 3

#给当前节点自定义属性(可以省略)

#node.attr.rack: r1

#数据存档位置

path.data: /usr/share/elasticsearch/data

#日志存放位置

path.logs: /usr/share/elasticsearch/log

#是否开启时锁定内存(默认为是)

#bootstrap.memory_lock: true

#设置网关地址,我是被这个坑死了,这个地址我原先填写了自己的实际物理IP地址,

#然后启动一直报无效的IP地址,无法注入9300端口,这里只需要填写0.0.0.0

network.host: 0.0.0.0

#设置映射端口

http.port: 9200

#内部节点之间沟通端口

transport.tcp.port: 9300

#集群发现默认值为127.0.0.1:9300,如果要在其他主机上形成包含节点的群集,如果搭建集群则需要填写

#es7.x 之后新增的配置,写入候选主节点的设备地址,在开启服务后可以被选为主节点,也就是说把所有的节点都写上

discovery.seed_hosts: ["node-1","node-2","node-3"]

#当你在搭建集群的时候,选出合格的节点集群,有些人说的太官方了,

#其实就是,让你选择比较好的几个节点,在你节点启动时,在这些节点中选一个做领导者,

#如果你不设置呢,elasticsearch就会自己选举,这里我们把三个节点都写上

cluster.initial_master_nodes: ["node-1","node-2","node-3"]

#在群集完全重新启动后阻止初始恢复,直到启动N个节点

#简单点说在集群启动后,至少复活多少个节点以上,那么这个服务才可以被使用,否则不可以被使用,

gateway.recover_after_nodes: 2

#删除索引是是否需要显示其名称,默认为显示

#action.destructive_requires_name: true

# 禁用安全配置,否则查询的时候会提示警告

xpack.security.enabled: falsenode-2

vi /tmp/data/elasticsearch/node-2/config/elasticsearch.yml

#集群名称

cluster.name: elastic

#当前该节点的名称

node.name: node-2

#是不是有资格竞选主节点

node.master: true

#是否存储数据

node.data: true

#最大集群节点数

node.max_local_storage_nodes: 3

#给当前节点自定义属性(可以省略)

#node.attr.rack: r1

#数据存档位置

path.data: /usr/share/elasticsearch/data

#日志存放位置

path.logs: /usr/share/elasticsearch/log

#是否开启时锁定内存(默认为是)

#bootstrap.memory_lock: true

#设置网关地址,我是被这个坑死了,这个地址我原先填写了自己的实际物理IP地址,

#然后启动一直报无效的IP地址,无法注入9300端口,这里只需要填写0.0.0.0

network.host: 0.0.0.0

#设置映射端口

http.port: 9200

#内部节点之间沟通端口

transport.tcp.port: 9300

#集群发现默认值为127.0.0.1:9300,如果要在其他主机上形成包含节点的群集,如果搭建集群则需要填写

#es7.x 之后新增的配置,写入候选主节点的设备地址,在开启服务后可以被选为主节点,也就是说把所有的节点都写上

discovery.seed_hosts: ["node-1","node-2","node-3"]

#当你在搭建集群的时候,选出合格的节点集群,有些人说的太官方了,

#其实就是,让你选择比较好的几个节点,在你节点启动时,在这些节点中选一个做领导者,

#如果你不设置呢,elasticsearch就会自己选举,这里我们把三个节点都写上

cluster.initial_master_nodes: ["node-1","node-2","node-3"]

#在群集完全重新启动后阻止初始恢复,直到启动N个节点

#简单点说在集群启动后,至少复活多少个节点以上,那么这个服务才可以被使用,否则不可以被使用,

gateway.recover_after_nodes: 2

#删除索引是是否需要显示其名称,默认为显示

#action.destructive_requires_name: true

# 禁用安全配置,否则查询的时候会提示警告

xpack.security.enabled: falsenode-3

vi /tmp/data/elasticsearch/node-3/config/elasticsearch.yml

#集群名称

cluster.name: elastic

#当前该节点的名称

node.name: node-3

#是不是有资格竞选主节点

node.master: true

#是否存储数据

node.data: true

#最大集群节点数

node.max_local_storage_nodes: 3

#给当前节点自定义属性(可以省略)

#node.attr.rack: r1

#数据存档位置

path.data: /usr/share/elasticsearch/data

#日志存放位置

path.logs: /usr/share/elasticsearch/log

#是否开启时锁定内存(默认为是)

#bootstrap.memory_lock: true

#设置网关地址,我是被这个坑死了,这个地址我原先填写了自己的实际物理IP地址,

#然后启动一直报无效的IP地址,无法注入9300端口,这里只需要填写0.0.0.0

network.host: 0.0.0.0

#设置映射端口

http.port: 9200

#内部节点之间沟通端口

transport.tcp.port: 9300

#集群发现默认值为127.0.0.1:9300,如果要在其他主机上形成包含节点的群集,如果搭建集群则需要填写

#es7.x 之后新增的配置,写入候选主节点的设备地址,在开启服务后可以被选为主节点,也就是说把所有的节点都写上

discovery.seed_hosts: ["node-1","node-2","node-3"]

#当你在搭建集群的时候,选出合格的节点集群,有些人说的太官方了,

#其实就是,让你选择比较好的几个节点,在你节点启动时,在这些节点中选一个做领导者,

#如果你不设置呢,elasticsearch就会自己选举,这里我们把三个节点都写上

cluster.initial_master_nodes: ["node-1","node-2","node-3"]

#在群集完全重新启动后阻止初始恢复,直到启动N个节点

#简单点说在集群启动后,至少复活多少个节点以上,那么这个服务才可以被使用,否则不可以被使用,

gateway.recover_after_nodes: 2

#删除索引是是否需要显示其名称,默认为显示

#action.destructive_requires_name: true

# 禁用安全配置,否则查询的时候会提示警告

xpack.security.enabled: falsekibana

vi /tmp/data/kibana/config/kibana.yml

server.host: 0.0.0.0

# 监听端口

server.port: 5601

server.name: "kibana"

# kibana访问es服务器的URL,就可以有多个,以逗号","隔开

elasticsearch.hosts: ["http://node-1:9200","http://node-2:9201","http://node-3:9202"]

monitoring.ui.container.elasticsearch.enabled: true

# kibana访问Elasticsearch的账号与密码(如果ElasticSearch设置了的话)

elasticsearch.username: "kibana"

elasticsearch.password: "12345"

# kibana日志文件存储路径

logging.dest: stdout

# 此值为true时,禁止所有日志记录输出

logging.silent: false

# 此值为true时,禁止除错误消息之外的所有日志记录输出

logging.quiet: false

# 此值为true时,记录所有事件,包括系统使用信息和所有请求

logging.verbose: false

ops.interval: 5000

# kibana web语言

i18n.locale: "zh-CN"编写部署文档

vi docker-compose.yml

version: "3"

services:

node-1:

image: elasticsearch:7.17.5

container_name: node-1

environment:

- "ES_JAVA_OPTS=-Xms1024m -Xmx1024m"

- "TZ=Asia/Shanghai"

ulimits:

memlock:

soft: -1

hard: -1

nofile:

soft: 65536

hard: 65536

ports:

- "9200:9200"

logging:

driver: "json-file"

options:

max-size: "50m"

volumes:

- /tmp/data/elasticsearch/node-1/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml

- /tmp/data/elasticsearch/node-1/plugins:/usr/share/elasticsearch/plugins

- /tmp/data/elasticsearch/node-1/data:/usr/share/elasticsearch/data

- /tmp/data/elasticsearch/node-1/log:/usr/share/elasticsearch/log

networks:

- elastic

node-2:

image: elasticsearch:7.17.5

container_name: node-2

environment:

- "ES_JAVA_OPTS=-Xms1024m -Xmx1024m"

- "TZ=Asia/Shanghai"

ulimits:

memlock:

soft: -1

hard: -1

nofile:

soft: 65536

hard: 65536

ports:

- "9201:9200"

logging:

driver: "json-file"

options:

max-size: "50m"

volumes:

- /tmp/data/elasticsearch/node-2/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml

- /tmp/data/elasticsearch/node-2/plugins:/usr/share/elasticsearch/plugins

- /tmp/data/elasticsearch/node-2/data:/usr/share/elasticsearch/data

- /tmp/data/elasticsearch/node-2/log:/usr/share/elasticsearch/log

networks:

- elastic

node-3:

image: elasticsearch:7.17.5

container_name: node-3

environment:

- "ES_JAVA_OPTS=-Xms1024m -Xmx1024m"

- "TZ=Asia/Shanghai"

ulimits:

memlock:

soft: -1

hard: -1

nofile:

soft: 65536

hard: 65536

ports:

- "9202:9200"

logging:

driver: "json-file"

options:

max-size: "50m"

volumes:

- /tmp/data/elasticsearch/node-3/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml

- /tmp/data/elasticsearch/node-3/plugins:/usr/share/elasticsearch/plugins

- /tmp/data/elasticsearch/node-3/data:/usr/share/elasticsearch/data

- /tmp/data/elasticsearch/node-3/log:/usr/share/elasticsearch/log

networks:

- elastic

kibana:

container_name: kibana

image: kibana:7.17.5

volumes:

- /tmp/data/kibana/config/kibana.yml:/usr/share/kibana/config/kibana.yml

ports:

- 5601:5601

networks:

- elastic

cerebro:

image: lmenezes/cerebro:0.9.4

container_name: cerebro

environment:

TZ: 'Asia/Shanghai'

ports:

- '9000:9000'

networks:

- elastic

networks:

elastic:

driver: bridge启动服务

使用以下命令就可以启动服务了

docker-compose up -d同步服务部署

下面我们来搭建以下同步服务,该服务主要用来进行将MySQL的数据同步到ES中

服务布局

我们整体采用Docker方式进行布局,以下是我们需要部署的服务

| 服务名称 | 服务名称 | 开放端口 |

|---|---|---|

| MySQL | MySQL | 3306 |

| Canal | Canal | 无 |

| RabbitMQ | RabbitMQ | 5672 |

| logstash | logstash | 无 |

准备工作

创建挂载目录

下面我们需要创建相关的挂载目录

mkdir -p /tmp/etc/{canal,logstash,mysql}

mkdir -p /tmp/data/{canal,logstash,mysql,rabbitmq}

# 创建canal日志目录

mkdir -p /tmp/data/canal/logs

# 创建logstash的pipeline配置目录

mkdir -p /tmp/etc/logstash/pipeline

# 创建logstash日志目录

mkdir -p /tmp/data/logstash/logs

chmod -R 777 /tmp/etc/{canal,logstash,mysql}创建配置文件

MySQL配置文件

我们需要开启binlog的row模式

vi /tmp/etc/mysql/my.cnf

[mysqld]

log-bin=mysql-bin # 开启 binlog

binlog-format=ROW # 选择 ROW 模式

server_id=1 # 配置 MySQL replaction 需要定义,不要和 canal 的 slaveId 重复Canan配置文件

配置canal.properties

配置Canal配置文件canal.properties的挂载文件

vi /tmp/etc/canal/canal.properties

#################################################

######### common argument #############

#################################################

# tcp bind ip

canal.ip =

# register ip to zookeeper

canal.register.ip =

canal.port = 11111

canal.metrics.pull.port = 11112

# canal instance user/passwd

# canal.user = canal

# canal.passwd = E3619321C1A937C46A0D8BD1DAC39F93B27D4458

# canal admin config

#canal.admin.manager = 127.0.0.1:8089

canal.admin.port = 11110

canal.admin.user = admin

canal.admin.passwd = 4ACFE3202A5FF5CF467898FC58AAB1D615029441

canal.zkServers =

# flush data to zk

canal.zookeeper.flush.period = 1000

canal.withoutNetty = false

# tcp, kafka, rocketMQ, rabbitMQ

canal.serverMode = rabbitMQ

# flush meta cursor/parse position to file

canal.file.data.dir = ${canal.conf.dir}

canal.file.flush.period = 1000

## memory store RingBuffer size, should be Math.pow(2,n)

canal.instance.memory.buffer.size = 16384

## memory store RingBuffer used memory unit size , default 1kb

canal.instance.memory.buffer.memunit = 1024

## meory store gets mode used MEMSIZE or ITEMSIZE

canal.instance.memory.batch.mode = MEMSIZE

canal.instance.memory.rawEntry = true

## detecing config

canal.instance.detecting.enable = false

#canal.instance.detecting.sql = insert into retl.xdual values(1,now()) on duplicate key update x=now()

canal.instance.detecting.sql = select 1

canal.instance.detecting.interval.time = 3

canal.instance.detecting.retry.threshold = 3

canal.instance.detecting.heartbeatHaEnable = false

# support maximum transaction size, more than the size of the transaction will be cut into multiple transactions delivery

canal.instance.transaction.size = 1024

# mysql fallback connected to new master should fallback times

canal.instance.fallbackIntervalInSeconds = 60

# network config

canal.instance.network.receiveBufferSize = 16384

canal.instance.network.sendBufferSize = 16384

canal.instance.network.soTimeout = 30

# binlog filter config

canal.instance.filter.druid.ddl = true

canal.instance.filter.query.dcl = false

canal.instance.filter.query.dml = false

canal.instance.filter.query.ddl = false

canal.instance.filter.table.error = false

canal.instance.filter.rows = false

canal.instance.filter.transaction.entry = false

# binlog format/image check

canal.instance.binlog.format = ROW,STATEMENT,MIXED

canal.instance.binlog.image = FULL,MINIMAL,NOBLOB

# binlog ddl isolation

canal.instance.get.ddl.isolation = false

# parallel parser config

canal.instance.parser.parallel = true

## concurrent thread number, default 60% available processors, suggest not to exceed Runtime.getRuntime().availableProcessors()

#canal.instance.parser.parallelThreadSize = 16

## disruptor ringbuffer size, must be power of 2

canal.instance.parser.parallelBufferSize = 256

# table meta tsdb info

canal.instance.tsdb.enable = true

canal.instance.tsdb.dir = ${canal.file.data.dir:../conf}/${canal.instance.destination:}

canal.instance.tsdb.url = jdbc:h2:${canal.instance.tsdb.dir}/h2;CACHE_SIZE=1000;MODE=MYSQL;

canal.instance.tsdb.dbUsername = canal

canal.instance.tsdb.dbPassword = canal

# dump snapshot interval, default 24 hour

canal.instance.tsdb.snapshot.interval = 24

# purge snapshot expire , default 360 hour(15 days)

canal.instance.tsdb.snapshot.expire = 360

#################################################

######### destinations #############

#################################################

canal.destinations = village

# conf root dir

canal.conf.dir = ../conf

# auto scan instance dir add/remove and start/stop instance

canal.auto.scan = true

canal.auto.scan.interval = 5

canal.instance.tsdb.spring.xml = classpath:spring/tsdb/h2-tsdb.xml

#canal.instance.tsdb.spring.xml = classpath:spring/tsdb/mysql-tsdb.xml

canal.instance.global.mode = spring

canal.instance.global.lazy = false

canal.instance.global.manager.address = ${canal.admin.manager}

#canal.instance.global.spring.xml = classpath:spring/memory-instance.xml

canal.instance.global.spring.xml = classpath:spring/file-instance.xml

#canal.instance.global.spring.xml = classpath:spring/default-instance.xml

##################################################

######### MQ Properties #############

##################################################

# aliyun ak/sk , support rds/mq

canal.aliyun.accessKey =

canal.aliyun.secretKey =

canal.aliyun.uid=

canal.mq.flatMessage = true

canal.mq.canalBatchSize = 50

canal.mq.canalGetTimeout = 100

# Set this value to "cloud", if you want open message trace feature in aliyun.

canal.mq.accessChannel = local

canal.mq.database.hash = true

canal.mq.send.thread.size = 30

canal.mq.build.thread.size = 8

##################################################

######### Kafka #############

##################################################

kafka.bootstrap.servers = 127.0.0.1:9092

kafka.acks = all

kafka.compression.type = none

kafka.batch.size = 16384

kafka.linger.ms = 1

kafka.max.request.size = 1048576

kafka.buffer.memory = 33554432

kafka.max.in.flight.requests.per.connection = 1

kafka.retries = 0

kafka.kerberos.enable = false

kafka.kerberos.krb5.file = "../conf/kerberos/krb5.conf"

kafka.kerberos.jaas.file = "../conf/kerberos/jaas.conf"

##################################################

######### RocketMQ #############

##################################################

rocketmq.producer.group = test

rocketmq.enable.message.trace = false

rocketmq.customized.trace.topic =

rocketmq.namespace =

rocketmq.namesrv.addr = 127.0.0.1:9876

rocketmq.retry.times.when.send.failed = 0

rocketmq.vip.channel.enabled = false

##################################################

######### RabbitMQ #############

##################################################

rabbitmq.host = rabbit

rabbitmq.virtual.host = /

rabbitmq.exchange = canal

rabbitmq.username = guest

rabbitmq.password = guest配置 instance.properties

配置Canal的数据源配置文件

instance.properties的挂载文件,路径在village/instance.properties

mkdir -p /tmp/etc/canal/village

vi /tmp/etc/canal/village/instance.properties

#################################################

## mysql serverId , v1.0.26+ will autoGen

## mysql slaveId v1.0.26 后的版本支持自动生成 可以不需要配置

# canal.instance.mysql.slaveId=0

# enable gtid use true/false

canal.instance.gtidon=false

# position info

## 配置连接数据库的地址

canal.instance.master.address=mysql:3306

canal.instance.master.journal.name=

canal.instance.master.position=

canal.instance.master.timestamp=

canal.instance.master.gtid=

# rds oss binlog

canal.instance.rds.accesskey=

canal.instance.rds.secretkey=

canal.instance.rds.instanceId=

# table meta tsdb info

canal.instance.tsdb.enable=true

#canal.instance.tsdb.url=jdbc:mysql://172.18.0.10:3306/test

#canal.instance.tsdb.dbUsername=canal

#canal.instance.tsdb.dbPassword=canal

#canal.instance.standby.address =

#canal.instance.standby.journal.name =

#canal.instance.standby.position =

#canal.instance.standby.timestamp =

#canal.instance.standby.gtid=

# username/password

# 配置数据库用户名密码

canal.instance.dbUsername=canal

canal.instance.dbPassword=canal

# 配置 连接数据库的编码格式

canal.instance.connectionCharset = UTF-8

# enable druid Decrypt database password

canal.instance.enableDruid=false

#canal.instance.pwdPublicKey=MFwwDQYJKoZIhvcNAQEBBQADSwAwSAJBALK4BUxdDltRRE5/zXpVEVPUgunvscYFtEip3pmLlhrWpacX7y7GCMo2/JM6LeHmiiNdH1FWgGCpUfircSwlWKUCAwEAAQ==

#canal.instance.defaultDatabaseName=village

# table regex

## canal 收集表的 过滤正则表达式 这个表示收集所有表数据

#canal.instance.filter.regex=t_village

canal.instance.filter.regex=village\\..*

# table black regex

## canal 收集表的黑名单

canal.instance.filter.black.regex=

# table field filter(format: schema1.tableName1:field1/field2,schema2.tableName2:field1/field2)

#canal.instance.filter.field=test1.t_product:id/subject/keywords,test2.t_company:id/name/contact/ch

# table field black filter(format: schema1.tableName1:field1/field2,schema2.tableName2:field1/field2)

#canal.instance.filter.black.field=test1.t_product:subject/product_image,test2.t_company:id/name/contact/ch

#################################################Logstash配置文件

创建 logstash.yml

该配置文件时logstash的主要的配置文件

vi /tmp/etc/logstash/logstash.yml

http.host: 0.0.0.0

path.config: /usr/share/logstash/config/pipeline/*.conf

path.logs: /usr/share/logstash/logs

pipeline.batch.size: 10

xpack.monitoring.elasticsearch.hosts:

- http://192.168.245.151:9200

xpack.monitoring.enabled: false创建village.conf

该文件是logstash的pipeline的配置

vi /tmp/etc/logstash/pipeline/village.conf

input {

rabbitmq {

host => "rabbit" #RabbitMQ-IP地址

port => 5672 #端口号

vhost => "/" #虚拟主机

user => "guest" #用户名

password => "guest" #密码

exchange=> "canal" # rabbitmq中的交换器

key => ""

queue => "direct_queue" #队列

durable => false #持久化跟队列配置一致

codec => "json" #格式

}

}

filter {

if [type] == "DELETE" {

drop{}

}

split {

field => "data"

}

mutate {

remove_field => ["sqlType"]

remove_field => ["mysqlType"]

remove_field => ["database"]

remove_field => ["sql"]

remove_field => ["es"]

remove_field => ["ts"]

remove_field => ["pkNames"]

remove_field => ["isDdl"]

remove_field => ["table"]

remove_field => ["tags"]

remove_field => ["type"]

remove_field => ["old"]

remove_field => ["id"]

remove_field => ["sql"]

}

date {

match => ["create_date", "yyyy-MM-dd HH:mm:ss"]

locale => "en"

timezone => "Asia/Shanghai"

target => "@timestamp"

}

ruby {

code => "

event.set('@timestamp', LogStash::Timestamp.at(event.get('@timestamp').time.localtime + 8*60*60))

"

}

if [data][name] {

mutate {

add_field => { "name" => "%{[data][name]}"}

}

}

if [data][province]{

mutate {

add_field => { "province" => "%{[data][province]}"}

}

}

if [data][city]{

mutate {

add_field => { "city" => "%{[data][city]}"}

}

}

if [data][area]{

mutate {

add_field => { "area" => "%{[data][area]}"}

}

}

if [data][addr]{

mutate {

add_field => { "addr" => "%{[data][addr]}"}

}

}

if [data][lat_gps]{

mutate {

add_field => { "[location][lat]" => "%{[data][lat_gps]}"}

add_field => { "[location][lon]" => "%{[data][lon_gps]}"}

convert => { "[location][lat]" => "float" }

convert => { "[location][lon]" => "float" }

}

}

if [data][property_type]{

mutate {

add_field => { "property_type" => "%{[data][property_type]}"}

}

}

if [data][property_company]{

mutate {

add_field => { "property_company" => "%{[data][property_company]}"}

}

}

if [data][property_cost]{

mutate {

add_field => { "property_cost" => "%{[data][property_cost]}"}

}

}

if [data][floorage]{

mutate {

add_field => { "floorage" => "%{[data][floorage]}"}

}

}

if [data][houses]{

mutate {

add_field => { "houses" => "%{[data][houses]}"}

}

}

if [data][built_year]{

mutate {

add_field => { "built_year" => "%{[data][built_year]}"}

}

}

if [data][parkings]{

mutate {

add_field => { "parkings" => "%{[data][parkings]}"}

}

}

if [data][volume]{

mutate {

add_field => { "volume" => "%{[data][volume]}"}

}

}

if [data][greening]{

mutate {

add_field => { "greening" => "%{[data][greening]}"}

}

}

if [data][producer]{

mutate {

add_field => { "producer" => "%{[data][producer]}"}

}

}

if [data][school]{

mutate {

add_field => { "school" => "%{[data][school]}"}

}

}

if [data][info]{

mutate {

add_field => { "info" => "%{[data][info]}"}

}

}

# if [data][create_date]{

# mutate {

# add_field => { "create_date" => "%{[data][create_date]}"}

# }

# }

mutate {

remove_field => ["data"]

}

}

output {

elasticsearch {

hosts => ["192.168.245.151:9200"]

index => "logstash-village-%{+YYYY.MM.dd}"

}

# stdout { codec => rubydebug }

}编写部署文档

vi docker-compose.yml

version: '2'

services:

mysql:

image: mysql:5.7

hostname: mysql

container_name: mysql

networks:

- dockernetwork

ports:

- "3306:3306"

environment:

MYSQL_ROOT_PASSWORD: root

volumes:

- "/tmp/etc/mysql:/etc/mysql/conf.d"

- "/tmp/data/mysql:/var/lib/mysql"

rabbit:

image: rabbitmq:management

hostname: rabbit

container_name: rabbit

networks:

- dockernetwork

ports:

- "15672:15672"

volumes:

- "/tmp/data/rabbitmq:/var/lib/rabbitmq"

canal:

image: canal/canal-server:v1.1.5

hostname: canal

container_name: canal

restart: always

networks:

- dockernetwork

volumes:

- "/tmp/etc/canal/canal.properties:/home/admin/canal-server/conf/canal.properties"

- "/tmp/etc/canal/village:/home/admin/canal-server/conf/village"

- "/tmp/data/canal/logs:/home/admin/canal-server/logs"

depends_on:

- mysql

- rabbit

logstash:

image: logstash:7.17.5

hostname: logstash

container_name: logstash

privileged: true

restart: always

networks:

- dockernetwork

environment:

XPACK_MONITORING_ENABLED: "false"

pipeline.batch.size: 10

volumes:

- "/tmp/etc/logstash/pipeline/:/usr/share/logstash/config/pipeline"

- "/tmp/etc/logstash/logstash.yml:/usr/share/logstash/config/logstash.yml"

- "/tmp/data/logstash/logs:/usr/share/logstash/logs"

depends_on:

- mysql

- rabbit

- canal

networks:

dockernetwork:

driver: bridge启动服务

执行下面的命令启动服务

docker-compose up -d初始化服务

初始化数据库

检查数据库

可以使用远程工具连接MySql检查是否能够正常连接

创建数据库

通过下面的脚本来创建数据库

CREATE DATABASE `village`

USE `village`;

DROP TABLE IF EXISTS `t_village`;

CREATE TABLE `t_village` (

`id` int(11) NOT NULL AUTO_INCREMENT COMMENT '主键',

`name` varchar(100) CHARACTER SET utf8mb4 DEFAULT NULL COMMENT '小区名字',

`province` varchar(100) CHARACTER SET utf8mb4 DEFAULT NULL COMMENT '省',

`city` varchar(100) CHARACTER SET utf8mb4 DEFAULT NULL COMMENT '市',

`area` varchar(100) COLLATE utf8_unicode_ci DEFAULT NULL COMMENT '区',

`addr` varchar(200) CHARACTER SET utf8mb4 DEFAULT NULL COMMENT '地址',

`lon_baid` varchar(50) CHARACTER SET utf8mb4 DEFAULT NULL COMMENT '经度_百度',

`lat_baid` varchar(50) CHARACTER SET utf8mb4 DEFAULT NULL COMMENT '维度_百度',

`lon_gps` varchar(50) CHARACTER SET utf8mb4 DEFAULT NULL COMMENT '经度_GPS',

`lat_gps` varchar(50) CHARACTER SET utf8mb4 DEFAULT NULL COMMENT '维度_GPS',

`property_type` varchar(100) CHARACTER SET utf8mb4 DEFAULT NULL COMMENT '小区物业类型',

`property_cost` float DEFAULT NULL COMMENT '小区物业费用/平米',

`property_company` varchar(100) CHARACTER SET utf8mb4 DEFAULT NULL COMMENT '物业公司',

`floorage` float DEFAULT NULL COMMENT '总建筑面积',

`houses` int(11) DEFAULT NULL COMMENT '总户数',

`built_year` varchar(10) COLLATE utf8_unicode_ci DEFAULT NULL COMMENT '建造年代',

`parkings` int(11) DEFAULT NULL COMMENT '停车位数量',

`volume` float DEFAULT NULL COMMENT '容积率',

`greening` float DEFAULT NULL COMMENT '绿化率',

`producer` varchar(100) CHARACTER SET utf8mb4 DEFAULT NULL COMMENT '开发商',

`school` varchar(100) CHARACTER SET utf8mb4 DEFAULT NULL COMMENT '相关学校',

`info` varchar(15000) CHARACTER SET utf8mb4 DEFAULT NULL COMMENT '小区介绍',

`create_date` datetime DEFAULT NULL COMMENT '创建时间',

PRIMARY KEY (`id`)

) ENGINE=InnoDB AUTO_INCREMENT=334511 DEFAULT CHARSET=utf8 COLLATE=utf8_unicode_ci;导入数据

通过服务连接Mysql服务,就可以将excel数据导入到mysql

创建Canal用户

canal的原理是模拟自己为mysql slave,所以这里一定需要做为mysql slave的相关权限

CREATE USER canal IDENTIFIED BY 'canal';

GRANT SELECT, REPLICATION SLAVE, REPLICATION CLIENT ON *.* TO 'canal'@'%';

-- GRANT ALL PRIVILEGES ON *.* TO 'canal'@'%' ;

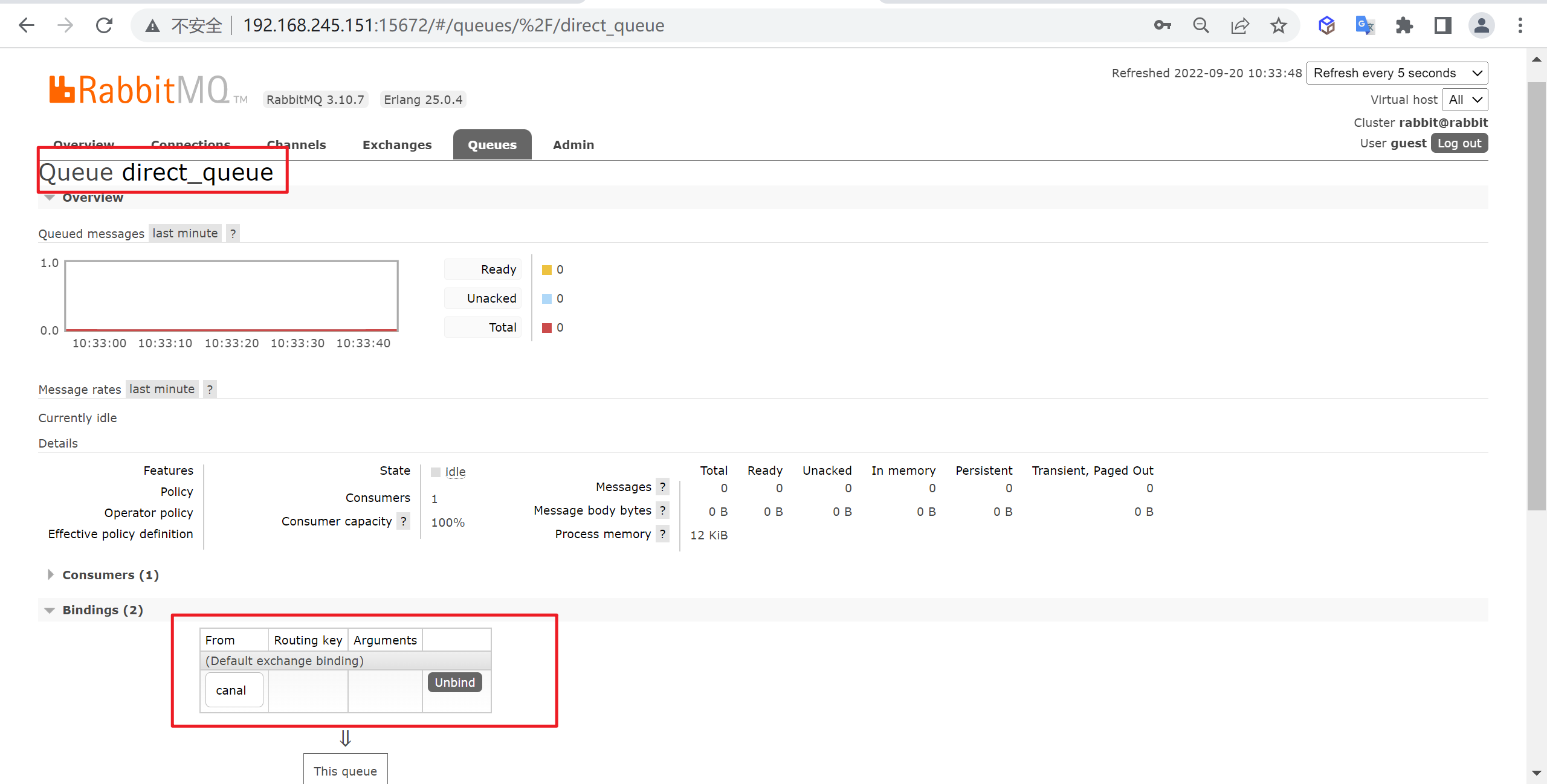

FLUSH PRIVILEGES;初始化RabbitMQ

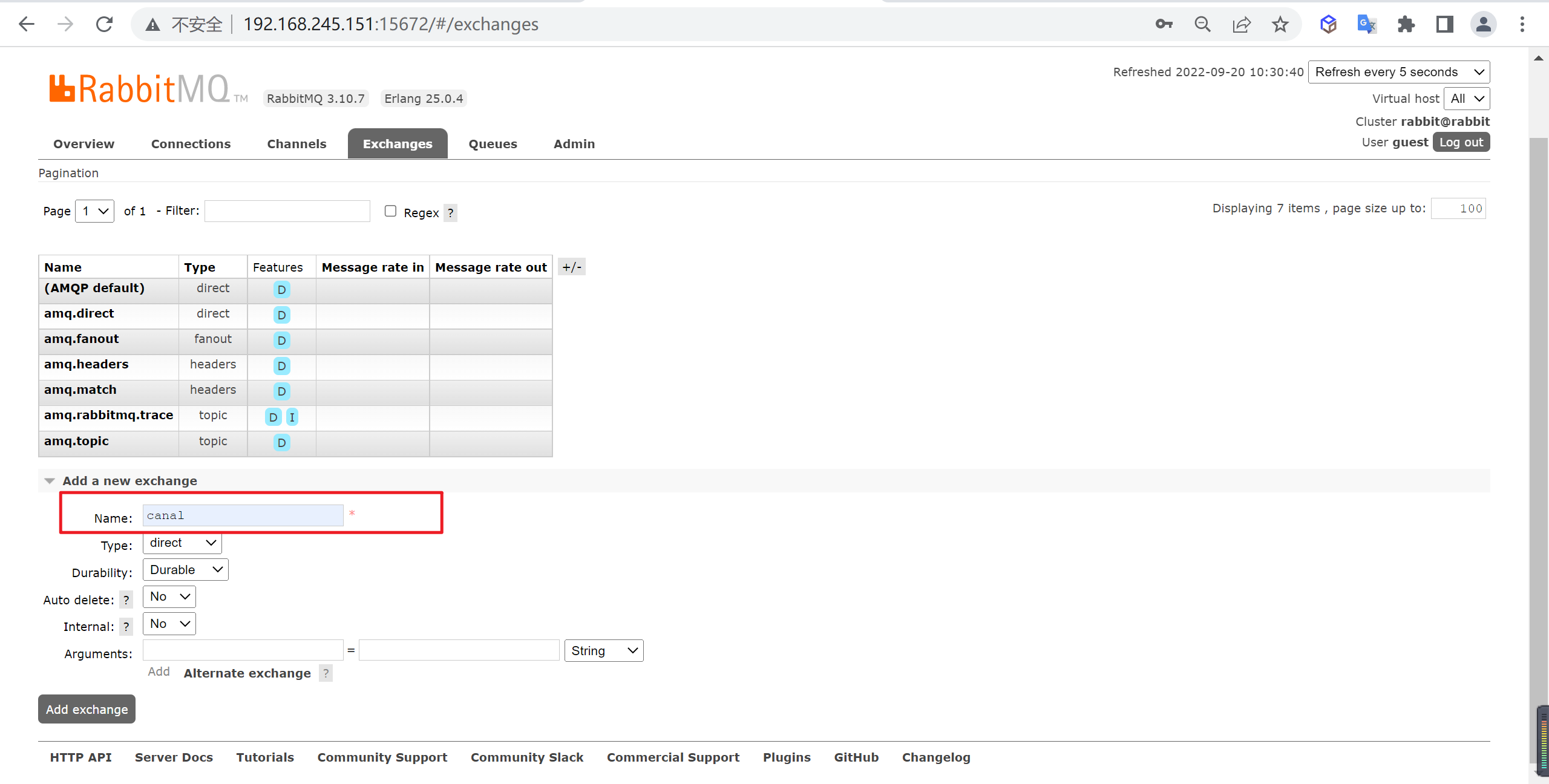

要将消息推送到RabbitMQ需要先添加交换器以及队列,登录

http://192.168.245.151:15672/进行操作

新增交换器

我们新增一个

canal的交换器

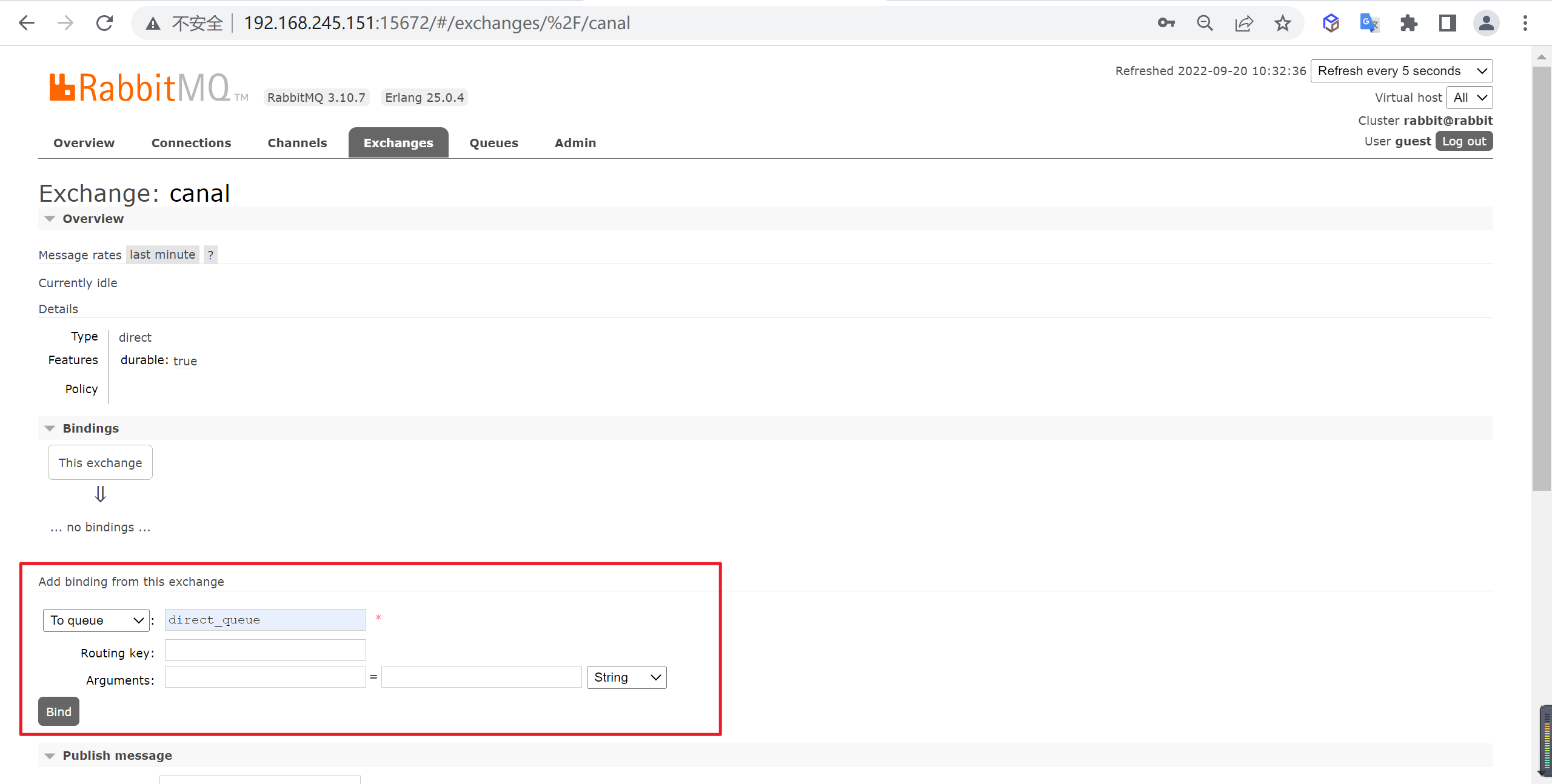

建立绑定关系

让

canal交换器和direct_queue队列建立绑定关系,路由键为空

查看队列情况

我们绑定完成后,可以来查看一下队列的情况

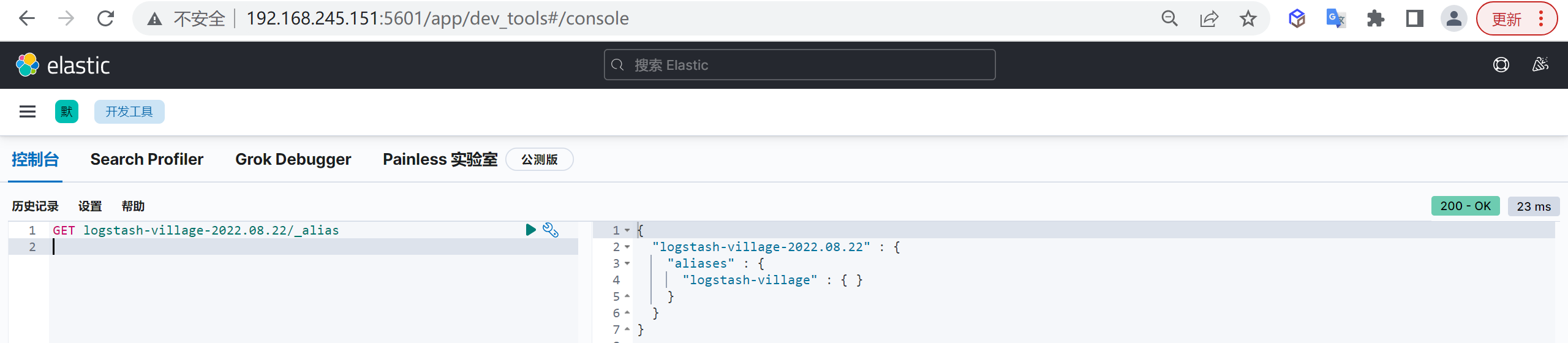

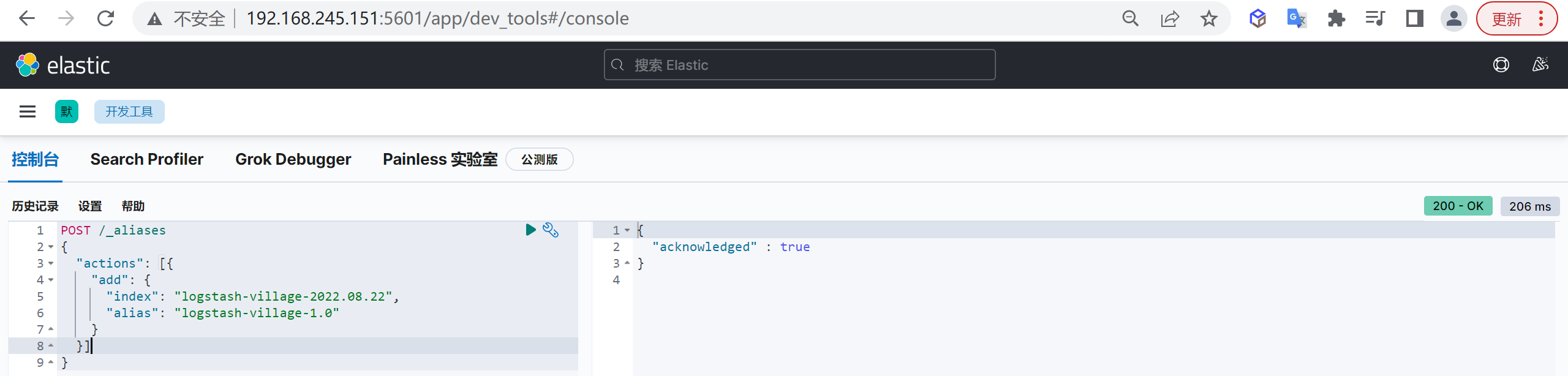

ElasticSearch初始化

因为要导入ES,我们需要先创建索引

创建索引模板

创建一个有三个分片两个副本的索引

PUT _index_template/logstash-village

{

"index_patterns": [

"logstash-village-*" // 可以通过"logstash-village-*"来适配创建的索引

],

"template": {

"settings": {

"number_of_shards": "3", //指定模板分片数量

"number_of_replicas": "2" //指定模板副本数量

},

"aliases": {

"logstash-village": {} //指定模板索引别名

},

"mappings": { //设置映射

"dynamic": "strict", //禁用动态映射

"properties": {

"@timestamp": {

"type": "date",

"format": "strict_date_optional_time||epoch_millis||yyyy-MM-dd HH:mm:ss"

},

"@version": {

"doc_values": false,

"index": "false",

"type": "integer"

},

"name": {

"type": "keyword"

},

"province": {

"type": "keyword"

},

"city": {

"type": "keyword"

},

"area": {

"type": "keyword"

},

"addr": {

"type": "text",

"analyzer": "ik_smart"

},

"location": {

"type": "geo_point"

},

"property_type": {

"type": "keyword"

},

"property_company": {

"type": "text",

"analyzer": "ik_smart"

},

"property_cost": {

"type": "float"

},

"floorage": {

"type": "float"

},

"houses": {

"type": "integer"

},

"built_year": {

"type": "integer"

},

"parkings": {

"type": "integer"

},

"volume": {

"type": "float"

},

"greening": {

"type": "float"

},

"producer": {

"type": "text",

"analyzer": "ik_smart"

},

"school": {

"type": "text",

"analyzer": "ik_smart"

},

"info": {

"type": "text",

"analyzer": "ik_smart"

}

}

}

}

}导入数据进行同步

接下来我们就需要导入相关的Excel的数据进行同步了,logstash会自动的创建索引,并应用上面的模板

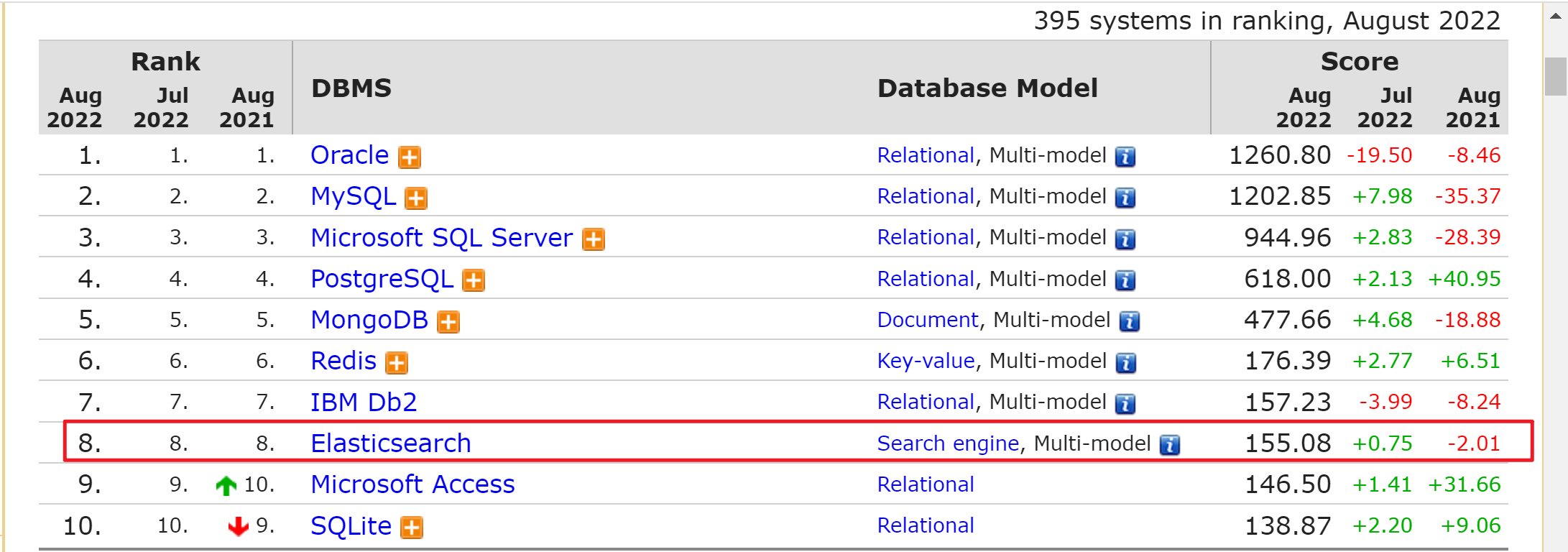

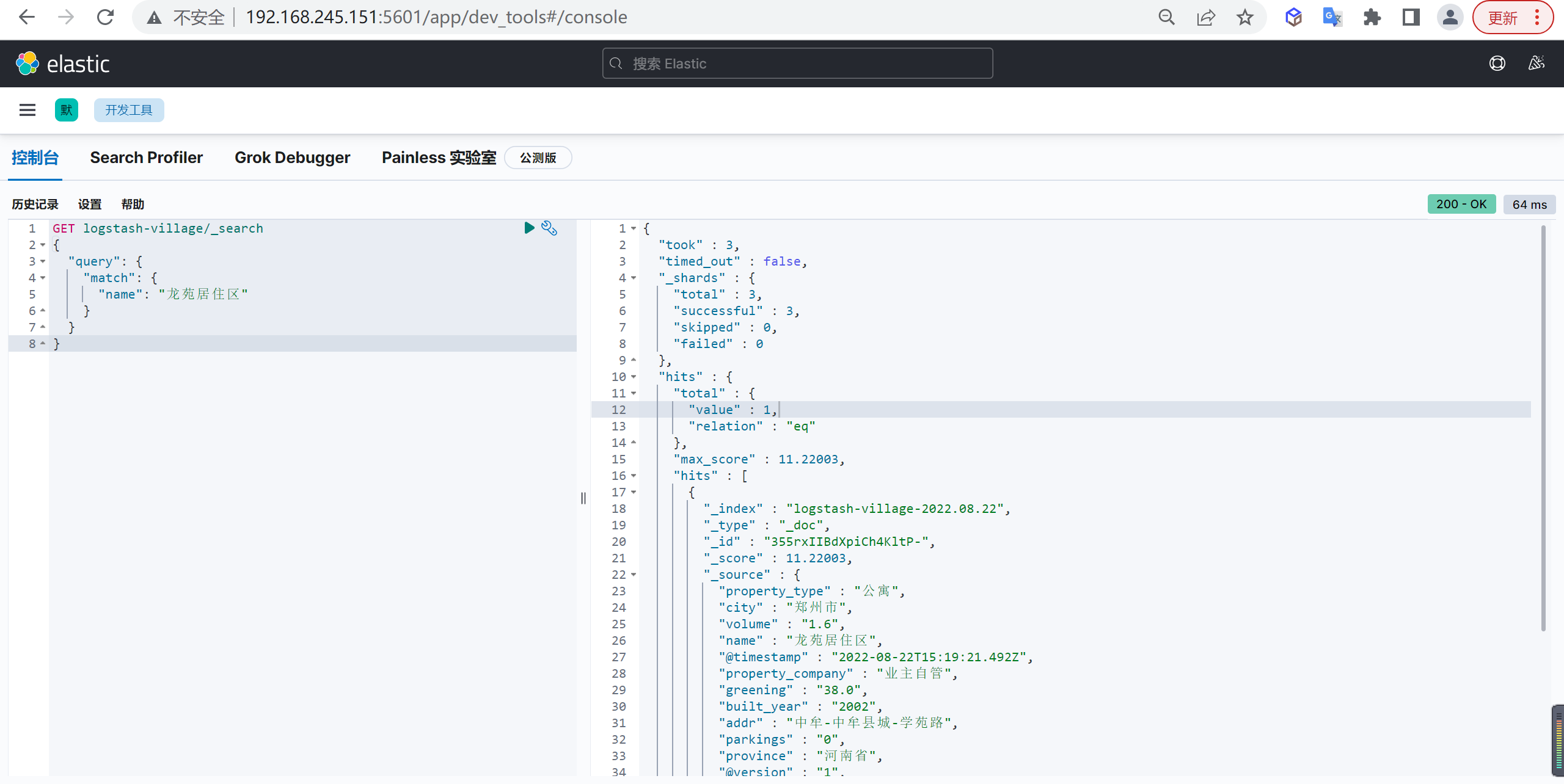

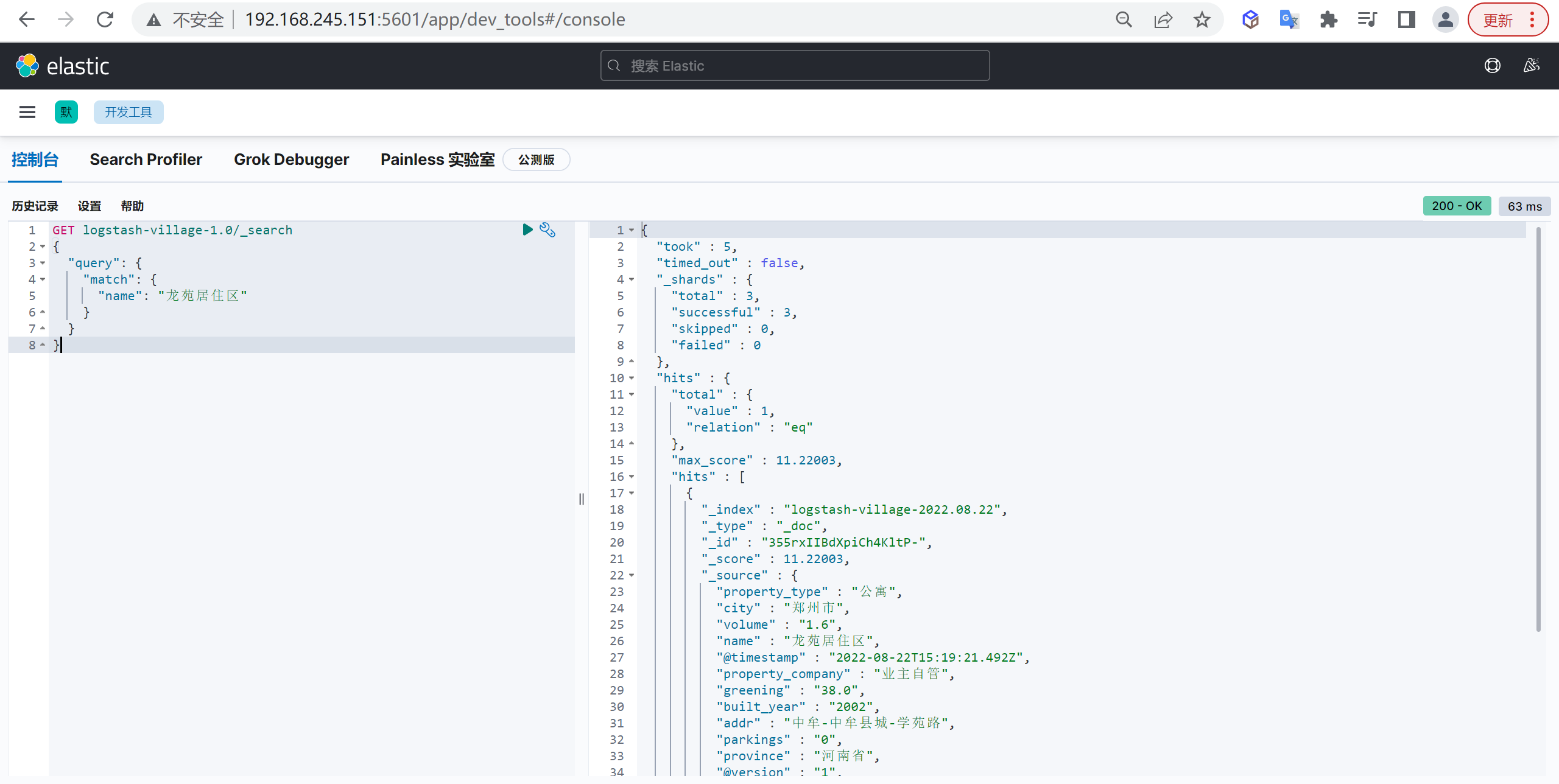

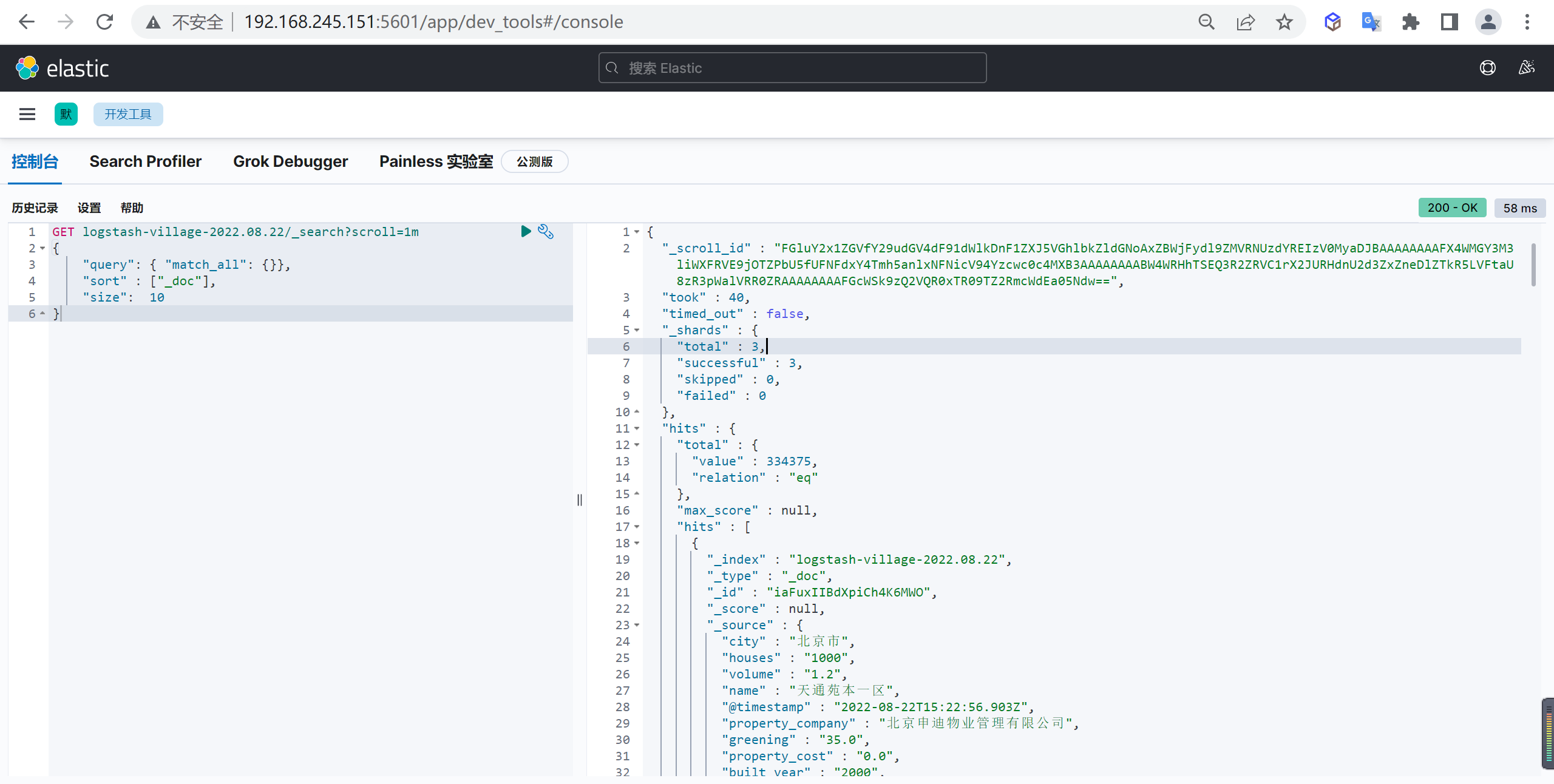

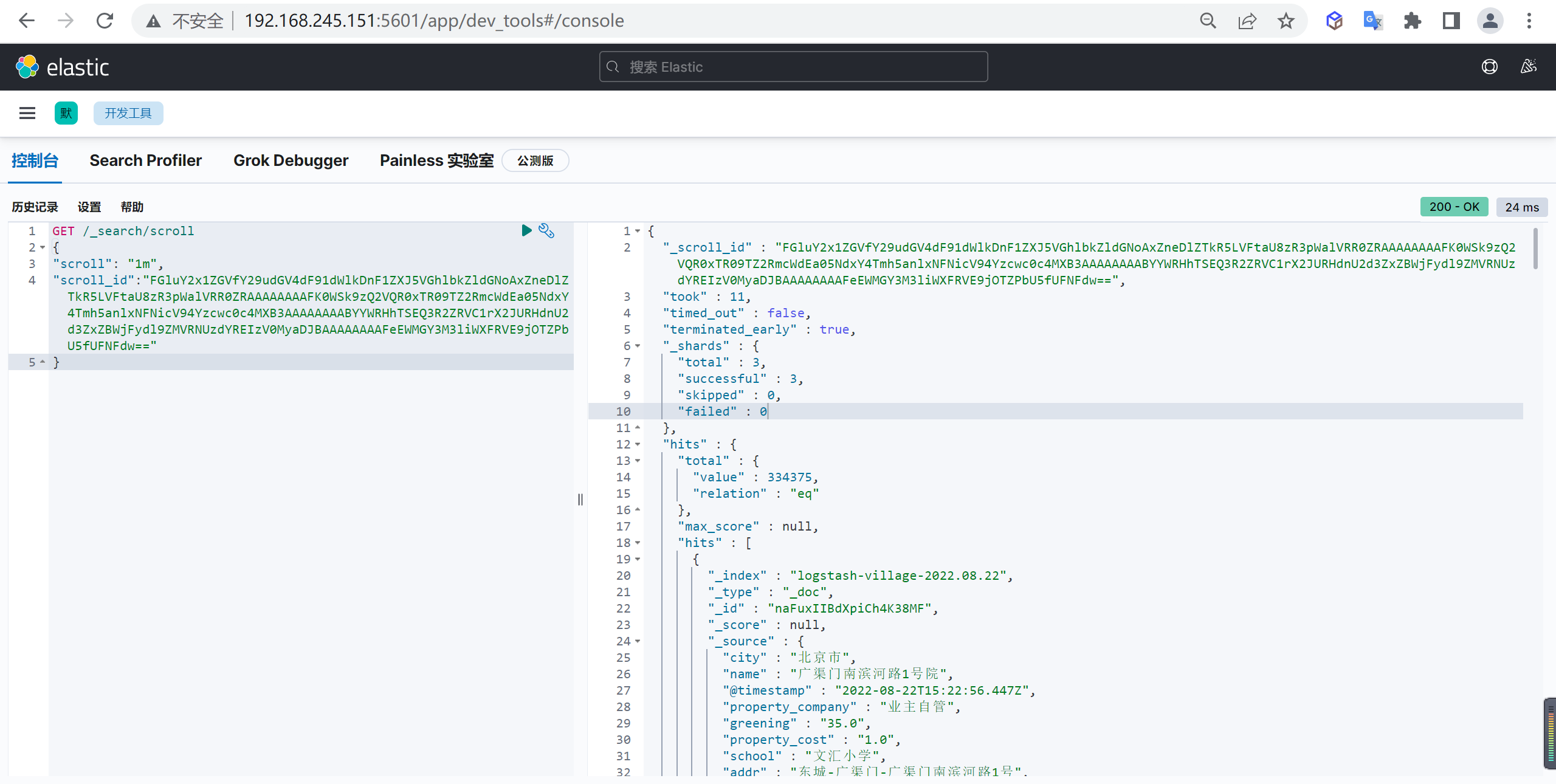

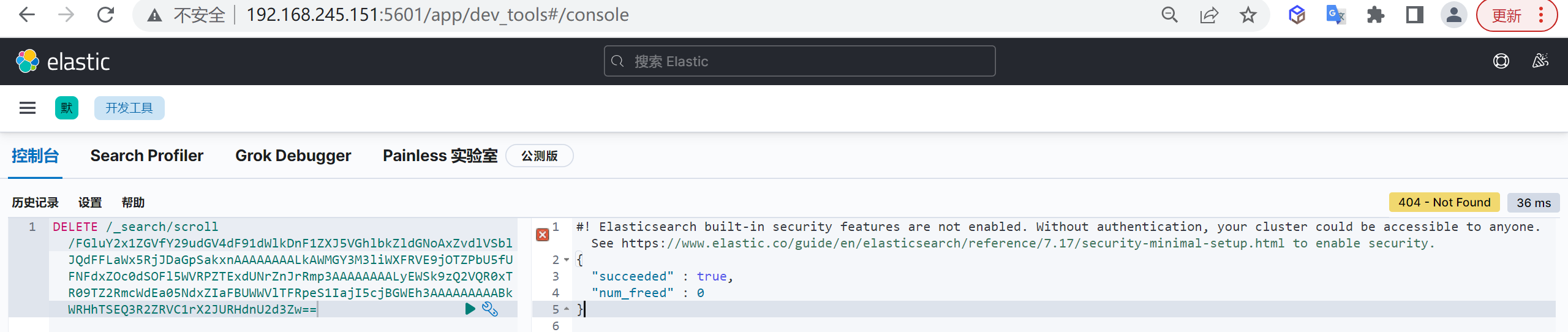

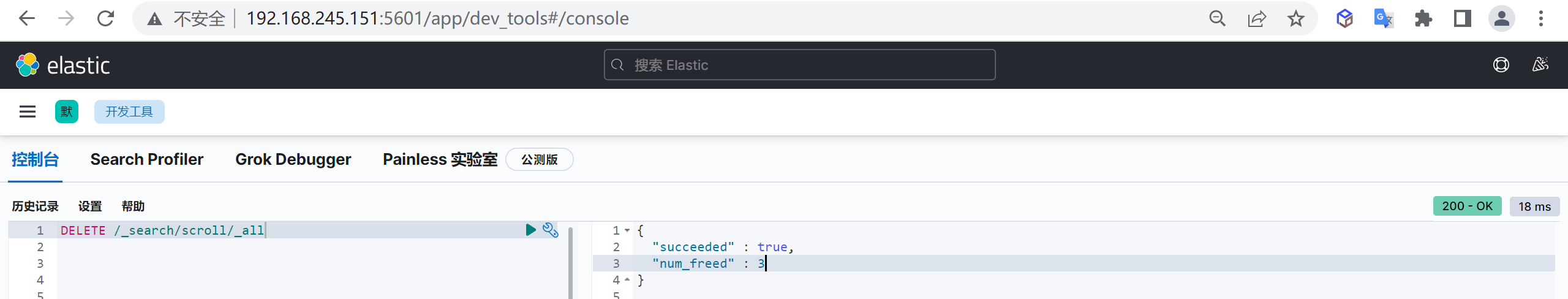

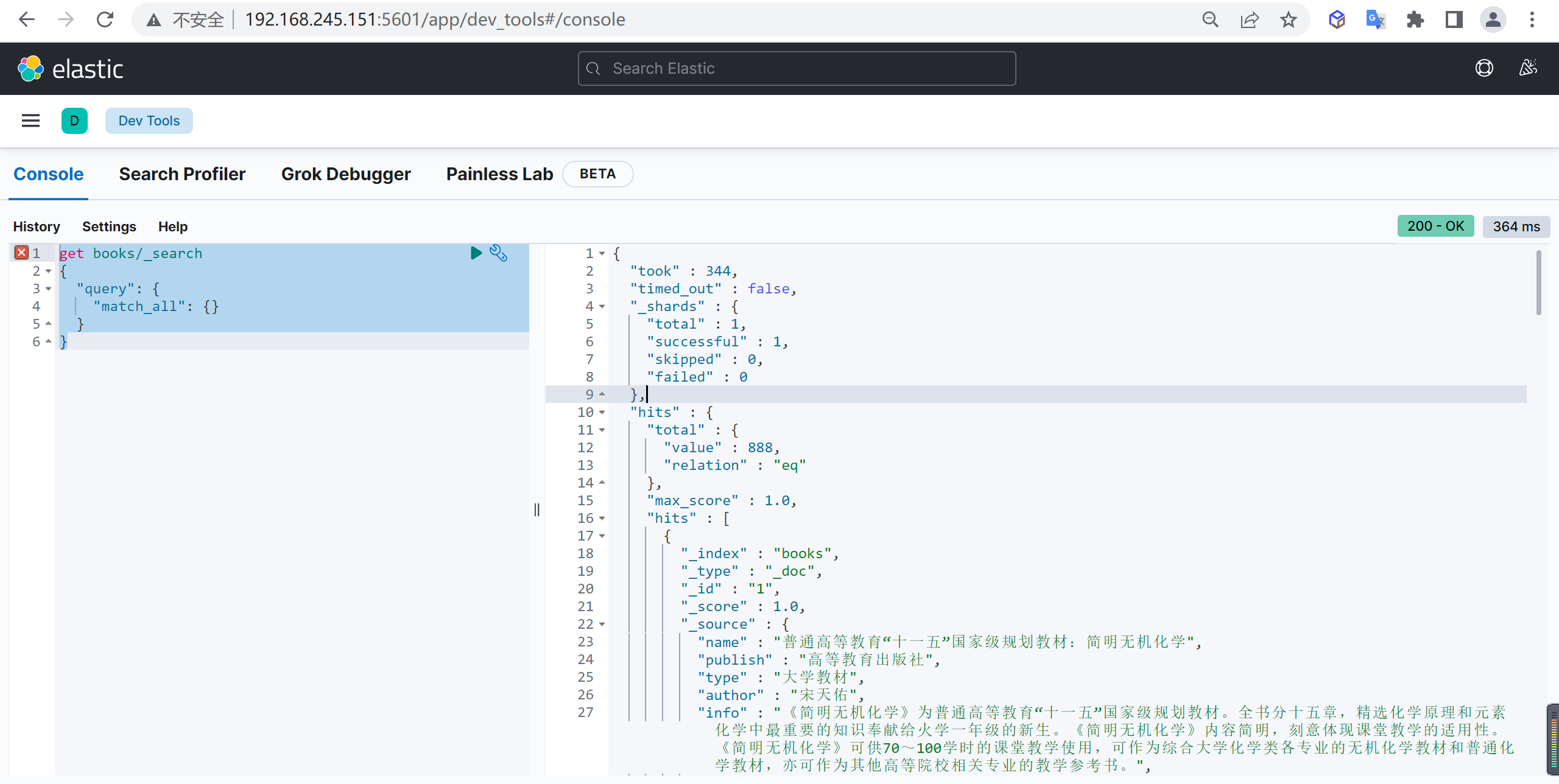

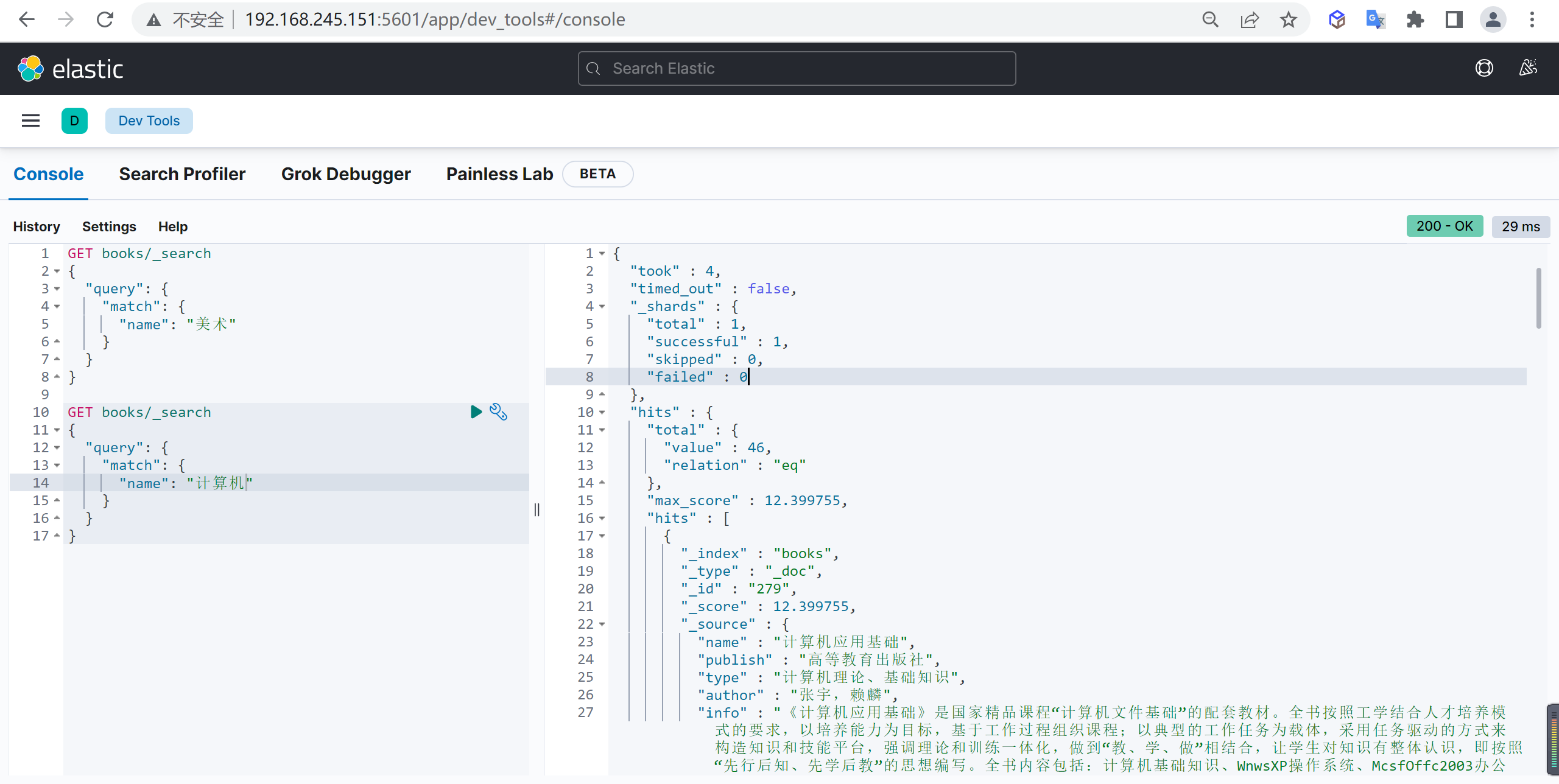

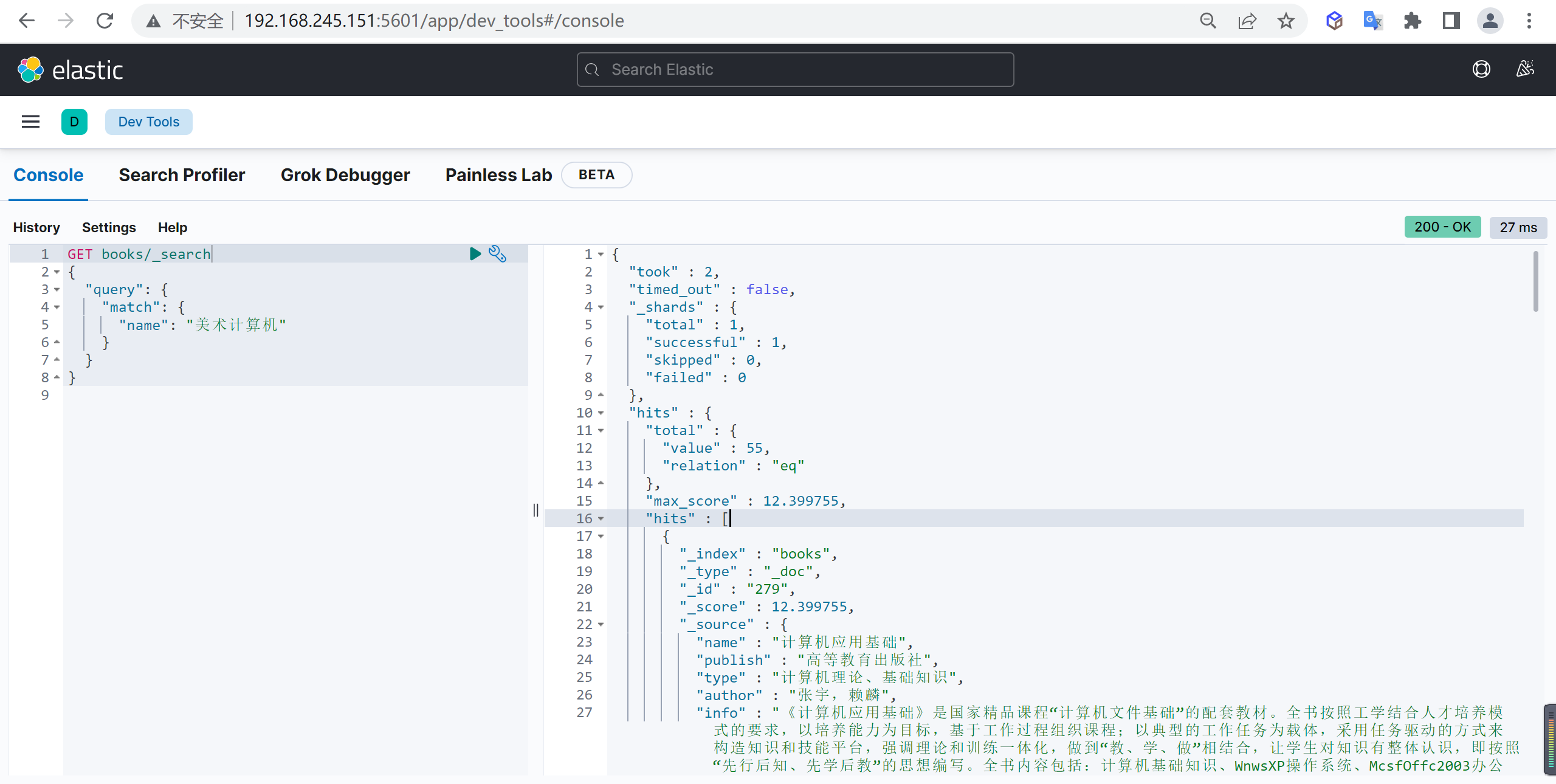

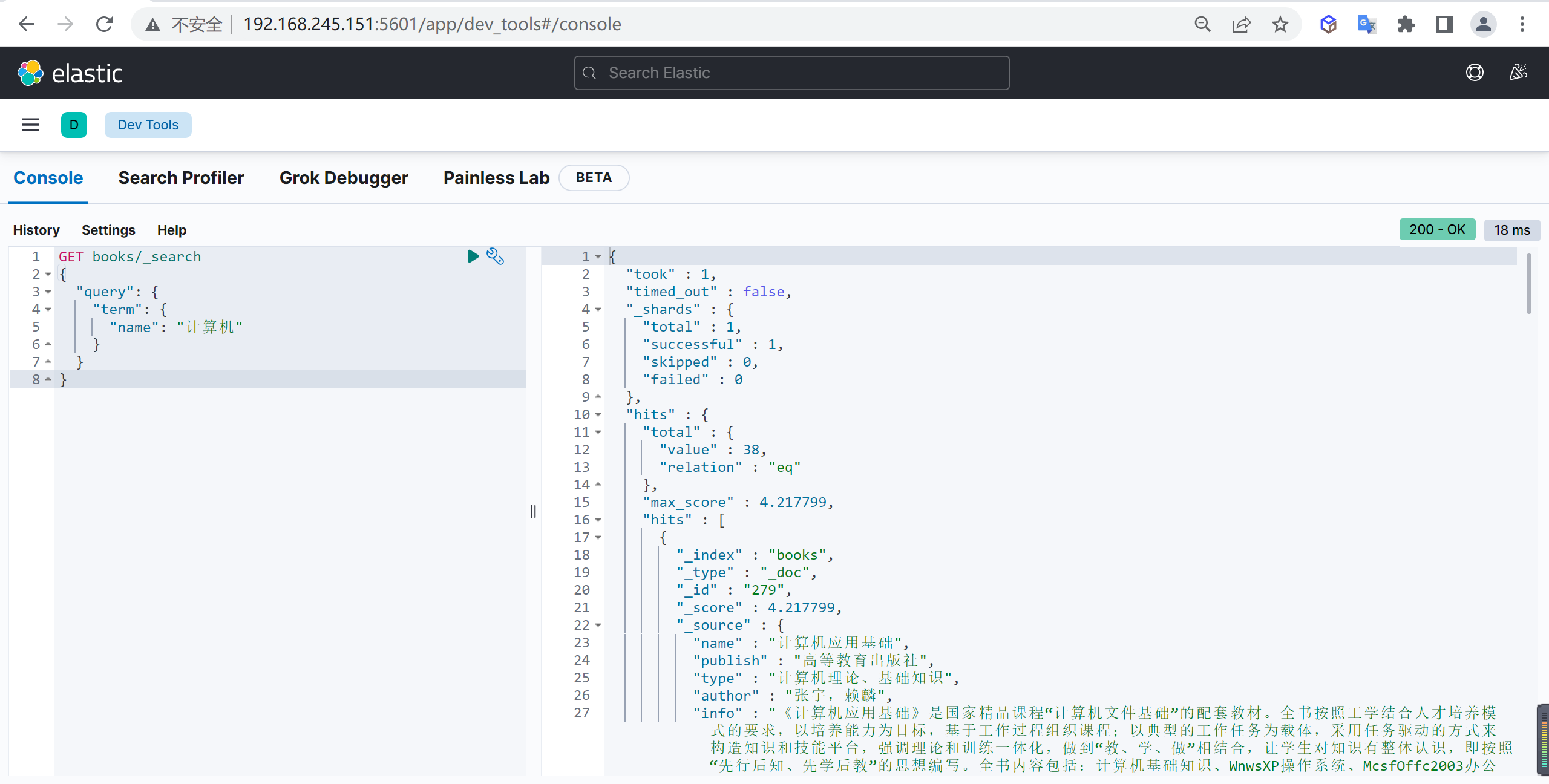

http://127.0.0.1:8080/api/import/crawler-data-4745655-1554808595755.xlsxKIBANA数据分析

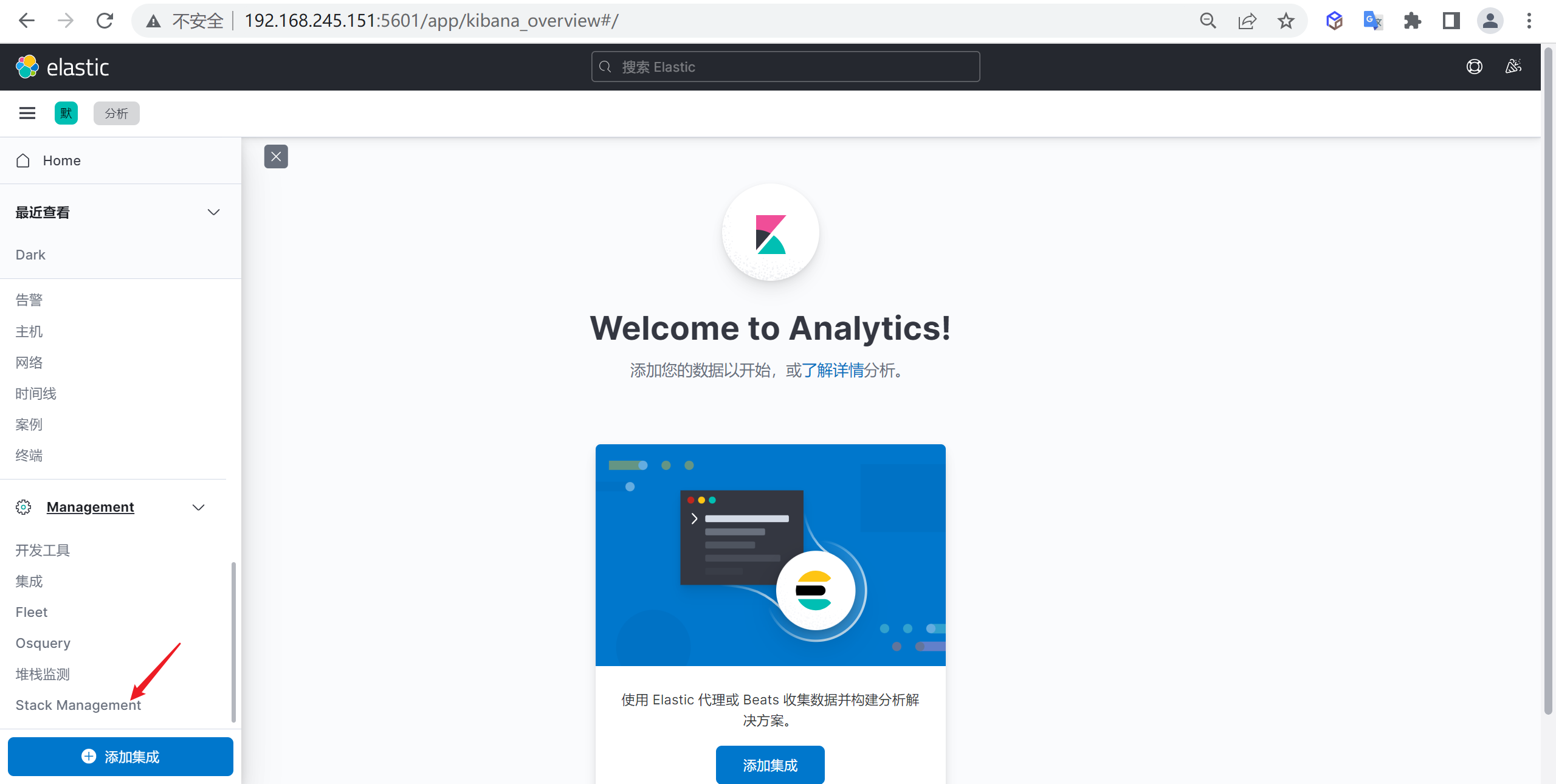

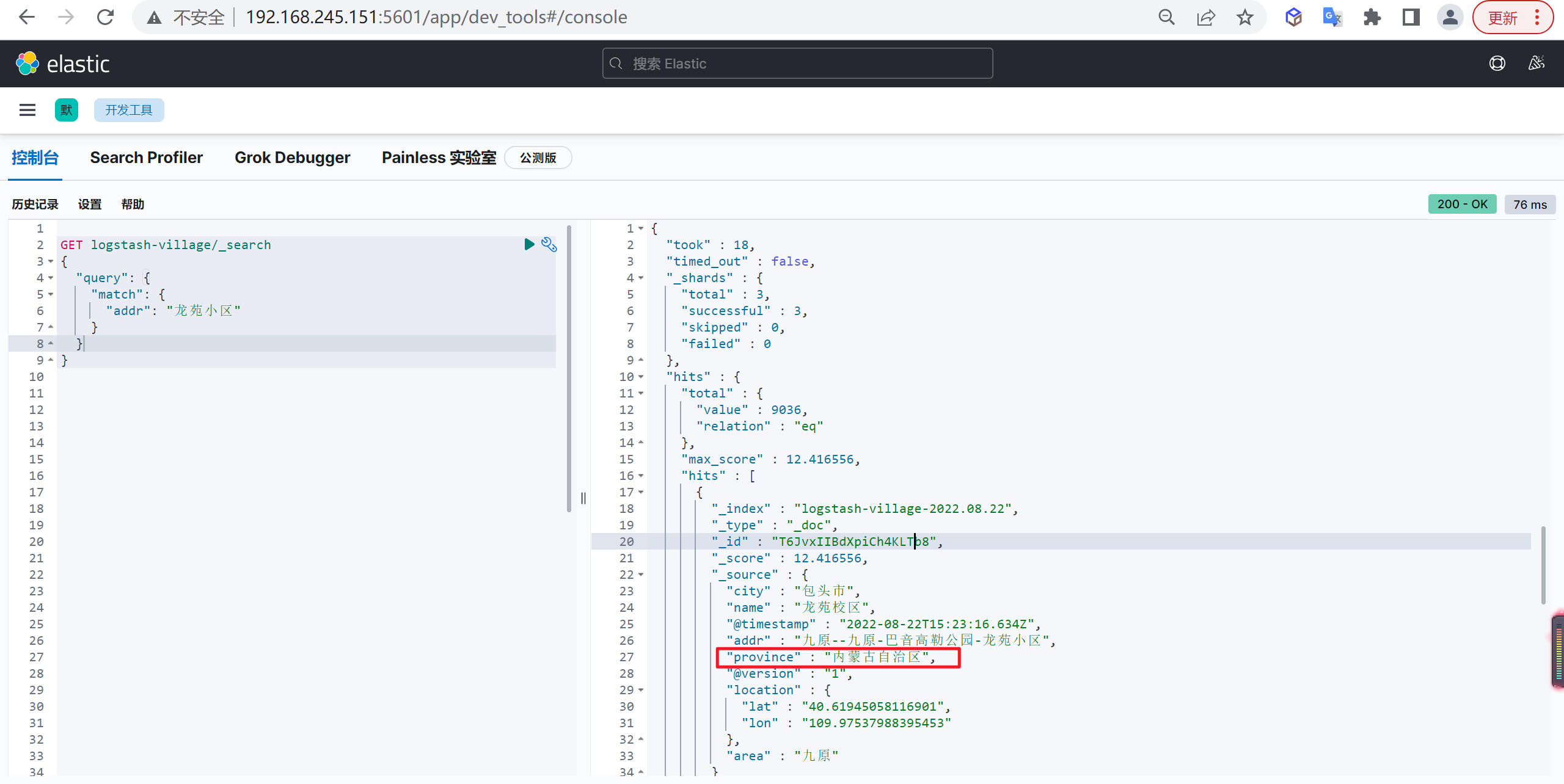

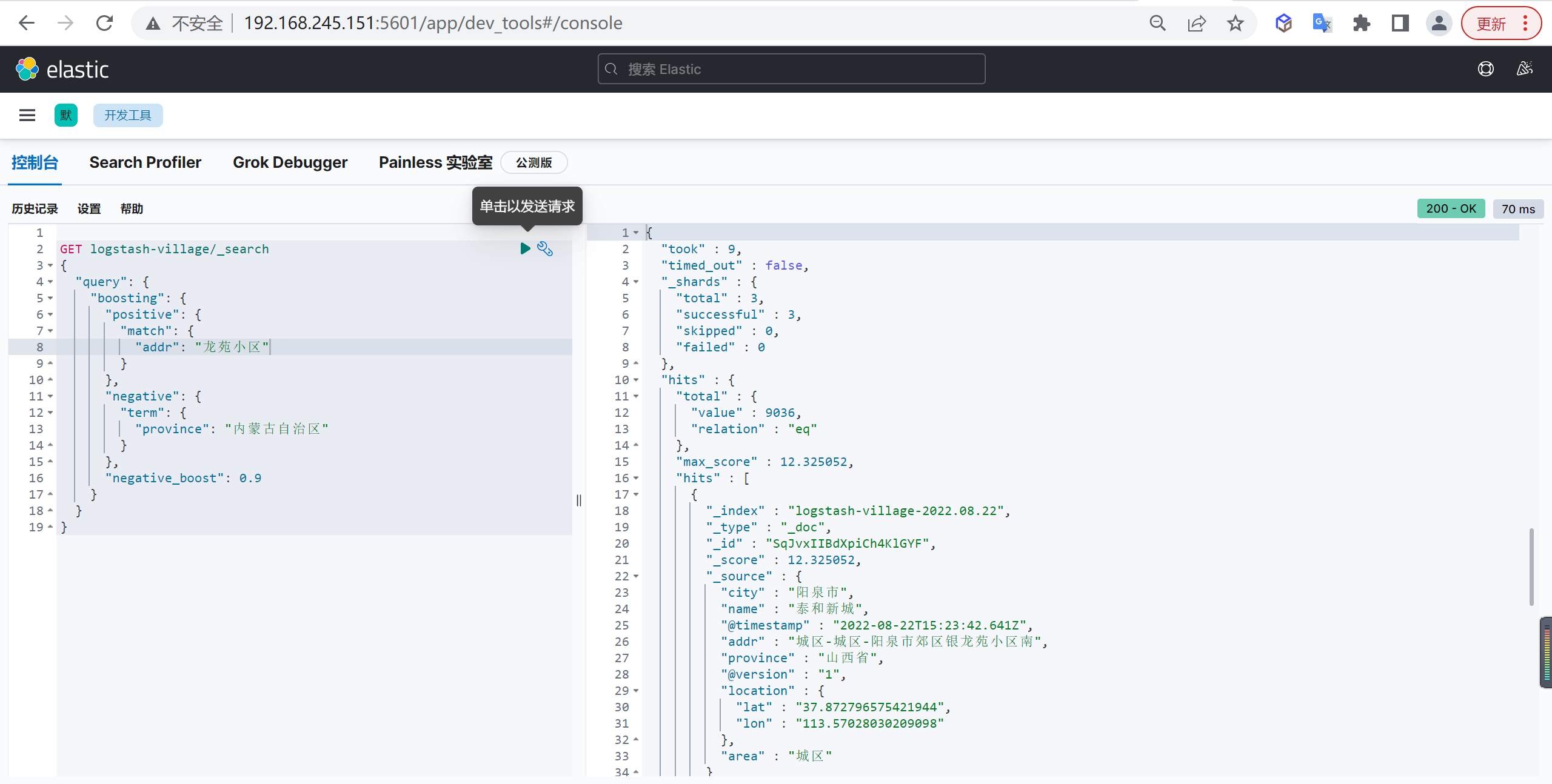

我们的数据已经导入到了ES中了,我们来对数据进行一波分析

管理索引

下面我们看下kibana如何进行索引管理

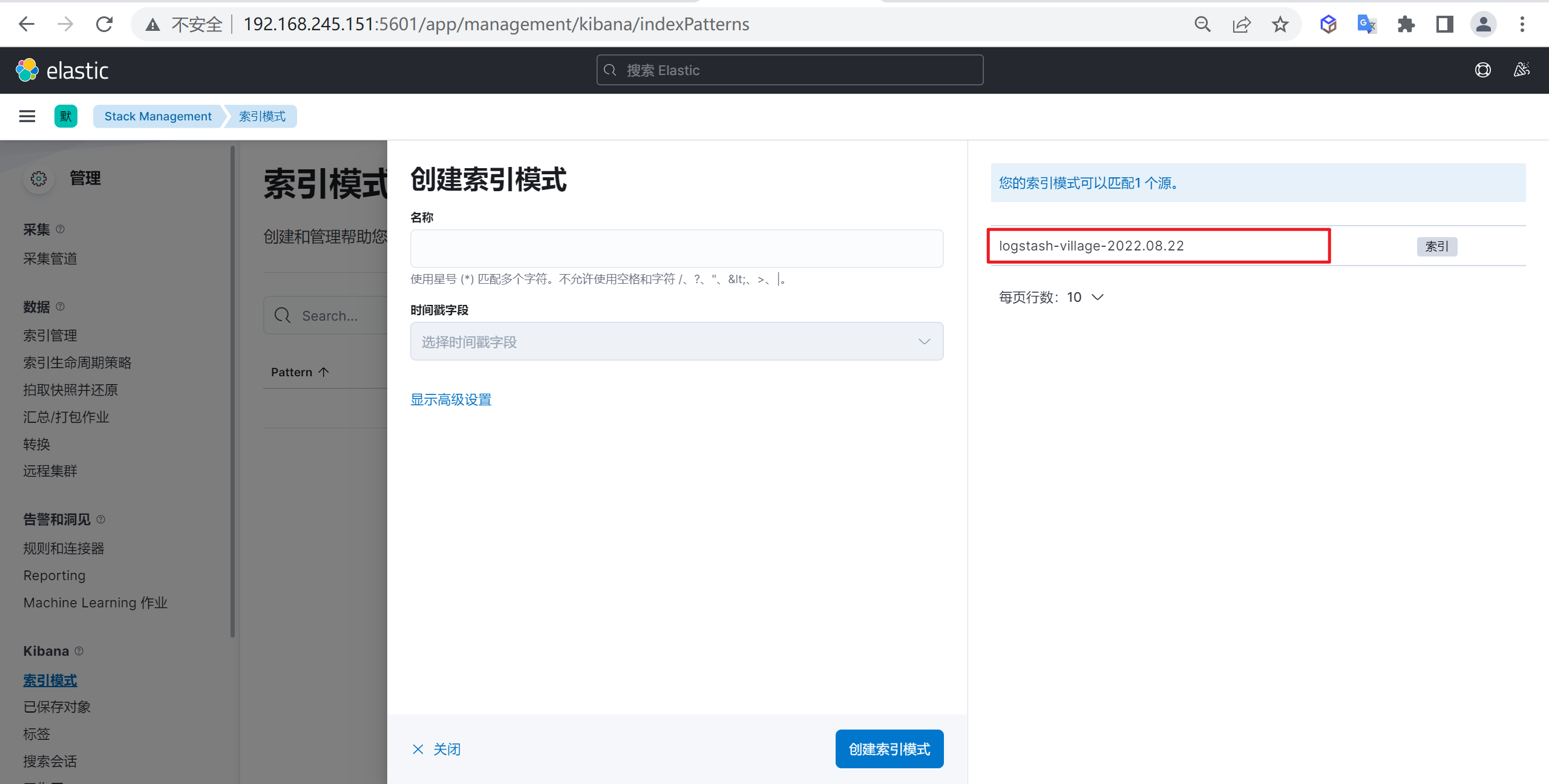

创建索引模式

进入索引管理

我们点击

Stack Management进入索引管理模块

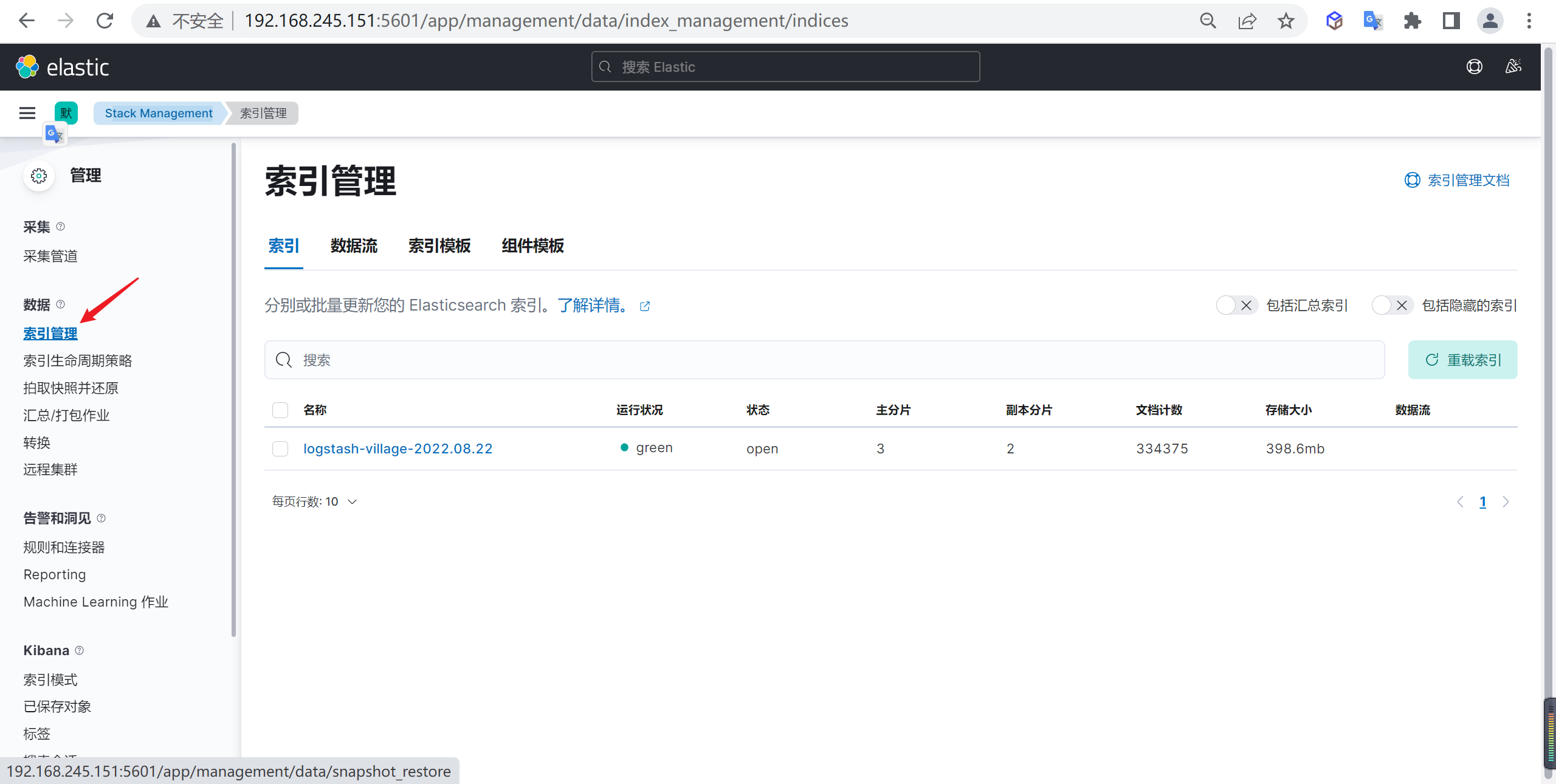

查看当前索引

进入管理模块后,点击索引管理,可以看到我们创建的索引

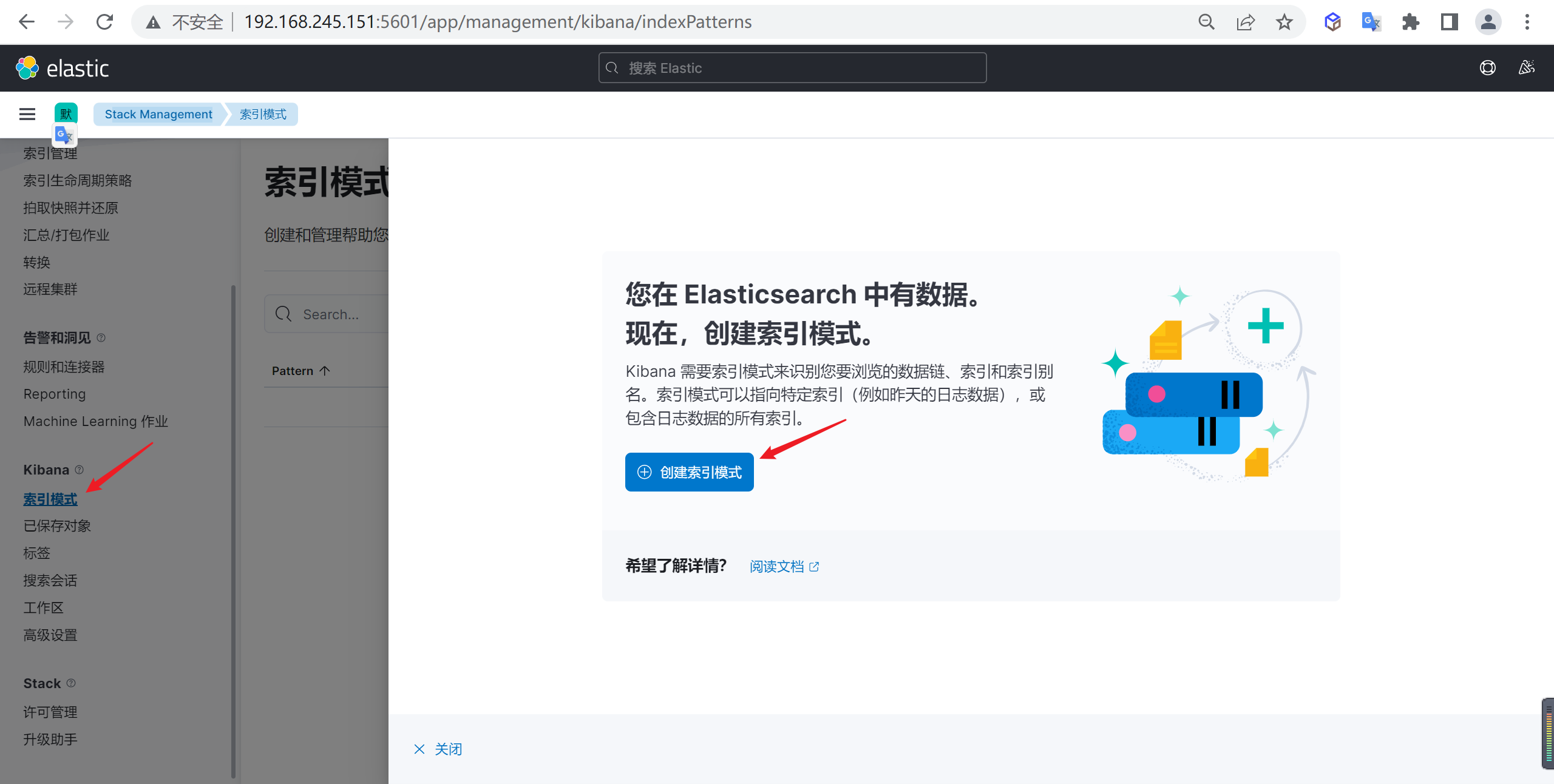

创建索引模式

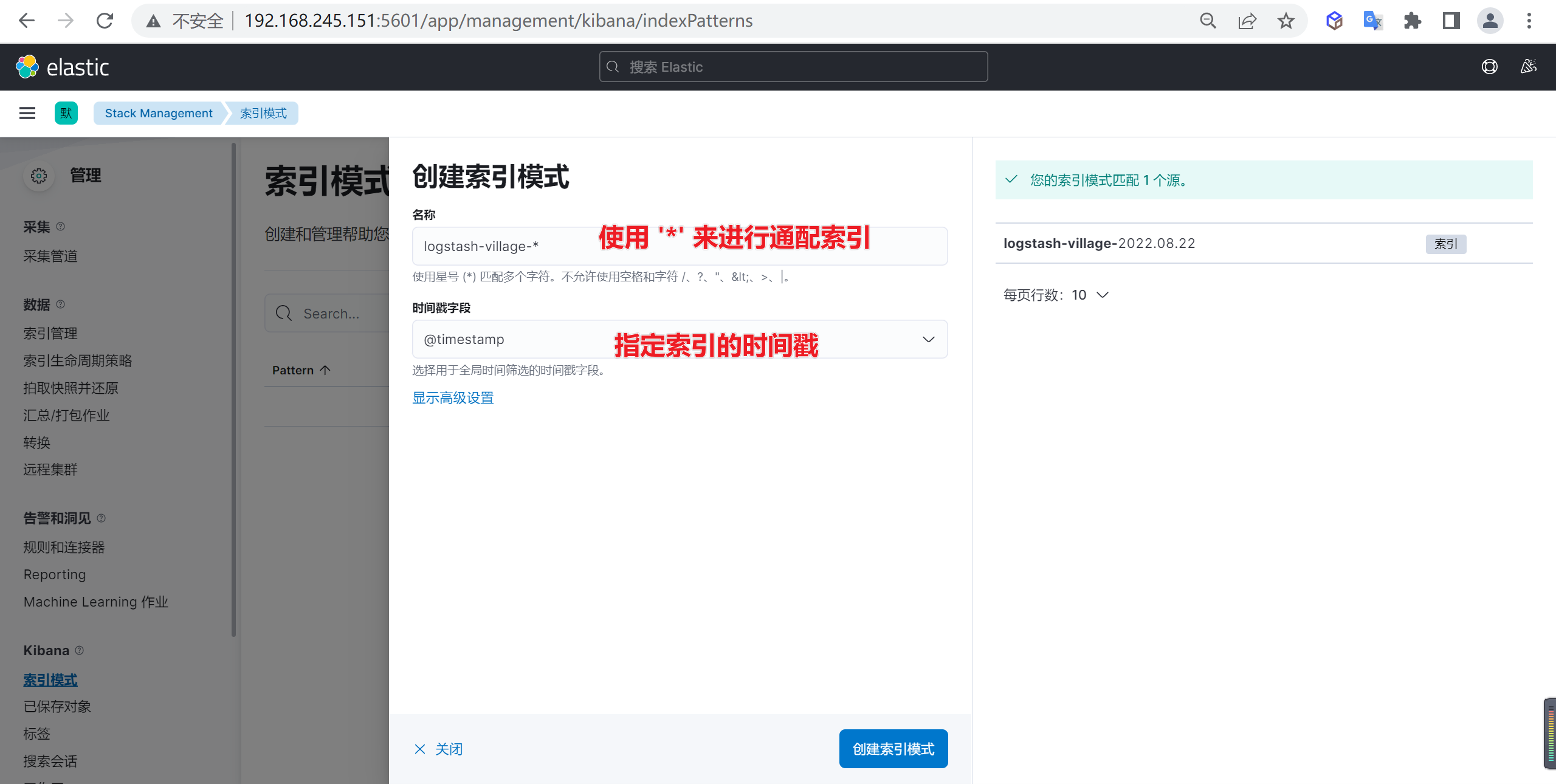

下面我们需要创建索引模式,因为当前的索引是一天一创建的,我们需要匹配所有的索引

进入创建索引模式后,接下来就是创建索引匹配模式,我们需要匹配的就是标红的索引

接下来就是创建索引模式,我们使用通配符的方式来进行创建

确定后我们就创建了一个索引模式,在这里我们可以编辑或者转换ES的字段

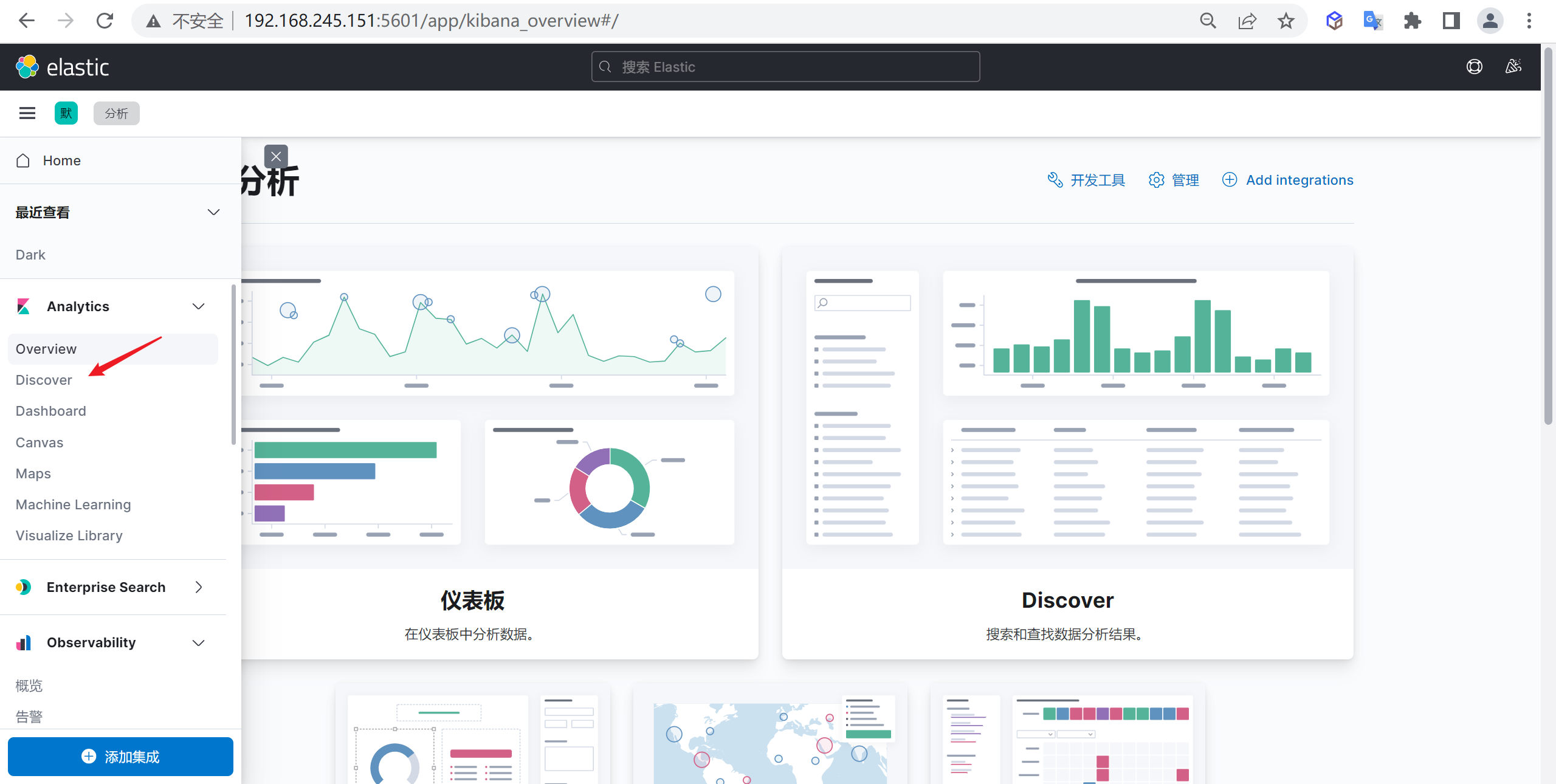

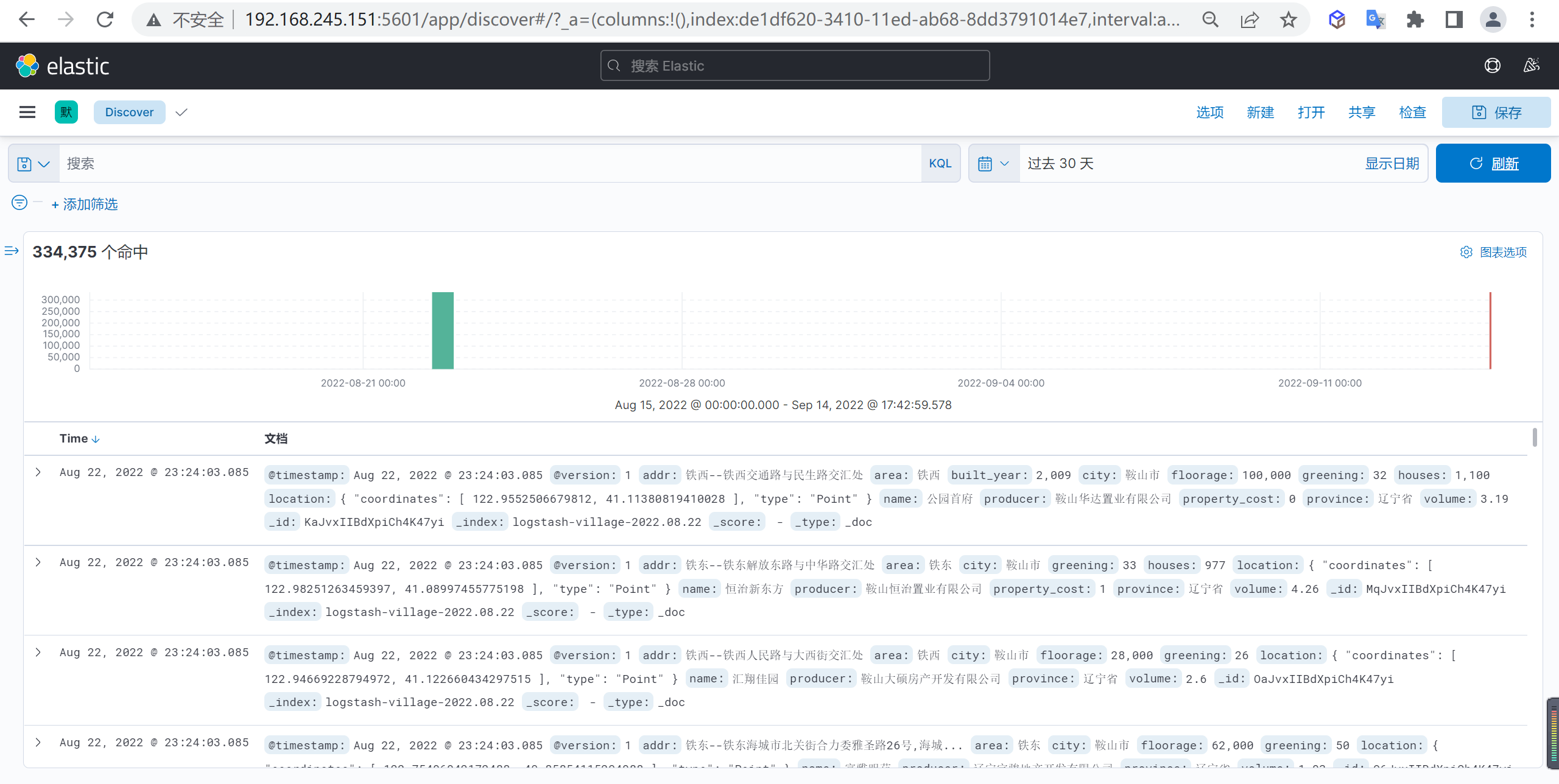

查看索引数据

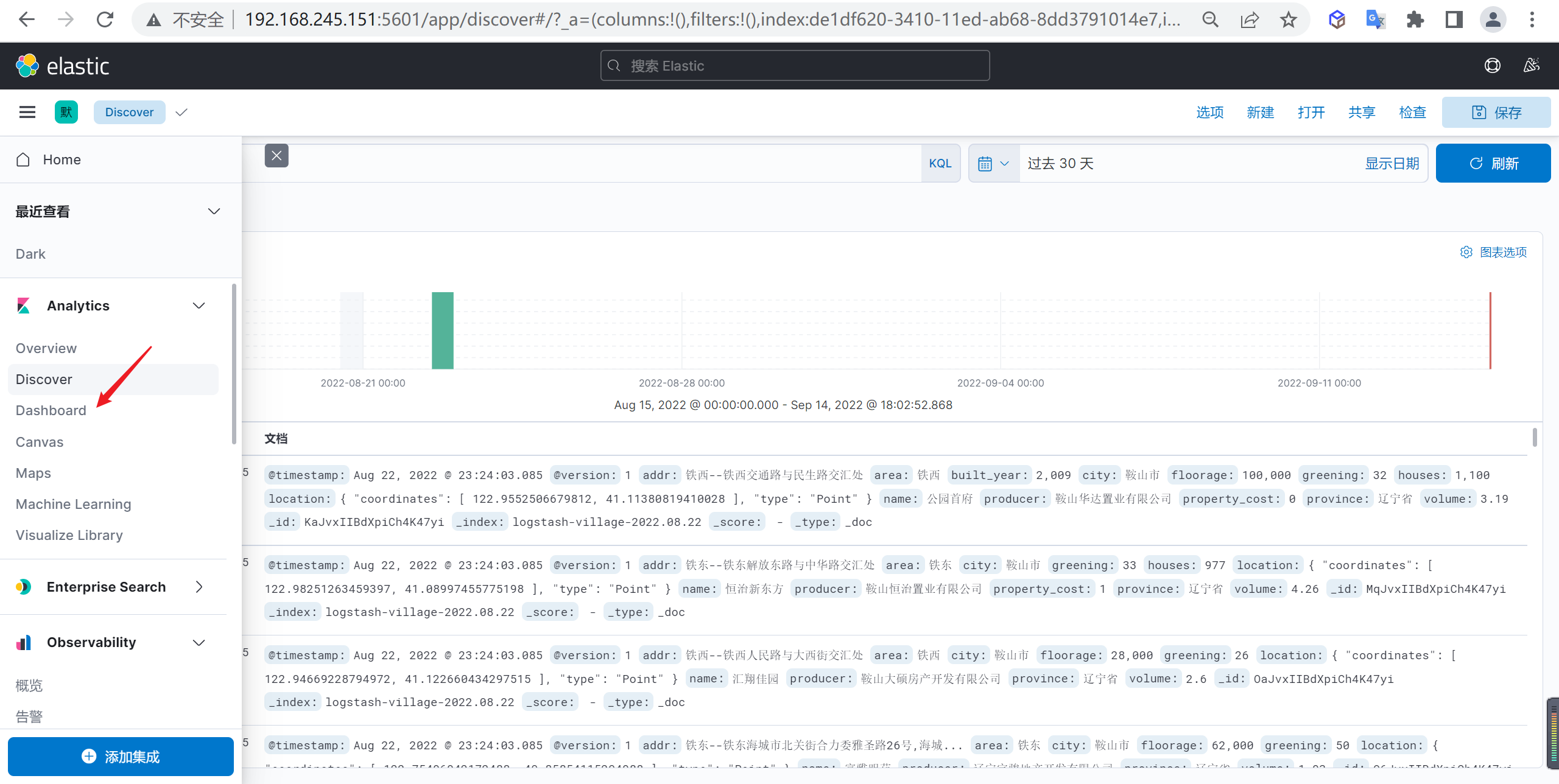

我们点击

Discover就可以查看索引数据

如果看不到可以选择不同的时间范围

数据分析

接下来我们就按照这些数据进行一些图表分析

柱状图示例

下面我们演示以下柱状图,我们统计以下按照省份统计下个省份的总住户数量

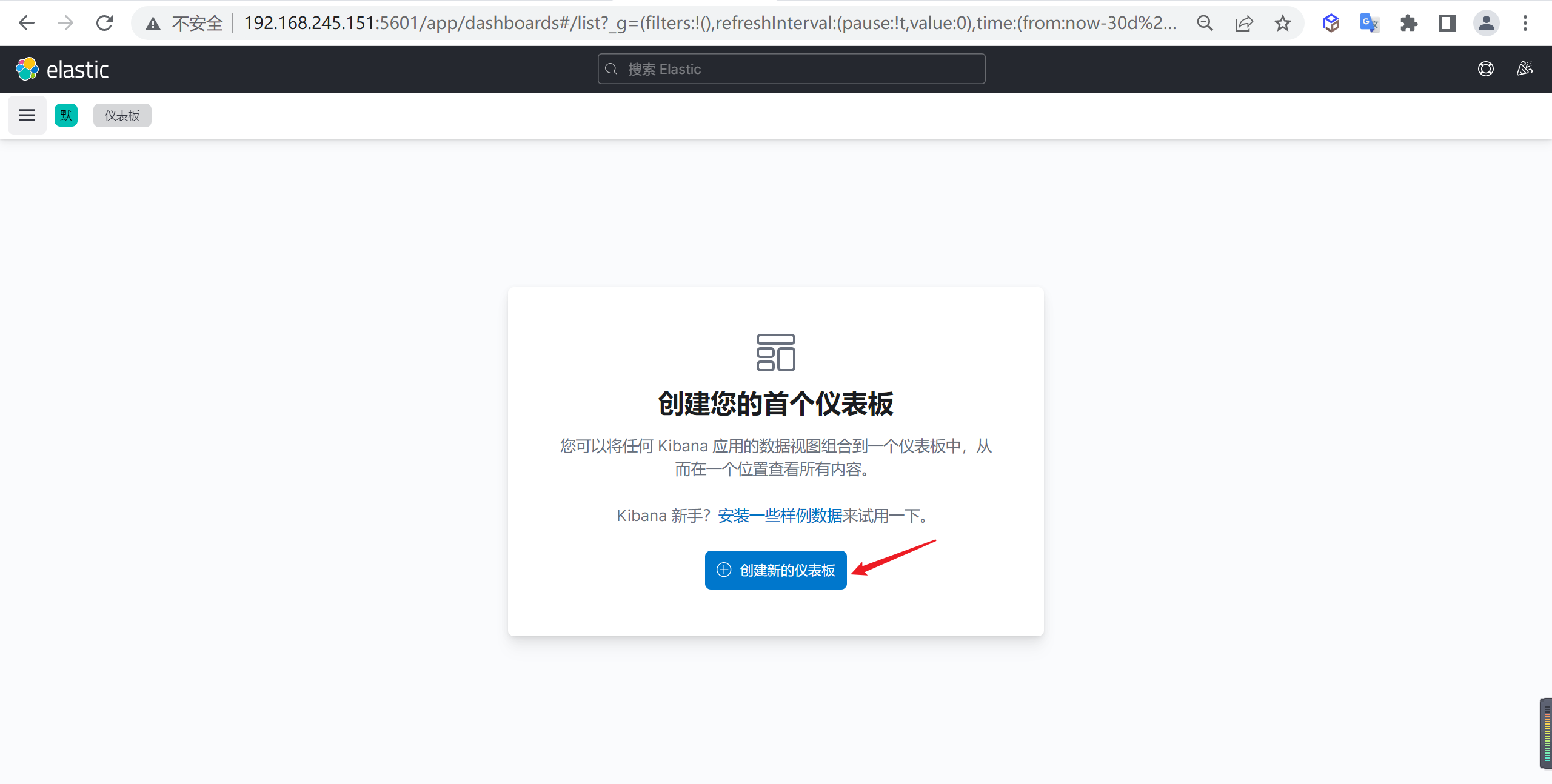

打开仪表盘

下面我们需要到点击进入仪表盘管理节点

点击创建仪表盘

点击创建仪表盘,进入仪表盘管理界面

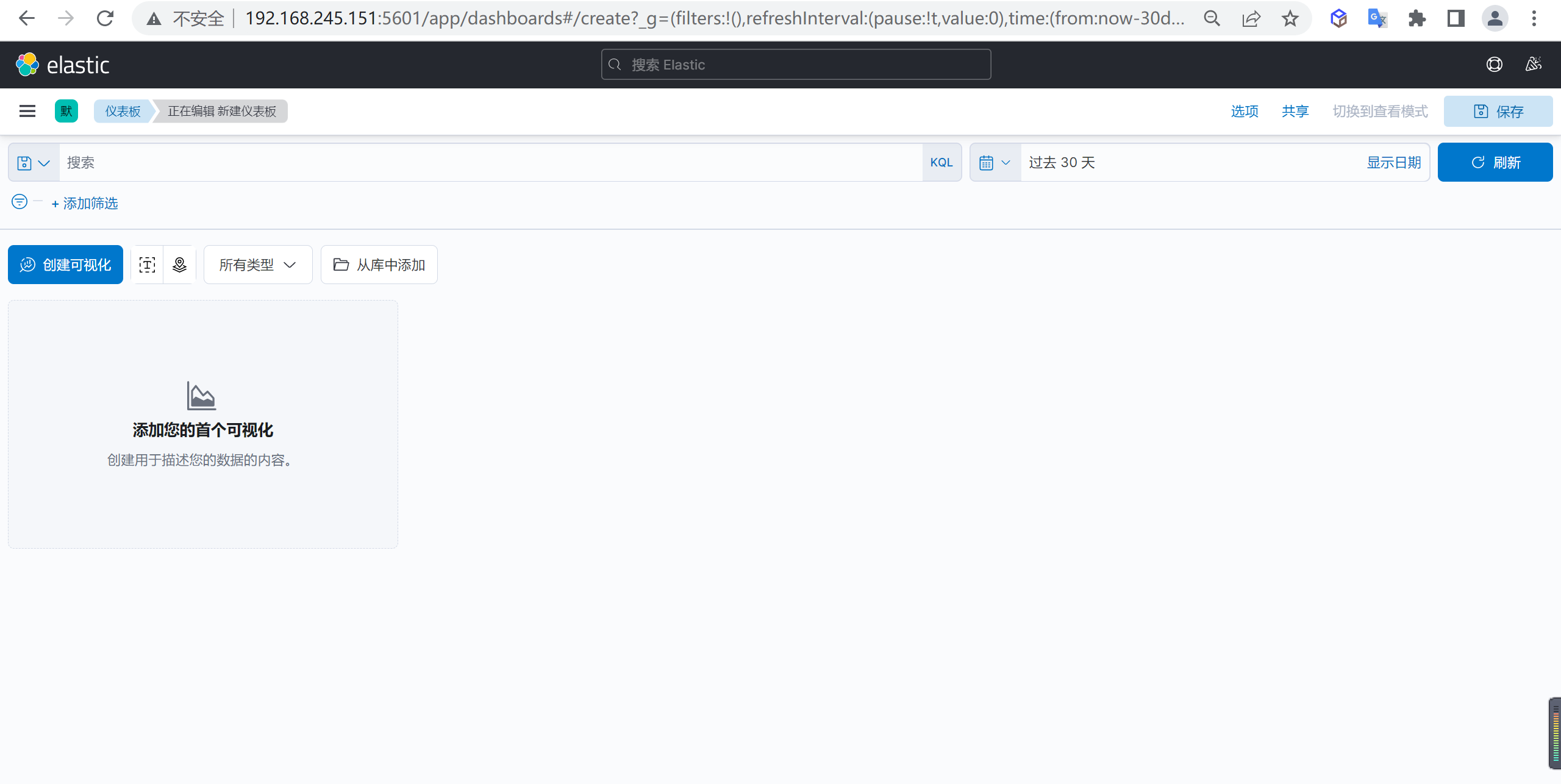

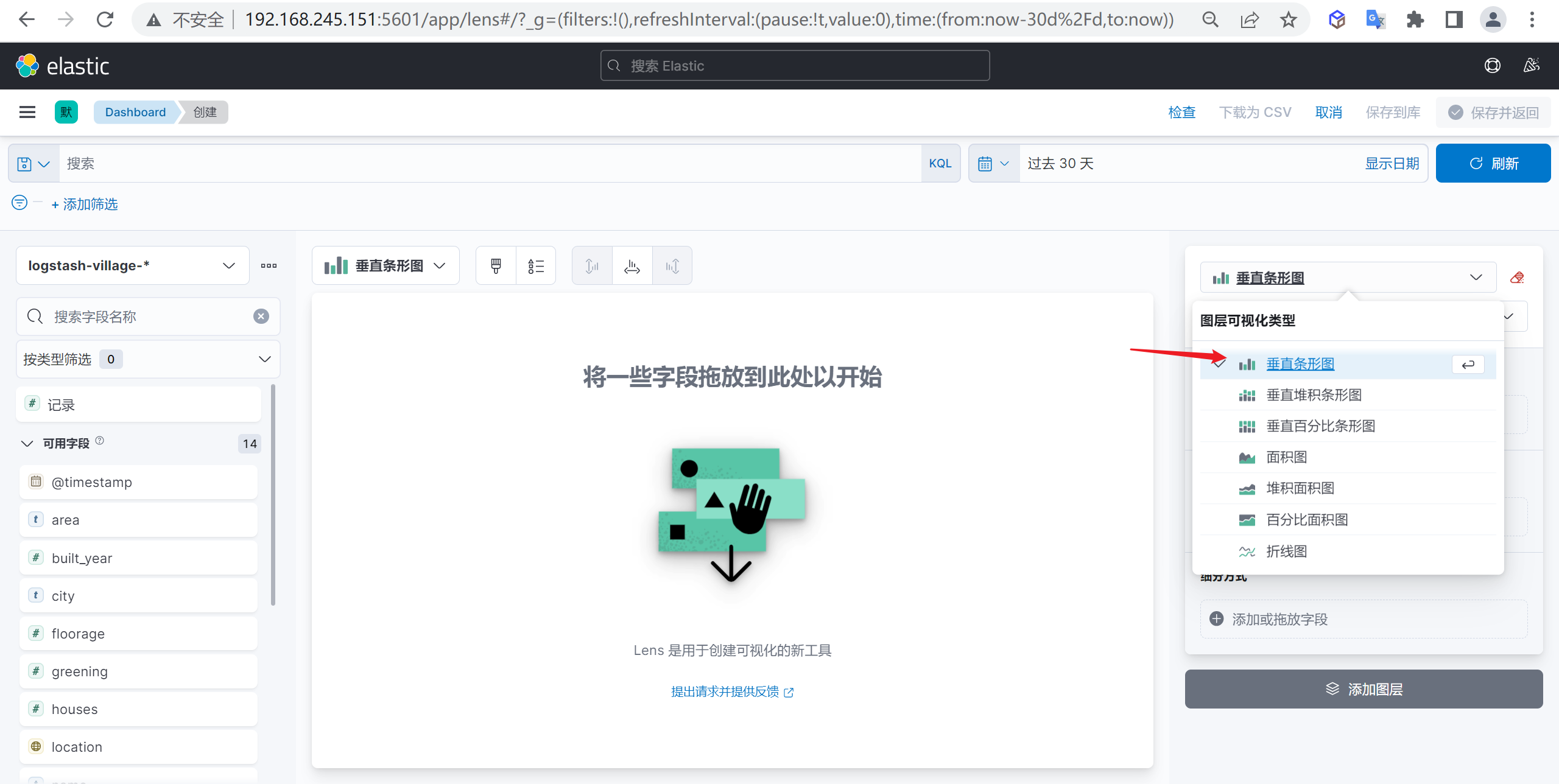

创建柱状图

点击

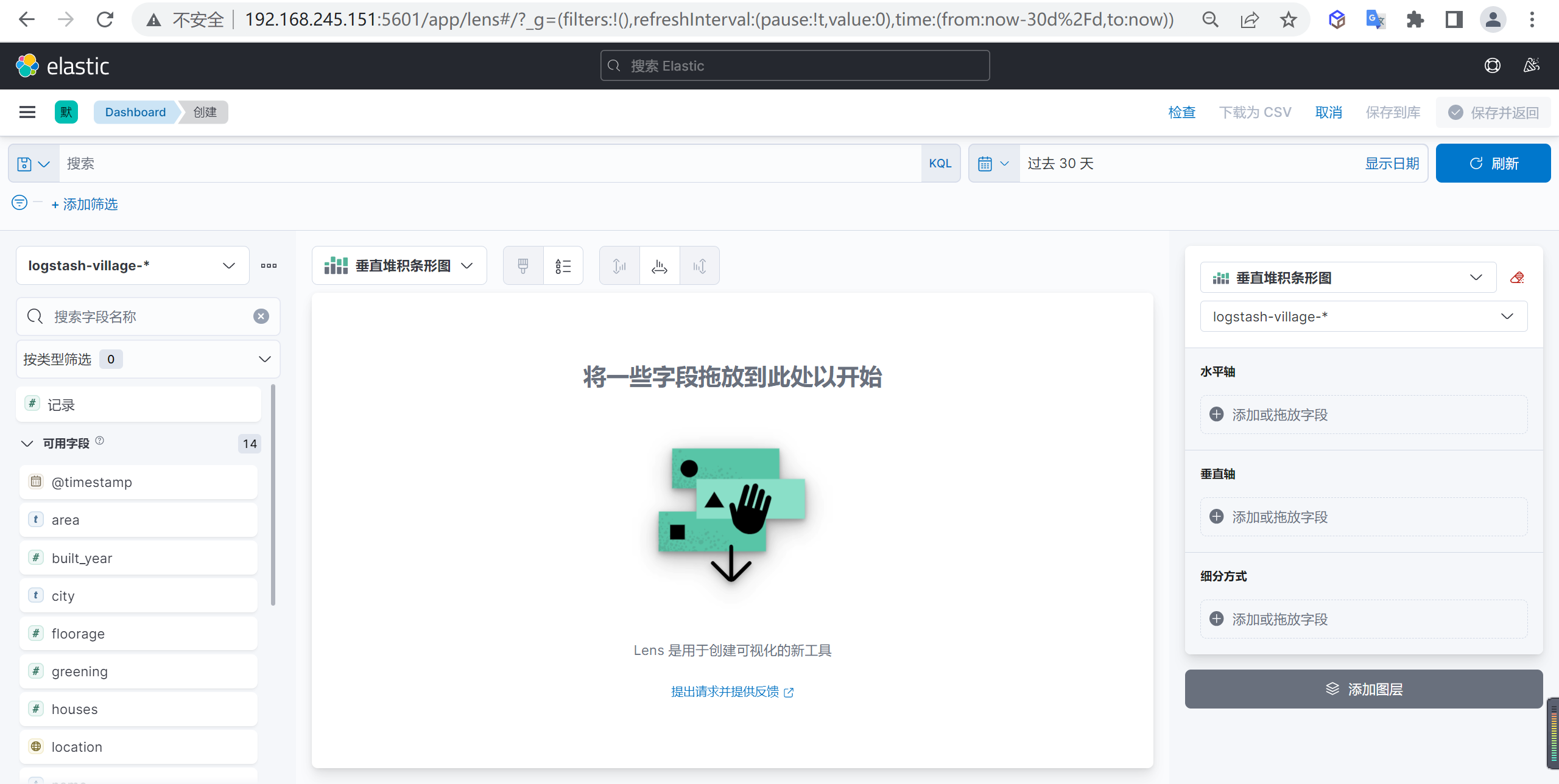

创建可视化我们就会打开一个可视化的管理界面

并且在这个管理界面选择对应的图形就好

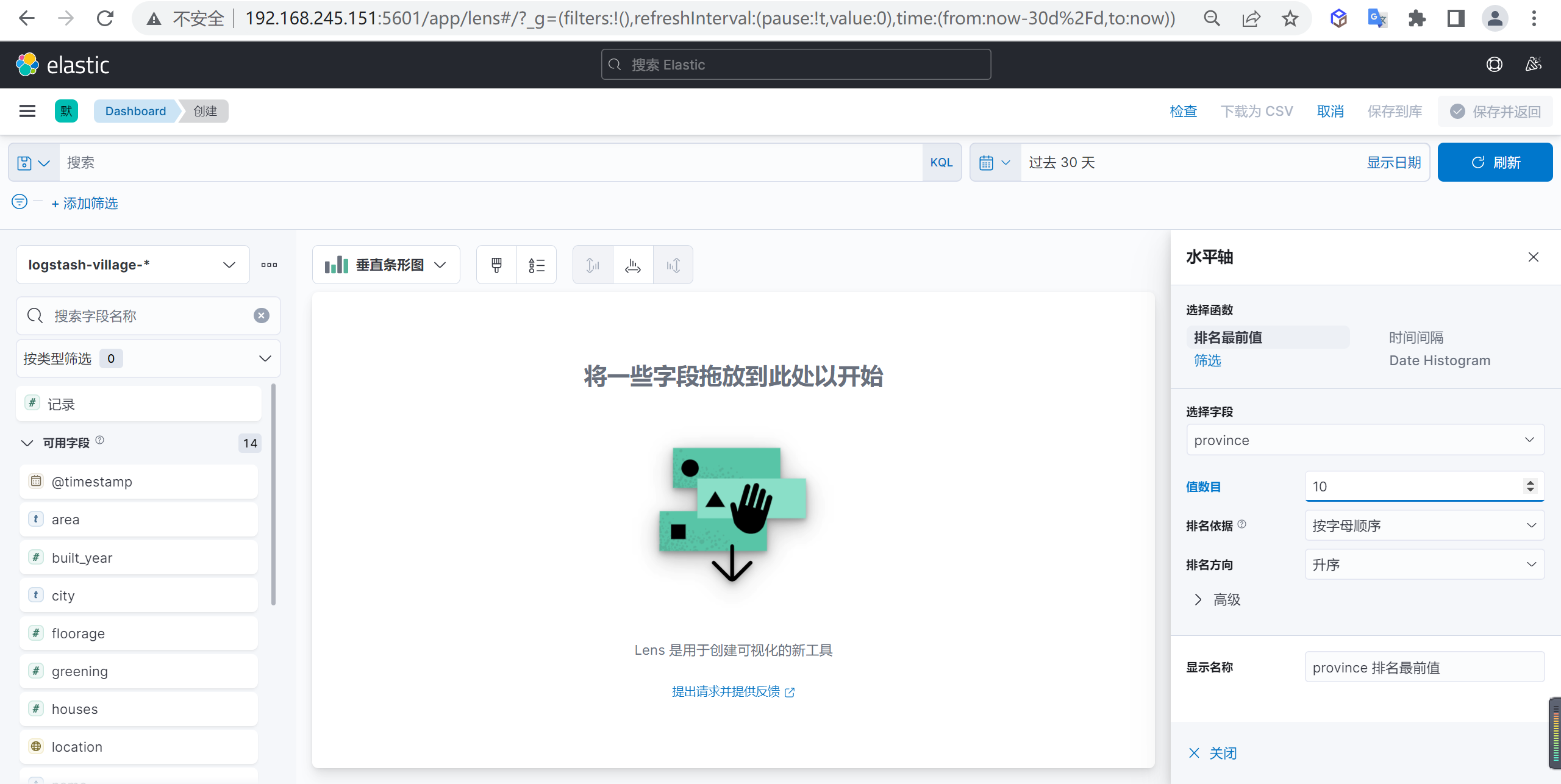

水平轴数据配置

我们先配置水平轴的数据,选择

省份字段作为水平轴的参数

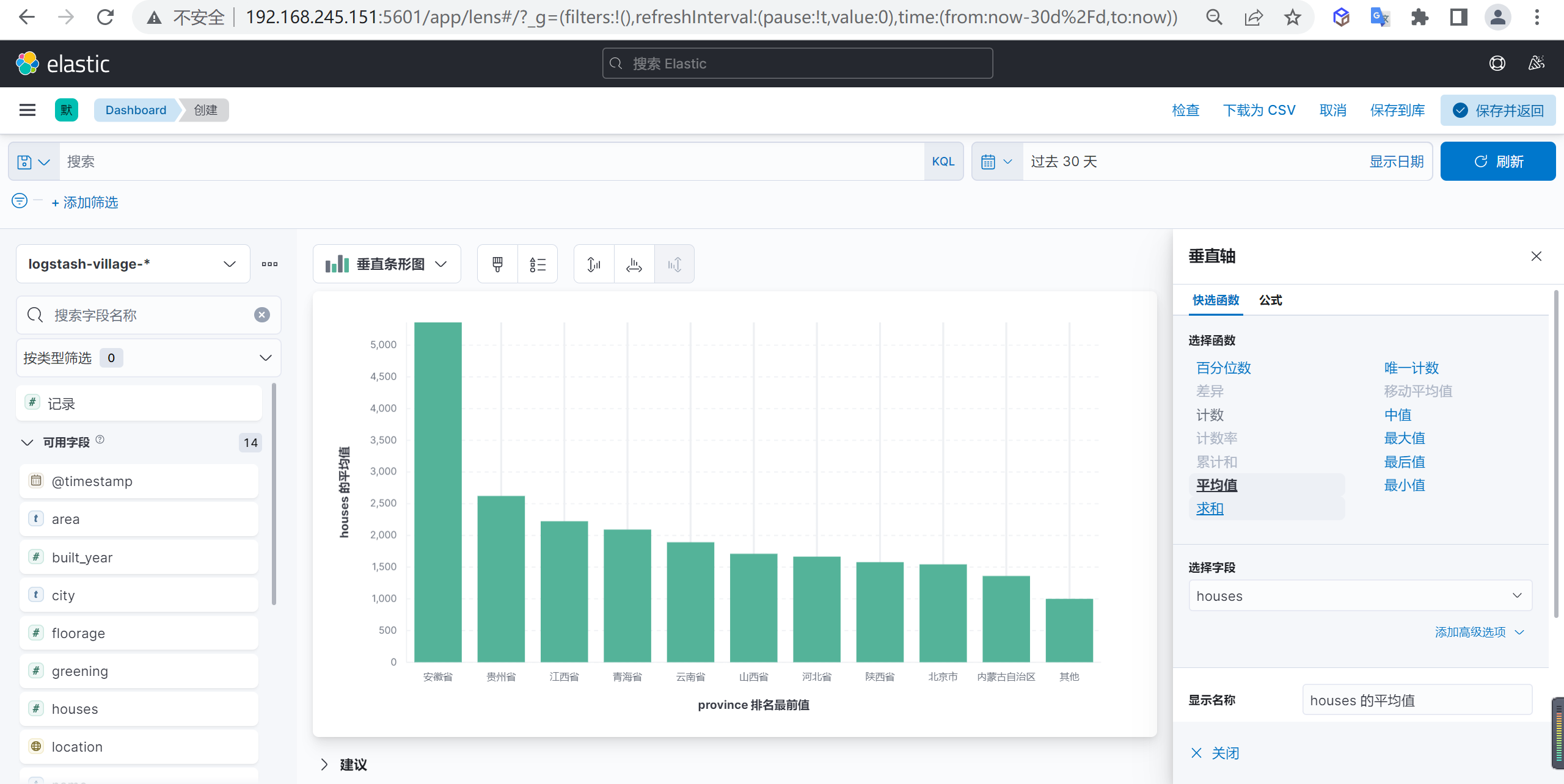

垂直轴数据配置

下面我们还需要配置垂直轴的数据,我们设置

总户数的平均值作为参数

查看数据

这样我们就可以进行分析数据了,我们看到安徽省是小区住户平均数量最多的省份

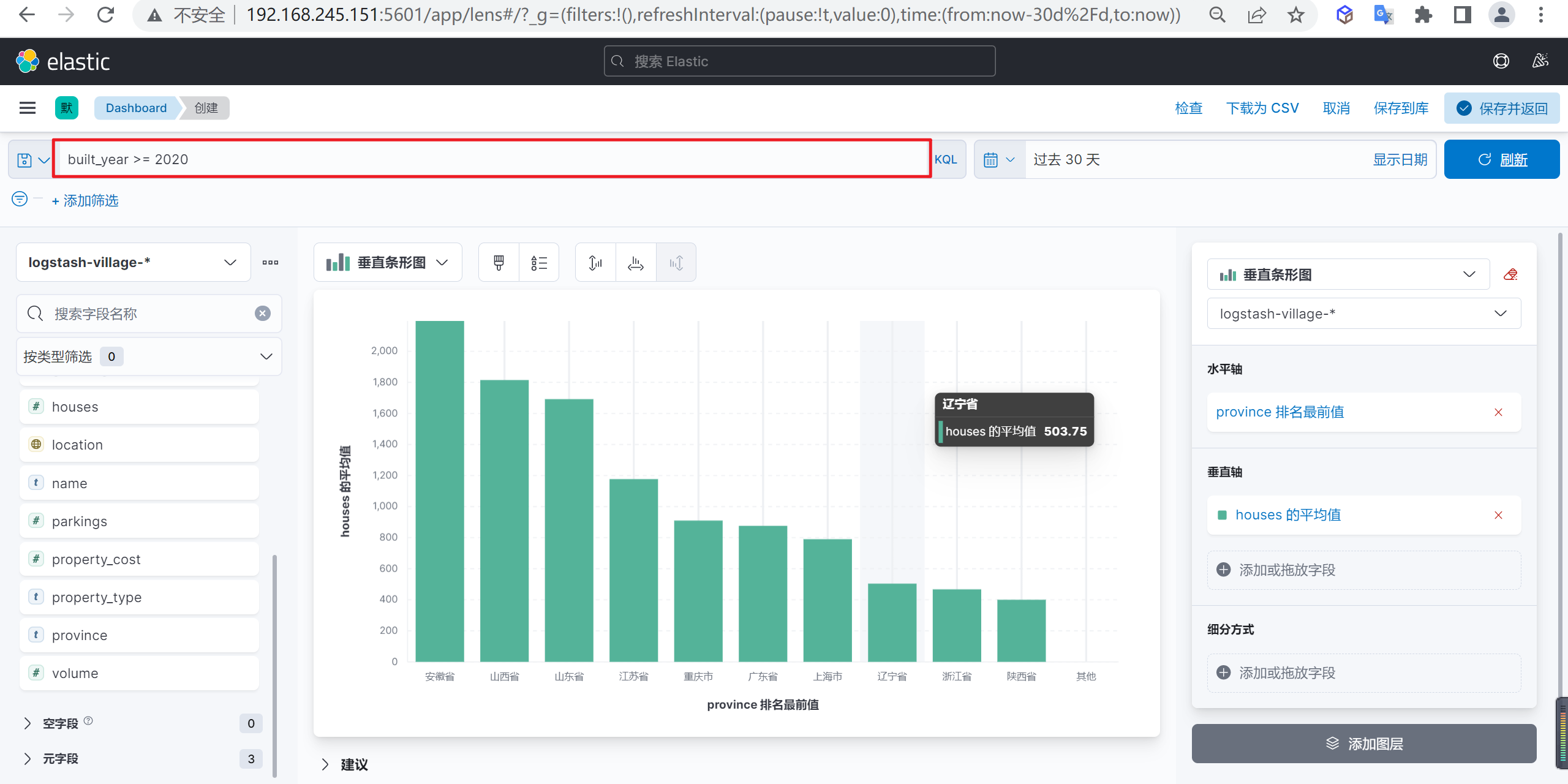

筛选数据

我们筛选以下2020年以后新建的小区住户平均数量最多的省份,我们可以使用表达式

built_year >= 2020进行筛选

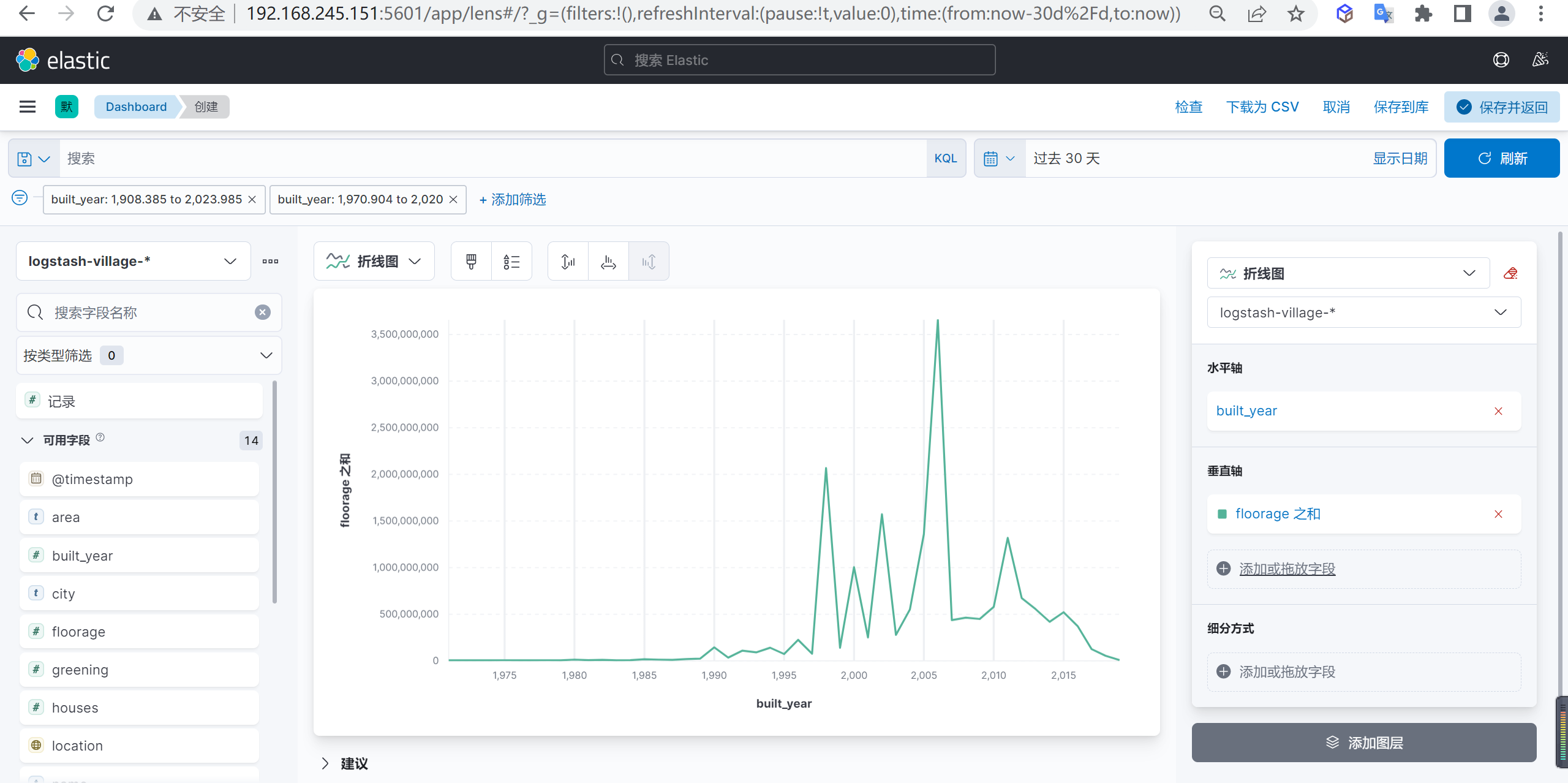

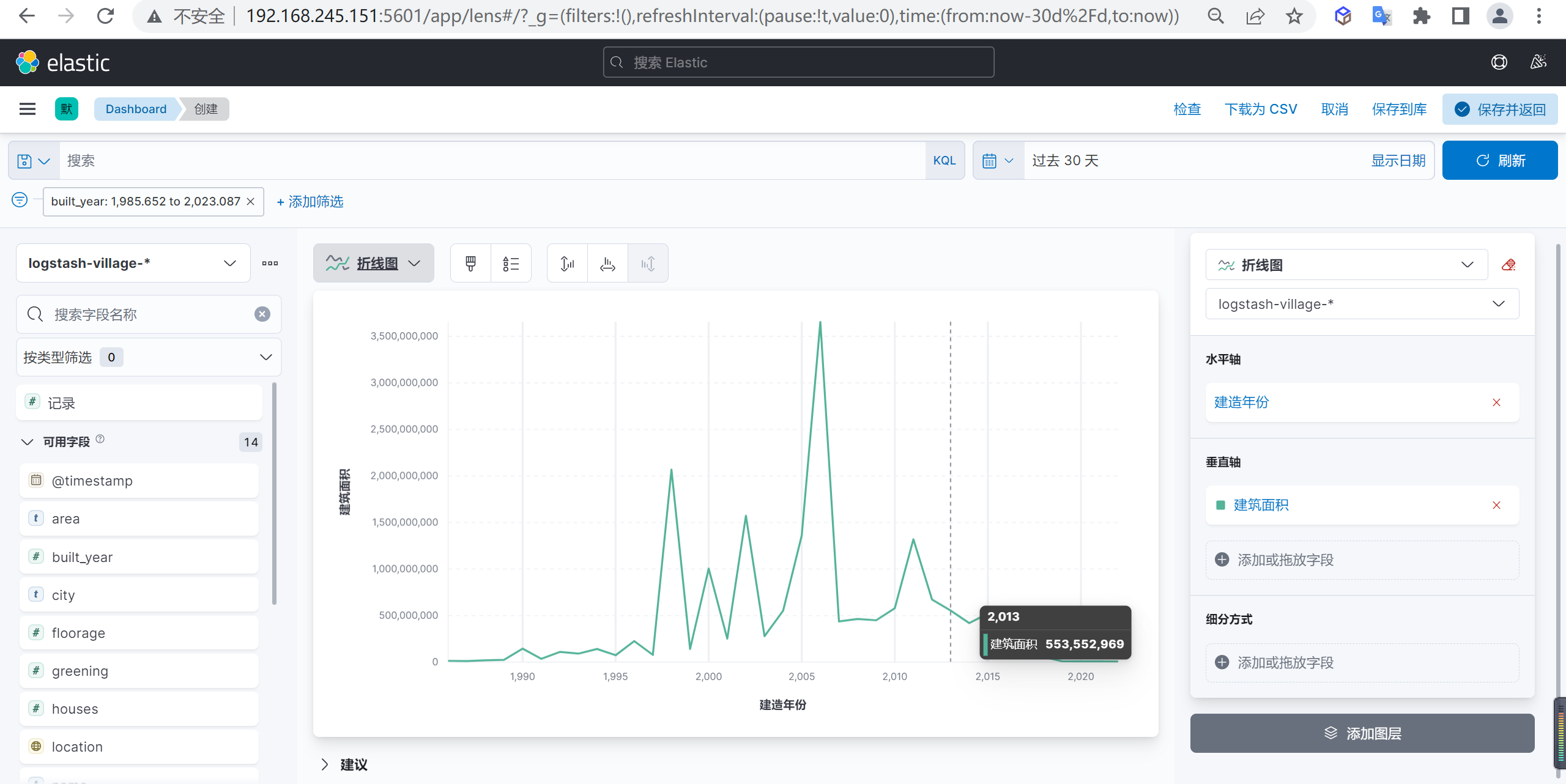

折线图示例

我们分析下全国每年小区新建面试的走势图

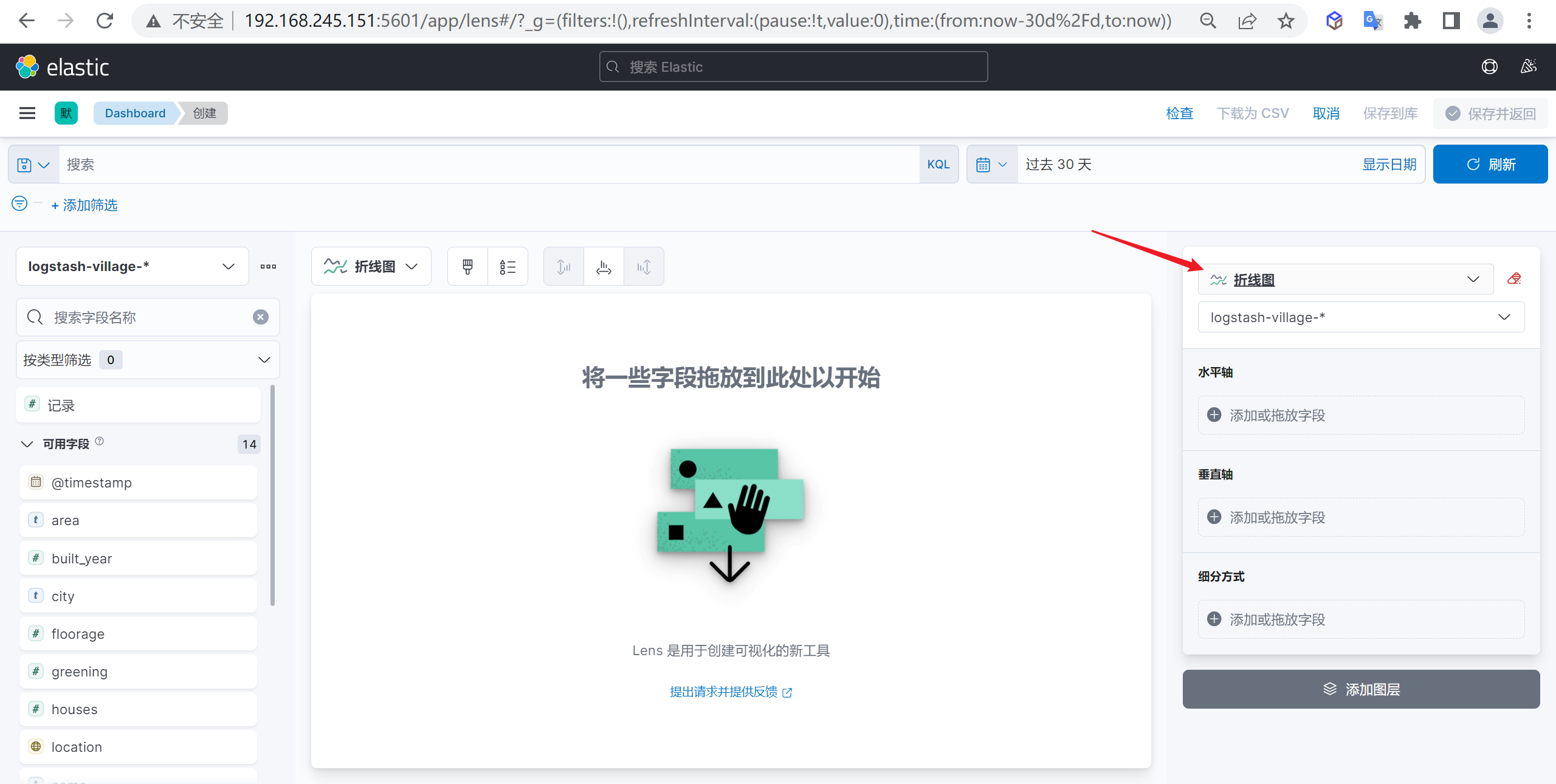

创建折线图

点击

创建可视化我们创建一个折线图

水平轴数据配置

我们在水平轴配置小区新建的年份,并选择时间间隔

垂直轴数据配置

我们在垂直轴配置小区新建面积的总和

数据分析

我们分析出来数据后可以发现2006年是小区新建面积的高峰期,2006年后就开始慢慢回落了

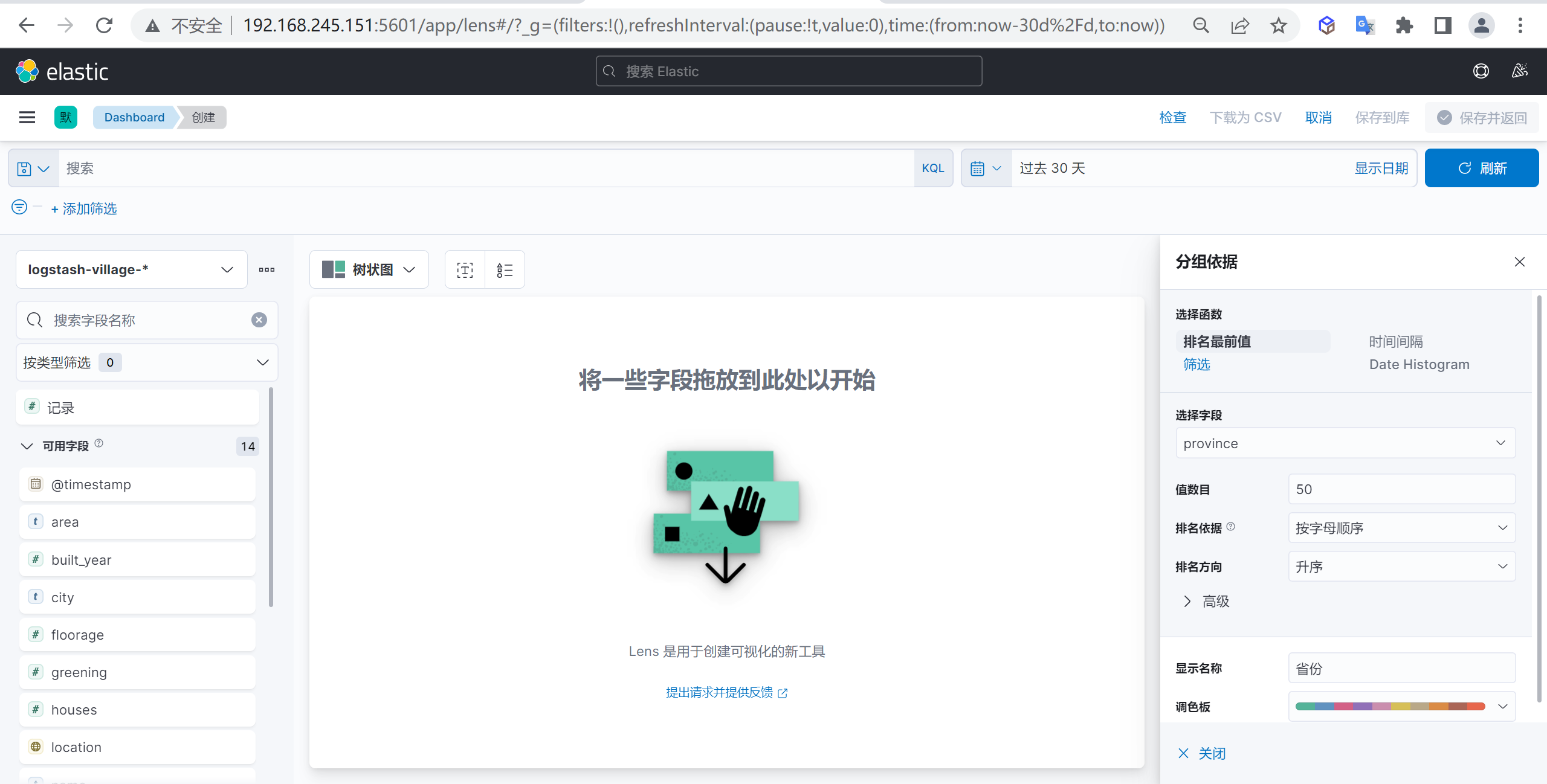

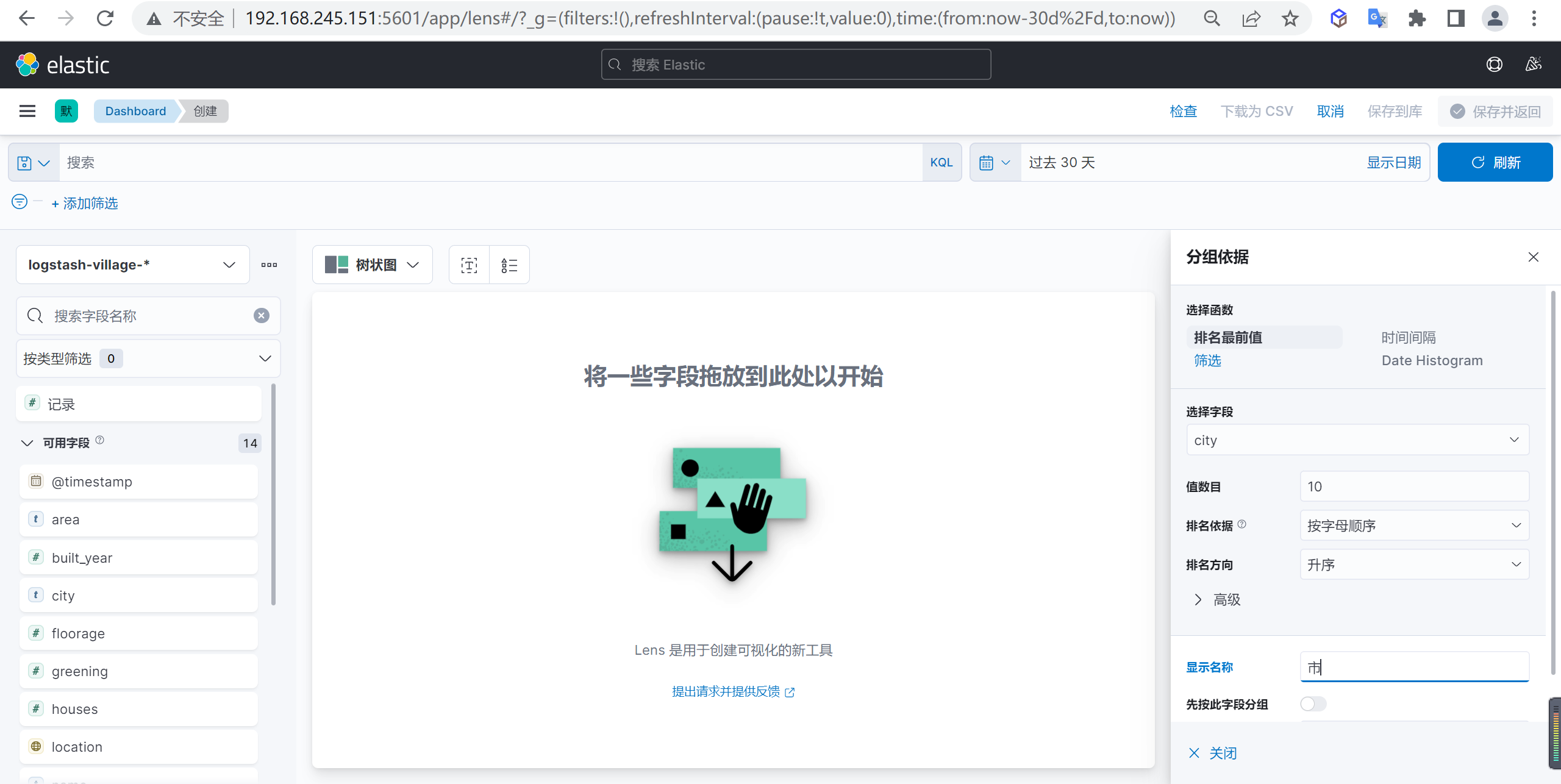

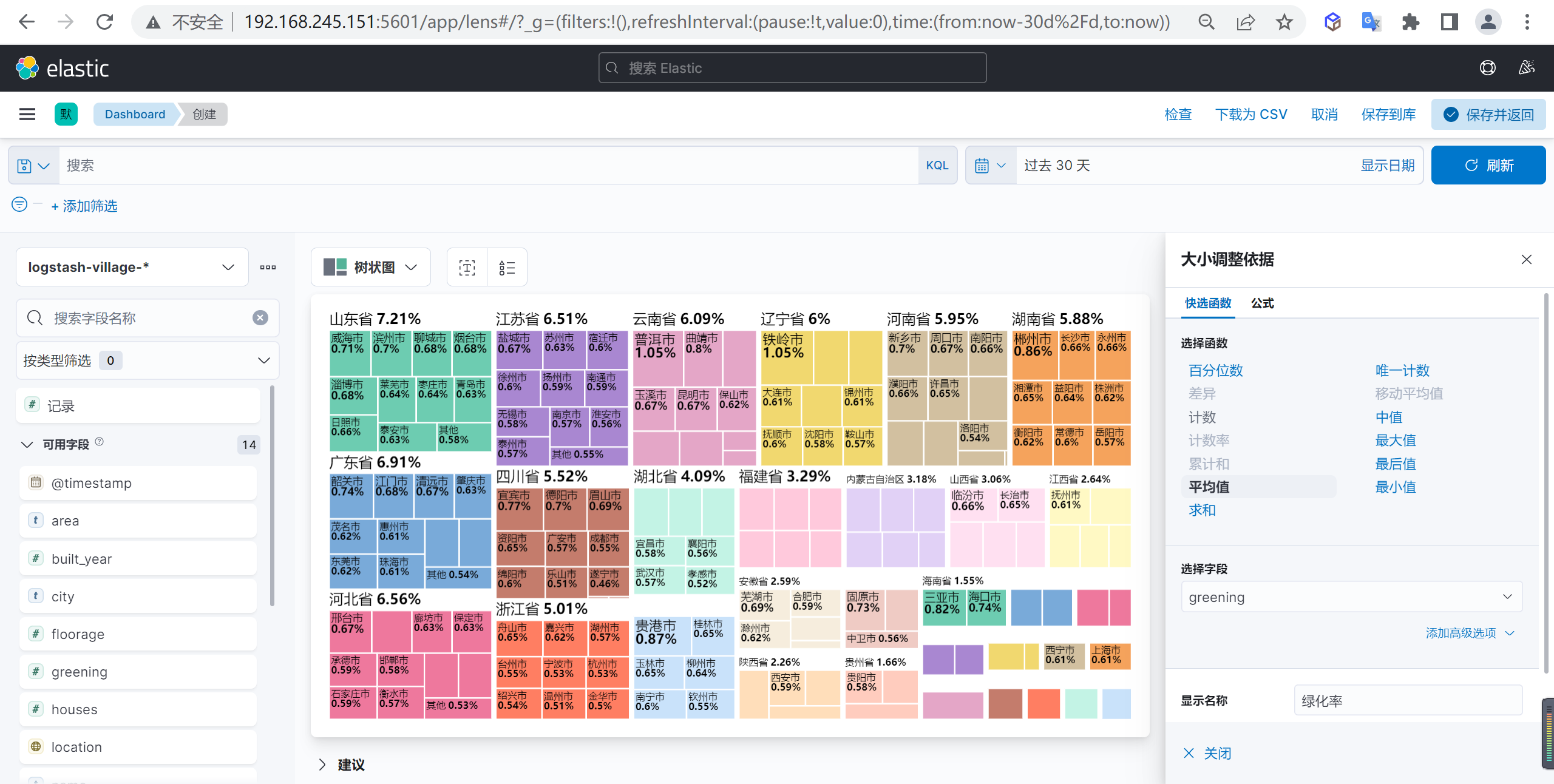

树状图示例

我们狂野配置一个按照省份的绿化率按照树状图进行展示

创建树状图

我们创建一个树状图

配置分组依据

我们可以配置一个分组依据,我们按照省份作为一个外部分组依据

接下来我们再按照市级来作为下级的分组依据

配置大小依据

我们按照绿化率的平均值作为大小依据

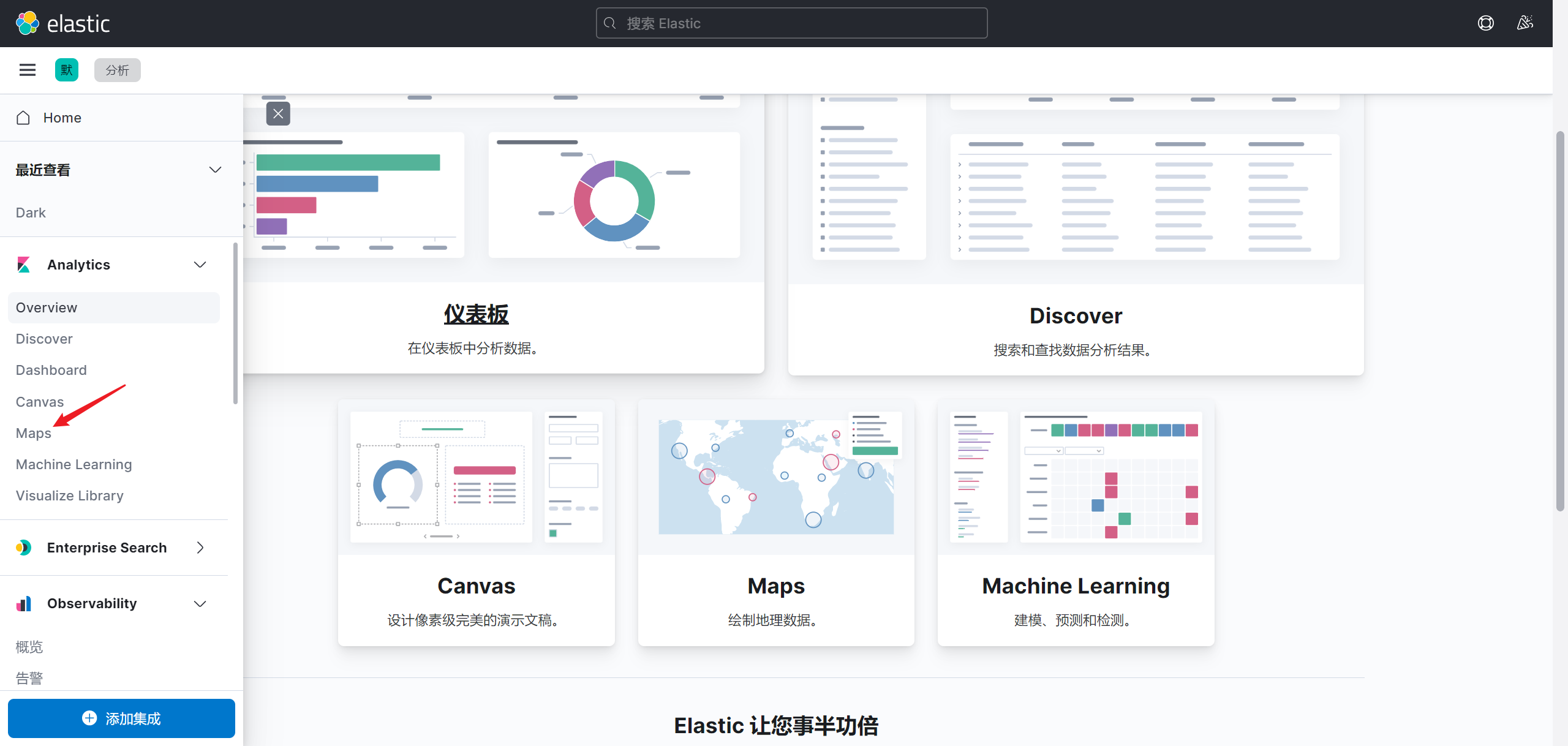

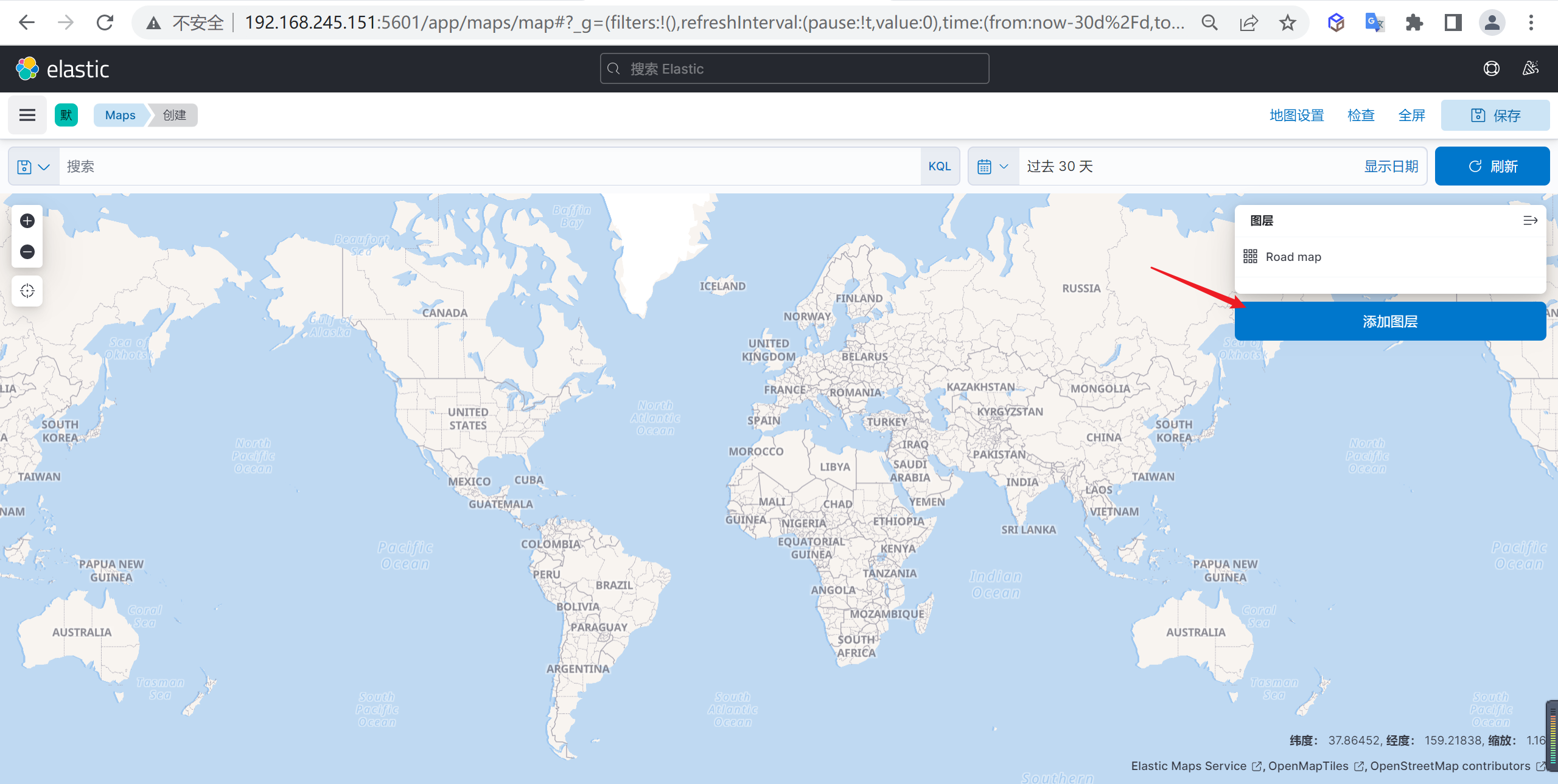

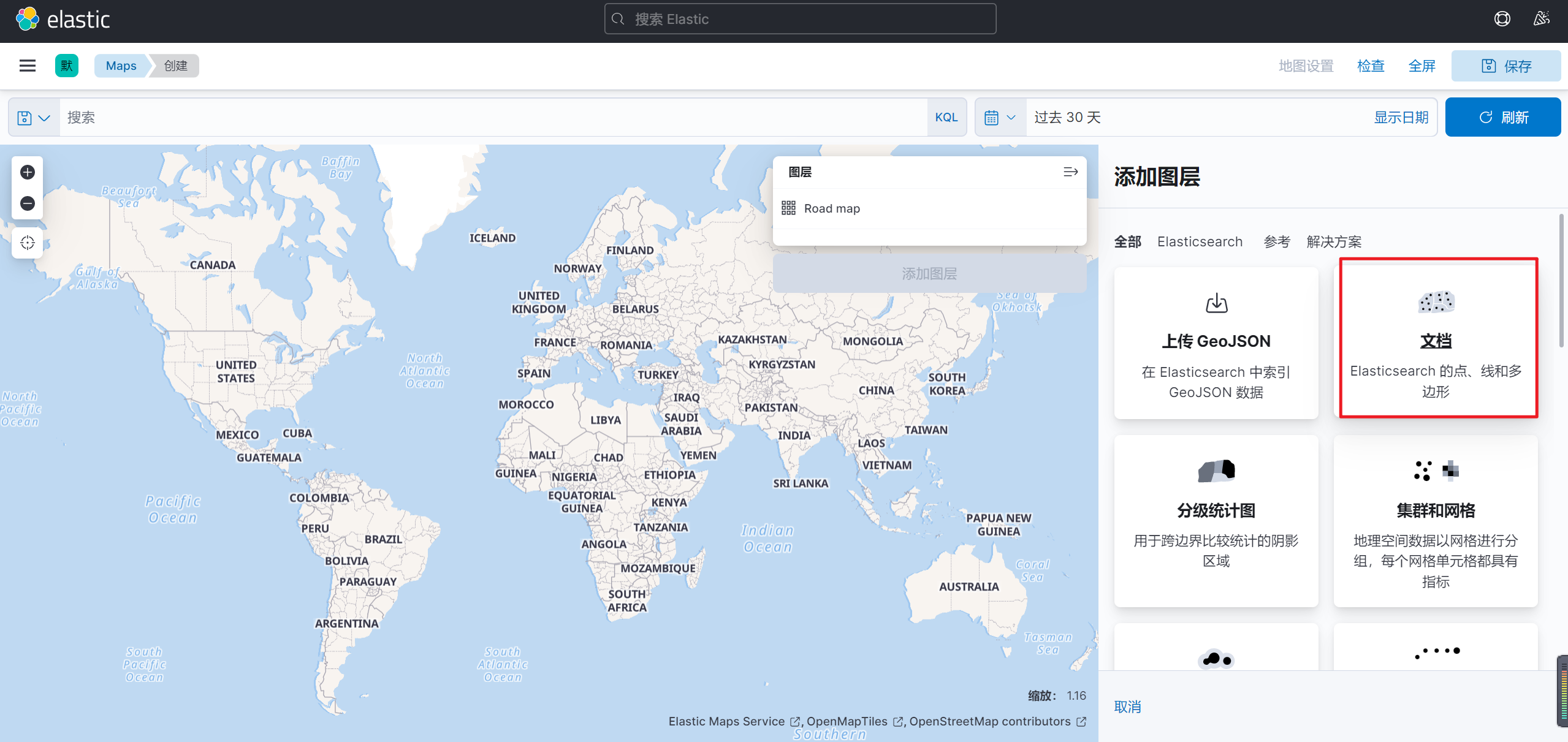

创建地图示例

我们还可以使用GEO信息创建一个地图

创建一个地图

我们先创建一个地图,选择Maps来创建一个地图

添加图层

在地图上面添加一个图层

选择文档数据

添加图层后选择需要添加的文档数据

并且在在弹出的界面选择需要显示索引以及GEO字段

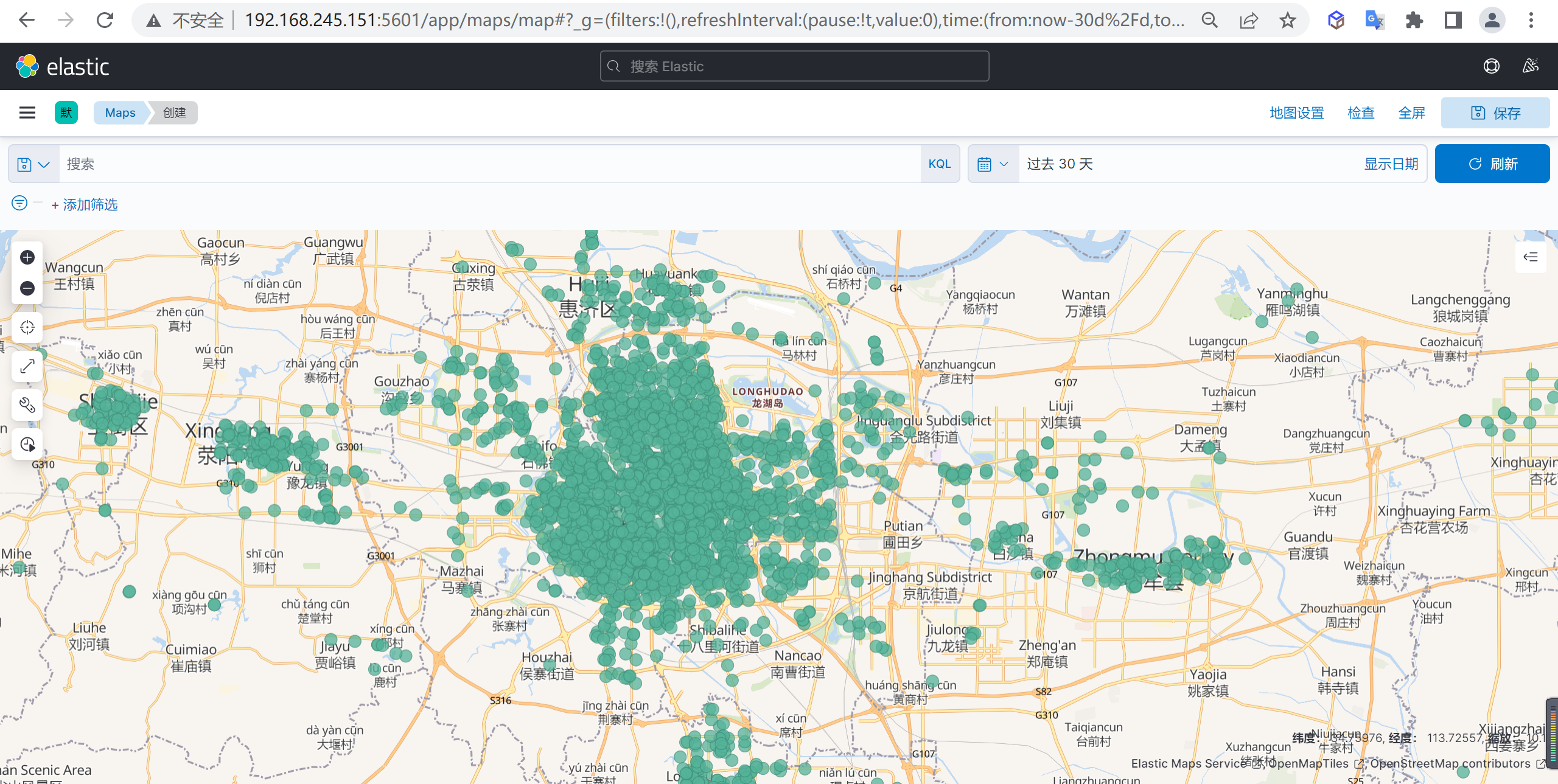

缩放显示数据

然后缩放地图可以看到就可以看到地图数据了

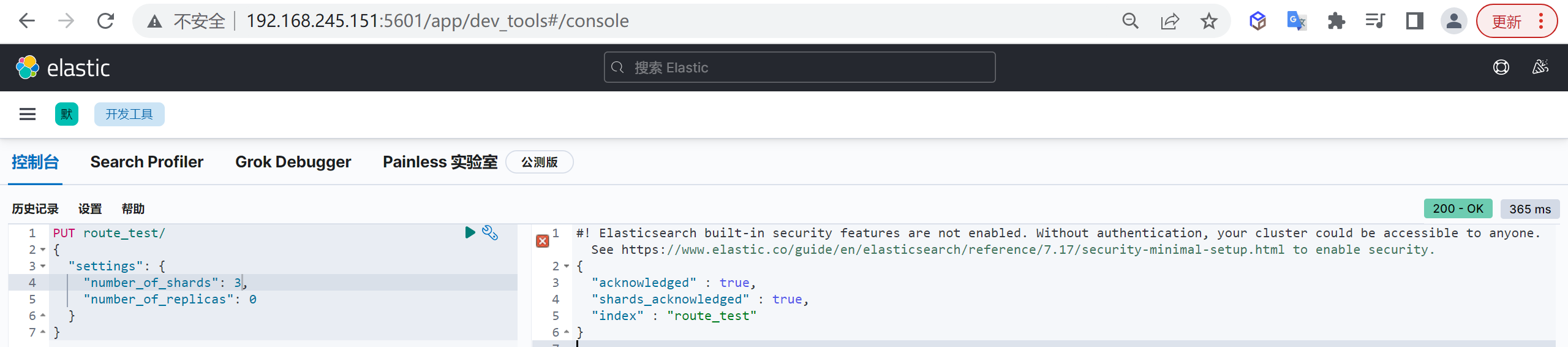

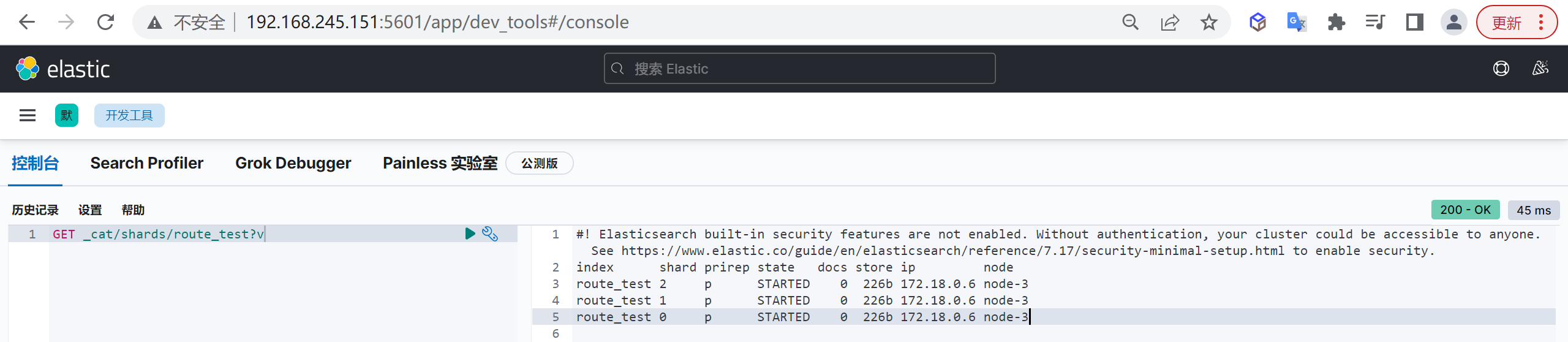

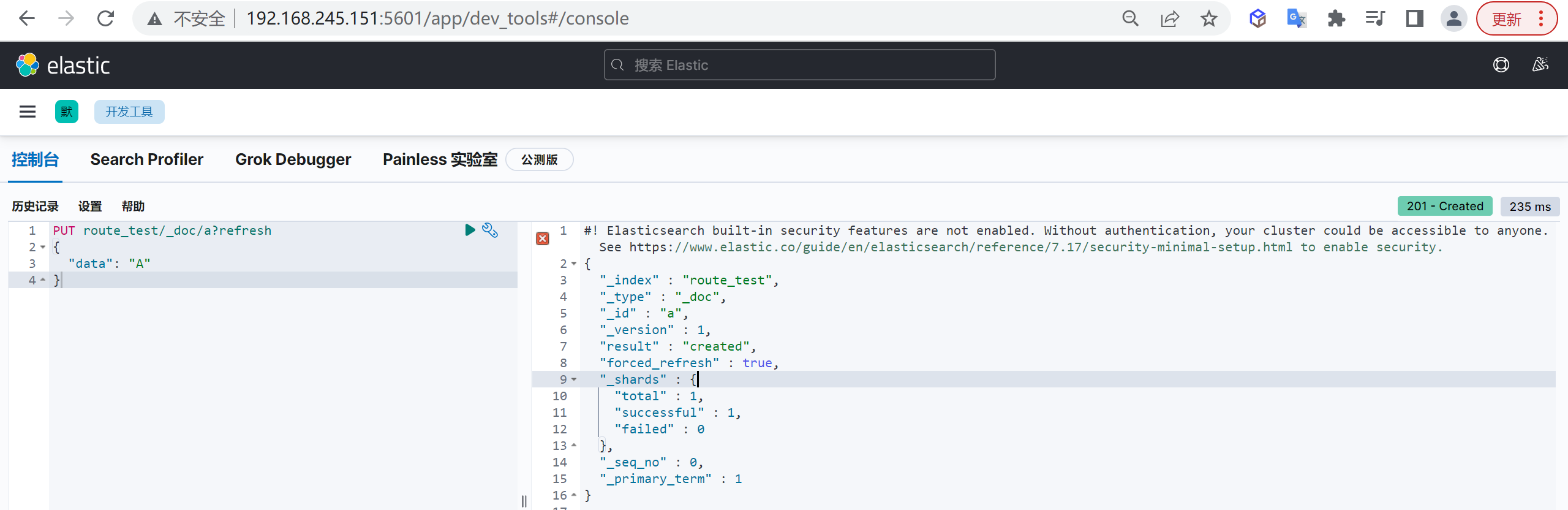

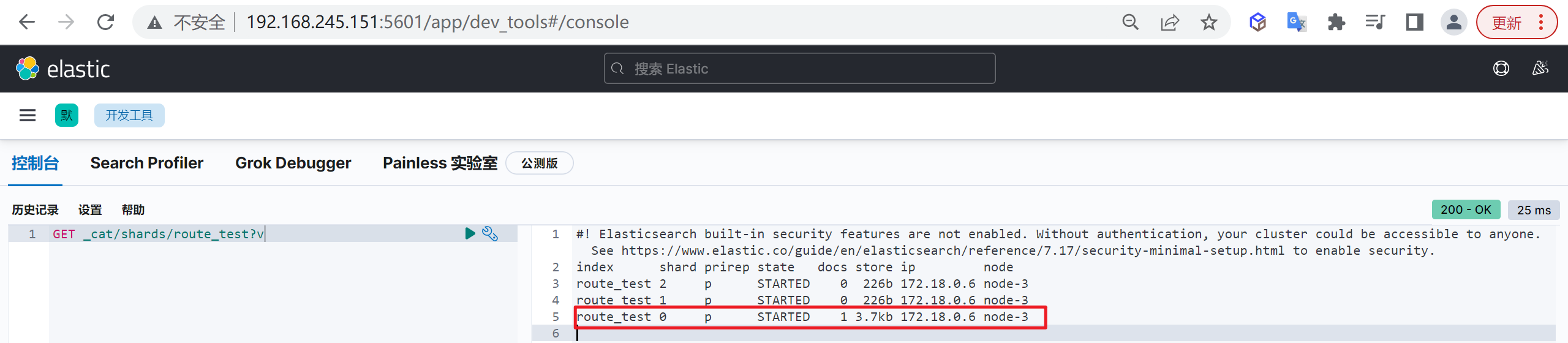

ElasticSearch 索引设计

在MySQL中数据库设计非常重要,同样在ES中数据库设计也是非常重要的

概述

我们创建索引就像创建表结构一样,必须非常慎重的,索引如果创建不好后面会出现各种各样的问题

索引设计的重要性

索引创建后,索引的分片只能通过

_split和_shrink接口对其进行成倍的增加和缩减

主要是因为es的数据是通过_routing分配到各个分片上面的,所以本质上是不推荐去改变索引的分片数量的,因为这样都会对数据进行重新的移动。

还有就是索引只能新增字段,不能对字段进行修改和删除,缺乏灵活性,所以每次都只能通过_reindex重建索引了,还有就是一个分片的大小以及所以分片数量的多少严重影响到了索引的查询和写入性能,所以可想而知,设计一个好的索引能够减少后期的运维管理和提高不少性能,所以前期对索引的设计是相当的重要的。

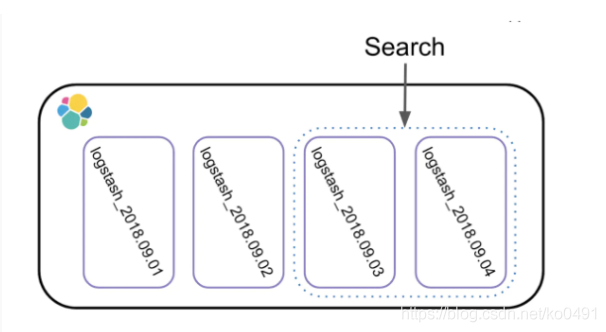

基于时间的Index设计

Index设计时要考虑的第一件事,就是基于时间对Index进行分割,即每隔一段时间产生一个新的Index

这样设计的目的

因为现实世界的数据是随着时间的变化而不断产生的,切分管理可以获得足够的灵活性和更好的性能

如果数据都存储在一个Index中,很难进行扩展和调整,因为Elasticsearch中Index的某些设置在创建时就设定好了,是不能更改的,比如Primary Shard的个数。

而根据时间来切分Index,则可以实现一定的灵活性,既可以在数据量过大时及时调整Shard个数,也可以及时响应新的业务需求。

大多数业务场景下,客户对数据的请求都会命中在最近一段时间上,通过切分Index,可以尽可能的避免扫描不必要的数据,提高性能。

时间间隔

根据上面的分析,自然是时间越短越能保持灵活性,但是这样做就会导致产生大量的Index,而每个Index都会消耗资源来维护其元信息的,因此需要在灵活性、资源和性能上做权衡

- 常见的间隔有小时、天、周和月:先考虑总共要存储多久的数据,然后选一个既不会产生大量Index又能够满足一定灵活性的间隔,比如你需要存储6个月的数据,那么一开始选择“周”这个间隔就会比较合适。

- 考虑业务增长速度:假如业务增长的特别快,比如上周产生了1亿数据,这周就增长到了10亿,那么就需要调低这个间隔来保证有足够的弹性能应对变化。

如何实现分割

切分行为是由客户端(数据的写入端)发起的,根据时间间隔与数据产生时间将数据写入不同的Index中,为了易于区分,会在Index的名字中加上对应的时间标识

创建新Index这件事,可以是客户端主动发起一个创建的请求,带上具体的Settings、Mappings等信息,但是可能会有一个时间错位,即有新数据写入时新的Index还没有建好,Elasticsearch提供了更优雅的方式来实现这个动作,即Index Template

分片设计

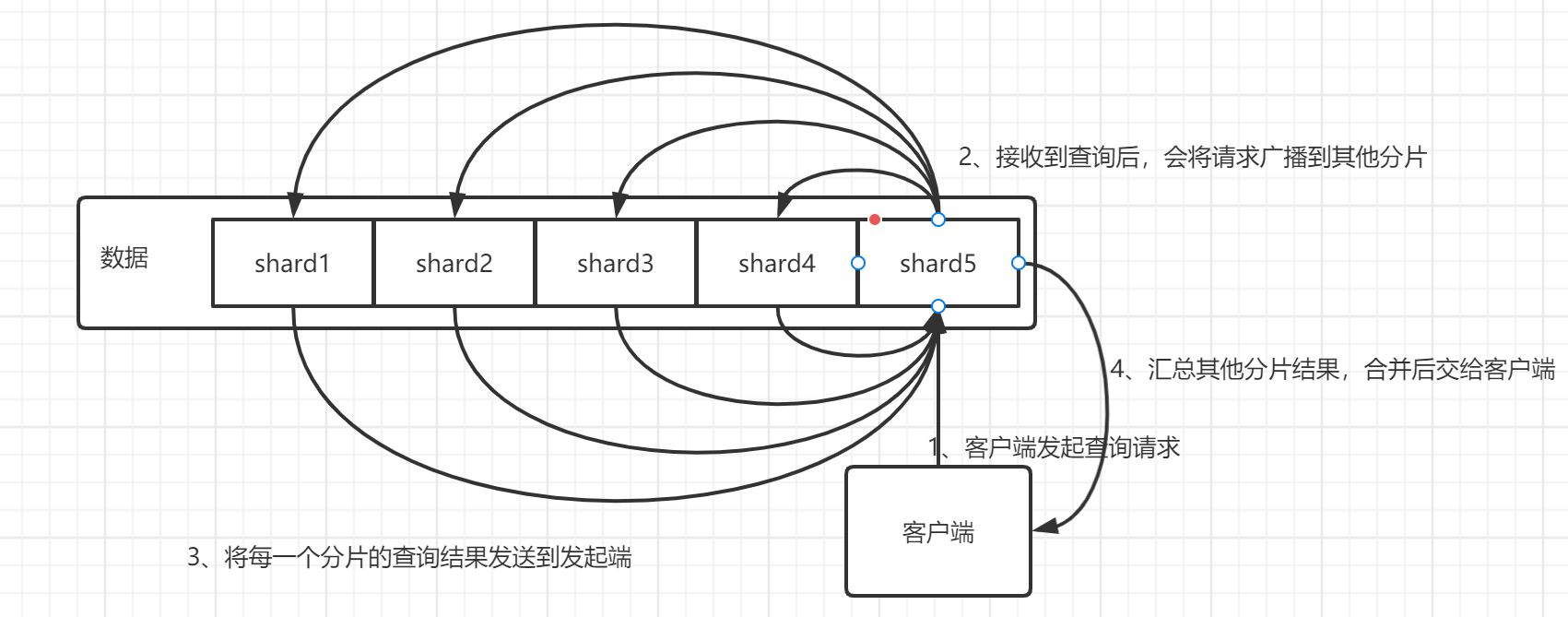

所谓分片设计,就是如何设定主分片的个数

看上去只是一个数字而已,也许在很多场景下,即使不设定也不会有问题(ES7默认是1个主分片一个副本分片),但是如果不提前考虑,一旦出问题就可能导致系统性能下降、不可访问、甚至无法恢复,换句话说,即使使用默认值,也应该是通过足够的评估后作出的决定,而非拍脑袋定的。

限制分片大小

单个Shard的存储大小不超过30GB

Elastic专家根据经验总结出来大家普遍认为30GB是个合适的上限值,实践中发现单个Shard过大(超过30GB)会导致系统不稳定。

其次,为什么不能超过30GB?主要是考虑Shard Relocate过程的负载,我们知道,如果Shard不均衡或者部分节点故障,Elasticsearch会做Shard Relocate,在这个过程中会搬移Shard,如果单个Shard过大,会导致CPU、IO负载过高进而影响系统性能与稳定性。

评估分片数量

单个Index的

Primary Shard个数 = k * 数据节点个数

在保证第一点的前提下,单个Index的Primary Shard个数不宜过多,否则相关的元信息与缓存会消耗过多的系统资源,这里的k,为一个较小的整数值,建议取值为1,2等,整数倍的关系可以让Shard更好地均匀分布,可以充分的将请求分散到不同节点上。

小索引设计

对于很小的Index,可以只分配1~2个Primary Shard的

有些情况下,Index很小,也许只有几十、几百MB左右,那么就不用按照第二点来分配了,只分配1~2个Primary Shard是可以,不用纠结。

使用索引模板

就是把已经创建好的某个索引的参数设置(settings)和索引映射(mapping)保存下来作为模板,在创建新索引时,指定要使用的模板名,就可以直接重用已经定义好的模板中的设置和映射

Elasticsearch基于与索引名称匹配的通配符模式将模板应用于新索引,也就是说通过索引进行匹配,看看新建的索引是否符合索引模板,如果符合,就将索引模板的相关设置应用到新的索引,如果同时符合多个索引模板呢,这里需要对参数priority进行比较,这样会选择priority大的那个模板进行创建索引。

在创建索引模板时,如果匹配有包含的关系,或者相同,则必须设置priority为不同的值,否则会报错,索引模板也是只有在新创建的时候起到作用,修改索引模板对现有的索引没有影响,同样如果在索引中设置了一些设置或者mapping都会覆盖索引模板中相同的设置或者mapping

索引模板的用途

索引模板一般用在时间序列相关的索引中。

也就是说, 如果你需要每间隔一定的时间就建立一次索引,你只需要配置好索引模板,以后就可以直接使用这个模板中的设置,不用每次都设置settings和mappings.

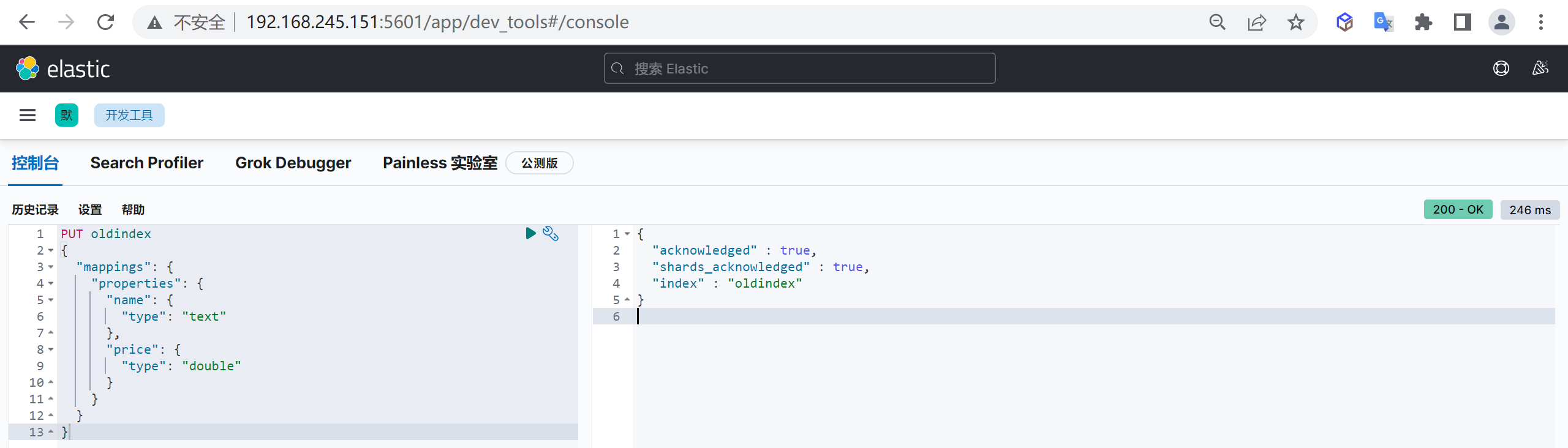

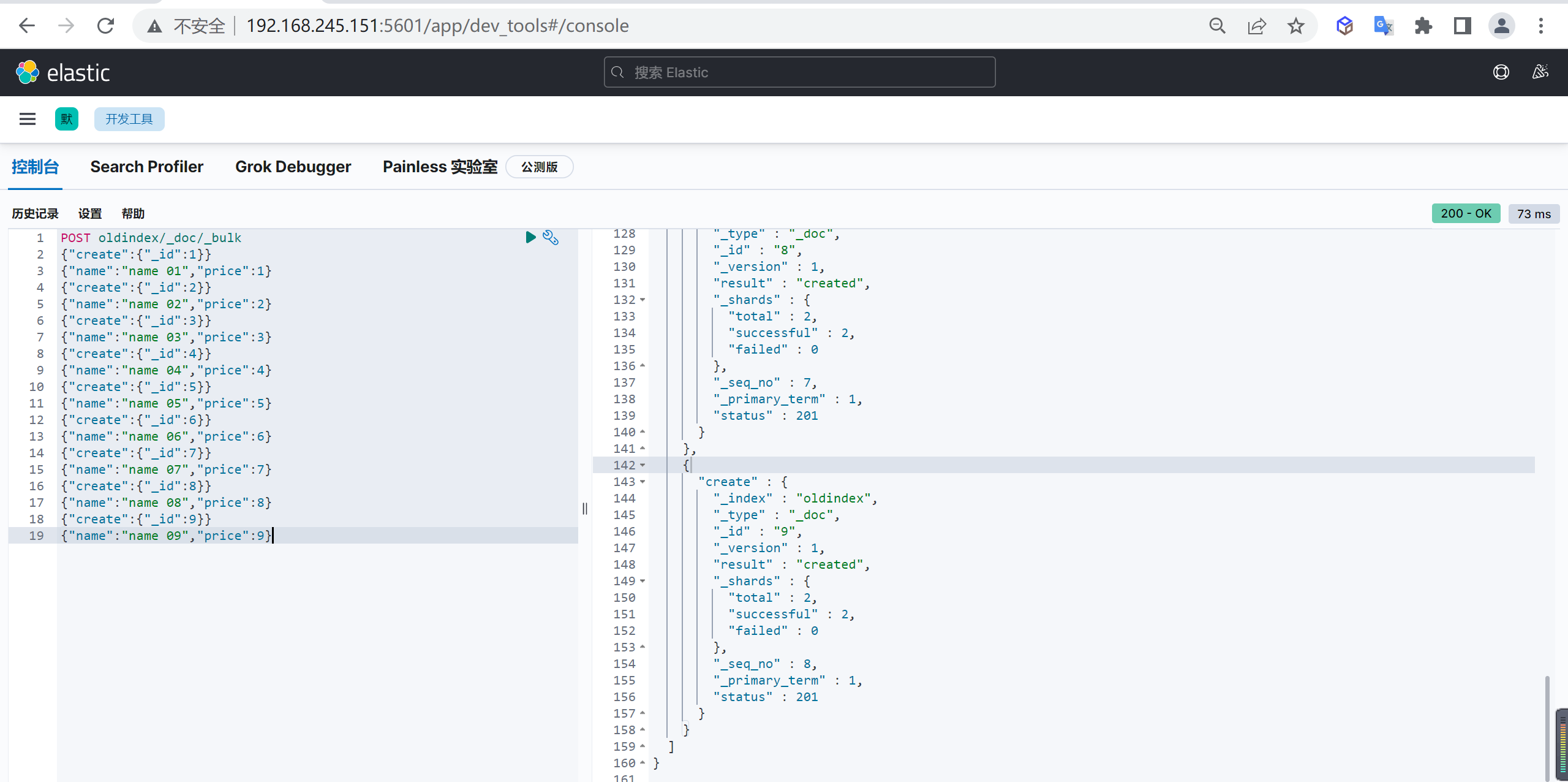

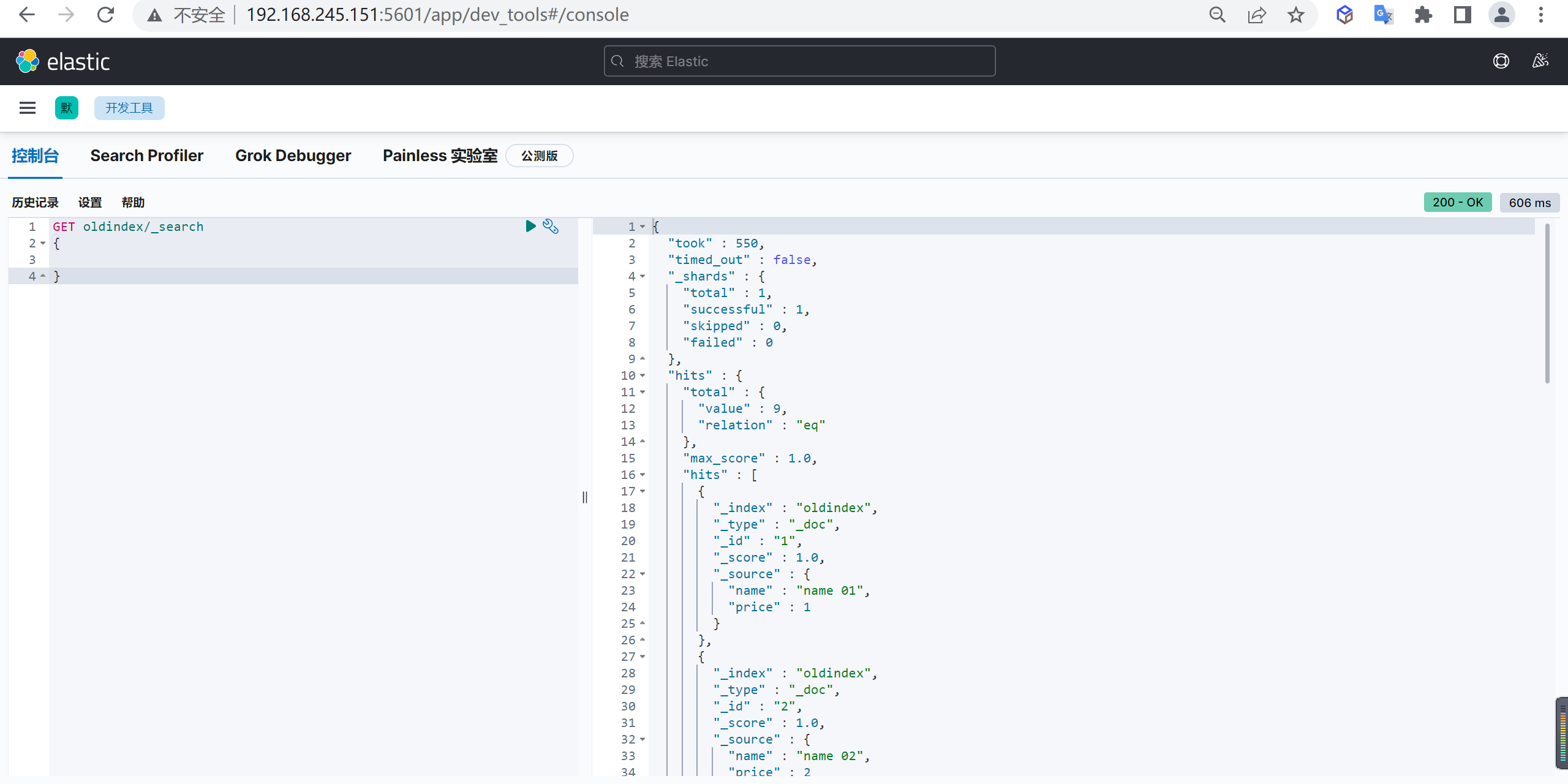

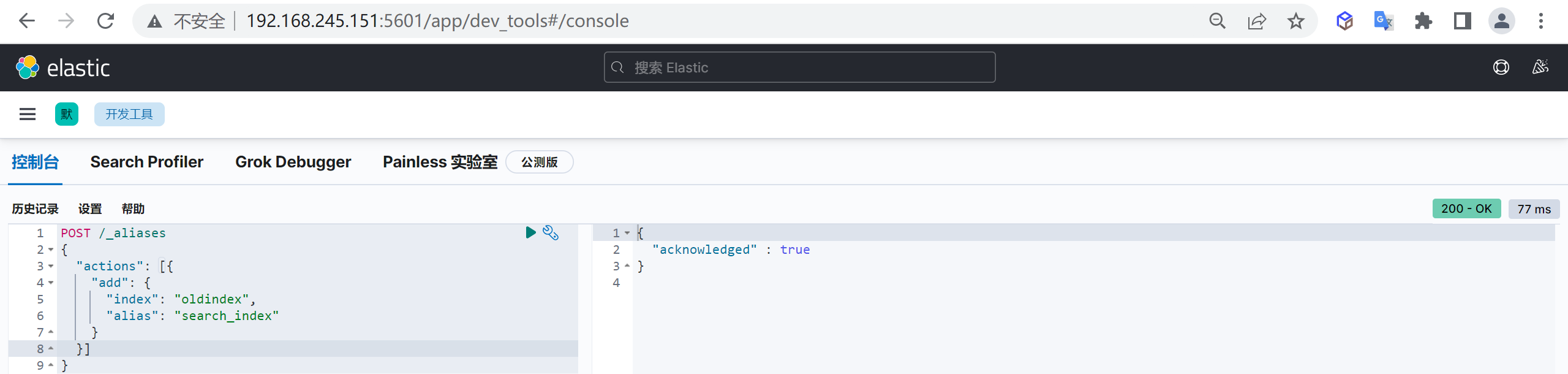

创建索引模板

PUT _index_template/logstash-village

{

"index_patterns": [

"logstash-village-*" // 可以通过"logstash-village-*"来适配创建的索引

],

"template": {

"settings": {

"number_of_shards": "3", //指定模板分片数量

"number_of_replicas": "2" //指定模板副本数量

},

"aliases": {

"logstash-village": {} //指定模板索引别名

},

"mappings": { //设置映射

"dynamic": "strict", //禁用动态映射

"properties": {

"@timestamp": {

"type": "date",

"format": "strict_date_optional_time||epoch_millis||yyyy-MM-dd HH:mm:ss"

},

"@version": {

"doc_values": false,

"index": "false",

"type": "integer"

},

"name": {

"type": "keyword"

},

"province": {

"type": "keyword"

},

"city": {

"type": "keyword"

},

"area": {

"type": "keyword"

},

"addr": {

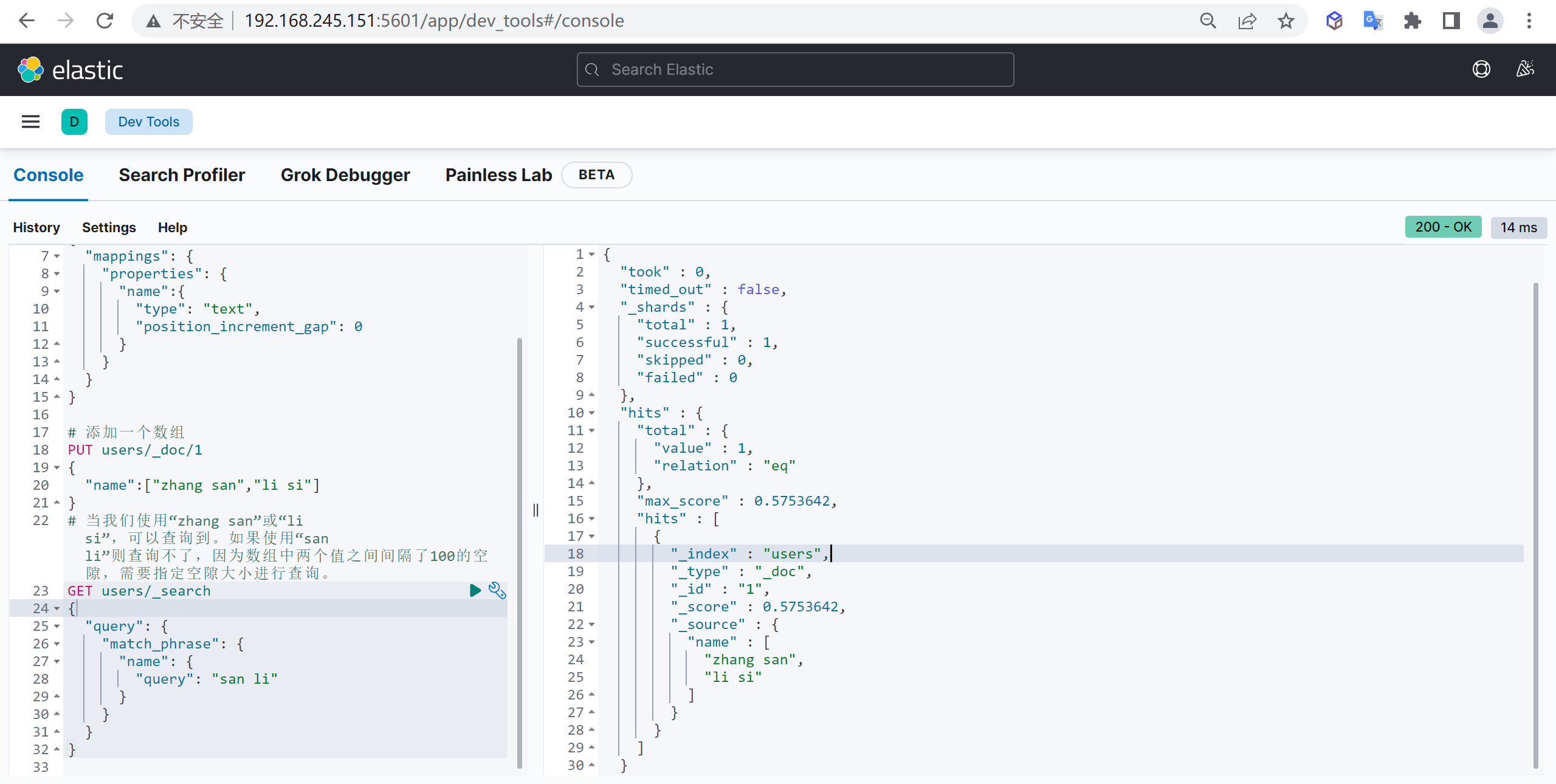

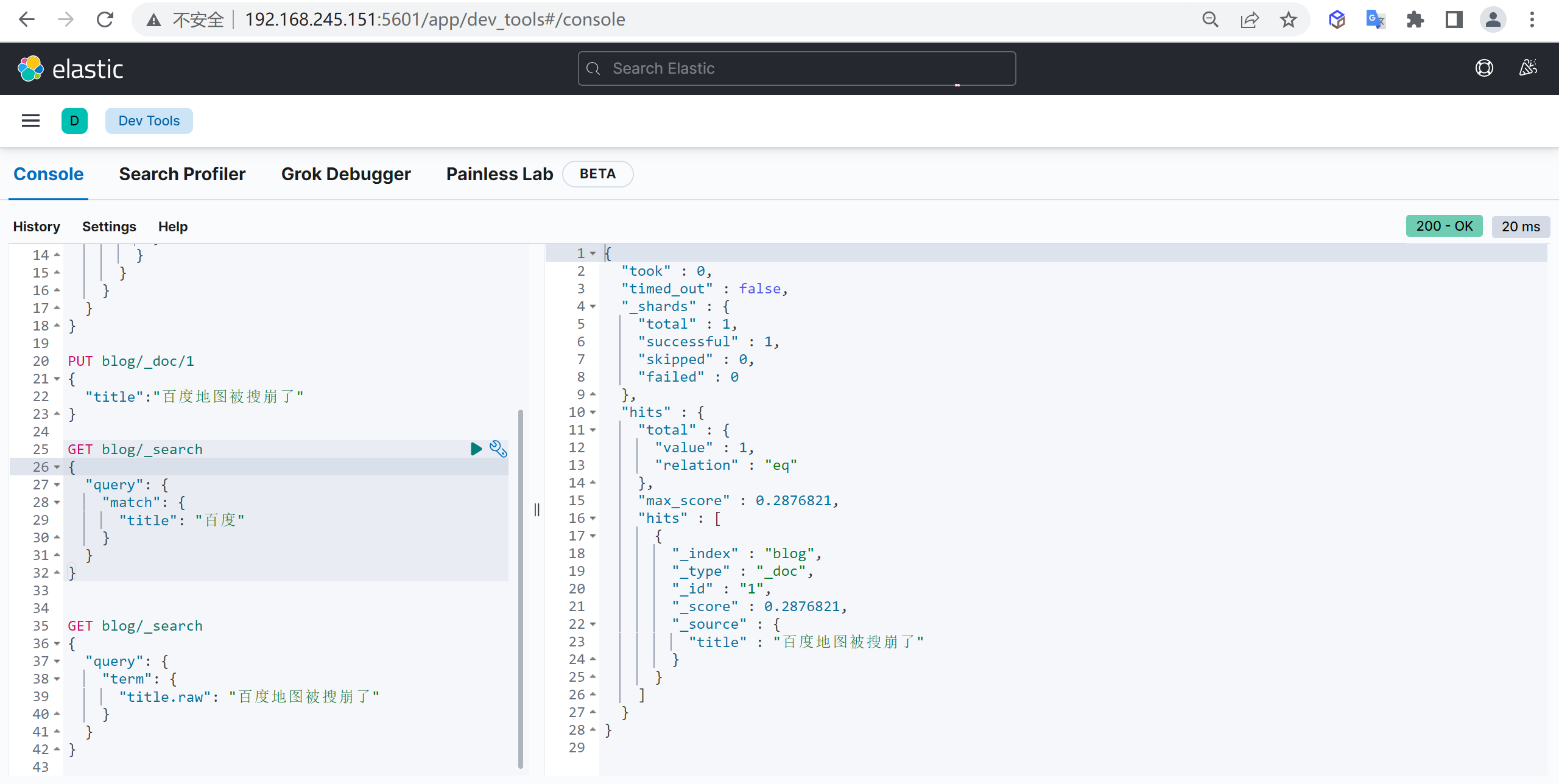

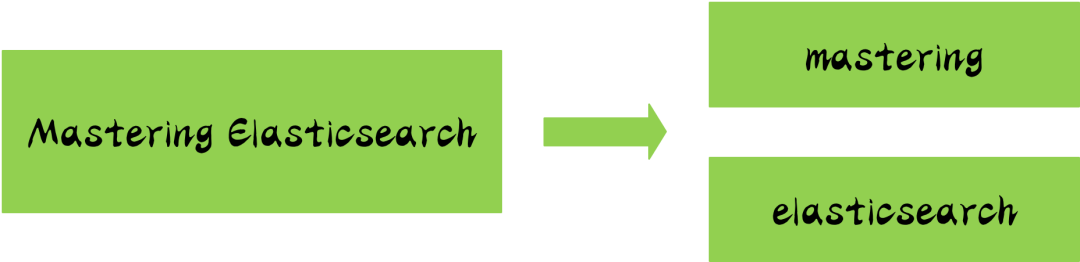

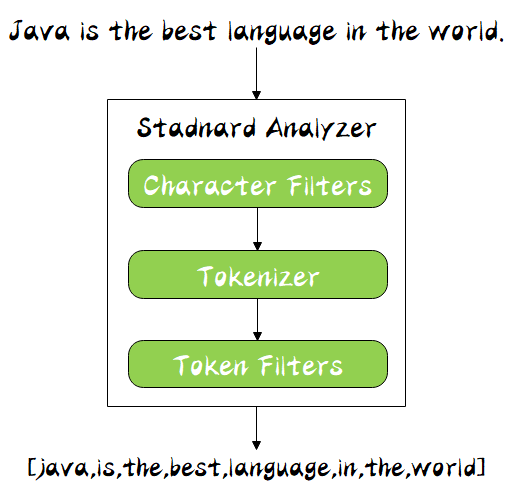

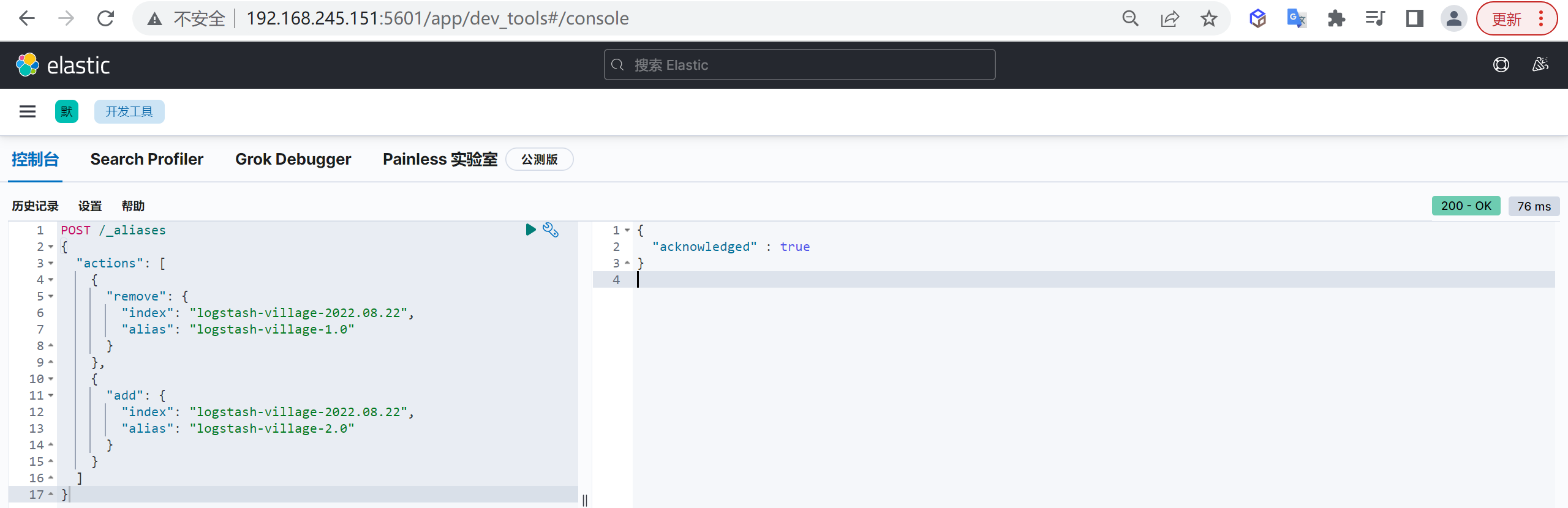

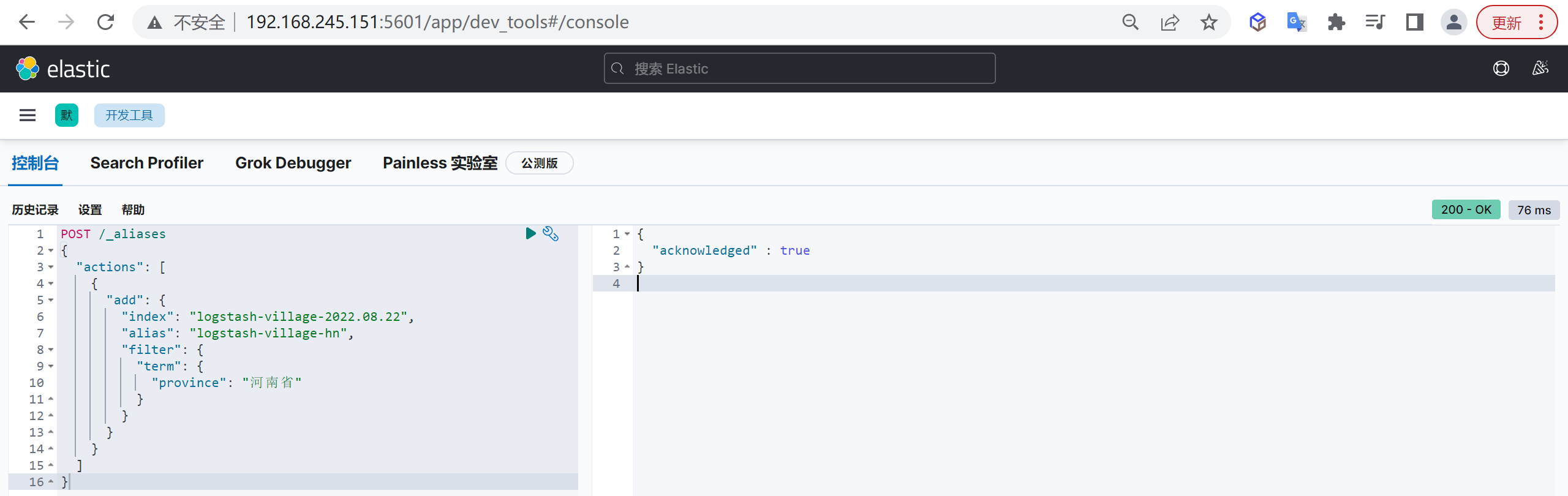

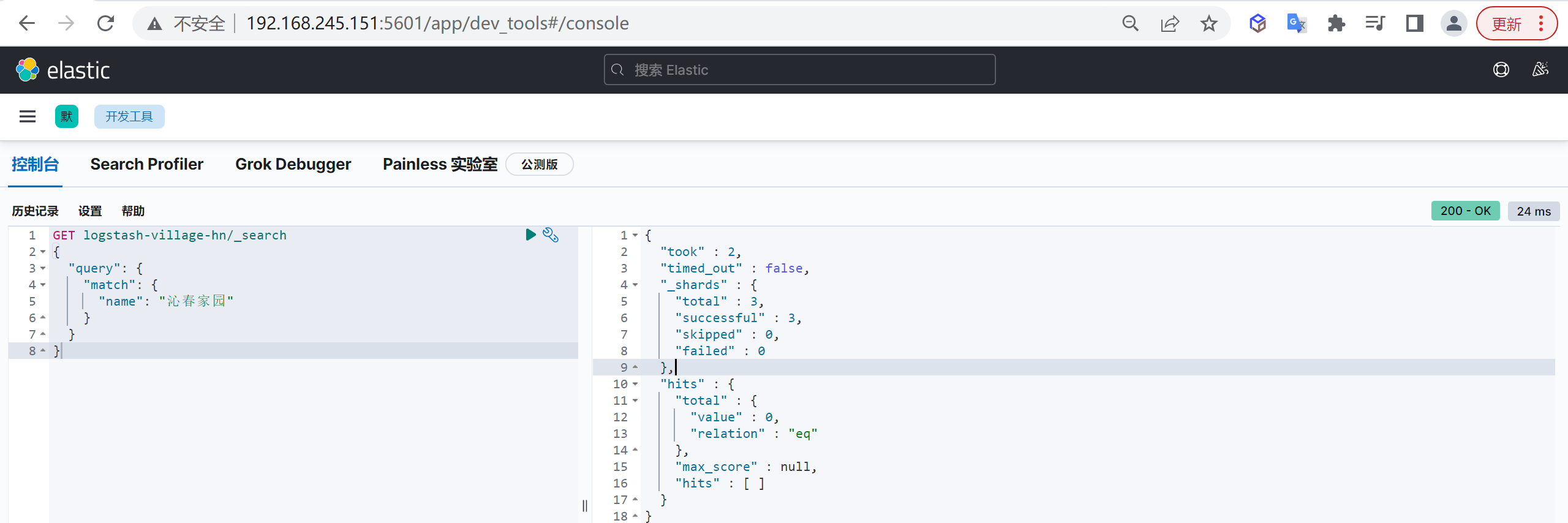

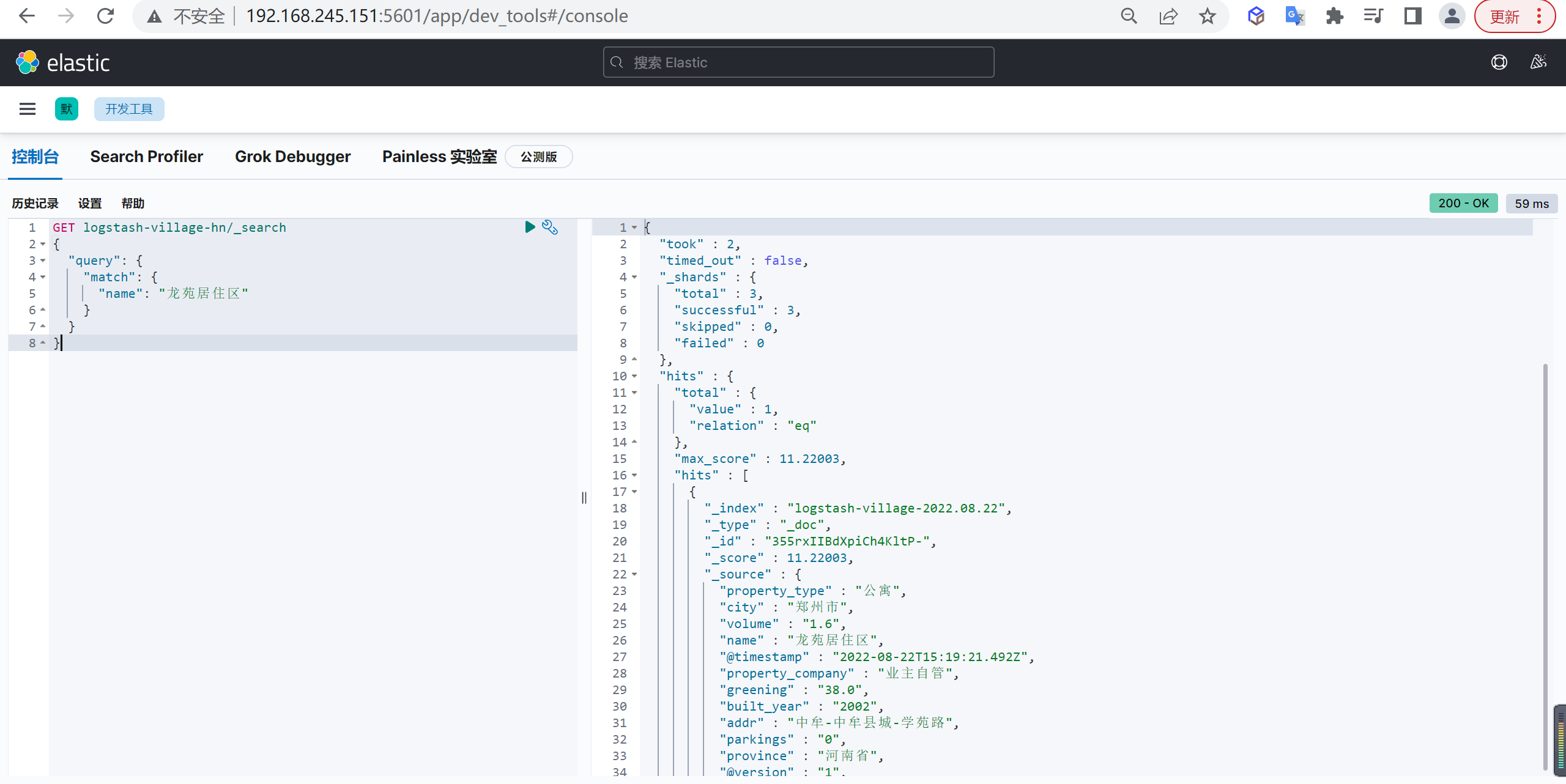

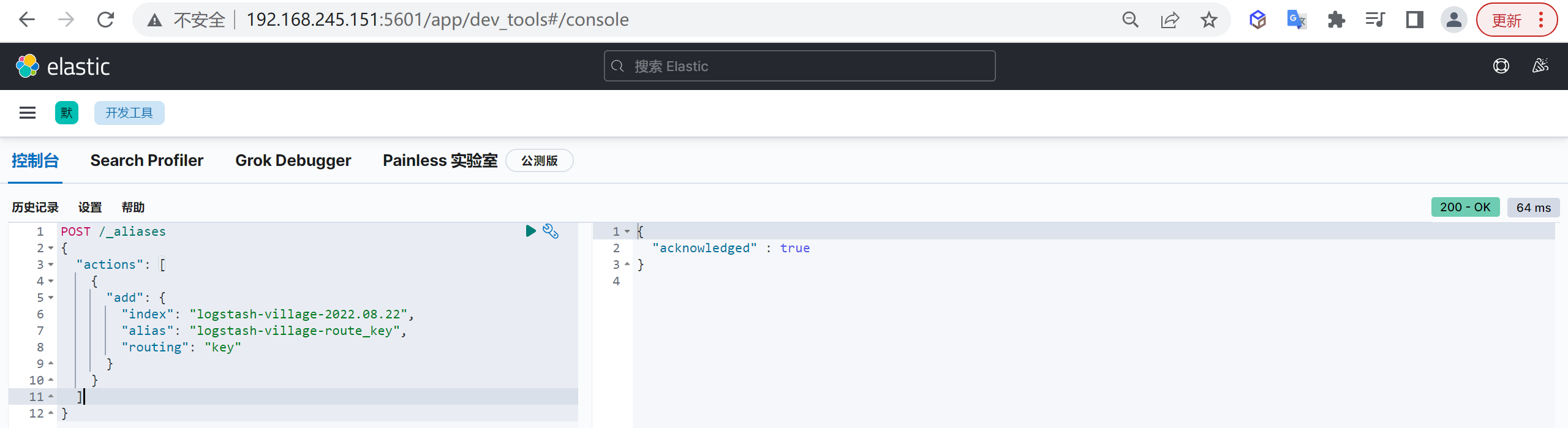

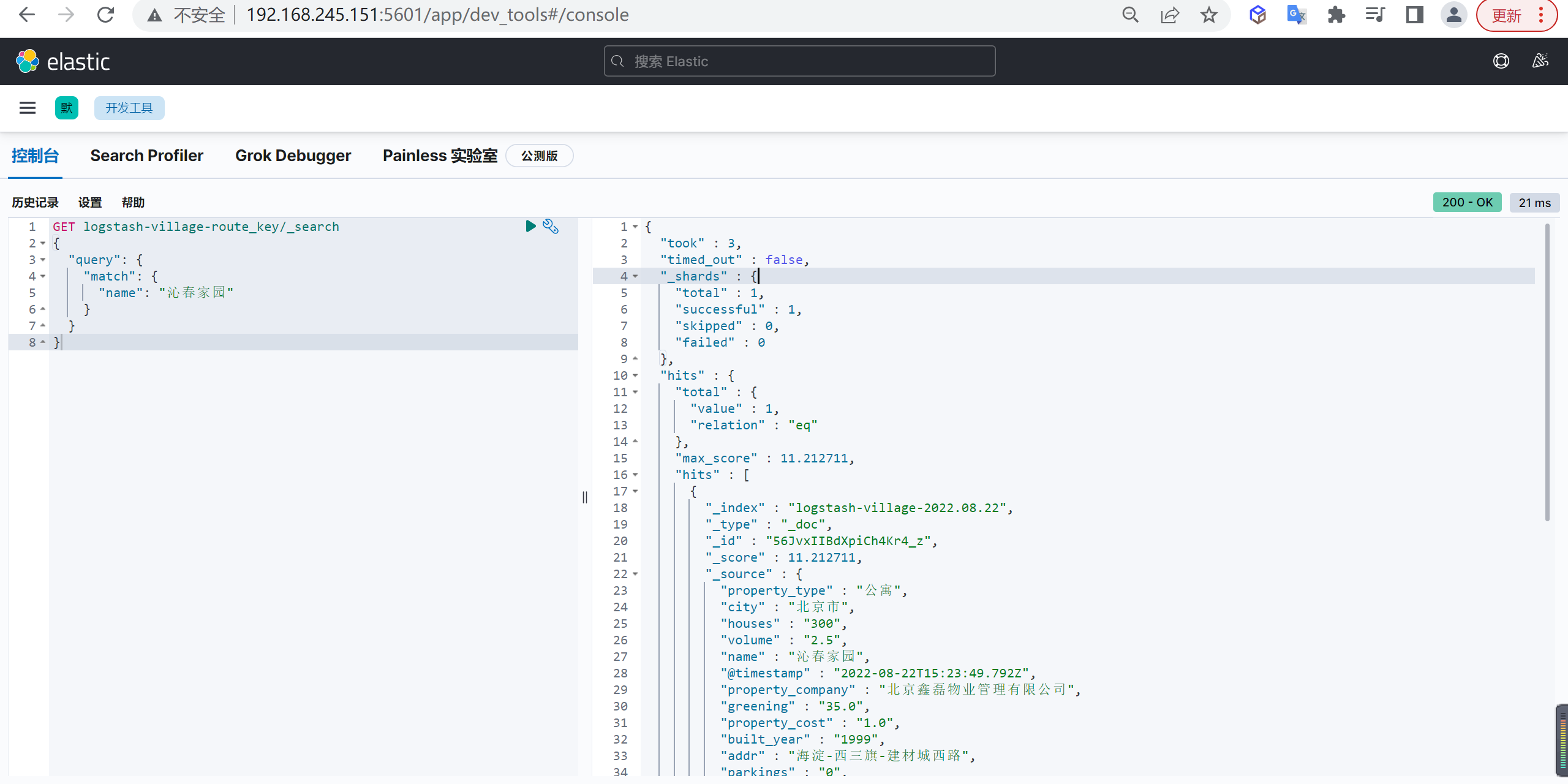

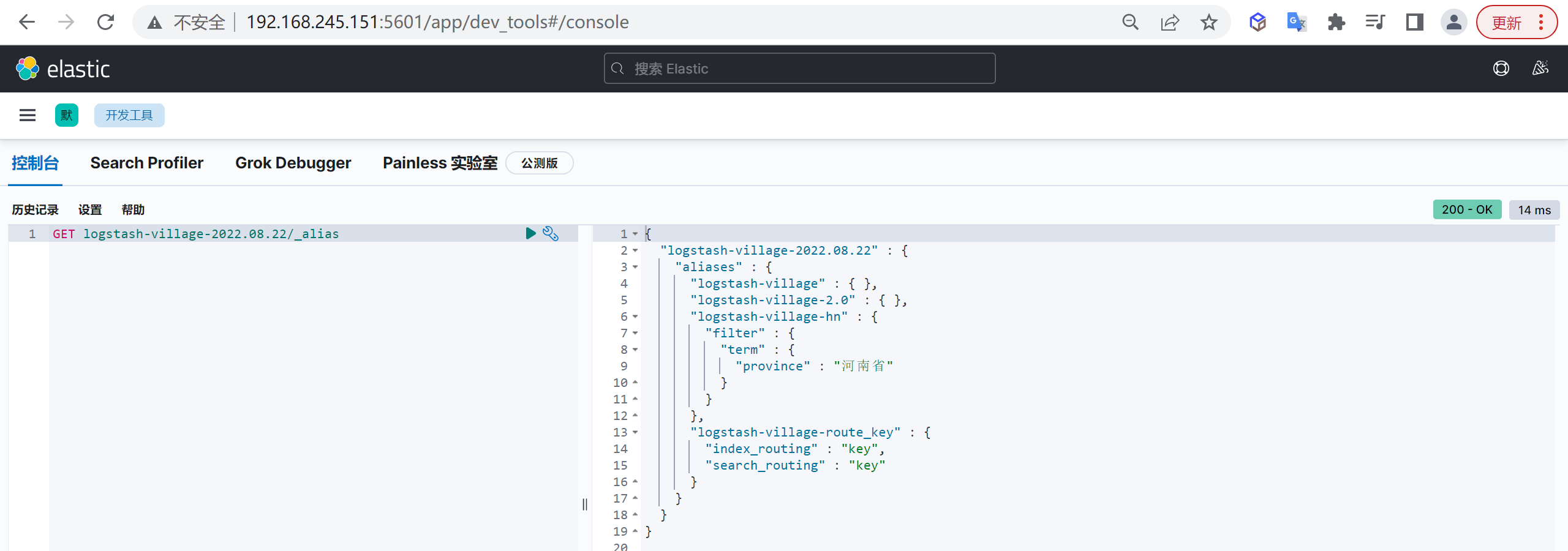

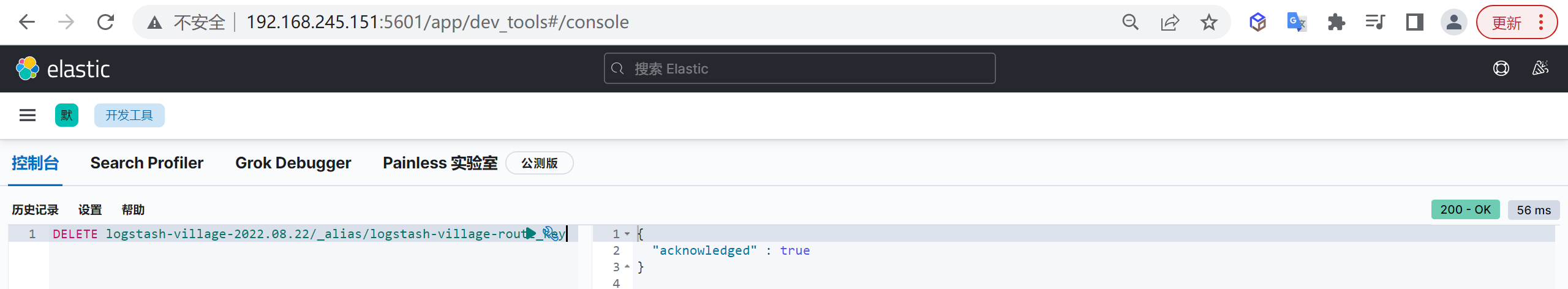

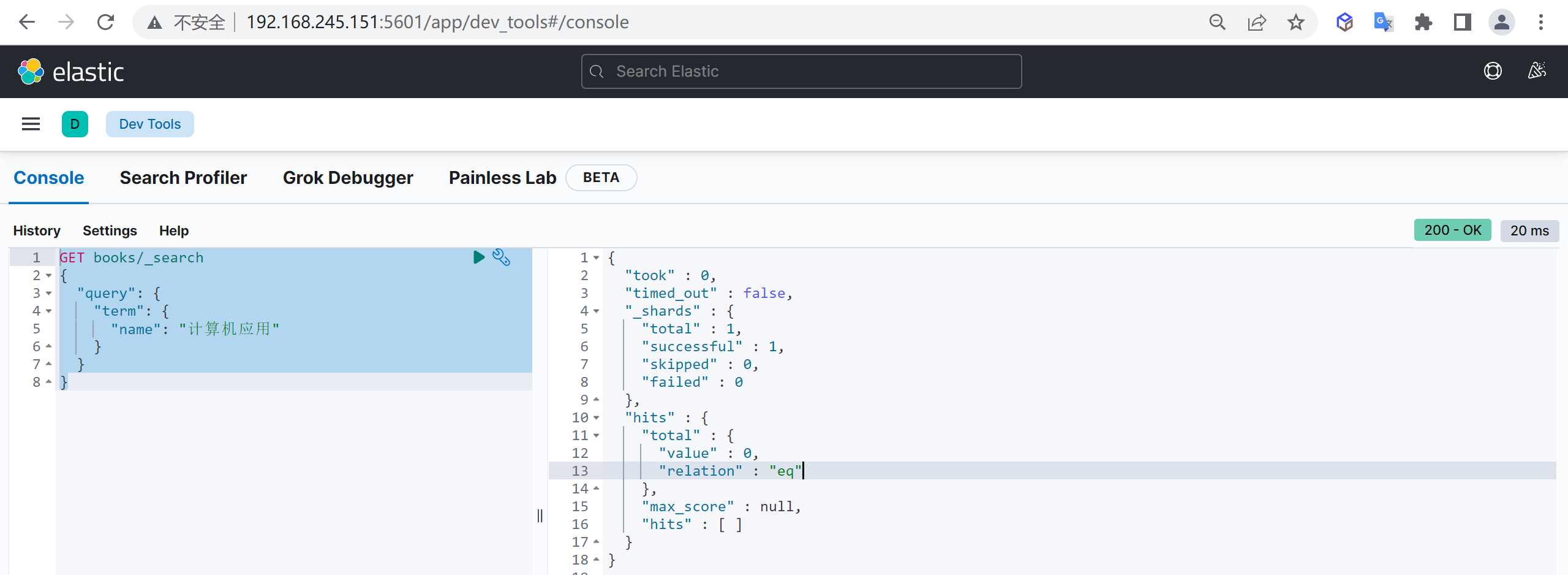

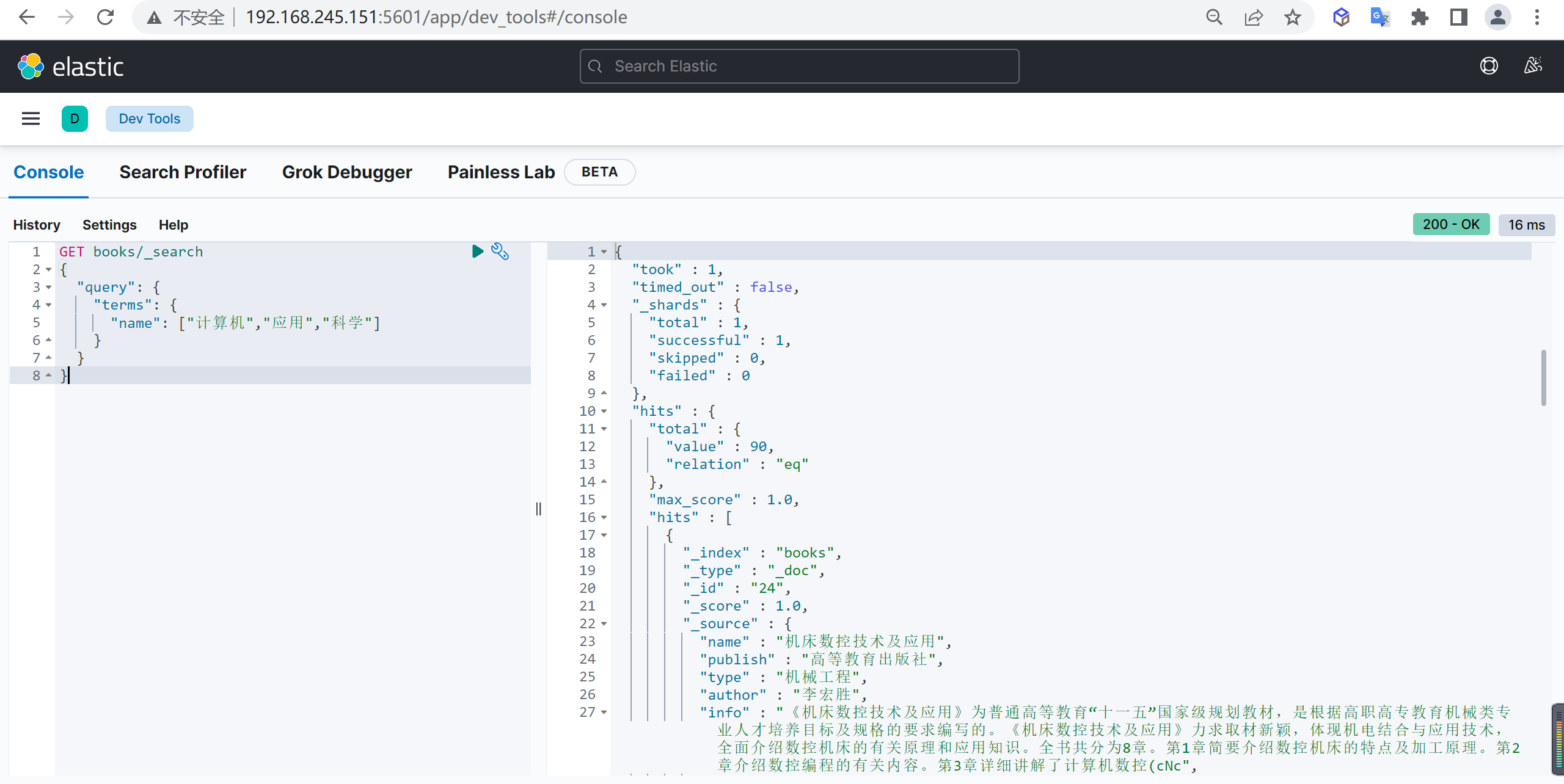

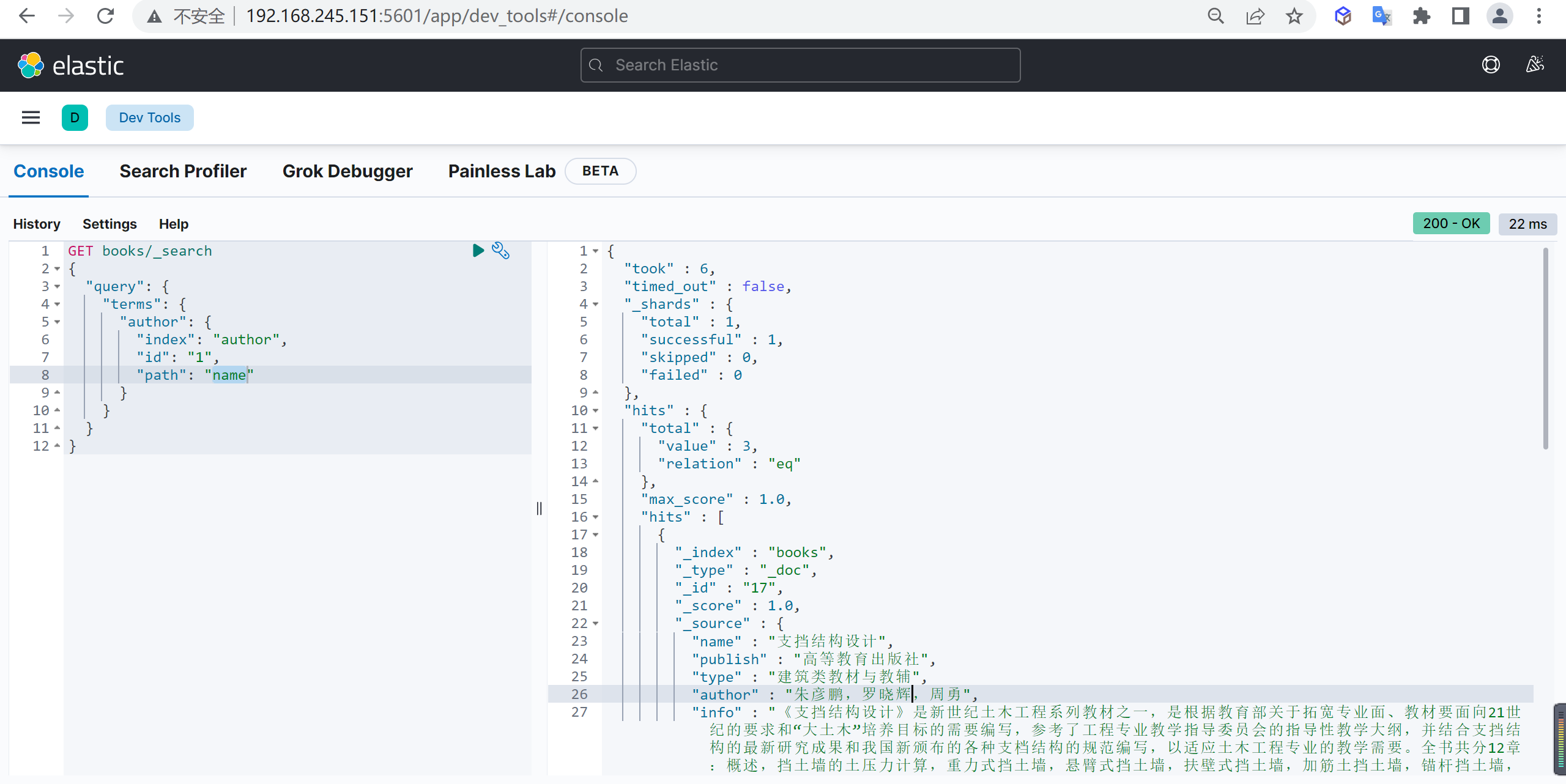

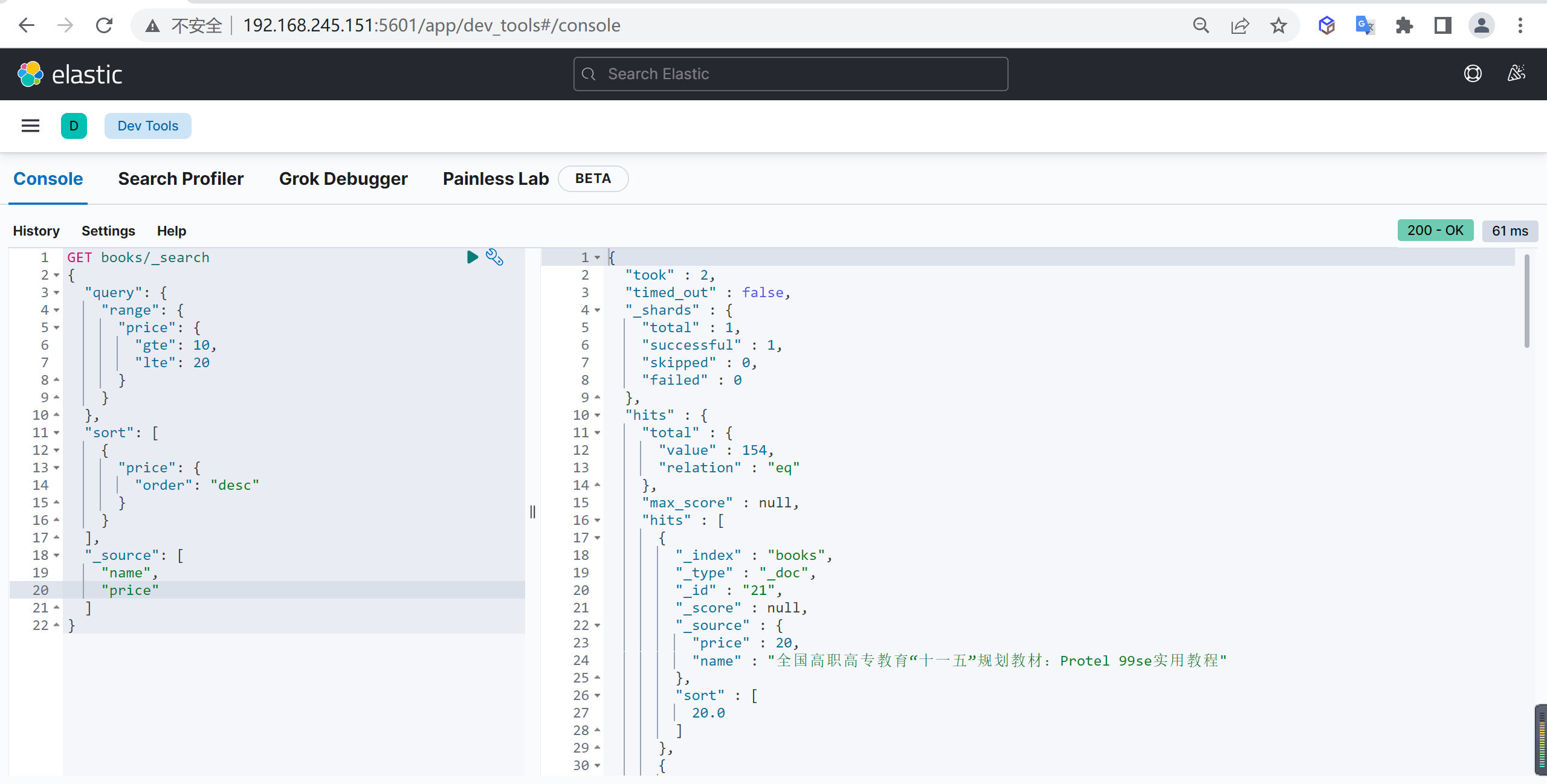

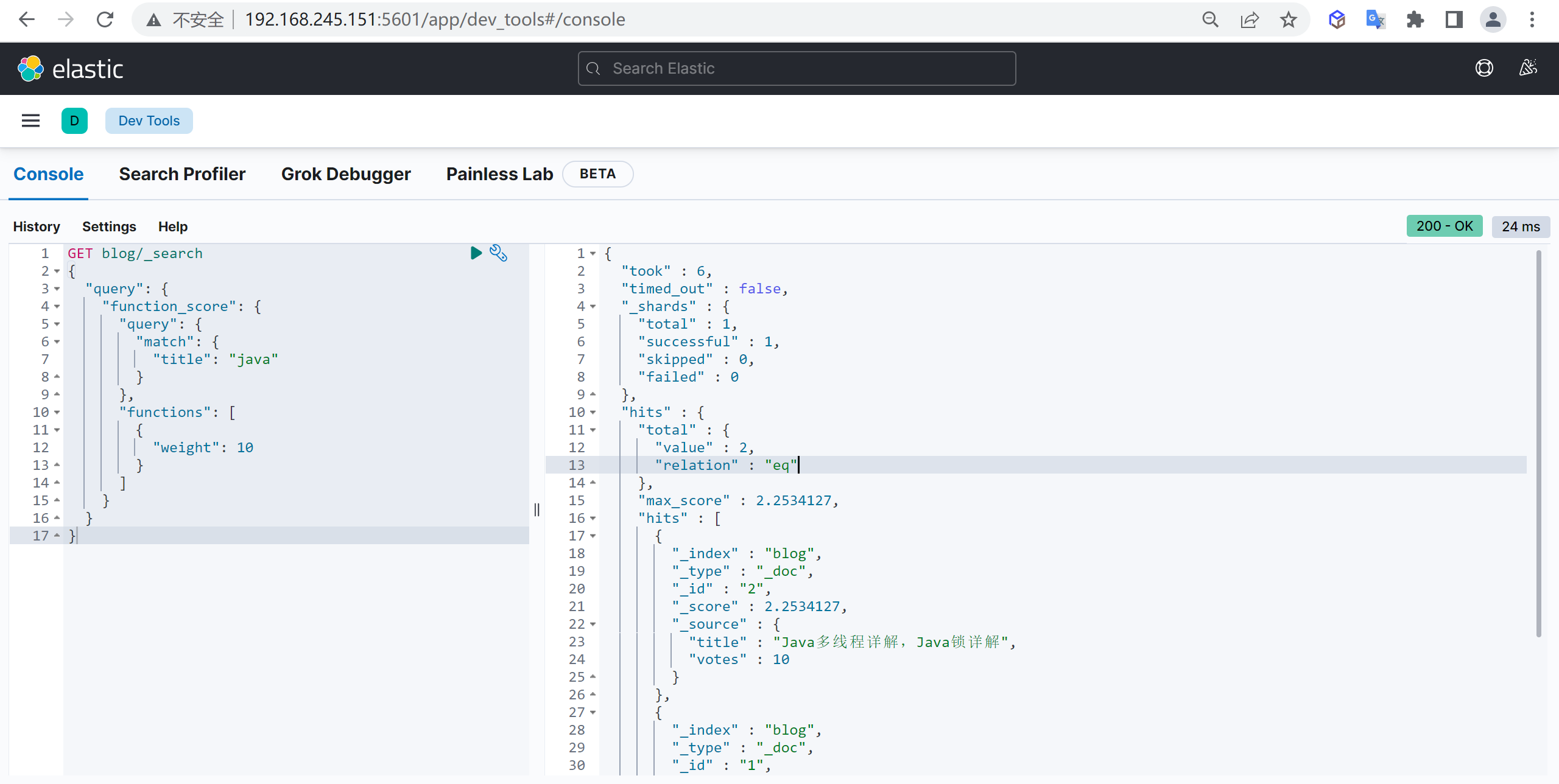

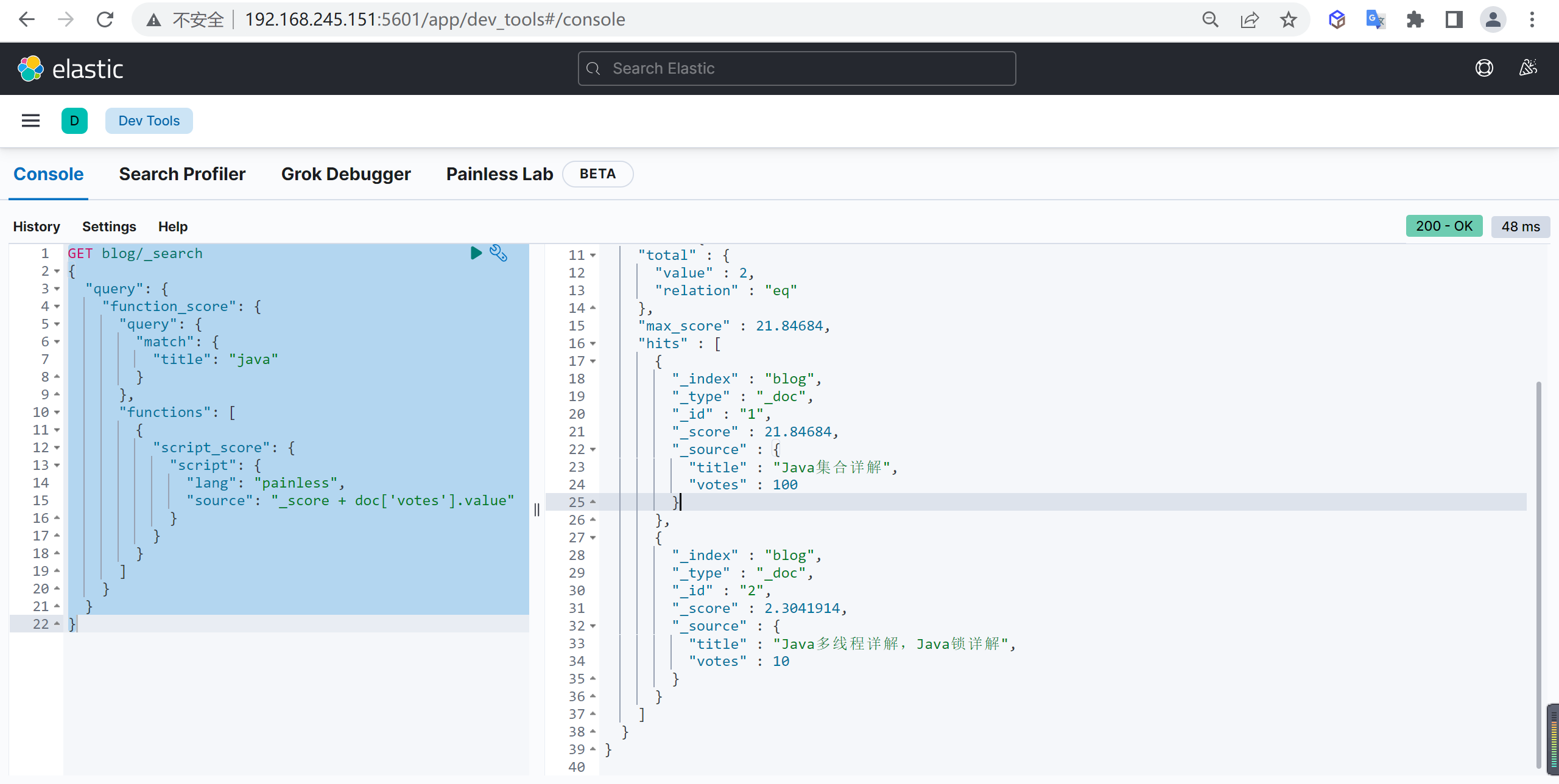

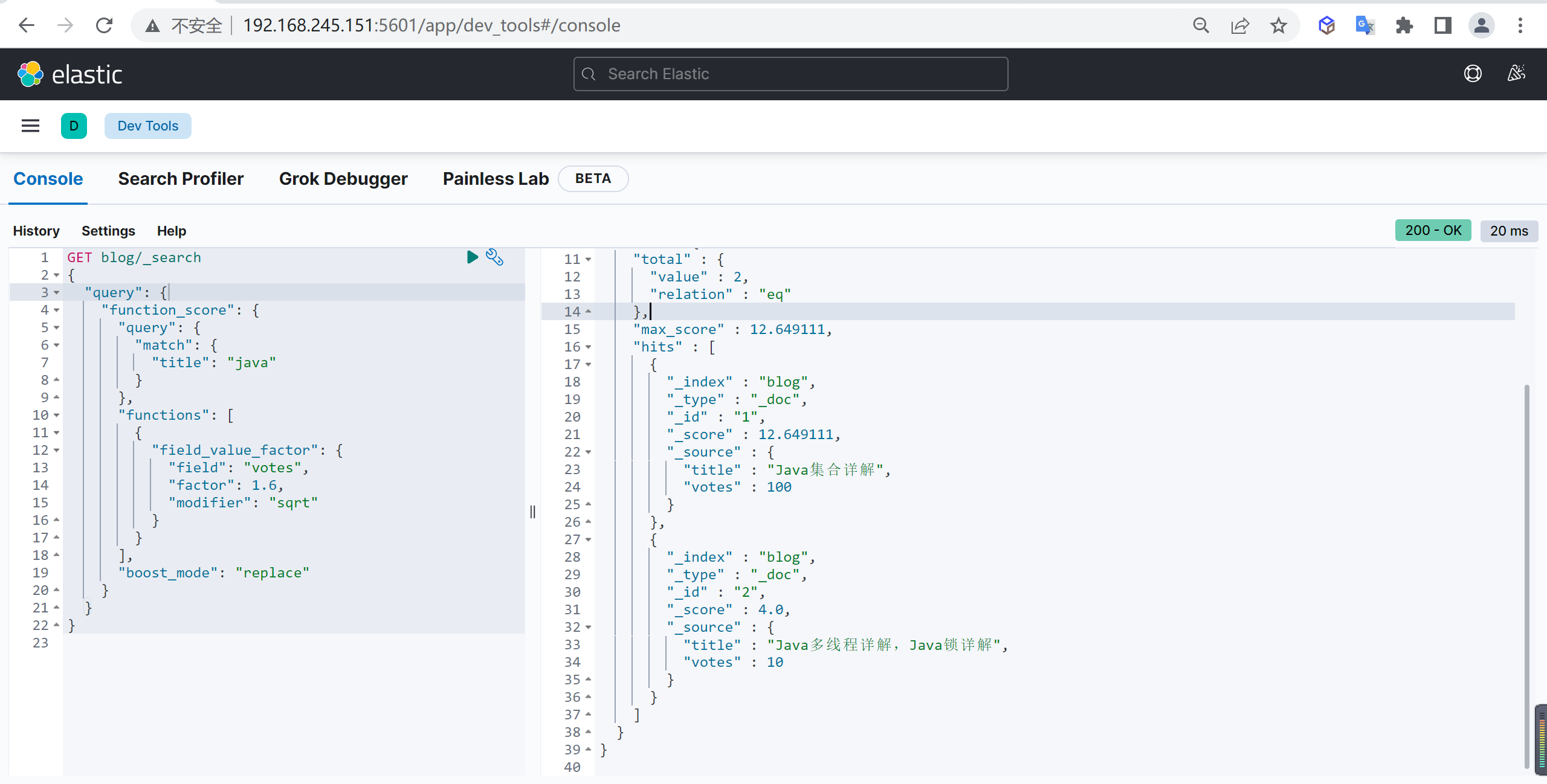

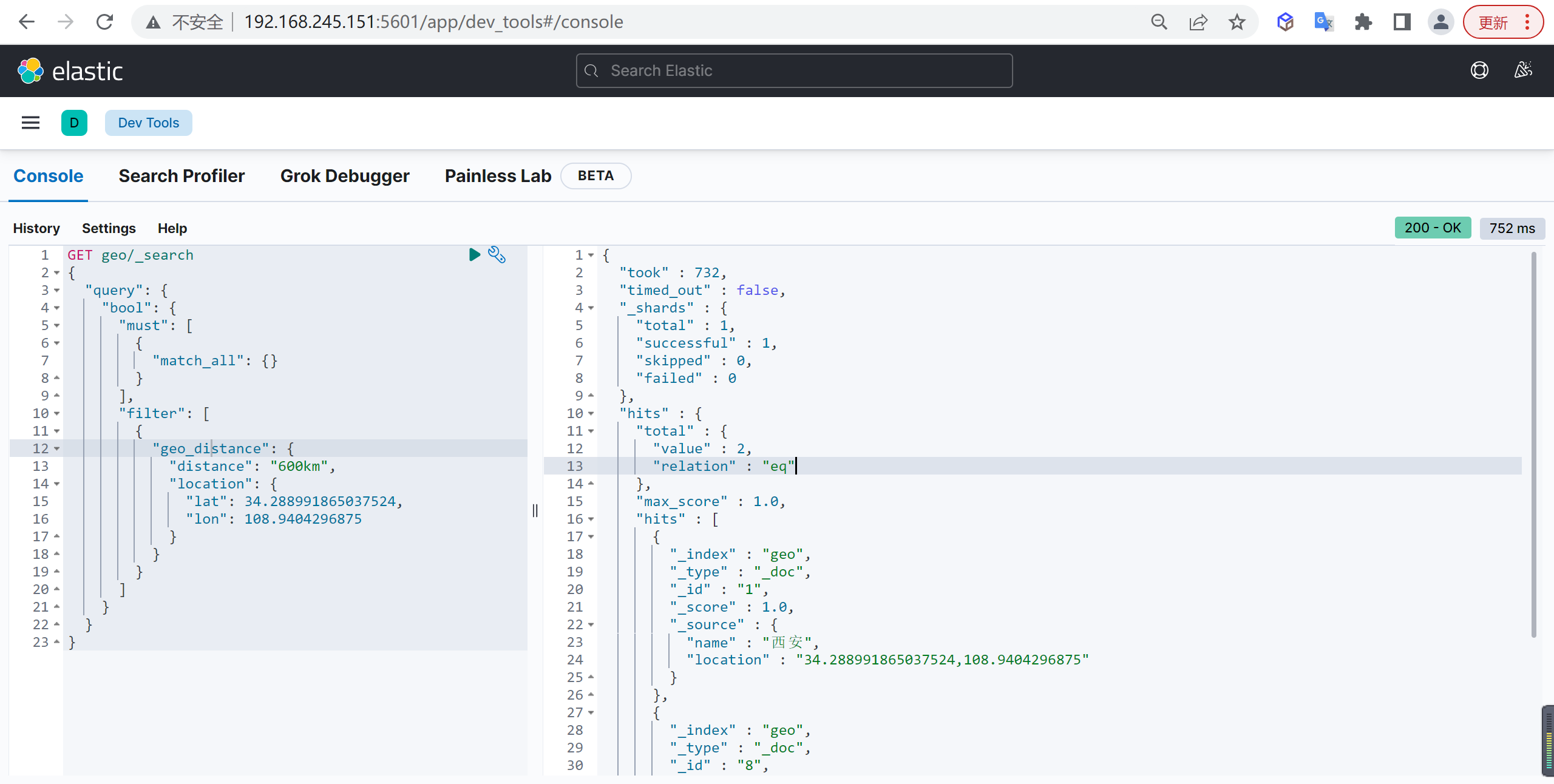

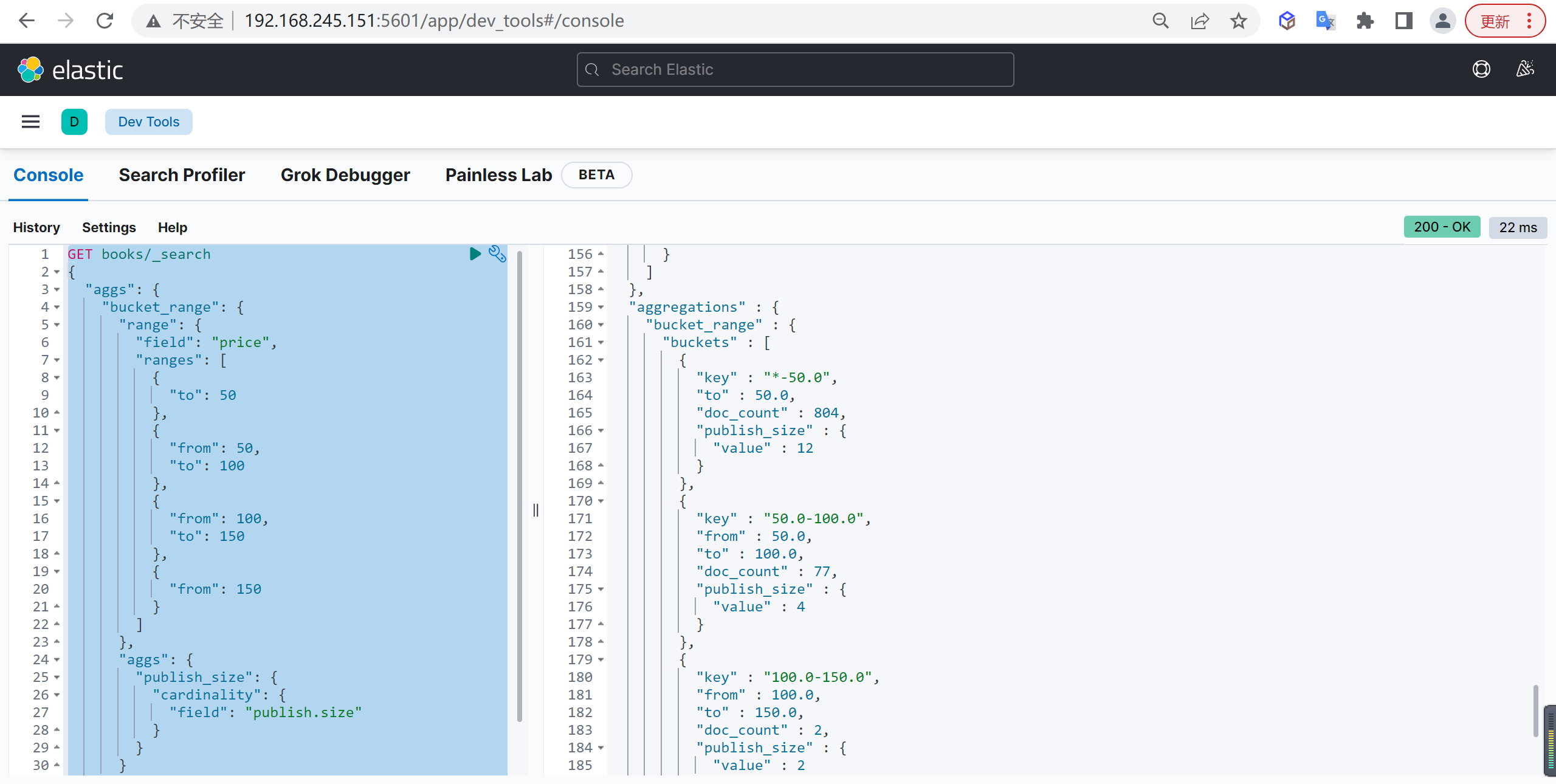

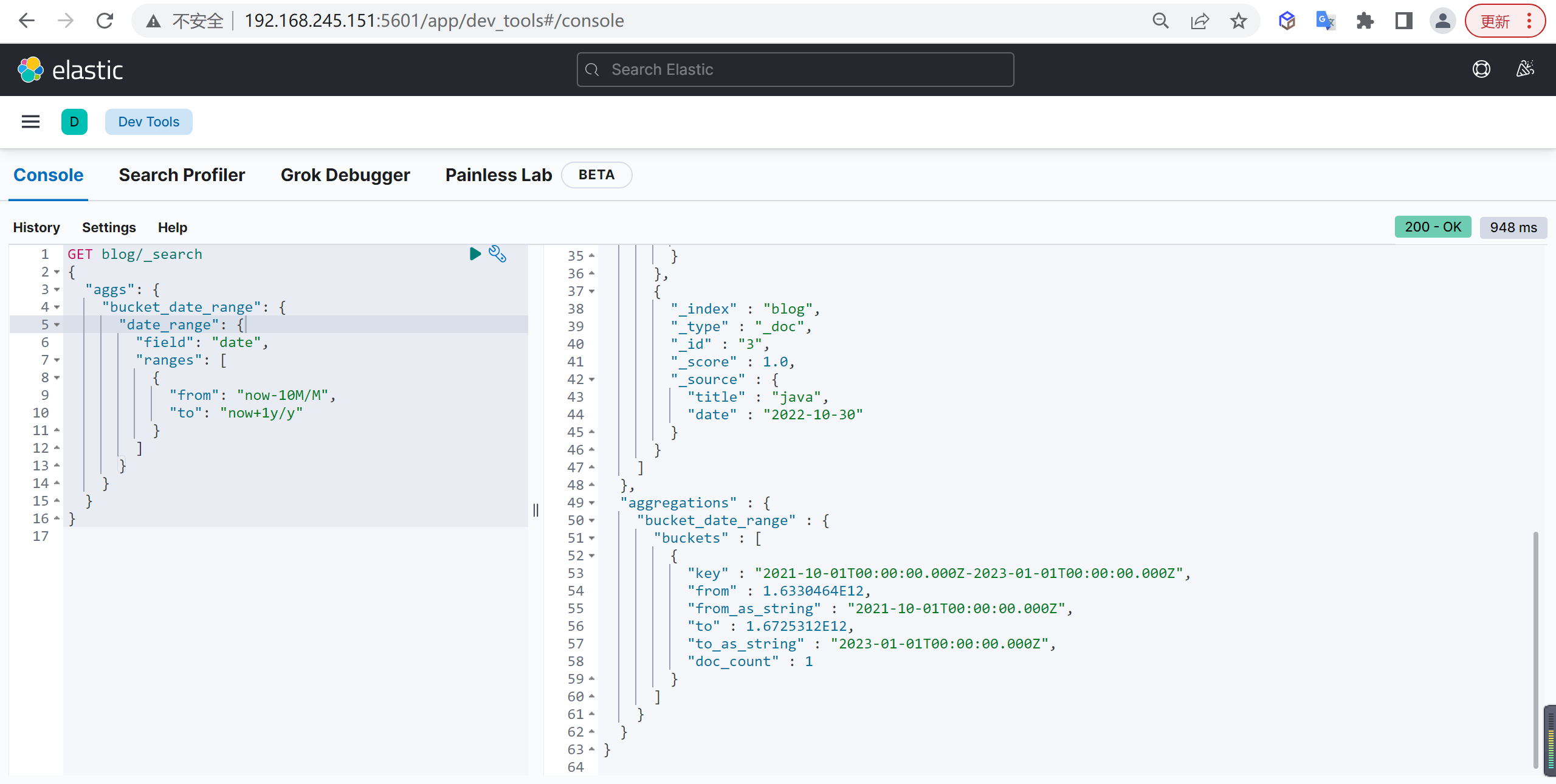

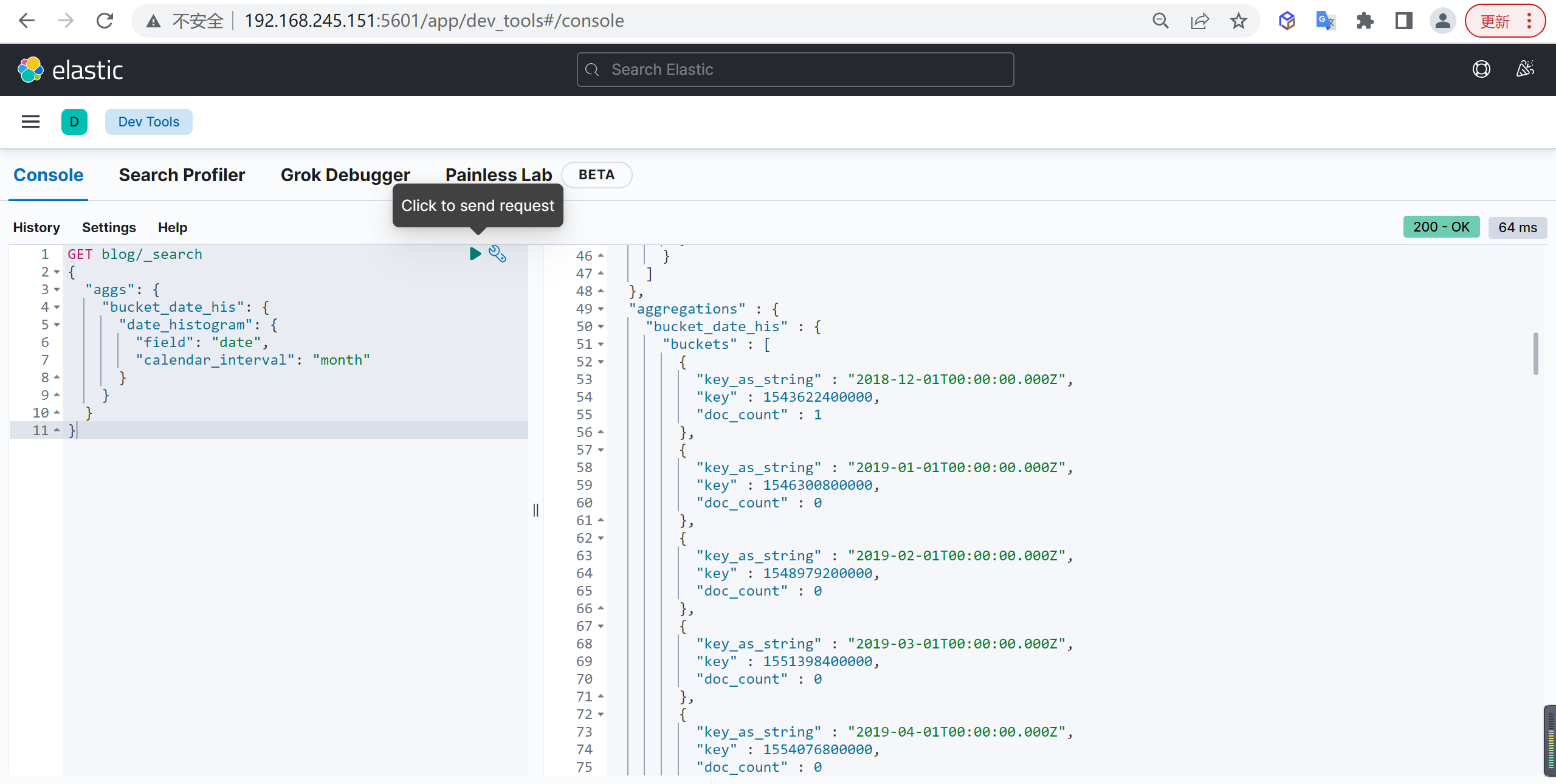

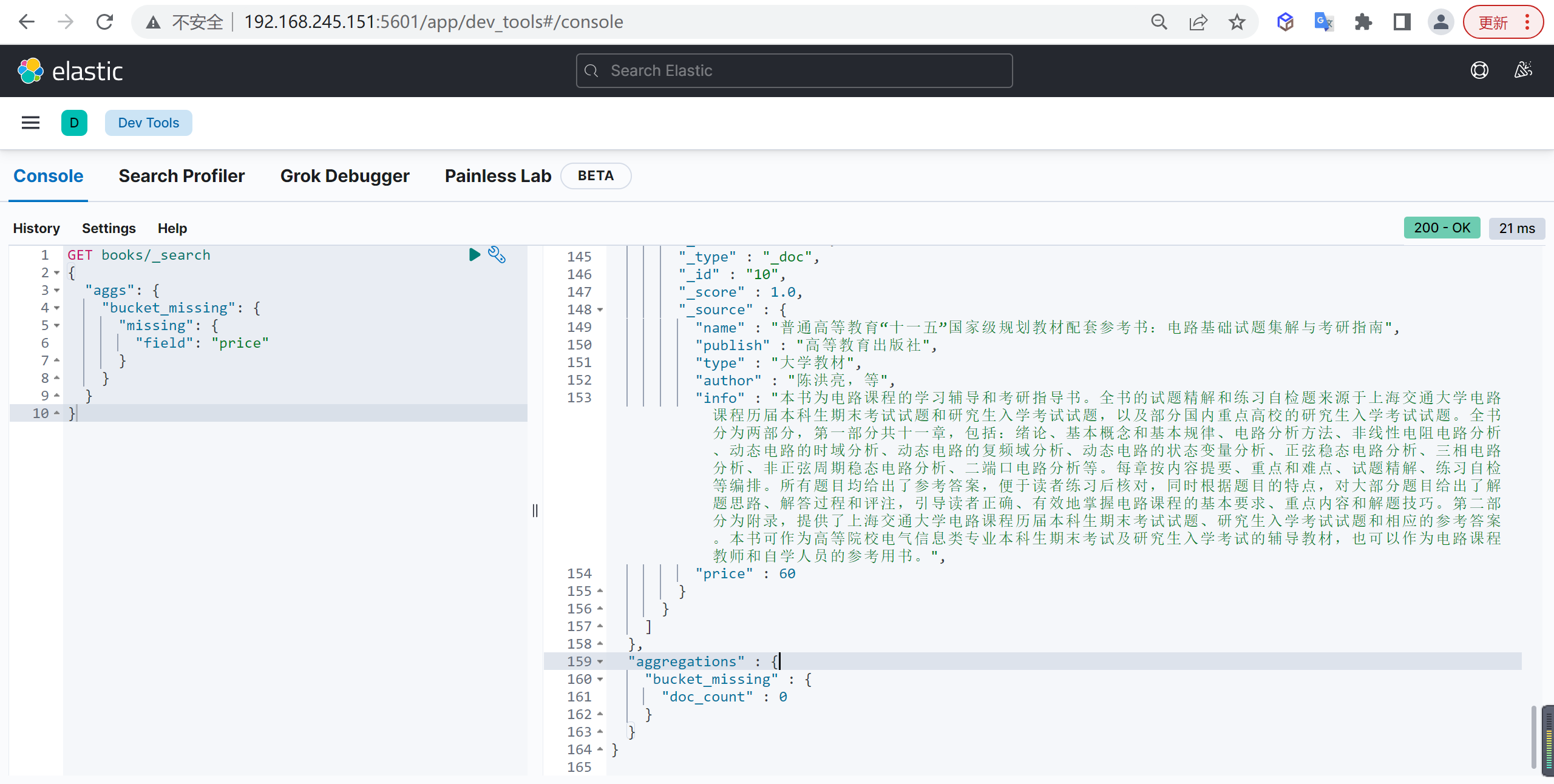

"type": "text",